Viewpoint-Aware Loss with Angular Regularization for Person Re-Identification[1] 带角度正则化的视角感知损失。

不同于视角和不同id之间分离研究的方向,文章提出了带角度正则化的视角感知损失 Viewpoint-Aware Loss with Angular Regularization (VA-reID),将行人视角投影到统一的特征子空间当中研究的方法,同时在id层面和视角层面有效建模了特征的分布。另外为了有效地拟合视角聚类标签分配的模糊性,本文引入了 视角感知自适应标签平滑正则化 viewpoint-aware adaptive label smoothing regularization (VALSR)。本文工作在多个benchmark中均取得了SOTA。

论文一览:

痛点

ReID存在大量的视角变化问题,这对于正确识别行人id带来了很大的挑战。许多解决视角变化的工作是学习针对具有不同视角的人体图像的判别特征表示来实现的,但是这些工作普遍存在一些问题:

1.这些工作将视角学习和id表征学习作为两种分开的过程,而没有一种统一的原则来在不同视角变化下学习最优id分类。

2.这些工作将不同行人的视角挂了硬标签,但在现实中一个人的不同视角是很模糊的。

3.将特征投影到分离且不相关的子空间中,只会模拟每个视点内的身份级别分布,而可能会忽略不同视点之间的潜在关系。

4.无法直接学习来自单独视点子空间的要素之间的关系,从而损害了模型匹配来自不同视点的人的图像的能力。

为了解决这些问题,因此文章提出将所有特征投影到一个统一的子空间中,并从不同的角度直接对特征的分布进行建模。如图1的(d)(f),文章在身份级别和视点级别对特征分布进行建模,在id层面,将不同的id彼此推开以形成id级别的聚类。 在视角层面,每个id聚类中的特征将进一步产生三个视角级别的聚类(正面,侧面,背面),并且由于它们的视觉效果,使用了新颖的中心正则化将这些聚类的中心拉近 相同id的相似性。

此外,由于视角统一聚类的引入,还会带来标签分配的问题。作者发现一些视角的样本标签应该是模糊的,而这时候视角聚类的硬标签分配可能会误导学习。

因此,文章提出了放松硬标签分配,而改为执行软标签分配,如图1(f)所示。

模型

给定一个图像Ii,

其中 xi 是第 i 张图像提取的feature,Vi为其对应的视角label,包含正面,侧面和背面三种,yi为其对应的id label。

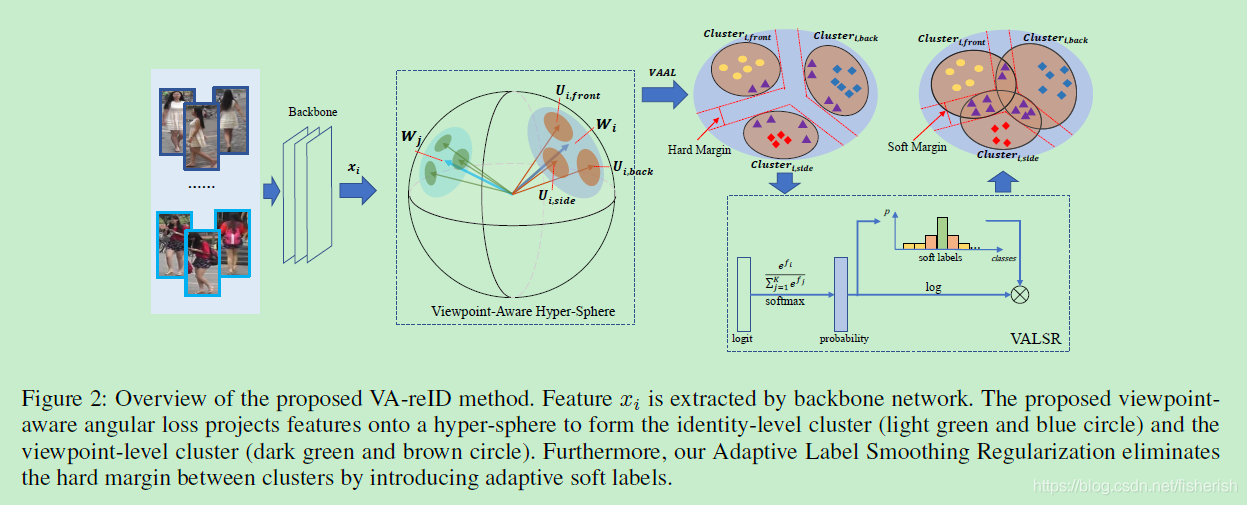

整个模型的结构示意图如下图2,提出的 viewpoint-aware angular loss视角感知角损失 将特征投影到一个超球体上,以形成身份层面的聚类(浅绿色和蓝色圆圈)和视角层面的聚类(深绿色和棕色圆圈)。

模型将两个与角度相关的损失整合到统一的学习框架中,可以在统一的超球面上为特征xi建立两级分布,包括id层面的分布和视角层面的分布。模型总loss有:

其中Ly表示id的角损失(施加了arcface loss角约束的softmax loss),Lv为视角感知角损失,LR为中心正则化项。

在图2右下角展示了视角感知自适应的label smooth regularization,其施加到Lv中消除视角聚类之间的硬边距(hard margin)。此外模型还在Ly探索了一个小的自适应标签平滑正则化,以有效地提高模型的泛化能力。

带角正则化的视角感知损失 Viewpoint-Aware Loss with Angular Regularization

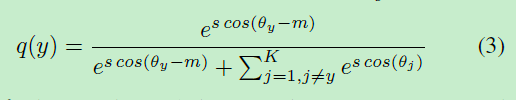

传统方法上softmax loss 有

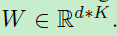

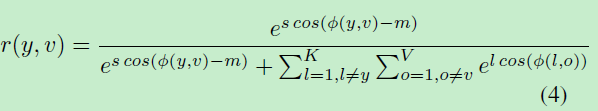

其中K为id 的数量,x为feature,其中第y列的weight Wy有

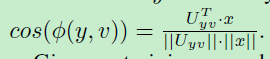

文章根据arcface loss,使用余弦距离将特征投影到超球面

其中有

角损失有助于对id进行更好的区分分布建模,因此文章也将此拓展到了视角感知损失中。

第y列的weight Wy能够被视为id 为y的center,为了获得更高的图像I属于y的可能性,文章需要将特征向量xi拉近中心Wy。为了建模不同视角的分布,文章将每个id 类能够被深度分类为V个子类,这V个子类能够对应到V个视角(如正面视角,侧面视角,背面视角)。

定义视角中心为

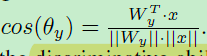

则对于id和视角的建模可以表示为:

其中有

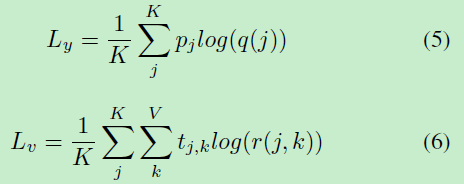

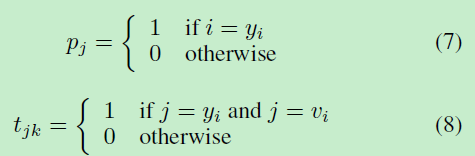

则基于以上,id classification loss Ly和视角感知 loss Lv有:

其中p和t都是label,传统方法都是硬标签(hard label):

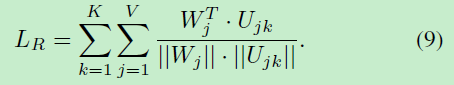

为了保持同一人但具有不同视角的要素之间的视觉相似性,连接id和视角辨别,文章提出了中心正则化项,

自适应标签平滑正则化 adaptive label smoothing regularization

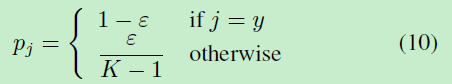

如果是Label smoothing regularization(LSR)有:

其中ε是一个固定的置, 用来调节模型对label的置信度。作为一个固定的值,ε对于每个输入样本,得出类别的预期概率相同,其他类别也是如此,但作者认为实际输入的样本具有不同的logit,因此对它们应用相同的预期概率是不合适的。

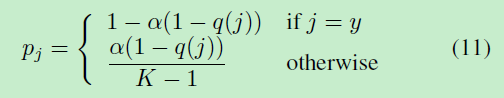

根据先验假设:网络往往会优先考虑先学习实际数据的简单模式,然后再学习噪声。考虑到训练集中存在噪声的情况,将带有真实身份标签y1的图像I错误地标注为y2。 根据假设,网络倾向于先学习正样本,然后学习噪声样本。通常,噪声样本的标签对数比阳性样本小。因此本文拓展了一种新的平滑参数ϵ=(1−q(j)),则p有:

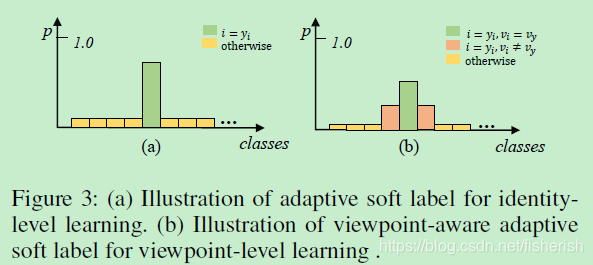

α为比例缩放系数,当输出q(j)大,则ϵ小,因此对该类有一个比较大的置信度。这种自适应标签平滑正则化针对噪声数据和过度拟合具有更好的性能,如图3(a)。

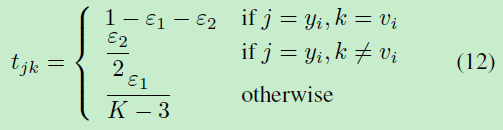

根据先验假设:现实中人的(view point)视角是一种连续值,而不是hard value。根据这个假设,本文将自适应标签平滑应用到视角损失中。由于模型建模了id 层面和视角层面的分布,文章根据视角(正面,侧面,背面)将每个身份标签划分为三个子类别,因此,每张图像都可分为3K视角感知类别。作者认为为软标签分配视角感知角损失,正则化程度将根据标签所属的聚类的级别而有所不同,如图3(b)所示。

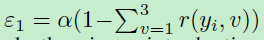

对视角感知损失的自适应标签有

其中ϵ1和ϵ2有

将式(11)(12)应用到(5)(6)即为完整的应用了自适应label smoothing的VA-ReID。

网络结构

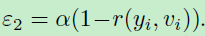

由于具有不同视角的身体部位(例如下半身,腿部)的巨大相似性,因此视角标签更适合全身而不是身体部位。文章backbone网络采用金字塔切片网络,如图4

在实际使用时,采用backbone提取图片特征,然后通过基于朝向角度的损失将特征向量映射到超球面空间,不采用上图中水平切分的方式。两个分支,ID分支做softmax loss和triplet loss,view分支做arcface loss,其中ID分支对应FC层数目为ID数量,view分支对应FC层数目为ID数目*view数目。

对于正则化,使用对应权重中心正则化拉近不同朝向中心与类别中心的距离。

文中对于REID实际效果提升明显的是朝向分支和自适应标签平滑来有效的解决了不同朝向行人重识别问题。增加的朝向分支等于将每个ID的每个朝向作为一个类别,增加了特征空间中的类别中心,可以有效区分同一ID不同朝向,后面自适应标签平滑和正则化其实都是让同一类别不同朝向聚拢,以免影响实际效果。

实验

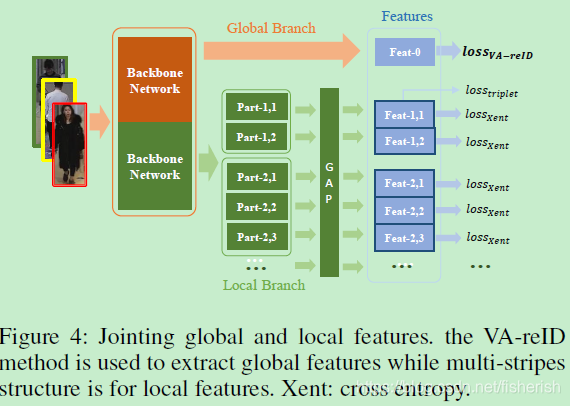

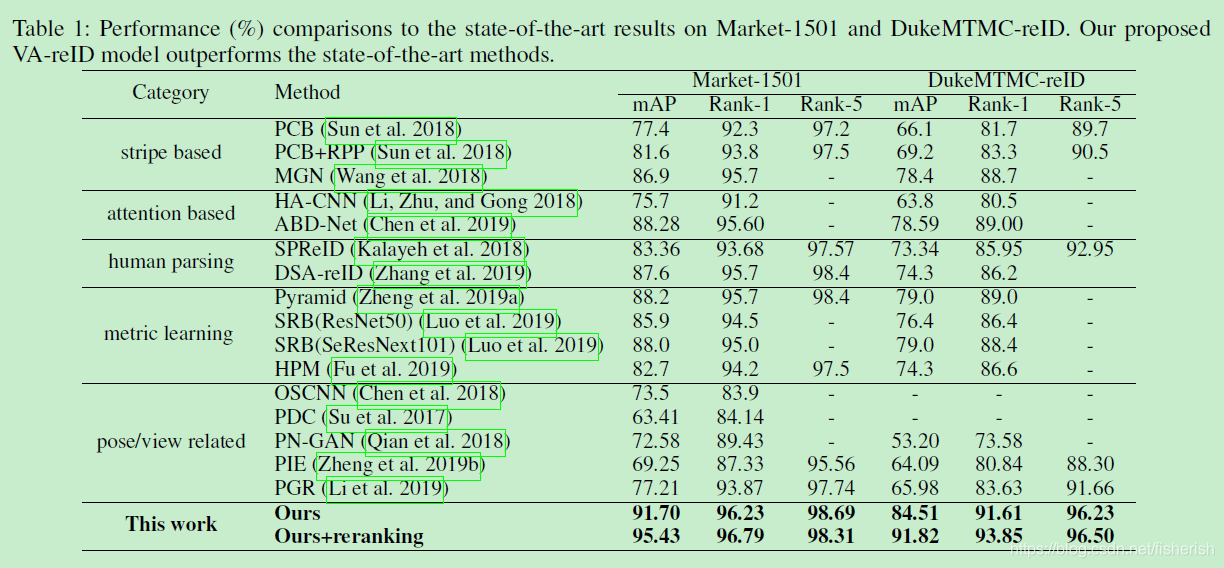

在Market1501和Duke数据集上的SOTA对比试验如下

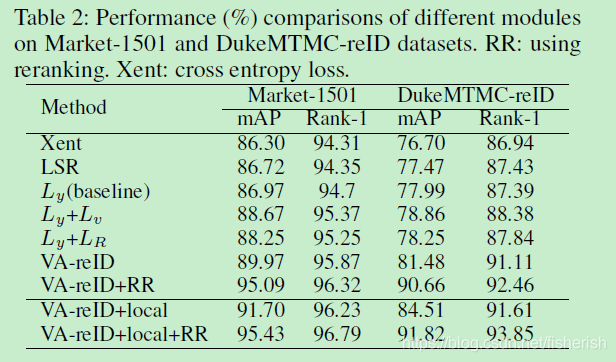

在Martet1501和Duke数据集上的分离试验如下

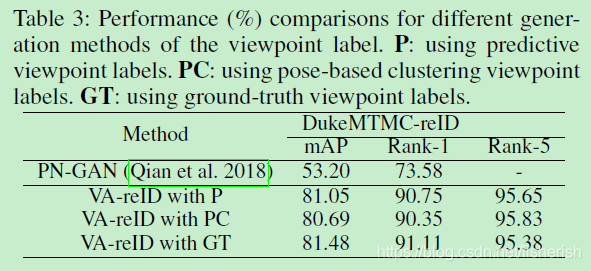

视角label的分离试验,分别是对比PT-GAN生成,视角预测label,姿态聚类视角label,ground-truth视角label:

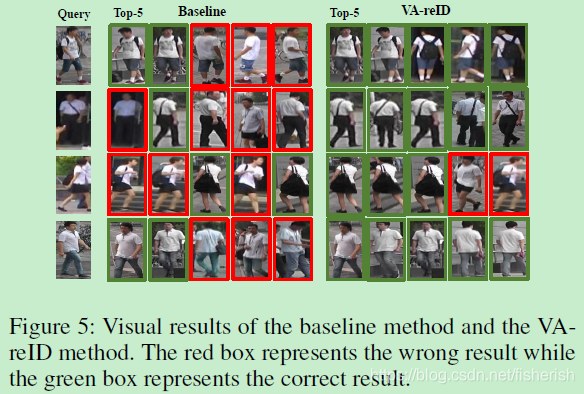

rank可视化如下:

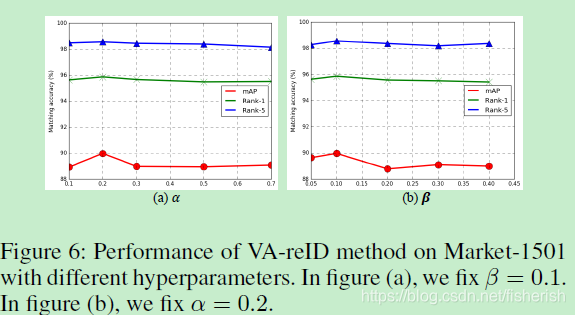

对式(1)和式(11)(12)超参数α和β的超参数数值分离试验如下:

参考文献

[1] Zhu Z, Jiang X, Zheng F, et al. Aware Loss with Angular Regularization for Person Re-Identification[C]//AAAI. 2020: 13114-13121.

部分论文内容转载自 https://blog.csdn.net/fisherish/article/details/111319401

2733

2733

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?