一 .卷积神经网络之层级结构

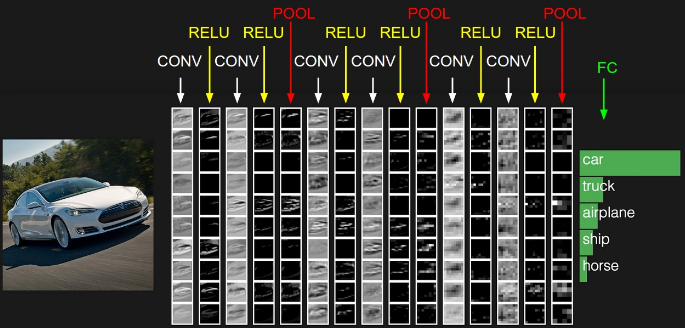

cs231n课程里给出了卷积神经网络各个层级结构,如下图

上图中CNN要做的事情是:给定一张图片,是车还是马未知,是什么车也未知,现在需要模型判断这张图片里具体是一个什么东西,总之输出一个结果:如果是车 那是什么车

所以

- 最左边是数据输入层,对数据做一些处理,比如去均值(把输入数据各个维度都中心化为0,避免数据过多偏差,影响训练效果)、归一化(把所有的数据都归一到同样的范围)、PCA/白化等等。CNN只对训练集做“去均值”这一步。

中间是

- CONV:卷积计算层,线性乘积 求和。

- RELU:激励层,上文2.2节中有提到:ReLU是激活函数的一种。

- POOL:池化层,简言之,即取区域平均或最大。

最右边是

- FC:全连接层

二.卷积层

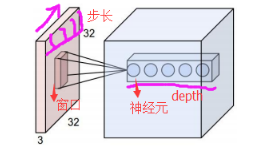

卷积神经网络和传统神经网络的区别在于局部连接和权值共享,以及有多个卷积核,即有深度(传统每层有多个神经元,cnn每层只有一个神经元(这个神经元滑动组成了这一层),多个神经元组成了深度,网上没有这种描述的方式,但是应该是这个意思)。

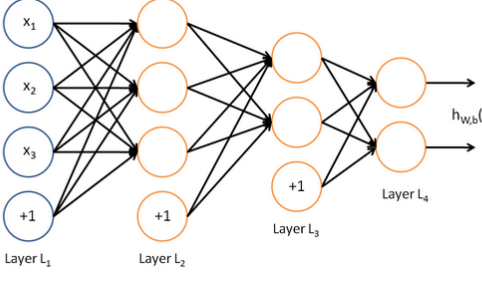

1.局部连接

在传统神经网络中,每个神经元都要接受上一层每一个神经元的输出,但在卷积神经网络中只接受域是固定的一小部分,称为局部连接,如图所示(图1,2为传统,图3,4为卷积)

卷积神经网络:

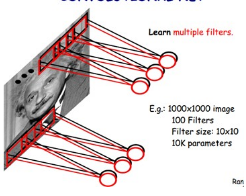

2.权值共享

在初学时,就理解成是理每层的权一样,虽然说的很对,但是并不易于理解。我建议大家不要理解成每一层权值一样,而是理解成每一层根本只是一个卷积核在图片中划过,也就是神经元在移动(网络中的线即为卷积核,神经元的圈是激活函数)。如图,同种颜色代表相同权重,所以说这三个神经元是同一个神经元在不同位置的表示。

再来张立体的,都是同一个过程

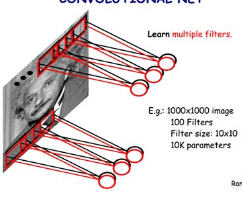

3.多个卷积核

卷积神经网络中通常会用多个卷积核对图片进行卷积处理,每个卷积核对一个通道产生一个结果。例如图片通道为3(黑白图片通道或深度为1,彩色三元色为3)用5个卷积核全卷积产生的结果深度就为15,如图所示

三.RELU层

就是激活函数层,和传统人工神经网络一样,进行非线性变换,采用的激活函数一般都是RELU。

四.池化层

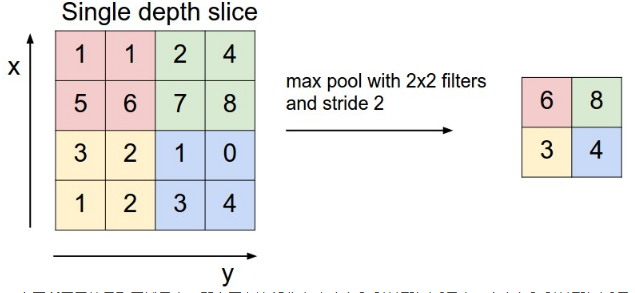

由于卷积后的数据量过于庞大,因此可以对图像的一个局部区域中不同位置的特征进行聚合统计,这种操作称为“池化”(也称作子采样)。池化分为两种,一种是最大池化,在选中区域中找最大的值作为Pooling后的值,另一种是平均值池化,把选中的区域中的平均值作为Pooling后的值。目的都是减小数据量,用一个像素代替一组像素,具体过程如下图:

上图所展示的是取区域最大,即上图左边部分中 左上角2x2的矩阵中6最大,右上角2x2的矩阵中8最大,左下角2x2的矩阵中3最大,右下角2x2的矩阵中4最大,所以得到上图右边部分的结果:6 8 3 4。再来组动图:

五.全连接层(FC)

顾名思义,就是将之前所有局部连接的计算完的图片特征全部输入该层,物理模型类似于传统人工神经网络的连接方式,将所有数据汇聚,计算。

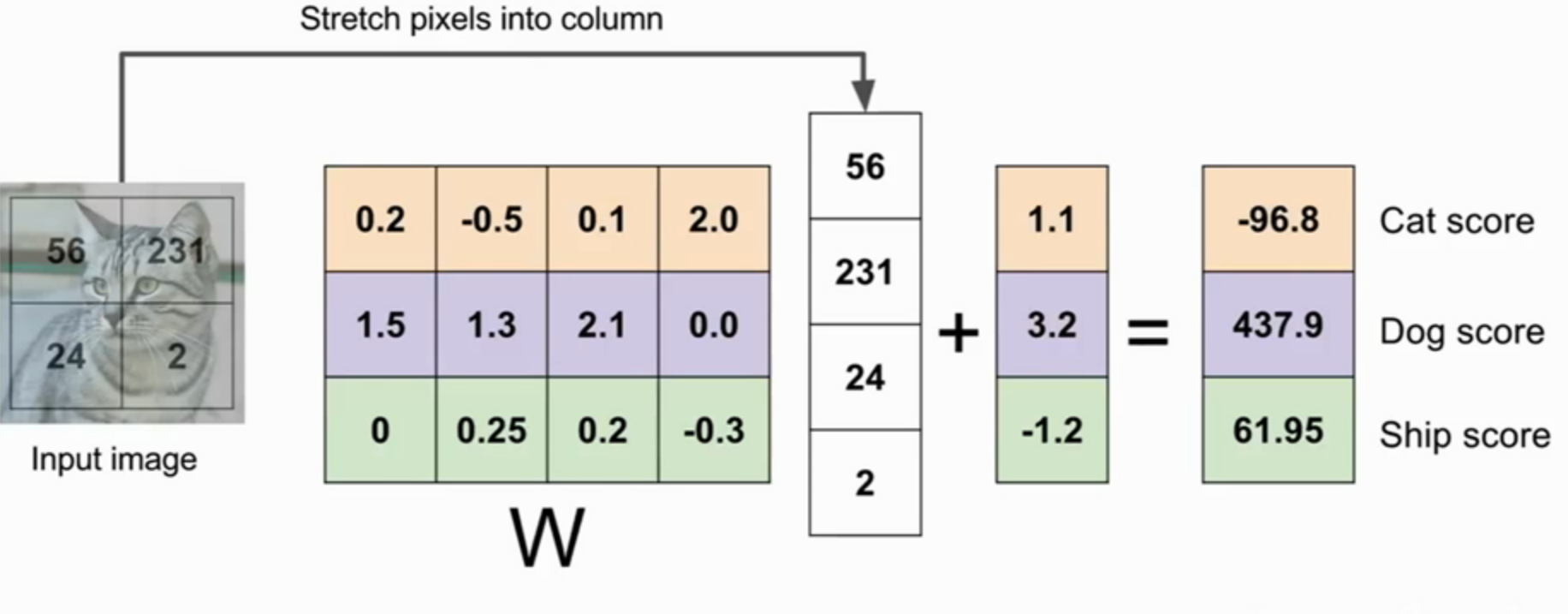

通俗理解就是2维变1维,计算出得分。有的网络里会有多个全连接层,那是因为第一个全连接层输出的虽然是1维的,但是可能长度过高,需要再次全连接将输出转换到和类数相应的数量,类似于线性分类器的作用。

630

630

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?