大型语言模型(LLMs)在自然语言处理(NLP)领域的应用日益广泛,它们在提供机器翻译、文本摘要、情感分析等服务方面展现出了卓越的能力。然而,训练这些模型需要大量的数据、复杂的算法和强大的计算资源。本文将介绍训练LLMs的关键步骤,并推荐一些优秀的开源模型,以便研究者和开发者可以利用这些资源进行实践和探索。

1. 数据准备

-

数据收集:收集大量高质量的文本数据,包括书籍、文章、网页内容、社交媒体数据等。确保数据来源广泛、多样化。

-

数据清洗和预处理:对数据进行清洗,去除噪声、标点符号等,并进行标记化、分词等预处理操作,以便模型更好地理解和学习语言规律。

2. 模型选择与设计

-

选择基础模型:选择一个已经证明在大规模数据集上表现良好的基础模型架构,如GPT、BERT等。

-

模型规模:根据你的需求和计算资源情况,选择适当规模的模型。通常来说,模型规模越大,它的表示能力和性能也越强大。

3. 训练设置

-

超参数调优:调整训练的超参数,如学习率、批量大小等,以最大程度地提升模型性能。

-

数据增强:使用数据增强技术,如随机遮盖、同义词替换等,来扩充训练数据,提升模型的泛化能力。

4. 训练过程

-

分布式训练:利用分布式训练技术,如使用多GPU或分布式计算平台,加速模型的训练过程。

-

模型微调:根据需要,在预训练模型的基础上进行微调,以适应特定的任务或领域。

5. 模型评估与调优

-

评估指标:选择合适的评估指标,如困惑度、BLEU分数等,来评估模型的性能。

-

模型调优:根据评估结果对模型进行调优,包括微调模型架构、优化超参数等。

6. 部署与应用

-

模型部署:将训练好的模型部署到生产环境中,以供实际应用使用。

-

持续监控与更新:定期监控模型的性能,并根据实际情况进行更新和优化,以确保模型的有效性和可靠性。

开源LLM推荐

以下是一些优秀的开源LLMs,它们支持微调,可以根据特定需求进行调整:

-

ChatGLM-6B - 一个开源的、支持中英双语的对话语言模型,基于GLM架构。

-

GitHub链接:ChatGLM-6B

-

-

LLaMA - Facebook Research提供的一系列大型语言模型,具有高效的预训练和推理性能。

-

GitHub链接:LLaMA

-

-

Alpaca - 斯坦福大学开发的指令遵从型LLaMA模型,提供与ChatGPT类似的体验。

-

GitHub链接:Alpaca

-

-

Baize - 使用LoRA微调的开源聊天模型,提供了多种规模的模型。

-

GitHub链接:Baize

-

-

BELLE - 基于Alpaca的中文优化模型,调整了代码生成功能。

-

GitHub链接:BELLE

-

-

Luotuo - 商汤科技和华中科技大学开源的中文语言模型,易于本地化应用。

-

GitHub链接:Luotuo

-

-

Vicuna (FastChat) - 旨在达到ChatGPT 90%效果的开源聊天机器人。

-

GitHub链接:Vicuna

-

-

GPT4All - 基于LLaMA训练的助手式大语言模型。

-

GitHub链接:GPT4All

-

-

BLOOM (BigScience) - 大型开放科学开放存取多语言模型。

-

Hugging Face链接:BLOOM

-

-

GPT-J (EleutherAI) - EleutherAI开发的开源人工智能语言模型,性能与GPT-3相似。

-

GitHub链接:GPT-J

-

-

Polyglot - 专注于非英语语言性能的多语言均衡能力的大型语言模型。

-

GitHub链接:Polyglot

-

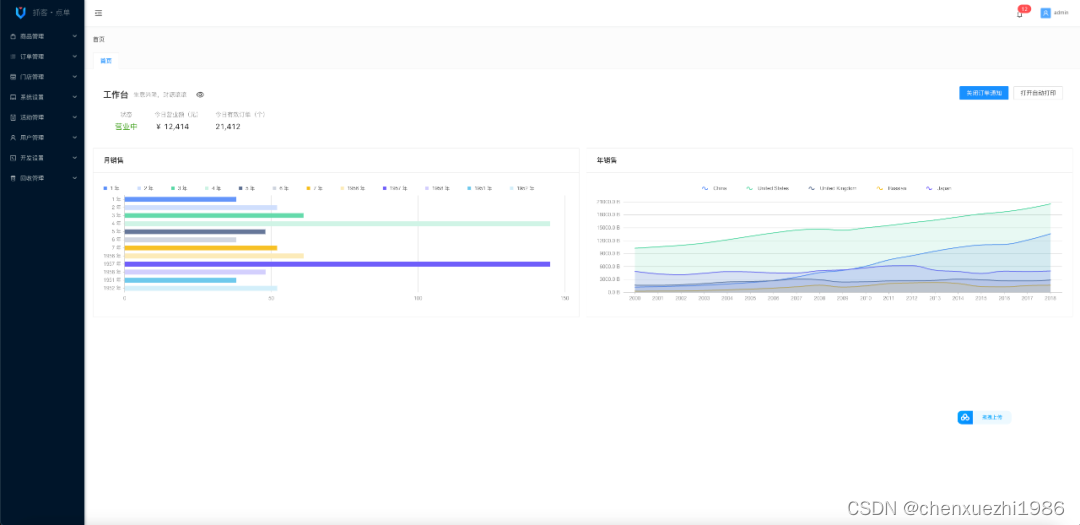

抓客点单SaaS多商户系统(源码)

前端小程序演示

管理后台演示(PC):https://dd.admin.zhuake.com

本文详细介绍了在NLP领域使用大型语言模型(LLMs)的过程,包括数据准备、模型选择、训练设置、评估与调优,以及推荐了一些可用于实践的开源LLM资源。

本文详细介绍了在NLP领域使用大型语言模型(LLMs)的过程,包括数据准备、模型选择、训练设置、评估与调优,以及推荐了一些可用于实践的开源LLM资源。

1591

1591

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?