http://blog.csdn.net/pipisorry/article/details/45307369

1. 短文本与LDA

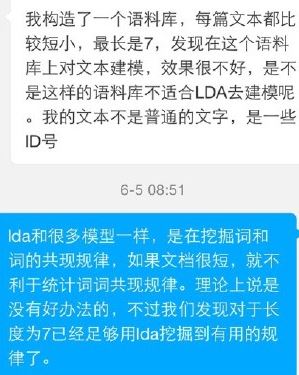

ICML论文有理论分析,文档太短确实不利于训练LDA,但平均长度是10这个数量级应该是可以的,如peacock基于query 训练模型。

有一些经验技巧加工数据,譬如把同一session 的查询拼接,同一个人的twitter 拼接等。也可以用w2v那样的小窗口训练过lda。

短文本上效果不好的原因是document-level word co-occurrences 很稀疏。

解决这个问题的方式:

1. 是如word2vec一样,利用local context-level word co-occurrences。 也就是说,把每个词当成一个文档以及把它周围出现过的词当做这个文档的内容。这样的话就不会受文档长度的限制了。

2. 短文本语义更集中明确,LDA是适合处理的,也可以做一些文本扩展的工作,有query log的话,1. query session,2. clickstream。无query log的话,1. 短文本当做query,通过搜索引擎(或语料库)获取Top相关性网页,2. 用语料库中短文本周边词集,3. 知识库中近义词,上下位词等。

3. KBTM

[http://weibo.com/1991303247/CltoOaSTN?type=repost#_rnd1433930168895]

LDA在处理短文本时面临挑战,因为document-level word co-occurrences稀疏。解决方案包括利用local context-level word co-occurrences和文本扩展。LDA的局限性包括未考虑词的相对位置和话题重叠。为解决这些问题,可以使用2-grams、H-LDA或TopicMapping等方法。此外,LDA在大数据文本分析中可能存在不一致性和不准确性,可以通过社区检测算法和并行计算(如基于GraphX的Gibbs Sampling LDA)来改进。

LDA在处理短文本时面临挑战,因为document-level word co-occurrences稀疏。解决方案包括利用local context-level word co-occurrences和文本扩展。LDA的局限性包括未考虑词的相对位置和话题重叠。为解决这些问题,可以使用2-grams、H-LDA或TopicMapping等方法。此外,LDA在大数据文本分析中可能存在不一致性和不准确性,可以通过社区检测算法和并行计算(如基于GraphX的Gibbs Sampling LDA)来改进。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?