课程4_第2周_测验题

第一题

1.在典型的卷积神经网络中,随着网络的深度增加,你能看到的现象是?

A. 【 】 n H n_H nH和 n W n_W nW增加,同时 n C n_C nC减少

B. 【 】 n H n_H nH和 n W n_W nW减少,同时 n C n_C nC也减少

C. 【 】 n H n_H nH和 n W n_W nW增加,同时 n C n_C nC也增加

D. 【 】 n H n_H nH和 n W n_W nW减少,同时 n C n_C nC增加

答案:

D.【 √ 】 n H n_H nH和 n W n_W nW减少,同时 n C n_C nC增加

第二题

2.在典型的卷积神经网络中,你能看到的是?

A. 【 】多个卷积层后面跟着的是一个池化层

B. 【 】多个池化层后面跟着的是一个卷积层

C. 【 】全连接层(FC)位于最后的几层

D. 【 】全连接层(FC)位于开始的几层

答案:

A.【 √ 】多个卷积层后面跟着的是一个池化层

C.【 √ 】全连接层(FC)位于最后的几层

第三题

3.为了构建一个非常深的网络,我们经常在卷积层使用“valid”的填充,只使用池化层来缩小激活值的宽/高度,否则的话就会使得输入迅速的变小。

A. 【 】对

B. 【 】不对

答案:

B.【 √ 】不对

第四题

4.训练更深层的网络(例如,在网络中添加额外的层)可以使网络适应更复杂的功能,因此几乎总是会导致更低的训练错误。对于这个问题,假设是指“普通”网络。

A. 【 】对

B. 【 】不对

答案:

B.【 √ 】不对

第五题

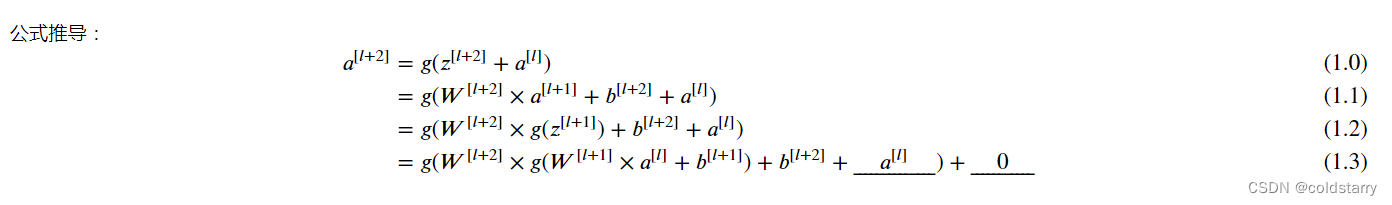

5.下面计算残差(ResNet)块的公式中,横线上应该分别填什么?

a [ l + 2 ] = g ( W [ l + 2 ] g ( W [ l + 1 ] + b [ l + 1 ] ) + b [ l + 2 ] + _ _ ? _ _ ) + _ _ ? _ _ ) a^{[l+2]}=g(W^{[l+2]}g(W^{[l+1]}+b^{[l+1]})+b^{[l+2]}+\_\_?\_\_)+\_\_?\_\_) a[l+2]=g(W[l+2]g(W[l+1]+b[l+1])+b[l+2]+__?__)+__?__)

A. 【 】分别是 0 0 0与 z [ l + 1 ] z^{[l+1]} z[l+1]

B. 【 】分别是 a [ l ] a^{[l]} a[l]与 0 0 0

C. 【 】分别是 z [ l ] z^{[l]} z[l]与 a [ l ] a^{[l]} a[l]

D. 【 】分别是 0 0 0与 a [ l ] a^{[l]} a[l]

答案:

B.【 √ 】分别是 a [ l ] a^{[l]} a[l]与 0 0 0

第六题

6.关于残差网络下面哪个(些)说法是正确的?

A. 【 】使用跳越连接能够对反向传播的梯度下降有益,且能够帮你对更深的网络进行训练

B. 【 】跳跃连接计算输入的复杂的非线性函数以传递到网络中的更深层

C. 【 】有L层的残差网络一共有 L 2 L^2 L2种跳跃连接的顺序

D. 【 】跳跃连接能够使得网络轻松地学习残差块类的输入输出间的身份映射

答案:

A.【 √ 】使用跳越连接能够对反向传播的梯度下降有益,且能够帮你对更深的网络进行训练

D.【 √ 】跳跃连接能够使得网络轻松地学习残差块类的输入输出间的身份映射

第七题

7.假设你的输入的维度为64x64x16,单个1x1的卷积过滤器含有多少个参数(包括偏差)?

A. 【 】2

B. 【 】17

C. 【 】4097

D. 【 】1

答案:

B.【 √ 】17

第八题

8.假设你有一个维度为 n H × n W × n C n_H×n_W×n_C nH×nW×nC的卷积输入,下面哪个说法是正确的(假设卷积层为1x1,步长为1,padding为0)?

A. 【 】你能够使用1x1的卷积层来减少 n C n_C nC,但是不能减少 n H , n W n_H,n_W nH,nW

B. 【 】你可以使用池化层减少 n H , n W n_H,n_W nH,nW,但是不能减少 n C n_C nC

C. 【 】你可以使用一个1x1的卷积层来减少 n H , n W n_H,n_W nH,nW和 n C n_C nC

D. 【 】你可以使用池化层减少 n H , n W n_H,n_W nH,nW和 n C n_C nC

答案:

A.【 √ 】你能够使用1x1的卷积层来减少 n C n_C nC,但是不能减少 n H , n W n_H,n_W nH,nW

B.【 √ 】你可以使用池化层减少 n H , n W n_H,n_W nH,nW,但是不能减少 n C n_C nC

第九题

9.关于 Inception 网络下面哪些说法是正确的

A. 【 】Inception 网络包含了各种网络的体系结构(类似于随机删除节点模式,它会在每一步中随机选择网络的结构),因此它具有随机删除节点的正则化效应。

B. 【 】Inception 块通常使用1x1的卷积来减少输入卷积的大小,然后再使用3x3和5x5的卷积。

C. 【 】一个inception 块允许网络使用1x1, 3x3, 5x5 的和卷积个池化层的组合。

D. 【 】通过叠加inception块的方式让inception网络更深,不会损害训练集的表现。

答案:

B.【 √ 】Inception 块通常使用1x1的卷积来减少输入卷积的大小,然后再使用3x3和5x5的卷积。

C.【 √ 】一个inception 块允许网络使用1x1, 3x3, 5x5 的和卷积个池化层的组合。

第十题

10.下面哪些是使用卷积网络的开源实现(包含模型/权值)的常见原因?

A. 【 】为一个计算机视觉任务训练的模型通常可以用来数据扩充,即使对于不同的计算机视觉任务也是如此。

B. 【 】为一个计算机视觉任务训练的参数通常对其他计算机视觉任务的预训练是有用的。

C. 【 】使用获得计算机视觉竞赛奖项的相同的技术,广泛应用于实际部署。

D. 【 】使用开源实现可以很简单的来实现复杂的卷积结构。

答案:

B.【 √ 】为一个计算机视觉任务训练的参数通常对其他计算机视觉任务的预训练是有用的。

D.【 √ 】使用开源实现可以很简单的来实现复杂的卷积结构。

1196

1196

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?