AlexNet网络

1、AlexNet 网络的创新点

AlexNet是发表在《ImageNet Classification with Deep Convolutional Neural Networks》使用了LSVRC-2010竞赛中的数据集并取它的子集,对1000个不同的类进行分类,并取得了历史性的提高。

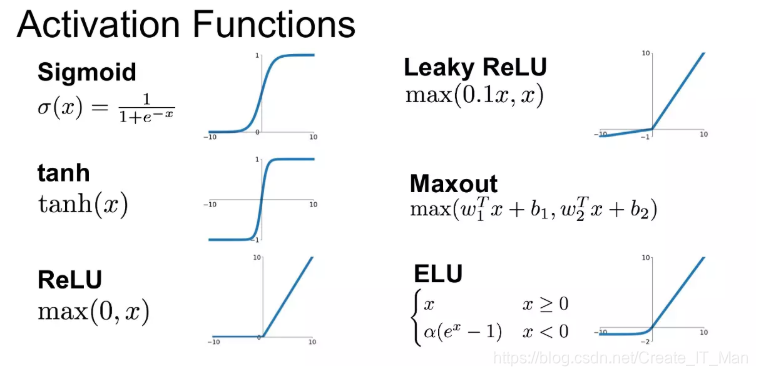

1.1、使用了ReLU作为激活函数

相比sigmoid,tanh,ReLu有一下优点:

- 1 计算开销少,论文中提到非饱和非线性变换(Relu)比饱和非线性变换(Sigmoid、tanh)梯度计算的要更快,(饱和是激活函数有界,而非饱和是指无界)

- 2 训练收敛速度快,Relu会让一部分神经元的输出为0,这样就照成了网络的稀疏性,减少了参数。

激活函数要使用非线性变换,而Relu是一个线性的分段函数,似乎有问题。可以指出,对于每一个样本ReLU做的是不同线性变换,而对整个样本集而言着可以理解为非线性的。

简单来说,不同训练样本中的同样的特征,在经过神经网络学习时,流经的神经元是不一样的(激活函数值为0的神经元不会被激活)。这样,最终的输出实际上是输入样本的非线性变换。

1.2 LRN(局部相应归一化)

- 可以方便后面数据的处理

- 可以加快程序的收敛

- 保证输出数据中数值小的值不被吞食

公式:

b x , y i = a x , y i / ( k + α ∑ j = m a x ( 0 , i − n / 2 ) m i n ( N − 1 , i + n / 2 ) ( a x , y j ) 2 ) β b_{x

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1410

1410

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?