目录

摘要

随着人工智能技术的飞速发展,越来越多的开发者和企业希望将 AI 能力集成到自己的应用和服务中。然而,部署和管理 AI 模型往往需要复杂的技术栈和高昂的成本。Open WebUI 的出现,为这一问题提供了一个高效且用户友好的解决方案。Open WebUI 是一个完全离线运行的自托管 AI 平台,支持多种大语言模型(LLM)运行器,如 Ollama 和 OpenAI 兼容 API,并内置了推理引擎,能够轻松实现 AI 的本地部署和使用。本文将详细介绍 Open WebUI 的功能特性、技术架构、安装与使用方法、应用场景以及开发过程中需要注意的事项,帮助读者快速掌握这一强大的工具。

一、引言

在当今数字化时代,人工智能已经渗透到我们生活的方方面面,从智能家居、智能办公到自动驾驶和医疗健康,AI 的应用场景无处不在。然而,对于许多开发者和企业来说,将 AI 模型部署到生产环境中仍然是一个挑战。传统的 AI 部署方式通常需要复杂的服务器配置、高昂的硬件成本以及专业的技术团队支持。此外,依赖外部云服务的 AI 解决方案可能会面临数据隐私和网络延迟等问题。Open WebUI 的出现,正是为了解决这些问题,提供一个简单、高效且安全的 AI 部署平台。

二、Open WebUI 的概念讲解

(一)功能特性

Open WebUI 是一个功能强大的 AI 平台,其主要特性包括:

-

离线运行:完全在本地运行,无需依赖外部网络,保护数据隐私的同时,避免了网络延迟问题。

-

支持多种 LLM 运行器:支持 Ollama 和 OpenAI 兼容 API,用户可以根据自己的需求选择合适的模型。

-

内置推理引擎:支持 Retrieval Augmented Generation(RAG),能够将文档交互集成到聊天体验中。

-

用户友好界面:提供响应式设计,支持桌面和移动设备,同时支持 Progressive Web App(PWA),提供类似原生应用的体验。

-

丰富的功能支持:

-

支持 Markdown 和 LaTeX,提升交互体验。

-

集成语音和视频通话功能,实现无缝沟通。

-

支持本地模型构建和自定义函数调用。

-

支持多语言,满足不同用户的需求。

-

支持 Web 搜索和网页浏览能力,丰富聊天内容。

-

支持图像生成集成,提供动态视觉内容。

-

-

安全性和权限管理:支持基于角色的访问控制(RBAC),确保只有授权用户才能访问敏感功能。

-

持续更新:定期发布新功能、修复和优化,保持平台的先进性。

(二)技术基础

Open WebUI 的技术实现基于以下几个关键技术:

-

Docker 和 Kubernetes:支持通过 Docker 和 Kubernetes 快速部署,简化安装和管理过程。

-

Python:使用 Python 编写,支持 Python 函数调用和自定义逻辑。

-

Web 技术栈:前端采用现代 Web 技术(如 React、Vue.js 等),提供流畅的用户体验。

-

机器学习和深度学习:支持多种大语言模型(LLM),利用先进的 AI 技术提供智能交互。

-

插件系统:支持通过插件扩展功能,满足不同用户的需求。

三、Open WebUI 的架构设计

(一)系统架构图

以下是 Open WebUI 的系统架构图:

(二)架构模块介绍

Open WebUI 的系统架构主要由以下几个模块组成:

-

用户界面模块:

-

提供用户友好的操作界面,支持桌面和移动设备。

-

使用现代 Web 技术(如 React 或 Vue.js)实现,提供流畅的用户体验。

-

支持 Progressive Web App(PWA),提供类似原生应用的体验。

-

-

后端服务模块:

-

使用 Python 编写,支持 Flask 或 Django 框架。

-

提供 API 接口,与前端用户界面进行通信。

-

集成多种 LLM 运行器,支持 Ollama 和 OpenAI 兼容 API。

-

-

LLM 运行器模块:

-

支持多种大语言模型(LLM),如 Ollama 和 OpenAI API。

-

提供灵活的模型选择和切换能力,满足不同用户的需求。

-

-

推理引擎模块:

-

内置 Retrieval Augmented Generation(RAG)推理引擎。

-

支持将文档交互集成到聊天体验中,提升交互的丰富性。

-

-

数据存储模块:

-

使用 SQLite 或 MySQL 等数据库存储用户数据和模型信息。

-

确保数据的安全性和持久性。

-

-

插件系统模块:

-

支持通过插件扩展功能,满足不同用户的需求。

-

支持自定义逻辑和 Python 库的集成。

-

四、Open WebUI 的安装与使用

(一)安装方法

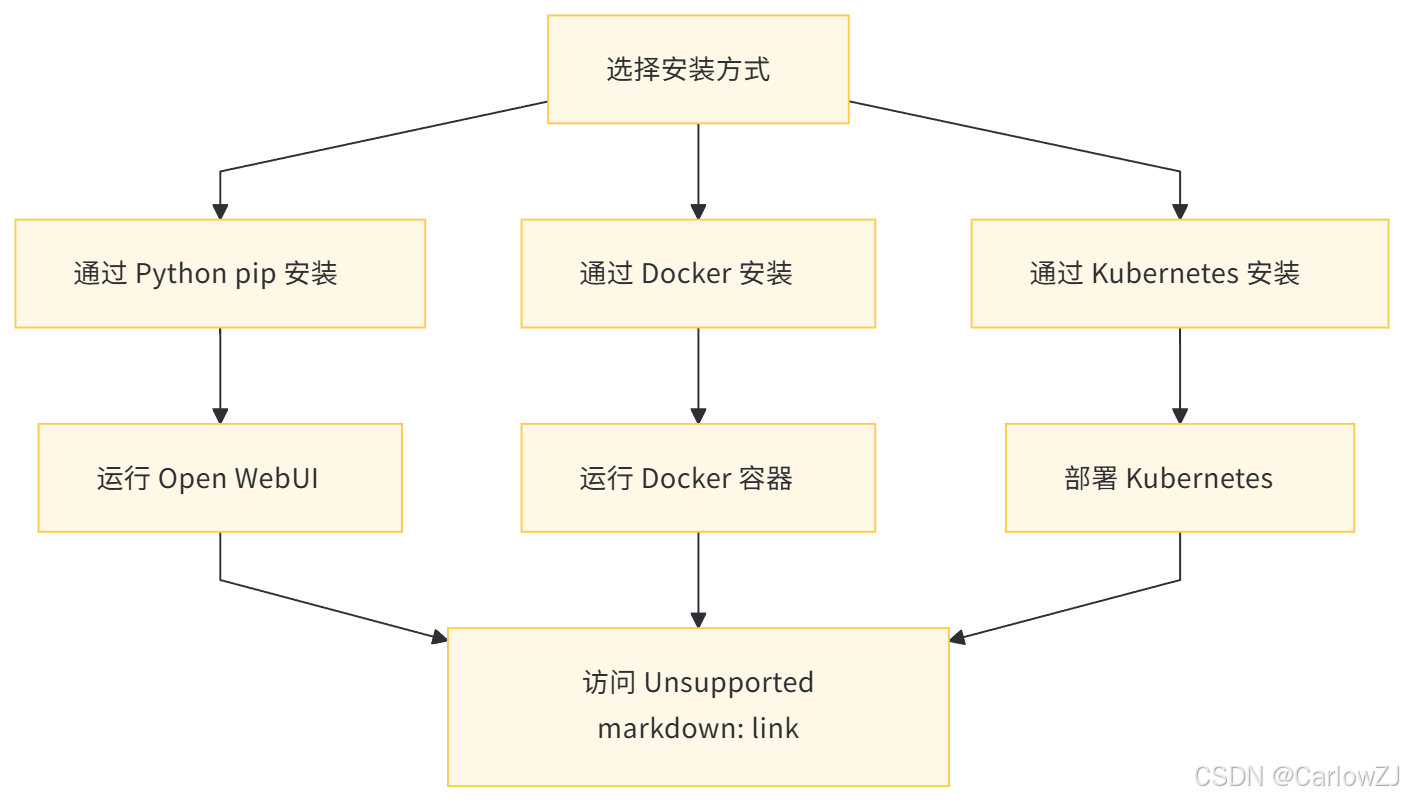

Open WebUI 提供了多种安装方法,包括通过 Python pip、Docker 和 Kubernetes 等方式。以下是具体的安装步骤:

1. 通过 Python pip 安装

-

安装 Open WebUI: 确保你已经安装了 Python 3.11,然后运行以下命令安装 Open WebUI:

pip install open-webui -

运行 Open WebUI: 安装完成后,运行以下命令启动 Open WebUI:

open-webui你可以在浏览器中访问

http://localhost:8080来使用 Open WebUI。

2. 通过 Docker 安装

-

安装 Docker: 确保你已经安装了 Docker。

-

运行 Docker 容器: 根据你的需求选择合适的命令运行 Open WebUI:

-

默认配置:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main -

使用 Ollama:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama -

使用 CUDA 加速:

docker run -d -p 3000:8080 --gpus all --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:cuda

你可以在浏览器中访问

http://localhost:3000来使用 Open WebUI。 -

3. 通过 Kubernetes 安装

-

安装 Kubernetes: 确保你已经安装了 Kubernetes。

-

部署 Open WebUI: 使用 Helm 或 Kustomize 部署 Open WebUI,具体步骤可以参考 Open WebUI 文档。

(二)使用方法

-

访问 Open WebUI: 打开浏览器,访问

http://localhost:8080或http://localhost:3000(根据安装方式不同)。 -

配置模型和 API: 在 Open WebUI 中配置所需的 LLM 模型和 OpenAI API 密钥。

-

创建用户和权限: 使用管理员权限创建用户和用户组,分配不同的权限。

-

使用功能:

-

聊天功能:与 AI 模型进行交互,支持 Markdown 和 LaTeX。

-

文档交互:加载文档到聊天中,使用 RAG 功能。

-

Web 搜索:通过 Web 搜索功能获取实时信息。

-

图像生成:集成图像生成工具,丰富聊天内容。

-

语音和视频通话:使用语音和视频通话功能进行无缝沟通。

-

五、Open WebUI 的应用场景

(一)企业内部 AI 平台

企业可以使用 Open WebUI 构建自己的内部 AI 平台,为员工提供智能助手、数据分析和文档处理等功能。通过离线运行和权限管理,确保企业数据的安全性和隐私性。

(二)教育机构

教育机构可以利用 Open WebUI 提供智能辅导工具,帮助学生更好地理解和学习课程内容。支持多语言和 Markdown 功能,能够满足不同语言背景学生的需求。

(三)个人开发者

个人开发者可以使用 Open WebUI 快速搭建自己的 AI 项目,支持多种 LLM 模型和自定义函数调用,能够满足不同开发需求。

(四)智能客服

企业可以将 Open WebUI 集成到客服系统中,提供智能客服功能,提升客户满意度。

(五)内容创作

内容创作者可以使用 Open WebUI 的图像生成和文档交互功能,提升创作效率和质量。

六、Open WebUI 的注意事项

(一)数据隐私

由于 Open WebUI 支持离线运行,数据存储在本地,用户无需担心数据泄露问题。然而,如果使用外部 API(如 OpenAI API),需要确保 API 密钥的安全性,避免泄露。

(二)模型选择

Open WebUI 支持多种 LLM 模型,用户可以根据自己的需求选择合适的模型。不同的模型在性能和功能上有所不同,用户需要根据自己的硬件配置和应用场景进行选择。

(三)硬件加速

如果使用 CUDA 加速,需要确保你的设备支持 NVIDIA GPU,并安装了相应的 CUDA Toolkit。使用 Docker 安装时,需要在命令中添加 --gpus all 参数。

(四)插件使用

Open WebUI 支持通过插件扩展功能,用户可以根据自己的需求安装和使用插件。然而,插件的使用可能会引入新的安全风险,用户需要确保插件来源可靠。

(五)更新与维护

Open WebUI 会定期发布新版本,用户需要及时更新以获取最新的功能和修复。如果使用 Docker 安装,可以通过 Watchtower 自动更新容器。

七、Open WebUI 的代码示例

(一)Python pip 安装代码示例

pip install open-webui

open-webui(二)Docker 安装代码示例

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main(三)使用 OpenAI API 示例

import requests

# OpenAI API 的 URL

url = "https://api.openai.com/v1/chat/completions"

# OpenAI API 的参数

headers = {

"Authorization": "Bearer YOUR_API_KEY",

"Content-Type": "application/json"

}

data = {

"model": "gpt-3.5-turbo",

"messages": [

{"role": "user", "content": "Hello, how are you?"}

]

}

# 发送请求

response = requests.post(url, headers=headers, json=data)

# 获取结果

result = response.json()

print(result["choices"][0]["message"]["content"])(四)使用 Ollama 模型示例

import requests

# Ollama API 的 URL

url = "http://localhost:11434/v1/chat/completions"

# Ollama API 的参数

data = {

"model": "ollama/model",

"messages": [

{"role": "user", "content": "Hello, how are you?"}

]

}

# 发送请求

response = requests.post(url, json=data)

# 获取结果

result = response.json()

print(result["choices"][0]["message"]["content"])八、Open WebUI 的流程图

(一)安装流程

(二)使用流程

九、Open WebUI 的总结

Open WebUI 是一个功能强大且用户友好的自托管 AI 平台,支持多种 LLM 运行器和丰富的功能扩展。通过离线运行和权限管理,Open WebUI 能够满足企业、教育机构和个人开发者的需求,提供安全、高效和灵活的 AI 部署解决方案。无论是在企业内部 AI 平台、教育工具、智能客服还是内容创作中,Open WebUI 都能够发挥重要作用。希望本文能够帮助读者更好地了解和使用 Open WebUI,为 AI 项目的开发和部署提供便利。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?