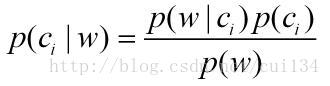

朴素贝叶斯是一种基于概率论的分类方法,它是在分类过程中计算不同类别的后验概率,哪一个类别的后验概率大,那么就将该类别作为分类的结果。其中的关键步骤就是对后验概率的计算。后验概率的计算公式如下:

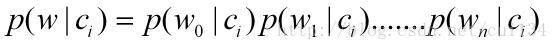

其中i代表的是类别,w代表的是特征向量,后验概率的实际意义就是在得到特征向量的条件下,该向量属于类别i的概率。为了计算后验概率,我们需要计算三个项,通常,我们考虑每一个特征向量的P(w)相等,因此也就不需要计算P(w),对于P(Ci),通过计算在训练数据中类别i的个数与训练数据总个数的比值来得到,通常,我们选取的不同类别的个数是相同的,所以这一项通常也是相等的。下面重点就是如何计算P(w|ci),这里的w=(w0,w1,w2....wn),那么计算P(w|ci)可以通过计算P(w0,w1,w2....wn|ci)来得到。朴素贝叶斯分类为什么叫做“朴素”,就是因为它经常考虑的是一些理想情况,所以在这里,我们认为w0,w1,w2...wn相互独立,那么就可以得到下面公式:

这里的每一项P(wn|ci)都是通过计算训练数据来得到的,因此,这个计算过程也就是对数据的训练过程。

朴素贝叶斯分类有很多应用,这里介绍一个在留言板中屏蔽侮辱性言论的例子。对此问题,我们建立两个类别,侮辱性和非侮辱性,使用1和0来分别表示。

首先,准备数据

def loadDataSet():

postingList=[['my', 'dog', 'has', 'flea', 'problems', 'help', 'please'],

['maybe', 'not', 'take', 'him', 'to', 'dog', 'park', 'stupid'],

['my', 'dalmation', 'is', 'so', 'cute', 'I', 'love', 'him'],

['stop', 'posting', 'stupid', 'worthless', 'garbage'],

['mr', 'licks', 'ate', 'my', 'steak', 'how', 'to', 'stop', 'him'],

['quit', 'buying', 'worthless', 'dog', 'food', 'stupid']]

classVec = [0,1,0,1,0,1] #1 侮辱, 0 非侮辱

return postingList,classVec这里有6组数据,即6个留言,保存为列表形式。这里的数据是文档,那么如何将这个文档表达为一个向量,这里用的方法是首先建立一个词汇表,词汇表包含了训练数据中所有的词汇,但不重复,相当于是所有词汇的一个集合,然后,对于每一个留言,建立一个与词汇表等长的向量,如果词汇表里的单词在留言中出现,那么向量中该单词的位置处的值就+1,这样就形成了一个文档向量。

def createVocabList(dataSet):#建立词汇表

vocabSet=set([])

for document in dataSet:

vocabSet=vocabSet|set(document)

return list(vocabSet)

def bagOfWords2VecMN(vocabList,inputSet):#将文档转换为文档向量

returnVec=[0]*len(vocabList)

for word in inputSet:

if word in vocabList:

returnVec[vocabList.index(word)]+=1

else:

print "the word: %s is not in my Vocabulary" % word

return returnVecdef trainWords2Vec(dataSet,vocabList):#将文档转换为文档向量矩阵

returnMat=[]

for i in range(len(dataSet)):

returnMat.append(setOfWords2Vec(vocabList,dataSet[i]))

return returnMat

>>> trainMat=Bayes.trainWords2Vec(lp,mvolist)

>>> trainMat

[[0, 0, 1, 0, 0, 0, 1, 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 1, 1, 0, 0, 0, 0, 0, 0, 1], [0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0, 1, 1, 0, 0, 0, 0, 0, 1, 1, 0, 1, 0, 1, 0, 1, 0, 0, 0], [1, 1, 0, 0, 0, 1, 0, 1, 0, 0, 0, 1, 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 1], [0, 0, 0, 1, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 1, 0, 1, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0], [0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 1, 0, 0, 1, 0, 0, 0, 0, 1, 1, 0, 0, 0, 1, 0, 0, 0, 1, 1, 1], [0, 0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 1, 0, 0, 1, 0, 0, 0, 0, 1, 0, 1, 0, 0, 0, 0, 0]]

def trainNB0(trainMatrix,trainCategory):#训练函数

numTrainDocs=len(trainMatrix)

numWords=len(trainMatrix[0])

pAbusive=sum(trainCategory)/float(numTrainDocs)

p0Num=np.ones(numWords)

p1Num=np.ones(numWords)

p0Denom=2.0

p1Denom=2.0

for i in range(numTrainDocs):

if trainCategory[i]==1:

p1Num+=trainMatrix[i]

p1Denom+=sum(trainMatrix[i])

else:

p0Num+=trainMatrix[i]

p0Denom+=sum(trainMatrix[i])

p1Vect=np.log(p1Num/p1Denom)#词汇表中元素属于1的概率

p0Vect=np.log(p0Num/p0Denom)#词汇表中元素属于0的概率

return p0Vect,p1Vect,pAbusive这里的p0Num和p1Num初始化为1,因为若为0,在后面概率相乘时,可能会得到后验概率为0,从而识别错误。

识别函数def classifyNB(testVec,p0Vect,p1Vect,pClass):

P1=sum(testVec*p1Vect)+np.log(pClass)

P0=sum(testVec*p0Vect)+np.log(1-pClass)

if P1>P0:

return 1

else:

return 0测试:

def testingNB():

listPost,listClass=loadDataSet()

myVocabList=createVocabList(listPost)

trainMat=trainWords2Vec(listPost,myVocabList)

p0V,p1V,pAb=trainNB0(trainMat,listClass)

testEntry = ['love', 'my', 'dalmation']#测试数据

thisDoc = np.array(setOfWords2Vec(myVocabList, testEntry))

print testEntry,'classified as: ',classifyNB(thisDoc,p0V,p1V,pAb)

testEntry = ['stupid', 'garbage']#测试数据

thisDoc = np.array(setOfWords2Vec(myVocabList, testEntry))

print testEntry,'classified as: ',classifyNB(thisDoc,p0V,p1V,pAb)>>> Bayes.testingNB()

['love', 'my', 'dalmation'] classified as: 0

['stupid', 'garbage'] classified as: 1

这样,就可以对留言分类,是否是侮辱性言论。

下面一个例子是利用朴素贝叶斯分类过滤垃圾邮件

首先,生成训练数据,训练数据保存在email文件夹下,email文件夹下有两个文件夹,分别是ham和spam,ham中是25个txt格式的邮件,都不是垃圾邮件,spam中有25个txt格式的垃圾邮件。下面对邮件进行分类

def textParse(bigString): #将输入字符串转换成字符列表

import re

listOfTokens = re.split(r'\W*', bigString)

return [tok.lower() for tok in listOfTokens if len(tok) > 2]

def spamTest():

docList=[]; classList = []; fullText =[]

for i in range(1,26):#导入文件

wordList = textParse(open('email/spam/%d.txt' % i).read())#垃圾邮件

docList.append(wordList)

fullText.extend(wordList)

classList.append(1)

wordList = textParse(open('email/ham/%d.txt' % i).read())#非垃圾邮件

docList.append(wordList)

fullText.extend(wordList)

classList.append(0)

vocabList = createVocabList(docList)#创建包含所有字符的集合

trainingSet = range(50); testSet=[]

for i in range(10):#测试数据,随机抽取

randIndex = int(np.random.uniform(0,len(trainingSet)))

testSet.append(trainingSet[randIndex])

del(trainingSet[randIndex])

trainMat=[]; trainClasses = []

for docIndex in trainingSet:#训练数据

trainMat.append(bagOfWords2VecMN(vocabList, docList[docIndex]))

trainClasses.append(classList[docIndex])

p0V,p1V,pSpam = trainNB0(np.array(trainMat),np.array(trainClasses))

errorCount = 0

for docIndex in testSet: #对测试数据测试

wordVector = bagOfWords2VecMN(vocabList, docList[docIndex])

if classifyNB(np.array(wordVector),p0V,p1V,pSpam) != classList[docIndex]:

errorCount += 1

print "classification error",docList[docIndex]

print 'the error rate is: ',float(errorCount)/len(testSet)>>> Bayes.spamTest()

the error rate is: 0.0

>>> Bayes.spamTest()

classification error ['home', 'based', 'business', 'opportunity', 'knocking', 'your', 'door', 'don', 'rude', 'and', 'let', 'this', 'chance', 'you', 'can', 'earn', 'great', 'income', 'and', 'find', 'your', 'financial', 'life', 'transformed', 'learn', 'more', 'here', 'your', 'success', 'work', 'from', 'home', 'finder', 'experts']

the error rate is: 0.1

450

450

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?