1. 局部连接/权值共享/池化操作/多层次结构

CNN抓住此共性的手段主要有四个:局部连接/权值共享/池化操作/多层次结构。

局部连接使网络可以提取数据的局部特征;

权值共享大大降低了网络的训练难度,一个Filter只提取一个特征,在整个图片(或者语音/文本) 中进行卷积;

池化操作与多层次结构一起,实现了数据的降维,将低层次的局部特征组合成为较高层次的特征,从而对整个图片进行表示。

2. 全卷积/Local-Conv

如果每一个点的处理使用相同的Filter,则为全卷积,如果使用不同的Filter,则为Local-Conv。

3. 激活函数

激活函数的主要作用是提供网络的非线性建模能力。加入激活函数是用来加入非线性因素的,解决线性模型所不能解决的问题。

常见的激活函数有sigmoid函数/ ReLU

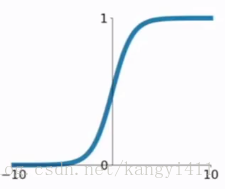

sigmoid函数

输出是在(0,1)这个开区间内

缺陷:

1) 当输入稍微远离了坐标原点,函数的梯度就变得很小了,几乎为零。在神经网络反向传播的过程中,我们都是通过微分的链式法则来计算各个权重w的微分的。当反向传播经过了sigmod函数,这个链条上的微分就很小很小了,况且还可能经过很多个sigmod函数,最后会导致权重w对损失函数几乎没影响,这样不利于权重的优化,这个问题叫做梯度饱和,也可以叫梯度弥散。

2) 函数输出不是以0为中心的,这样会使权重更新效率降低。

3) sigmod函数要进行指数运算,计算比较慢。

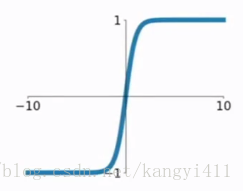

tanh函数

tanh是双曲正切函数,tanh函数和sigmod函数的曲线是比较相近的。首先相同的是,这两个函数在输入很大或是很小的时候,输出都几乎平滑,梯度很小,不利于权重更新;不同的是输出区间,tanh的输出区间是在(-1,1)之间,而且整个函数是以0为中心的,这个特点比sigmod的好。

一般二分类问题中,隐藏层用tanh函数,输出层用sigmod函数。

ReLU函数

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

4814

4814

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?