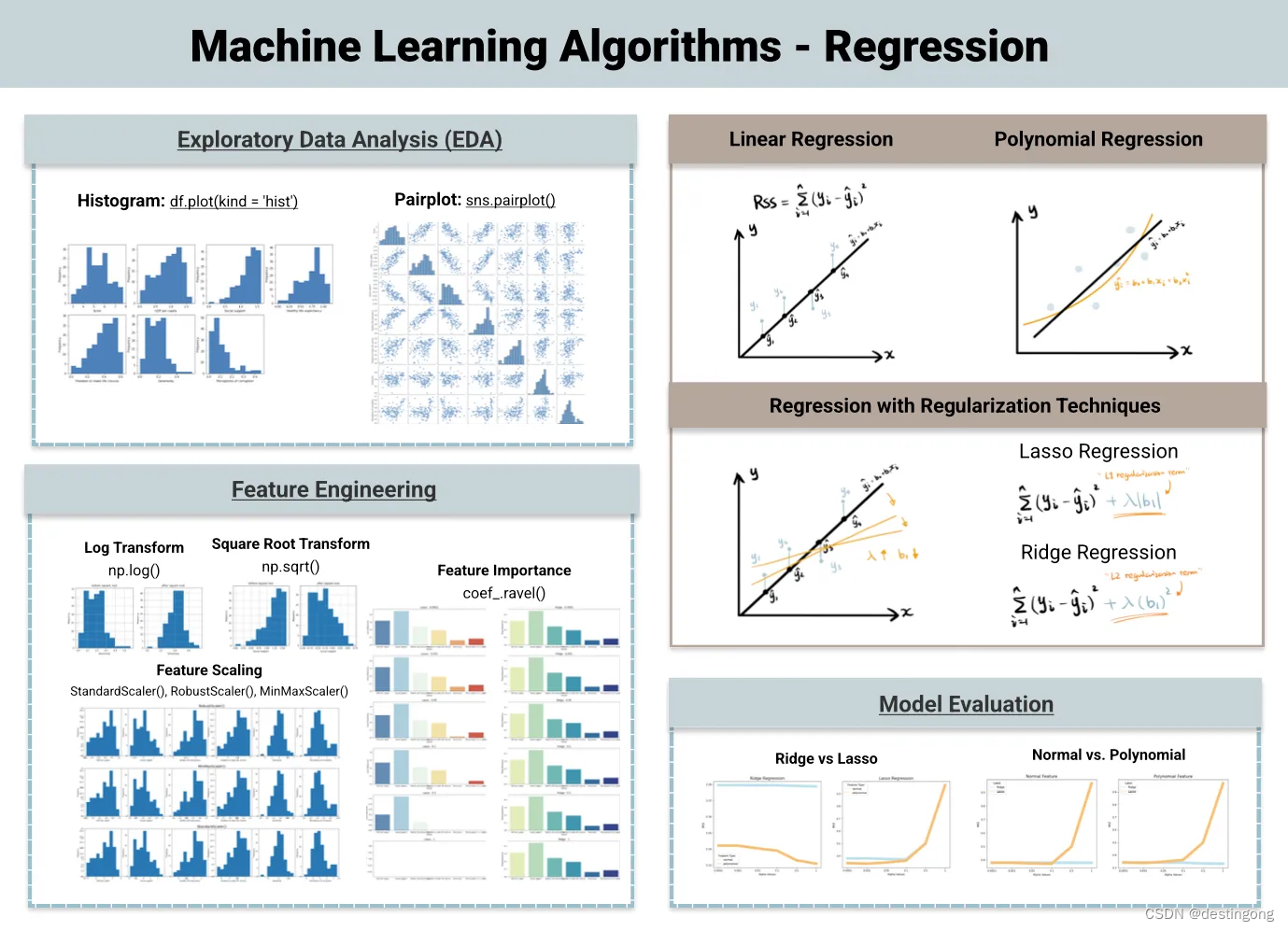

在之前的帖子中,我们概述了常见的分类算法,现在让我们深入了解另一类监督学习 - 回归,其中输出变量是连续的和数字的。 有四种常见的回归模型。

- 线性回归(Linear Regression)

- Lasso 回归(Lasso Regression)

- Ridge 回归 (Ridge Regression)

- 多项式回归 (Polynomial Regression)

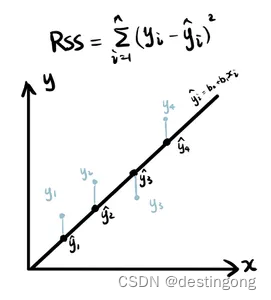

线性回归

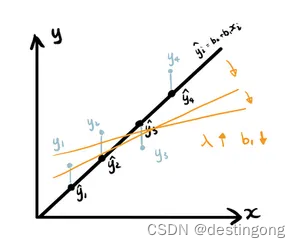

线性回归寻找自变量和因变量之间的最佳线性关系,从而进行相应的预测。最简单的形式是y = b0 + b1x。当只有一个输入特征时,线性回归模型在二维空间中拟合直线,以最小化预测值和实际值之间的残差。衡量残差大小的常见成本函数(cost function)是残差平方和(RSS)。随着更多特性的引入,简单线性回归演变为多元线性回归 y = b0 + b1x1 + b2x2 + ... + bnxn。

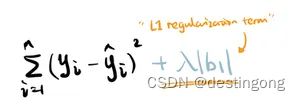

Lasso回归

Lasso回归是具有L1正则化 (L1 Regularization)的线性回归变体。简单来说,它只是在试图最小化的回归模型的残差中添加了一个额外的元素。之所以被称为L1正则化,是因为这个添加的正则化项与系数的绝对值成正比。与Ridge回归相比,它更擅长将一些特征的系数降至0,因此适用于特征消除。我们将在之后的“特征重要性”部分回顾这一点。

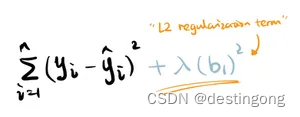

Ridge回归

Ridge回归是线性回归另一种具有L2正则化 (L2 Regularization)的变体。因此,不难推断正则化项是基于系数的平方值的次方。相比于Lasso回归,脊回归具有收敛更快,消耗时间更少的优点。

Lasso和Ridge的正则化强度由值确定。较大的

值会使系数值缩小,使模型更平坦,

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1133

1133

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?