问题

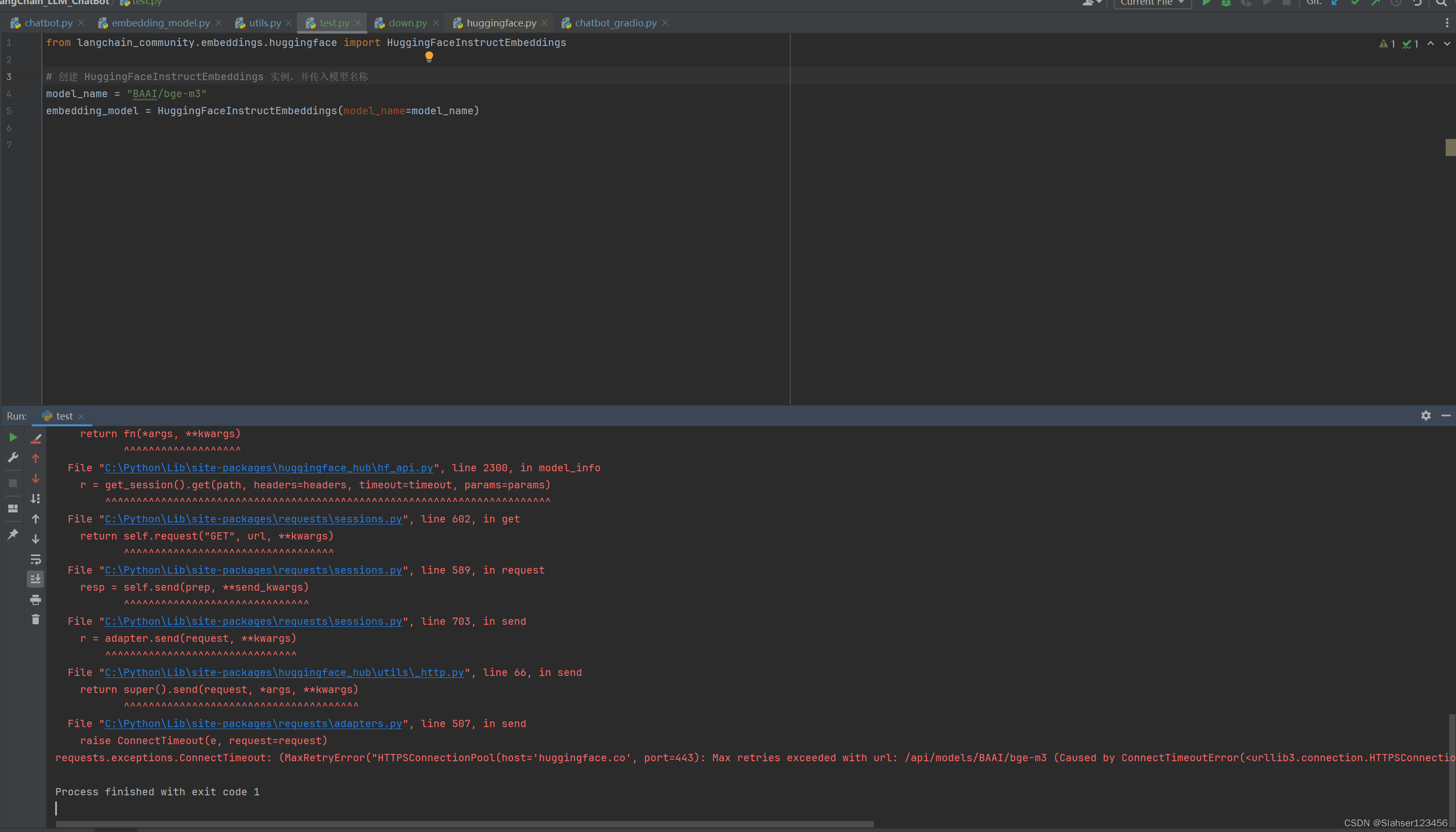

因业务需要在本机测试embedding分词模型,使用 huggingface上的transformers 加载模型时,因为网络无法访问,不能从 huggingface 平台下载模型并加载出现如下错误。

下面提供几种模型下载办法

解决

有三种方式下载模型,一种是通过 huggingface model hub 的按钮下载,一种是使用 huggingface 的 transformers 库实例化模型进而将模型下载到缓存目录(上述报错就是这种),另一种是通过 huggingface 的 huggingface_hub 工具进行下载。下面介绍两种方式:

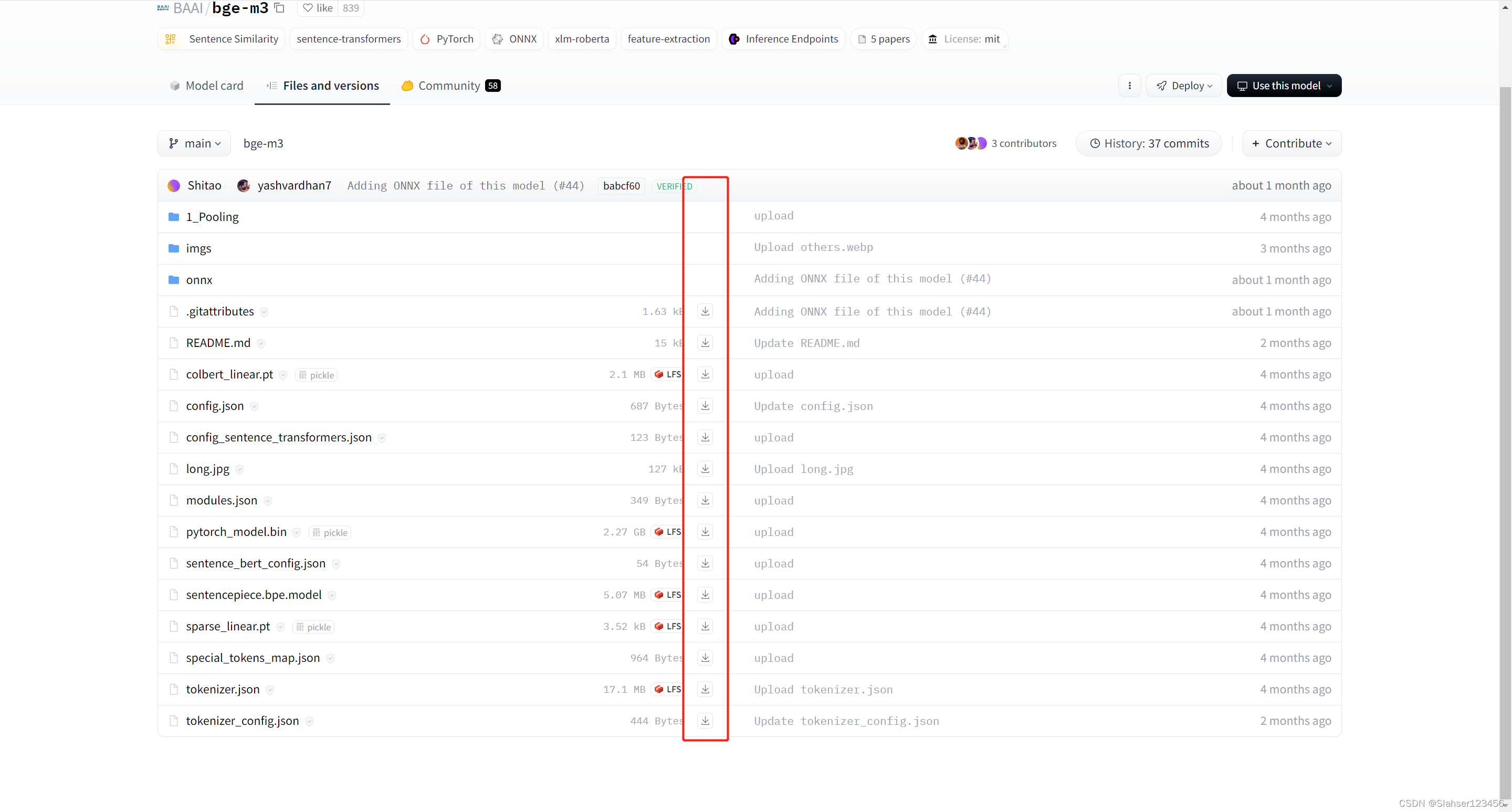

huggingface 按钮下载

点击下图的下载按钮,把所有文件下载到一个目录即可。

因网络原因无法下载可使用访问镜像HF-Mirror - Huggingface 镜像站

解决HuggingFaceTransformers模型下载问题:网络受限与替代方法

解决HuggingFaceTransformers模型下载问题:网络受限与替代方法

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

5万+

5万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?