Low-Rank Adaptation (LoRA)是一种流行的训练技术,因为它速度快,生成的文件大小较小(几百MB)。LoRA可以训练模型从几个图像中学习新风格。它的工作原理是在Stable Diffusion模型中插入新的权重,然后只训练新的权重而不是整个模型。这使得LoRA训练更快,存储更容易。

LoRA是一种非常通用的训练技术,可以与其他训练方法一起使用。例如,使用DreamBooth和LoRA训练模型是很常见的。加载和合并多个LoRA以创建新的独特图像也越来越普遍。

import os

os.environ["HF_ENDPOINT"] = "https://hf-mirror.com"

rom diffusers import AutoPipelineForText2Image

import torch

pipeline = AutoPipelineForText2Image.from_pretrained("stabilityai/stable-diffusion-xl-base-1.0",

torch_dtype=torch.float16).to("cuda")

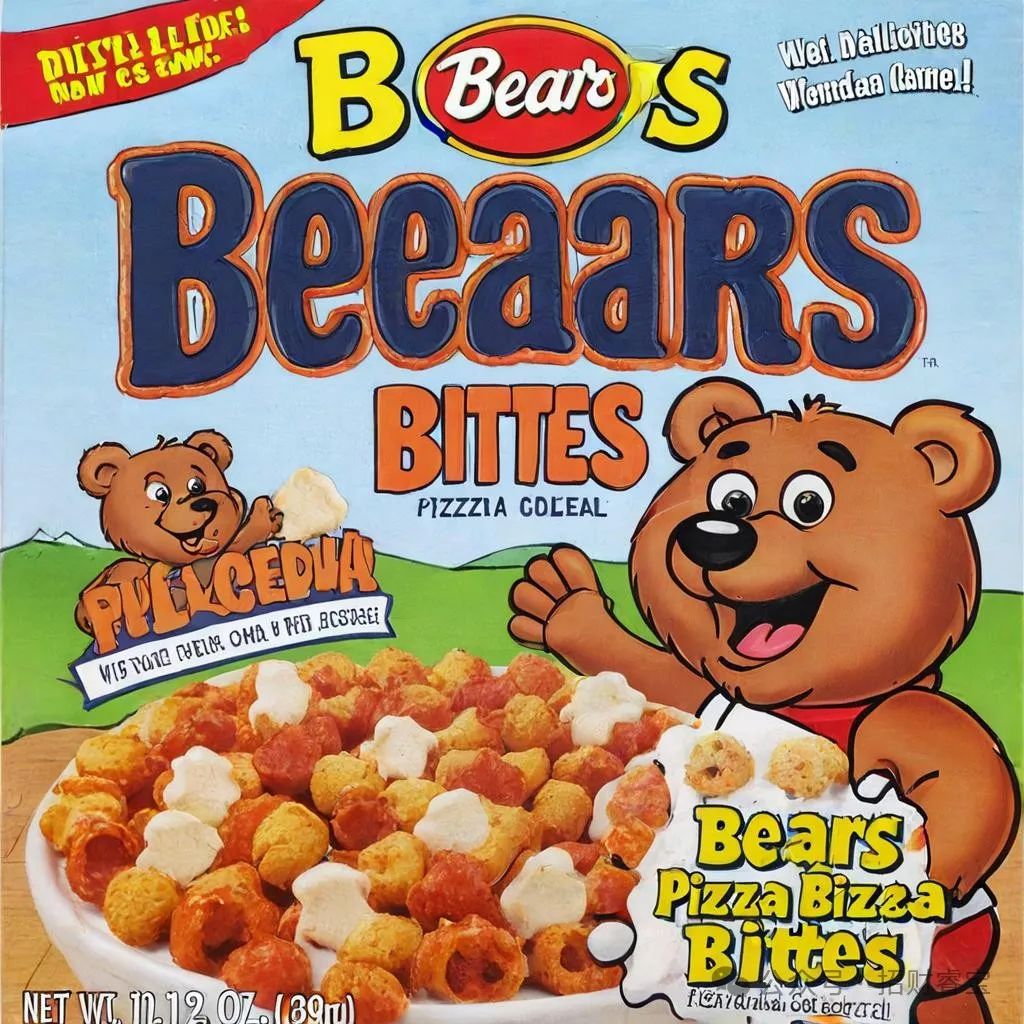

pipeline.load_lora_weights("ostris/super-cereal-sdxl-lora", weight_name="cereal_box_sdxl_v1.safetensors")

prompt = "bears, pizza bites"

image = pipeline(prompt).images[0]

image.save("load.jpg")

2535

2535