sparse_softmax_cross_entropy_with_logits实际上是softmax和cross_entropy(交叉熵)两个函数的组合

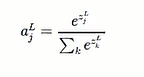

一、softmax

核心是做归一化

而softmax把一个k维的real value向量(a1,a2,a3,a4….)映射成一个(b1,b2,b3,b4….)其中bi是一个0-1的常数,然后可以根据bi的大小来进行多分类的任务,如取权重最大的一维。

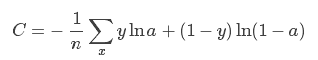

二、交叉熵代价函数

梯度与误差loss有关,避免了饱和梯度趋近于0的问题

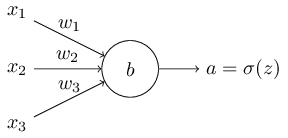

对于多输入单输出的神经元结构而言,如下图所示:

我们将其损失函数定义为:

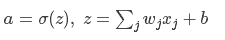

其中:

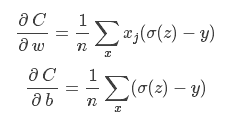

最终求导得:

学习的快慢取决于

σ(z) - y

也就是输出的error

好处:错误大时,更新多,学的快

错误小时,学习慢

避免了

σ′(z) 参与参数更新、影响更新效率的问题;

1145

1145

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?