最近在做UAC的项目,大概就是接收内核UAC的事件,也就是声音相关事件。然后就是pcm_read和AudioTrackr->write之间互传。感觉略微有点奇怪,所以简单总结一下。

1 UAC的简要流程

open_netlink_socket 打开内核窗口,类似于ioctl。

recvfrom 接收数据。

UAC_CAP_START 处理开始播放事件。

host_to_device

tracker_data_thread 播放线程。

pcm_read->(AudioTrackr->write)

pcm_open

pcm_read

pcm_close

UAC_CAP_STOP 处理停止播放事件。

UAC_PLAY_START 处理开始录音事件。

device_to_host

recorder_data_thread

(AudioRecord->read)<-pcm_write

pcm_open

pcm_write

pcm_close

UAC_PLAY_STOP 处理停止录音事件。

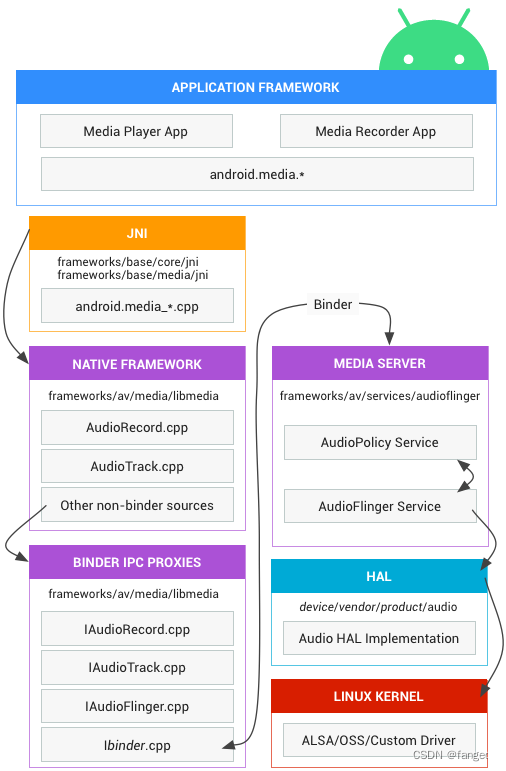

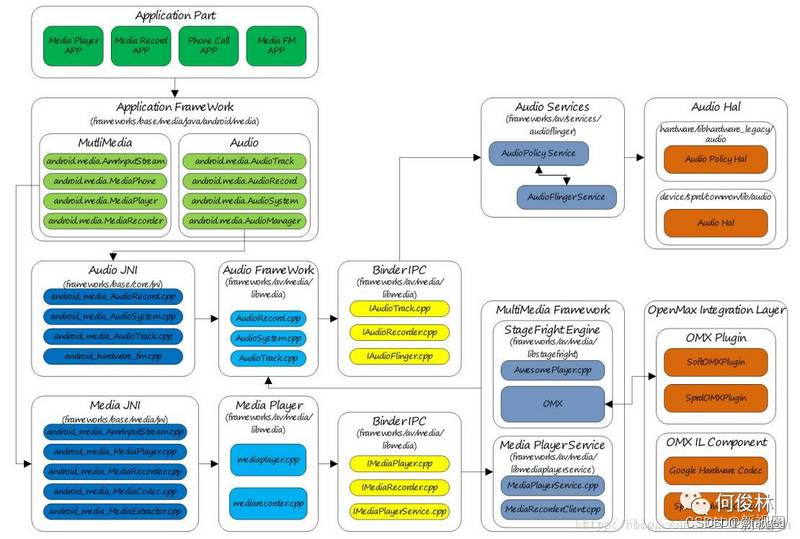

2 安卓音频系统

https://source.android.com/docs/core/audio?hl=zh-cn

https://source.android.com/docs/core/audio?hl=zh-cn

关于UAC的内容,居然也有说:

https://source.android.com/docs/core/audio/usb?hl=zh-cn

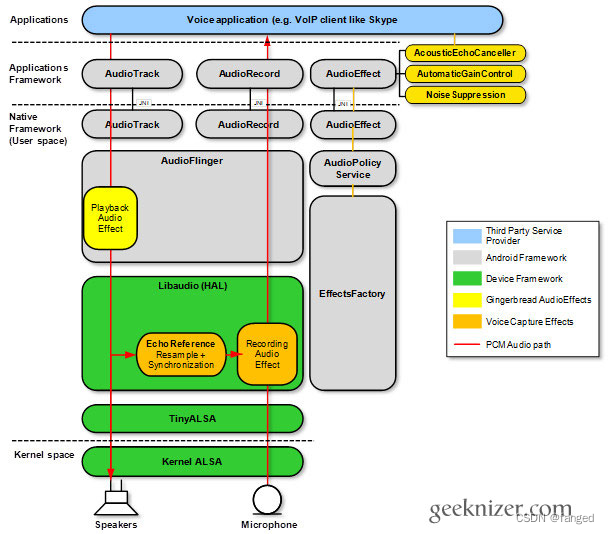

不过下面这两个图我觉得直观一丢丢。

下面这个都包浆了。。。

大致就是几层:

1 Java App层,这一层封装最完善,但是只有最常规的操作,给开发app的帅哥做傻瓜式操作的。使用android.media.MediaPlayer。

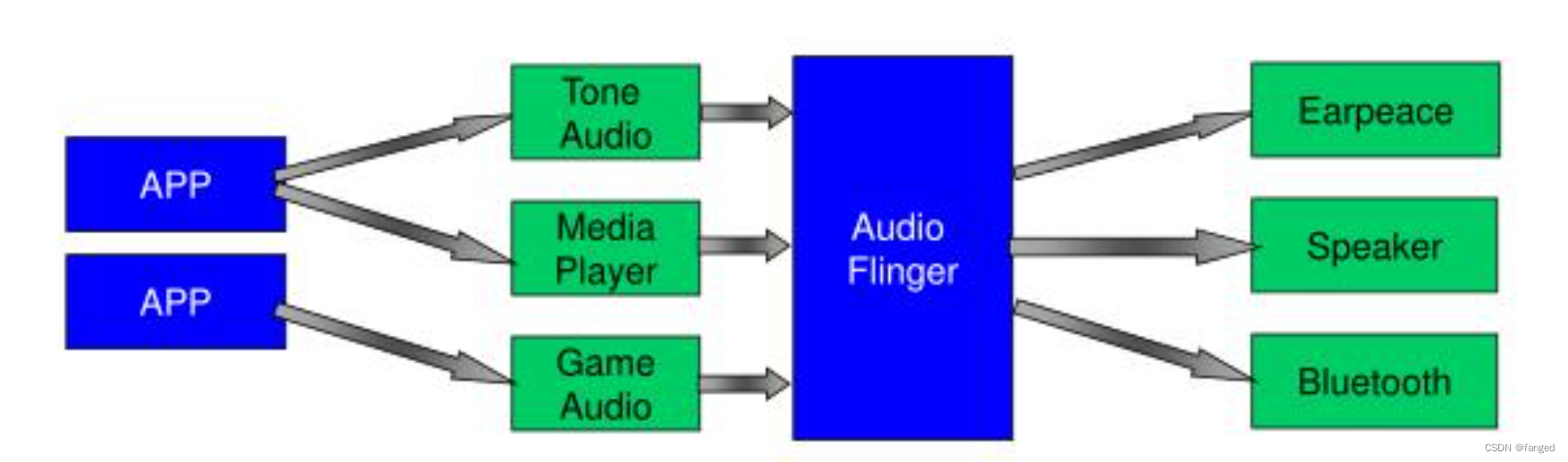

2 Framework层,这一层可以使用AudioTracker和AudioRecorder,这一层接口比较底层一点,提供的功能比较多。可以实现实时处理和一些特效。Java和C++都可以用。下面还有个AudioFlinger,是用来做混音的。也是上下层的分隔。所以绕过Framework层,直接用HAL的接口,可能就有问题。

3 HAL接口。有HIDL和AIDL的,这一层理论上可以用,但是貌似比较少,起码我们公司的大神都不在这层搞事。

4 ALSA接口,这一层是标准Linux的,花样也是非常多。

3 App接口

没啥好说的,这部分我也不是太熟悉,直接怼media.MediaPlayer即可。代码说明一切吧。

package com.example.audioplayer;

import android.media.MediaPlayer;

import android.os.Bundle;

import android.view.View;

import android.widget.Button;

import androidx.appcompat.app.AppCompatActivity;

public class MainActivity extends AppCompatActivity {

private MediaPlayer mediaPlayer;

@Override

protected void onCreate(Bundle savedInstanceState) {

super.onCreate(savedInstanceState);

setContentView(R.layout.activity_main);

Button playButton = findViewById(R.id.play_button);

Button stopButton = findViewById(R.id.stop_button);

// 播放本地音频文件

mediaPlayer = MediaPlayer.create(this, R.raw.example_audio);

// 如果你想播放网络音频流,可以使用下面的代码

// mediaPlayer = new MediaPlayer();

// try {

// mediaPlayer.setDataSource("http://your-audio-url.com/audio.mp3");

// mediaPlayer.prepare(); // 同步准备,可能会阻塞主线程,建议使用异步准备

// } catch (IOException e) {

// e.printStackTrace();

// }

playButton.setOnClickListener(new View.OnClickListener() {

@Override

public void onClick(View v) {

if (mediaPlayer != null && !mediaPlayer.isPlaying()) {

mediaPlayer.start();

}

}

});

stopButton.setOnClickListener(new View.OnClickListener() {

@Override

public void onClick(View v) {

if (mediaPlayer != null && mediaPlayer.isPlaying()) {

mediaPlayer.stop();

// 重新准备MediaPlayer

mediaPlayer.prepareAsync();

}

}

});

}

@Override

protected void onDestroy() {

super.onDestroy();

if (mediaPlayer != null) {

mediaPlayer.release();

mediaPlayer = null;

}

}

}

4 AudioTracker和AudioRecorder

我这次项目用的就是这两个,其实还是挺简单,看个例子就够了。。。

#include <android/media/AudioTrack.h>

// 假设audioBuffer是一个已经加载好的音频数据的short数组

short audioBuffer[]; // 音频数据填充到这个数组中

int bufferSize = audioTrack->frameCount() * audioTrack->channelCount(); // 计算缓冲区大小

// 创建一个AudioTrack实例

auto audioTrack = new android::media::AudioTrack(

android::media::AudioTrack::STREAM_MUSIC, // 音频流类型

44100, // 采样率44.1kHz

android::media::AudioTrack::CHANNEL_OUT_STEREO, // 立体声输出

android::media::AudioTrack::TRANSFER_MODE_STATIC, // 静态模式

bufferSize, // 缓冲区大小

android::media::AudioTrack::MODE_STATIC // 静态播放模式

);

// 开始播放音频

audioTrack->start();

// 写入数据到AudioTrack缓冲区

audioTrack->write(audioBuffer, bufferSize);

// 播放完毕,暂停并释放资源

audioTrack->stop();

delete audioTrack;5 HAL

这部分位于vendor,上面的是位于system,所以还是区别很大。如果要在vendor搞事情,还是要用这个部分。

定义是在这个地方:https://android.googlesource.com/platform/hardware/interfaces/+/refs/heads/master/audio/

但是比较疑惑的一点是单位有大神说直接调用Hal,会碰坏系统。。。存疑中。。。

用的话直接用hardware/audio.h就可以。

#include <jni.h>

#include <string>

#include <android/log.h>

#include <hardware/hardware.h>

#include <hardware/audio.h>

#define LOG_TAG "NativeAudio"

#define LOGD(...) __android_log_print(ANDROID_LOG_DEBUG, LOG_TAG, __VA_ARGS__)

extern "C" JNIEXPORT void JNICALL

Java_com_example_audioplayer_MainActivity_nativeInitAudio(JNIEnv *env, jobject thiz) {

LOGD("Initializing Audio HAL");

hw_module_t *module = nullptr;

hw_device_t *device = nullptr;

// Load the audio hardware module

if (hw_get_module(AUDIO_HARDWARE_MODULE_ID, (const hw_module_t **)&module) == 0) {

LOGD("Audio module loaded");

// Open the audio hardware device

if (module->methods->open(module, AUDIO_HARDWARE_INTERFACE, &device) == 0) {

LOGD("Audio device opened");

audio_hw_device_t *audioDevice = (audio_hw_device_t *)device;

if (audioDevice && audioDevice->init_check(audioDevice) == 0) {

LOGD("Audio device initialized");

// Set up and start playback using audio_stream_out

audio_stream_out_t *streamOut = nullptr;

audioDevice->open_output_stream(audioDevice, 0, AUDIO_DEVICE_OUT_SPEAKER,

AUDIO_OUTPUT_FLAG_NONE, nullptr, &streamOut, nullptr);

if (streamOut) {

LOGD("Audio stream out opened");

// Simplified example to play a buffer (should use actual audio data)

size_t bufferSize = streamOut->common.get_buffer_size(&streamOut->common);

uint8_t *buffer = new uint8_t[bufferSize];

memset(buffer, 0, bufferSize); // Fill buffer with silence or actual audio data

streamOut->write(streamOut, buffer, bufferSize);

delete[] buffer;

audioDevice->close_output_stream(audioDevice, streamOut);

} else {

LOGD("Failed to open audio stream out");

}

} else {

LOGD("Audio device initialization failed");

}

device->close(device);

} else {

LOGD("Failed to open audio device");

}

} else {

LOGD("Failed to load audio module");

}

}

6 ALSA

这个部分有点略大,看看下次写吧。。。还有一个OMX,以后有心情再写吧。。。

一些调试工具,tinymix,可以用来调试声卡的驱动。

最后回到一开始说的UAC,应该是新生成了音频的节点,然后可以从这个节点读取音频数据,但是最后要将声音从Android的接口放出去,所以那么搞。之前调试的时候,在UAC的模式下,好像也确实是生成了两张声卡。这部分感觉内容也挺多了,下次再总结。

参考:

https://source.android.com/docs/core/audio?hl=zh-cn

3105

3105

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?