概述

通过前两小节的介绍,可以清楚的了解RNN模型的网络结构以及LSTM。本小节主要介绍RNN其他变形以及应用,包括

1.GRU单元

2.序列到序列(Seq2Seq)模型

3.注意力(Attention)模型

4.RNN在NLP中的应用

5.总结

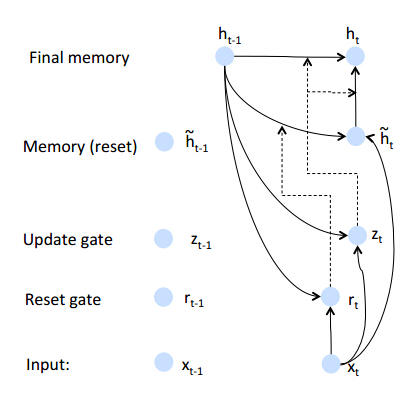

GRU单元

GRU通过引入重置门和遗忘门来解决长期依赖问题,相对于LSTM有更少参数并且在某些问题上,效果好于LSTM。

- 重置门

rt=σ(Wrx+Urht−1)如果重置门关闭,会忽略掉历史状态,即将历史不相干的信息不会影响未来的输出。- 遗忘门

zt=σ(Wzx+Uzht−1)遗忘门能够控制历史信息对当前输出的影响,如果遗忘门接近1,此时会把历史信息传递下去- 节点状态

h^t=tanh(Wx+rtoUht−1)- 输出

ht=ztoht−1+(1−zt)oh^t

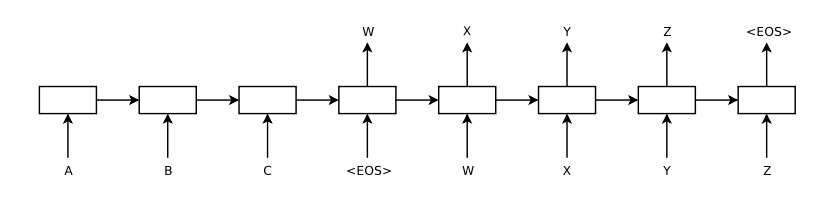

Seq2Seq模型

序列到序列模型可以解决很多不定长输入到输出的变换问题,等价于编码和解码模型,即编码阶段将不定长输入编码成定长向量;解码阶段对输出进行解码。

1.其中序列ABC是输入序列,WXYZ是输出序列,EOS是结束符号

2.模型分为两个阶段1)encode阶段,该阶段将输入序列编码成一个定长维度的向量2)decode阶段,根据编码后向量预测输出向量。

3.编码过程,可以使用标准的RNN模型,例如htyt=f(Whxxt+Whhht−1)=Whyht

4.解码过程,也可以使用一个标准的RNN模型进行解码,例如RNN-LMp(y1,y2...yM|x1,x

本文深入探讨了循环神经网络(RNN)的应用,包括GRU单元的原理,Seq2Seq模型在不定长输入到输出转换中的作用,以及注意力机制如何增强模型性能。重点介绍了注意力模型的通用框架和在机器翻译中的具体应用。此外,还列举了RNN在命名实体识别、情感分析等任务中的应用。

本文深入探讨了循环神经网络(RNN)的应用,包括GRU单元的原理,Seq2Seq模型在不定长输入到输出转换中的作用,以及注意力机制如何增强模型性能。重点介绍了注意力模型的通用框架和在机器翻译中的具体应用。此外,还列举了RNN在命名实体识别、情感分析等任务中的应用。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?