1. 坐标下降法

coordinate descent method 【1】

对于一个最优化问题:min_x F(x_1,x_2,...x_n),其求解过程如下:

Loop until convergence:

{

For i=1:n

{

x_i = arg min_x_i F(x_1,x_2,...,x_i-1,x_i,x_i+1,...,x_n);

}

}

可以看出:

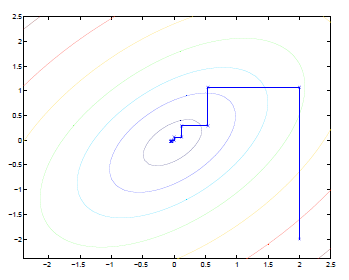

(1)坐标下降法在每次迭代中在当前点处沿一个坐标方向进行一维搜索 ,固定其他的坐标方向,找到一个函数的局部极小值。

(2)坐标下降优化方法是一种非梯度优化算法。在整个过程中依次循环使用不同的坐标方向进行迭代,一个周期的一维搜索迭代过程相当于一个梯度迭代。

(3)gradient descent 方法是利用目标函数的导数(梯度)来确定搜索方向的,该梯度方向可能不与任何坐标轴平行。而coordinate descent方法是利用当前坐标方向进行搜索,不需要求目标函数的导数,只按照某一坐标方向进行搜索最小值。

此种算法,在latenSVM-DPM中有使用。

2. 牛顿法

3. 梯度下降法

659

659

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?