《Simple Baselines for Human Pose Estimation and Tracking》阅读笔记

《Simple Baselines for Human Pose Estimation and Tracking》阅读笔记

原文链接:https://arxiv.org/pdf/1804.06208.pdf

这篇文章出自MSRA,主要做了两个工作,一个是姿态检测(即人体的关键点检测),第二个是基于姿态检测进行人体运动轨迹追踪。

姿态检测

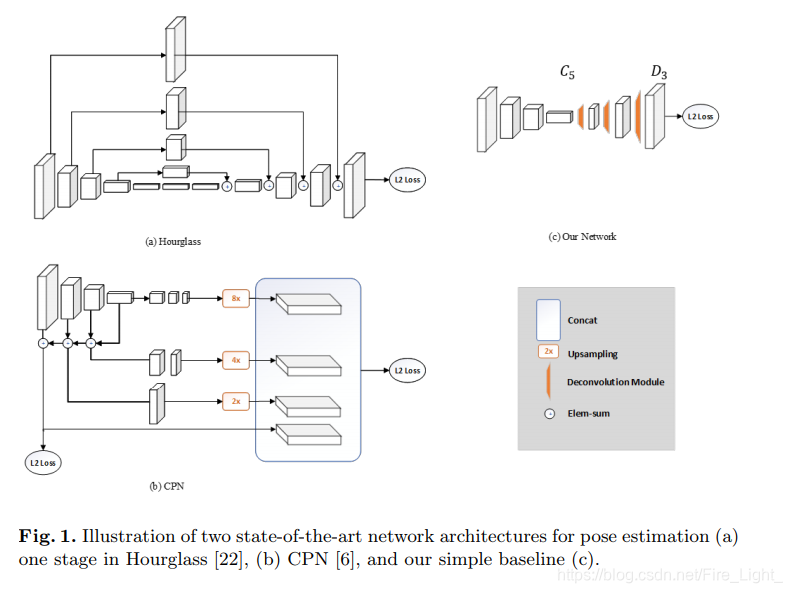

正如论文的标题,作者在文中提出的姿态检测方法是一种简单的baseline(图1©),相比于Hourglass与CPN,本文并没有使用什么华丽的技巧,仅仅是在ResNet中插入了几层反卷积,将低分辨率的特征图扩张为原图大小,以此生成预测关键点需要的Heatmap。没有任何的特征融合,网络结构非常简单,相较于Hourglass和CPN,唯一较为新颖的点是引入了Deconvolution来替换Upsampling与convolution组成的结构。

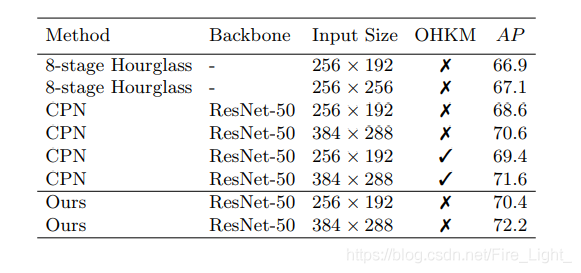

但是本文的方法在COCO关键点检测的任务上比CPN,Hourglass得到了更高的AP,如图:

文中解释为“ the performance difference could come from implementation difference”,也就是本文可能在调参、数据增强等方面可能做得很好,才有这样的结果。比如文中提到使用原图和翻转过的图片同时测试,以及最终结果会由Heatmap的最大值点向第二大值点进行一些偏移等技巧(看起来有点像做比赛^ ^),其他我就不一一翻译了,感兴趣的可以直接查看原文。

轨迹追踪

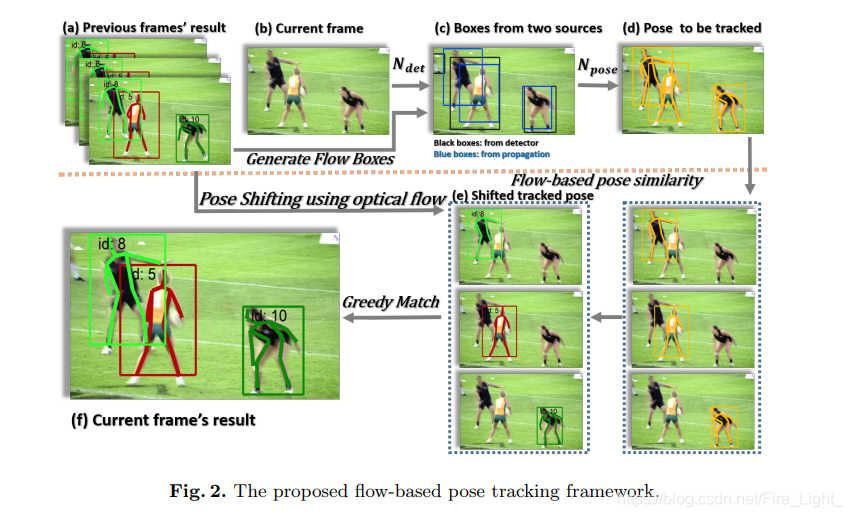

文中先介绍了ICCV’17 PoseTrack Challenge的优胜者解决多人轨迹追踪的一种算法,简单来说就是使用MaskRcnn来进行人的检测,在视频第一帧中每个检测到的人给一个id,然后之后的每一帧检测到的人都和上一帧检测到的人通过某种度量方式(文中提到的是计算检测框的IOU)算一个相似度,将相似度大的作为同一个id,没有匹配到的分配一个新的id。

本文提出的方法保留了这一方法的主要流程,并且在此之上提出了两点改进:

一是除了检测网络之外,还使用光流法补充一些检测框,用以解决检测网络的漏检问题(比如图2©中最左边的人就没有被检测网络检测到)。

二是使用 Object Keypoint Similarity (OKS)代替检测框的IOU来计算相似度。这是因为当人的动作比较快时,用IOU可能并不合理。

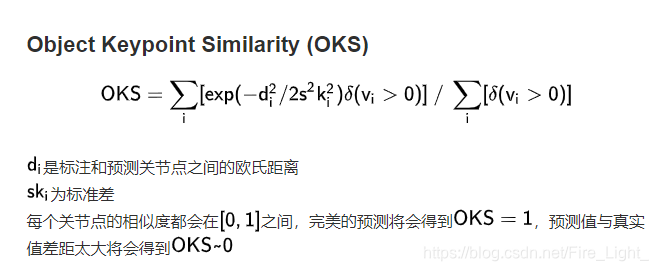

OKS是关键点距离的一种度量方式,计算方式如下:

文中提出的新的相似度计算方式具体是使用光流法计算某一帧的关键点会出现在的另外一帧的位置,然后用这个计算出来的位置和这一帧检测出来的关键点之间计算OKS,以此作为两帧之间的不同人的相似度值。

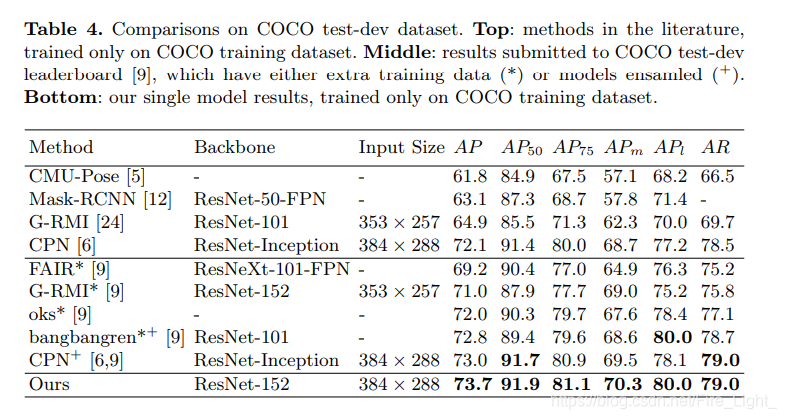

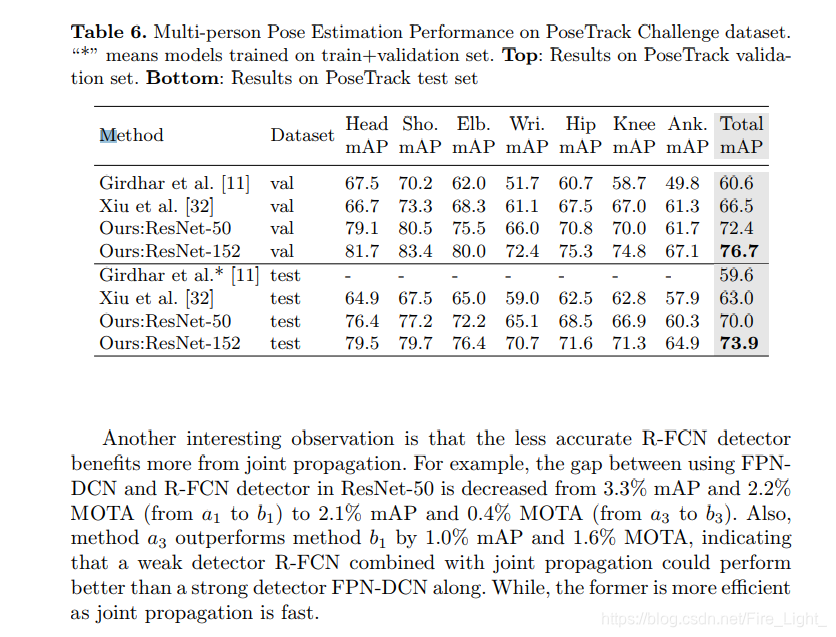

下图是和其他工作的对比:

5077

5077

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?