Logistic回归简介

Logistic回归是统计学习中的经典分类方法,属于对数线性模型,所以也被称为对数几率回归。该模型是一种分类算法,Logistic回归是一种线性分类器,针对的是线性可分问题。我们要了解Logistic回归进行分类的主要思想是:根据现有的数据对分类边界线建立回归方程,然后以此进行分类。这里回归一词源于最佳拟合参数,表示要找到最佳拟合参数集。

Logistic回归的优点在于计算代价不高,易于理解和实现。缺点是容易发生欠拟合现象,分类的精度不高。适合于数值型和标称型数据进行分类。

1.基于Logistic回归和Sigmoid函数的分类

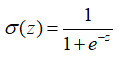

我们想要的函数应该是: 能接受所有的输入然后预测出类别。例如,在两个类的情况下,上述函数输出 0 或 1。有一个函数具有类似的性质(可以输出 0 或者 1 的性质),且数学上更易处理,这就是 Sigmoid 函数。 Sigmoid 函数具体的计算公式如下:

我们可以在每个特征上都乘以一个回归系数,然后将所有值累加,将中国总和带入Sigmoid 函数中,得到一个范围在[0,1]的数值,小于0.5归为0类,导游0.5归为1类。所以Logistic回归可以看出是一种概率估计。

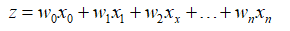

Sigmoid 函数的函数输入记为z,由下面公式得出:

采用向量的写法可以写成 ,它表示 将两个数值向量对于元素相乘然后相加得到z值。x为分类器输入数值,w为我们要找的最佳参数。

,它表示 将两个数值向量对于元素相乘然后相加得到z值。x为分类器输入数值,w为我们要找的最佳参数。

Sigmoid函数的曲线图:

图1-1 两种坐标尺度下的sigmoid函数图。上图为-8到8,曲线变化较为平滑;下图坐标尺度较大-60到60,在(0,0.5)处看起来像阶跃函数

为了实现logistic回归分类器,可以在每个特征上乘以一个回归系数,然后把所有的结果值相加,带入到sigmoid函数中,进而得到0-1之间的数值。任意大于0.5的数值被分入1类,小于0.5的被分入0类。

2.基于最优化方法的最佳回归系数确定

- 梯度上升法思想:要找到某个函数的最大值,最好的方法是沿着该函数的梯度方向寻找。

- 梯度下降法用来计算函数的最小值,在梯度下降算法中,梯度算子总是向函数值增长最慢的方向。

3.训练算法:使用梯度上升算法找到最佳参数

给出一个简单的数据集,利用logistic进行回归分类:

图1-2有100个样本点,每个点包含两个数值型特征:X1和X2,下面采用梯度上升法找到logistic回归器在此数据及上的最佳回归系数。

Logistic回归梯度上升算法:

def loadDataSet():

dataMat=[];labelMat=[] #创建数据列表和标签列表

fr=open('D:1.txt')

for line in fr.readlines():

lineArr=line.strip()</

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1601

1601

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?