引言

符号含义

- 点乘与叉乘

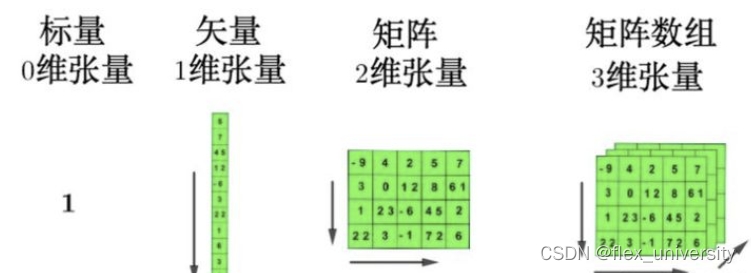

- 标量、向量、张量

张量(tensor),在机器学习领域指代张量类(MXNet中为ndarray,在PyTorch和TensorFlow中为Tensor)与numpy的ndarray相似,但比numpy多的功能是:支持GPU加速计算。支持自动微分。

- 指示函数

参考知乎文章

机器学习的关键组件

- 用于学习的数据data

- 转换数据的模型model

- 衡量模型优劣的目标函数objective function,有时被称为损失函数(loss function),或(cost function)

- 改进模型的调参优化算法(algorithm)

专业术语

- 样本(example, sample)= 数据点(data point)= 数据实例(data instance):数据由一个个样本构成

- 独立同分布(independently and identically distributed, i.i.d.):一般样本会遵循的性质

- 每个样本由一组称为特征(features),或协变量(covariates)的属性组成

- 要分析的属性,称为标签(label),或目标(target)

- 当每个样本的特征类别数量都是相同的时候,其特征向量是固定长度的,这个长度被称为数据的维数(dimensionality)

- 训练集(training set)与测试集(test dataset)

- 过拟合(overfitting):一个模型在训练集上表现良好,但不能推广到测试集

- 深度学习中,大多流行的优化算法通常基于一种基本方法–梯度下降(gradient descent)

各种机器学习问题概览

1.监督学习(supervised learning)

- 从已知大量数据样本中随机选取一个子集,为每个样本获取真实标签。有时,这些样本已有标签(例如,患者是否在下一年内康复?);有时,这些样本可能需要被人工标记(例如,图像分类)。这些输入和相应的标签一起构成了训练数据集;

- 选择有监督的学习算法,它将训练数据集作为输入,并输出一个“已完成学习的模型”;

- 将之前没有见过的样本特征放到这个“已完成学习的模型”中,使用模型的输出作为相应标签的预测。

1.1 回归(regression)

1.2 分类(classification)

1.3 多标签分类(multi‐label classification)

学习预测不相互排斥的类别的问题

1.4 搜索

1.5 推荐系统

1.6 序列学习

模型记住输入的内容。语音识别,翻译,文字转语音等

2、无监督学习(unsupervised learning)

//数据中不含有目标/标签//

2.1 聚类(clustering)问题

没有标签的情况下进行分类

2.2 主成分分析(principal component analysis)问题

2.3 因果关系(causality)和概率图模型(probabilistic graphical models)问题

能否根据经验数据发现特征间关系

2.4 生成对抗性网络(generative adversarial networks)

合成数据的方法,生成器网络通过学习训练数据的分布,生成新的数据。而判别器网络则尝试区分生成器生成的数据和真实的训练数据。在训练过程中,两个网络相互对抗,生成器网络试图欺骗判别器网络,使其无法准确地区分生成的数据和真实的训练数据,而判别器网络则试图正确地识别哪些数据是真实的。通过不断地迭代训练,生成器网络逐渐学习到如何生成更逼真的数据,而判别器网络则逐渐变得更加准确。最终,生成器网络可以生成与训练数据相似的新数据,这些数据可以用于图像生成、视频生成、自然语言处理等领域。

3、强化学习

//与环境互动//

“在强化学习问题中,智能体(agent)在一系列的时间步骤上与环境交互。在每个特定时间点,智能体从环境接收一些观察(observation),并且必须选择一个动作(action),然后通过某种机制(有时称为执行器)将其传输回环境,最后智能体从环境中获得奖励(reward)。此后新一轮循环开始,智能体接收后续观察,并选择后续操作,依此类推。请注意,强化学习的目标是产生一个好的策略(policy)。强化学习智能体选择的“动作”受策略控制,即一个从环境观察映射到行动的功能。”

监督学习问题其实可以转化为强化学习问题。

- 当环境可被完全观察到时,强化学习问题被称为马尔可夫决策过程(markov decision process)。

- 当状态不依赖于之前的操作时,我们称该问题为上下文赌博机(contextual bandit problem)。

- 当没有状态,只有一组最初未知回报的可用动作时,这个问题就是经典的多臂赌博机(multi‐armed bandit problem)

本文围绕机器学习展开,介绍了符号含义,如点乘、叉乘、张量等。阐述了机器学习的关键组件,包括数据、模型、目标函数和优化算法。还讲解了专业术语,如样本、特征、标签等。重点概述了监督学习、无监督学习和强化学习等各类机器学习问题。

本文围绕机器学习展开,介绍了符号含义,如点乘、叉乘、张量等。阐述了机器学习的关键组件,包括数据、模型、目标函数和优化算法。还讲解了专业术语,如样本、特征、标签等。重点概述了监督学习、无监督学习和强化学习等各类机器学习问题。

1348

1348

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?