写在前面:

阅读这篇论文的主要目的是为了计算隐私预算ε,虽然我对moment accountant还是处于一知半解的状态qwq

Abstract

基于神经网络的机器学习技术在很多领域卓有成效。通常情况下,训练模型需要大型的、有代表性的数据集,这些数据集来自大众且包含敏感信息。这些模型需要不暴露数据集中的个人信息。为了达到这个目的,我们在差分隐私框架下提出了新的学习算法工具和对隐私预算的精细化分析。我们的实验证明,我们可以在适度的隐私预算下训练一个非凸目标的神经网络,并且在软件复杂度、训练效率、模型质量上具有可控的成本。

introduction

贡献:

- 通过追踪隐私损失的细节信息(高阶),可以在渐进和经验上得到全局损失的更紧的评估。

- 改进了差分隐私的计算效率,包括对单个训练样本计算梯度,将batch分割来减少内存占用的空间,在输入层应用了差分隐私的主成分投影。

- 使用tensorflow架构对MNIST和CIFAR-10数据集进行实验,表明差分隐私下的深度神经网络可以在软件复杂度、训练效率、模型质量上达到合适的代价。

background

differential privacy

设计步骤

- 顺序组合敏感度有界的功能去近似实际功能

- 选择噪声的参数

- 隐私分析

deep learning

mini-batch SGD

选择batchB求梯度,取平均值,进行梯度下降,而非用整个数据集

our approach

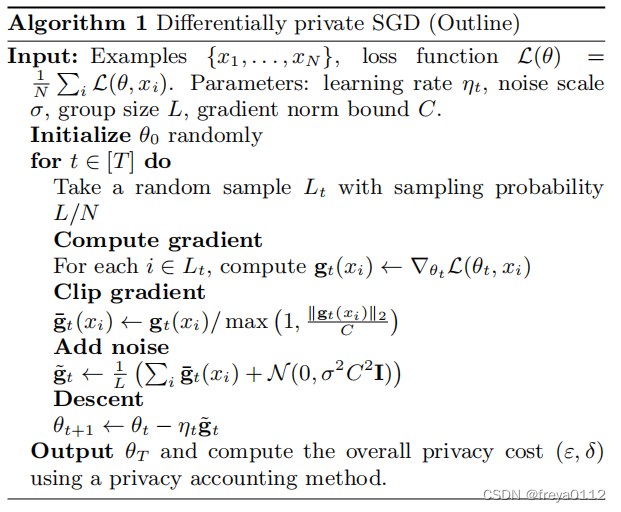

differentially private SGD algorithm

Per-layer and time-dependent parameters:

分别处理每一层,使用不同的clipping threshold C和noise scale σ,这两者也随着training steps t的变化而变化。

Lots:

在batch上运算,然后将几个batch组合成一个lot来添加噪声。

privacy accounting:

the moment accountant

这个推导写完了会放上来的

hyperparameter tuning

实验观察到,模型的精度对批量大小和噪声水平等训练参数比对神经网络的结构更敏感。

凸目标函数的差异私有优化最好是使用小至1的批次大小来实现,但非凸学习,它本质上不太稳定,受益于聚合到更大的批次。

implementation

santizer: 预处理梯度来保护隐私

(1)clip (2)noise

privacy_accountant: 跟踪训练过程中的隐私消耗

experimental results

PCA: 提高了模型的精度和训练性能。

Lot size: 较小的lots可以运行更多epochs,增强精度;较大的lots添加的噪声较少。Lot size对accuracy的影响较大,最好约为根号N,N为training samples的数量。

learning rate: 学习率上升,accuracy会下降,即使是对于较大的学习率,我们也可以通过降低噪音水平,以及相应的减少训练,来达到类似的准确性水平,以避免耗尽隐私预算。

clipping bound: clip可以破坏梯度的非偏性,如果C过小,梯度与真实梯度会相差很大。但如果C过大,那么加的noise会变多,因为是基于σC。

神经网络的大小对精度影响不大,当我们只能运行更少的epochs时,使用更大的网络更有益。lot size和noise σ的影响较大。

先前的工作已经表明,卷积层通常是可转移的:从一个数据集学习到的参数可以用于另一个数据集,而不需要再训练。我们将CIFAR-100数据集视为一个公共数据集,并使用它来训练一个具有相同架构的网络,使用从训练这个数据集中学习到的卷积。

871

871

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?