motivation:基于神经网络的机器学习技术需要大量且有代表性的训练数据,其中包含了许多敏感信息,所以为了解决这个问题,提出了一种学习算法技术和对差分隐私的隐私损失进行详细分析。

key sentence:

1.在本文中,我们将最先进的机器学习方法与先进的隐私保护机制相结合,在一个适度的(“个位数”)的隐私预算内训练神经网络。我们处理模型用具有非凸目标、几层、数层和数万到数百万参数的元素。

2.我们证明,通过跟踪隐私损失的详细信息(更高的时刻),我们可以获得更严格的对总体隐私损失的估计,无论是渐近性的和经验上的。

3.通过引入新技术,提高了差分隐私训练的计算效率。这些技术包括计算个人训练梯度的有效算法 ,将任务细分为更小的批处理以减少内存占用,并在输入层应用差分隐私主成分投影。

差分隐私属性:

1.组合定理(composability):Composability enables modular design of mechanisms: if all the components of a mechanism are difffferentially private,then so is their composition.

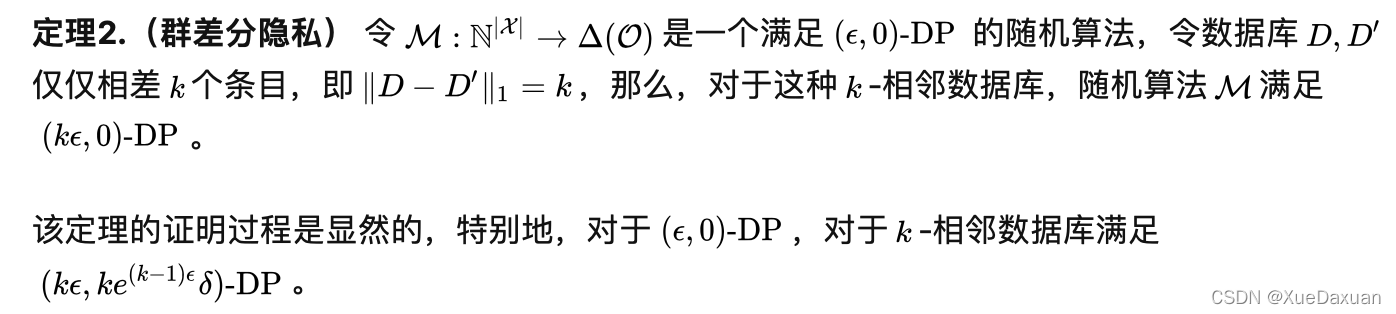

2.群隐私(group privacy):Group privacy implies graceful degradation of privacy guarantees if datasets contain cor related inputs, such as the ones contributed by the same individual.

3.辅助信息的健壮性(robustness to auxiliary information):Robustness to auxiliary information means that privacy guarantees are not affected by any side information available to the adversary.

4.隐私损失性质

method:

1.整体架构

2.方法架构:

2.1Differentially Private SGD Algorithm

有人尝试去保护训练数据的隐私通过对最后输出层的参数进行变化,像是黑盒一样,但是加入过大的噪声会影响实用性。所以需要一种更复杂的方法去控制训练过程中的数据。对SGD算法进行一些修改和延伸在我们的privacy accounting。以下为算法1:(倒数第二步)take a step in the opposite direction of this average noisy gradient. 应该是反向传播

分组Lots:像普通的SGD算法一样,本算法通过计算一组例子的梯度并取平均估算L的梯度。这个平均值提供了一个无偏差的估算值,方差的变化随着数据量的增加迅速减少。我们称这个组合为lot,与通常的计算组合batch区别开。为了限制内存消耗,设置batch的容量远小于lot,batch是算法的超参数。我们对batch进行计算,然后将batch放在一个lot中,在Lot中添加噪声。

隐私计算:对于差分隐私SGD,计算训练的整体隐私成本非常重要。差分隐私的可组合性允许我们执行可累加过程:先计算每种到达训练数据的方式的隐私,然后将这些隐私累加作为训练过程。训练的每一步骤要求多个层次的梯度,然后计算累加对应于它们的所有成本。

Hyperparameter Tuning:作者识别与隐私相关的模型特征,特别是通过可以调整的超参数,以平衡隐私、准确性和性能。特别是作者观察到模型精度对训练参数,如 batchsize 和噪声水平比对神经网络的结构更敏感。

与传统做法不同的是,作者的两个超参数选择是 batchsize 和学习率。虽然凸目标函数的优化在批量最小为 1 时最容易实现,但非凸学习本质上不太稳定,有利于聚集成更大的 batches。当模型收敛到局部最优时,非私有训练的学习率通常向下调整。相反,作者保持学习率不变,因为基于差分隐私的训练需要的时间相对较少,因此无需降低学习率。

experiments:在我们的实验中,每个训练数据集都是一组图像标签对;如果其中两个集合在单个条目中不同,即如果一个图像标签对是相邻的在一组中存在,在另一组中没有。

说明:

1.Norm Clipping:如果所有参数的gradient组成的向量的L2 norm 大于max norm,那么需要根据L2 norm/max_norm 进行缩放。从而使得L2 norm 小于预设的 clip_norm。

2.Per-layer and time-dependent parameters:裁剪和噪声参数会随着训练步骤而变化。

3.Sanitizer:为了实现隐私保护,Sanitizer需要执行两种操作:(1)通过裁剪每个示例的梯度范数来限制每个单独示例的敏感性;(2)在更新网络参数之前,向批次的梯度添加噪声。

683

683

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?