接口防刷笔记

Redis 方案

可用setIfAbsent(key, code, 60, TimeUnit.SECONDS); 来判断

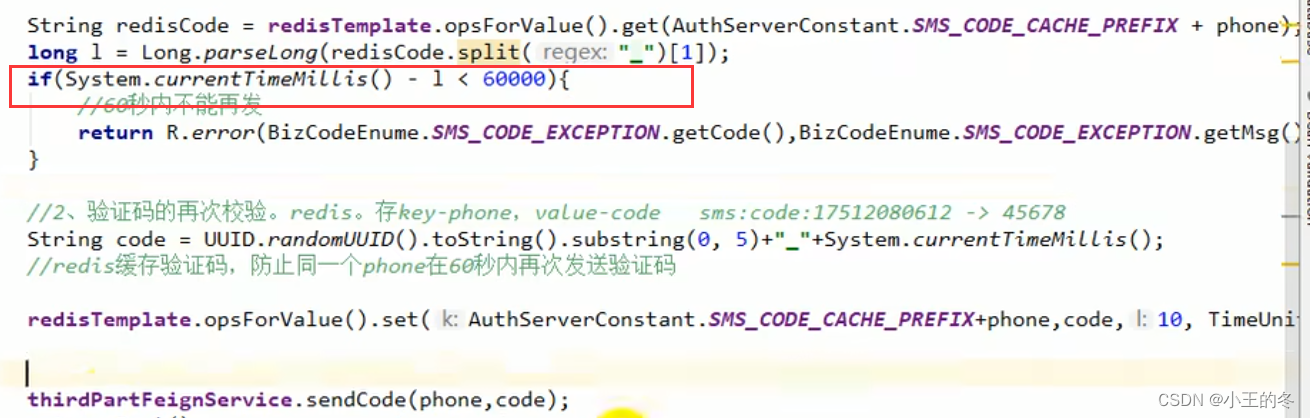

可存入value的时候,带上时间戳,再对时间戳进行比较

1.setIfAbsent

String key = AuthConstant.EMAIL_CODE_CACHE_PREFIX + email;

Boolean result = redisTemplate.opsForValue().setIfAbsent(key, code, 60, TimeUnit.SECONDS);

if(result){

// 发送

return this.send(mailTO);

}else{

return R.error(BizCodeEnum.SMS_CODE_EXCEPTION.getMsg());

}

1

2

3

4

5

6

7

8

value + 时间戳

关于toMap()方法的key冲突问题

可以这样解决

Map<String, String> errors = fieldErrors.stream().collect(

Collectors.toMap(FieldError::getField,

FieldError::getDefaultMessage,

(val1, valu2) -> val1));

1

2

3

4

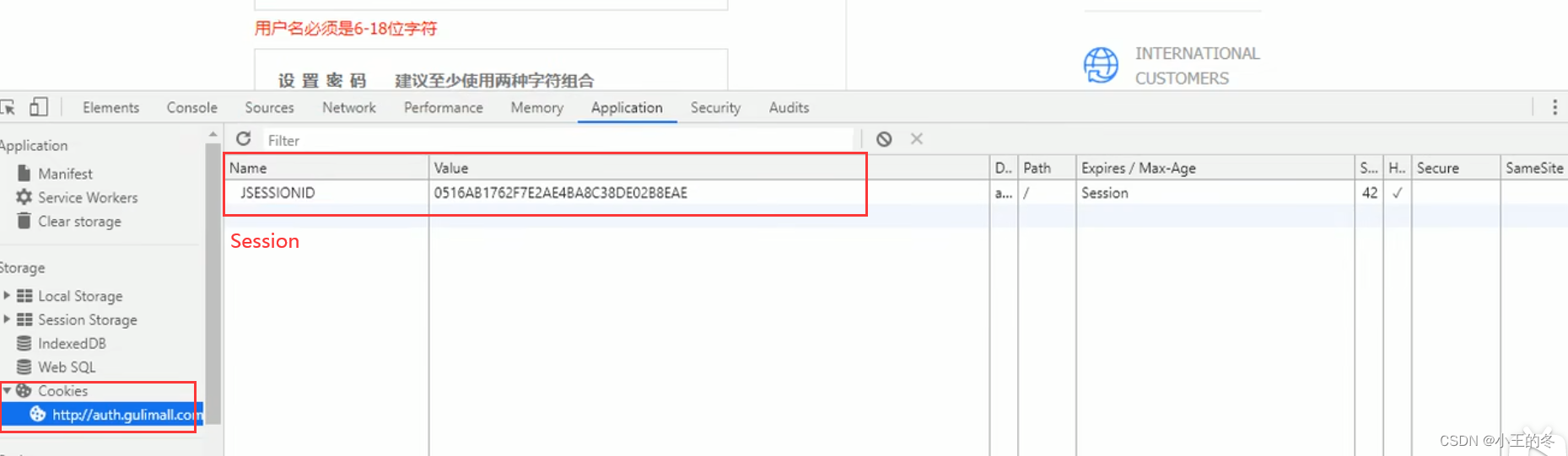

关于Spring MVC重定向的Model渲染

原理:用了session缓存,用session来取模板数据来渲染;

补充:只要跳下一个页面取了这个session的数据,这个session的数据就自动删除了

防止接口冲刷

不要用转发!!! 改成重定向

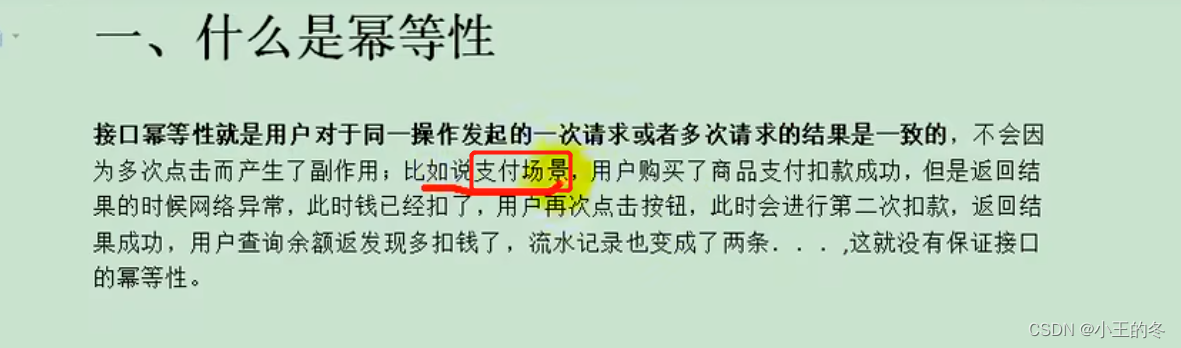

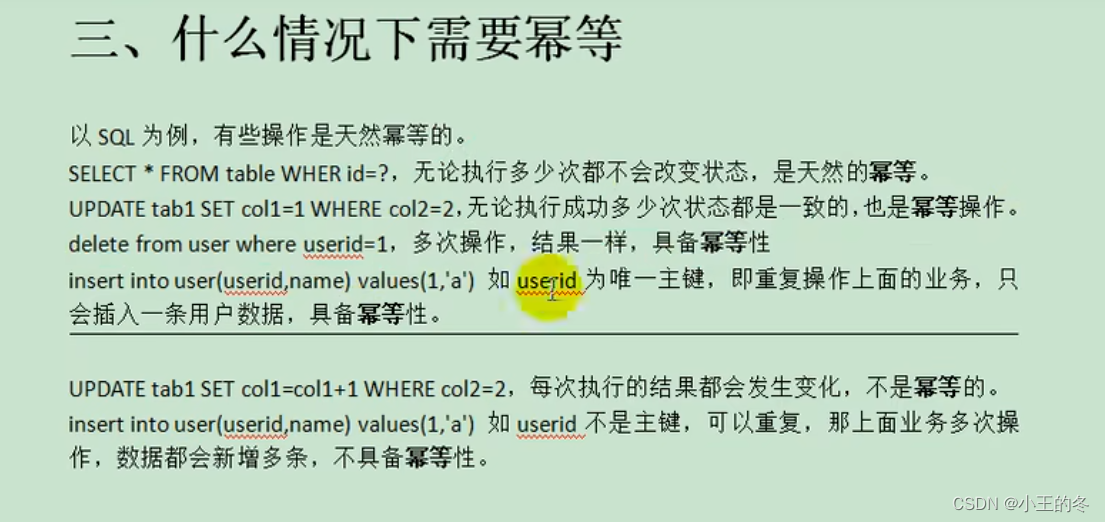

接口幂等性问题

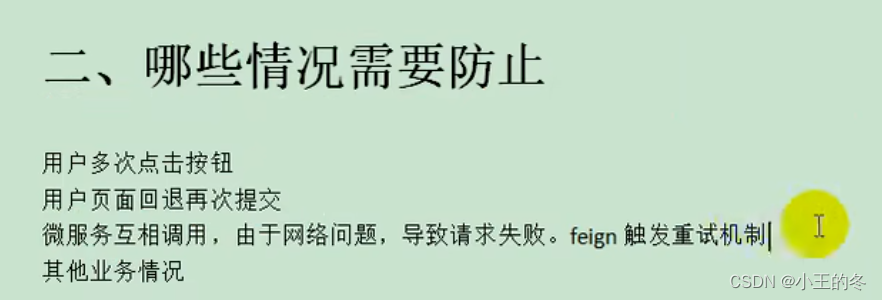

5种解决方案

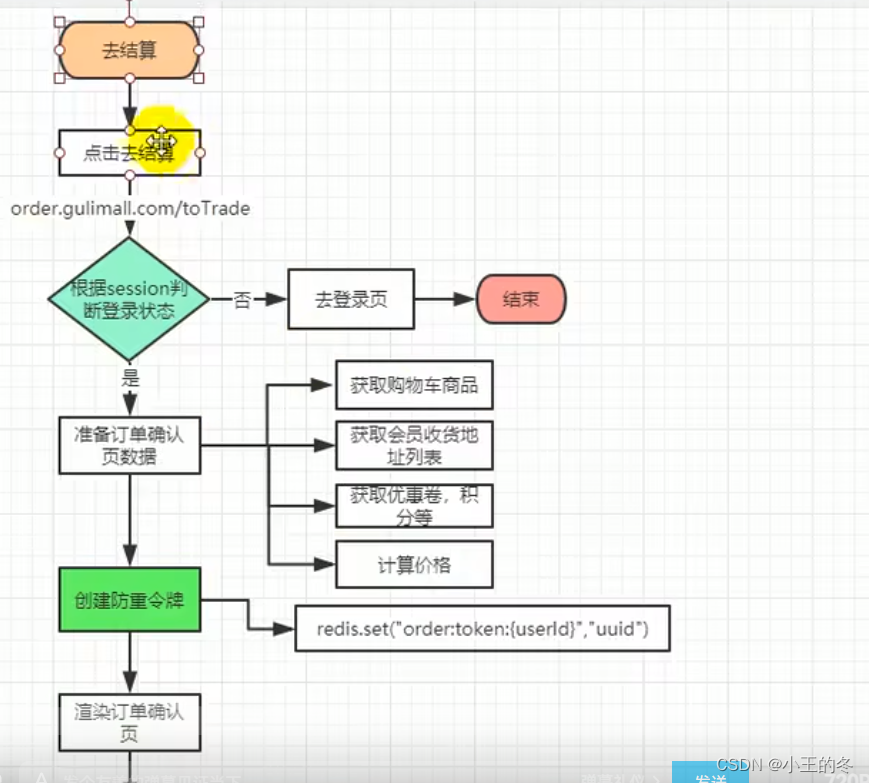

1、token 机制

1、服务端提供了发送 token 的接口。我们在分析业务的时候,哪些业务是存在幂等问题的,

就必须在执行业务前,先去获取 token,服务器会把 token 保存到 redis 中。

2、然后调用业务接口请求时,把 token 携带过去,一般放在请求头部。

3、服务器判断 token 是否存在 redis 中,存在表示第一次请求,然后删除 token,继续执行业

务。

4、如果判断 token 不存在 redis 中,就表示是重复操作,直接返回重复标记给 client,这样

就保证了业务代码,不被重复执行。

危险性:

1、先删除 token 还是后删除 token;

(1) 先删除可能导致,业务确实没有执行,重试还带上之前 token,由于防重设计导致,

请求还是不能执行。

(2) 后删除可能导致,业务处理成功,但是服务闪断,出现超时,没有删除 token,别

人继续重试,导致业务被执行两边

(3) 我们最好设计为先删除 token,如果业务调用失败,就重新获取 token 再次请求。

2、Token 获取、比较和删除必须是原子性

(1) redis.get(token) 、token.equals、redis.del(token)如果这两个操作不是原子,可能导

致,高并发下,都 get 到同样的数据,判断都成功,继续业务并发执行

(2) 可以在 redis 使用 lua 脚本完成这个操作

if redis.call(‘get’, KEYS[1]) == ARGV[1] then return redis.call(‘del’, KEYS[1]) else return 0 end

2、各种锁机制

1、数据库悲观锁

select * from xxxx where id = 1 for update;

1

悲观锁使用时一般伴随事务一起使用,数据锁定时间可能会很长,需要根据实际情况选用。

另外要注意的是,id 字段一定是主键或者唯一索引,不然可能造成锁表的结果,处理起来会

非常麻烦。

2、数据库乐观锁

这种方法适合在更新的场景中,

update t_goods set count = count -1 , version = version + 1 where good_id=2 and version = 1

1

根据 version 版本,也就是在操作库存前先获取当前商品的 version 版本号,然后操作的时候

带上此 version 号。我们梳理下,我们第一次操作库存时,得到 version 为 1,调用库存服务

version 变成了 2;但返回给订单服务出现了问题,订单服务又一次发起调用库存服务,当订

单服务传如的 version 还是 1,再执行上面的 sql 语句时,就不会执行;因为 version 已经变

为 2 了,where 条件就不成立。这样就保证了不管调用几次,只会真正的处理一次。

乐观锁主要使用于处理读多写少的问题

3、业务层分布式锁

如果多个机器可能在同一时间同时处理相同的数据,比如多台机器定时任务都拿到了相同数

据处理,我们就可以加分布式锁,锁定此数据,处理完成后释放锁。获取到锁的必须先判断

这个数据是否被处理过。

3、各种唯一约束

1、数据库唯一约束

插入数据,应该按照唯一索引进行插入,比如订单号,相同的订单就不可能有两条记录插入。

我们在数据库层面防止重复。

这个机制是利用了数据库的主键唯一约束的特性,解决了在 insert 场景时幂等问题。但主键

的要求不是自增的主键,这样就需要业务生成全局唯一的主键。

如果是分库分表场景下,路由规则要保证相同请求下,落地在同一个数据库和同一表中,要

不然数据库主键约束就不起效果了,因为是不同的数据库和表主键不相关。

2、redis set 防重

很多数据需要处理,只能被处理一次,比如我们可以计算数据的 MD5 将其放入 redis 的 set,

每次处理数据,先看这个 MD5 是否已经存在,存在就不处理。

4、防重表

使用订单号 orderNo 做为去重表的唯一索引,把唯一索引插入去重表,再进行业务操作,且

他们在同一个事务中。这个保证了重复请求时,因为去重表有唯一约束,导致请求失败,避

免了幂等问题。这里要注意的是,去重表和业务表应该在同一库中,这样就保证了在同一个

事务,即使业务操作失败了,也会把去重表的数据回滚。这个很好的保证了数据一致性。

之前说的 redis 防重也算

5、全局请求唯一 id

调用接口时,生成一个唯一 id,redis 将数据保存到集合中(去重),存在即处理过。

可以使用 nginx 设置每一个请求的唯一 id;

proxy_set_header X-Request-Id $request_id;

订单服务的幂等处理

————————————————

版权声明:本文为CSDN博主「小王的冬」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/jams3368/article/details/127215975

787

787

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?