在文本分类中,CNN由于主要提取的是局部特征而忽略了global特征,这容易造成一次多义的现象,进而对文本分类的精度产生一定的影响,而LSTM是RNN的一种变形,其处理的输入是序列化的输入,RNN由于容易更长久的记忆能力,容易造成梯度消失,所以可以利用lstm模型来防止序列化输入在传输时造成的梯度消失现象。利用BPTT算法来优化参数。

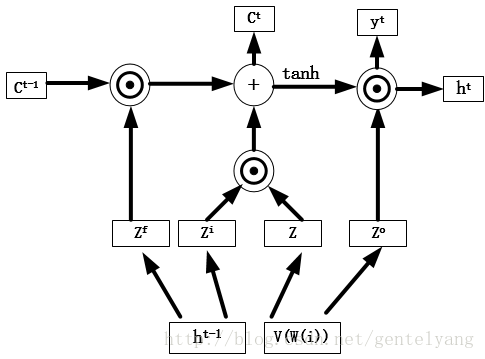

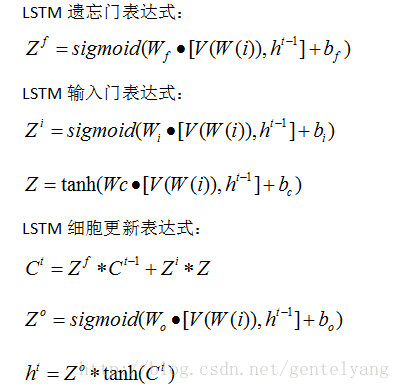

由于RNN能学习任意时间长度序列的输入,但随着输入的增多,难以学习到连接之间的关系,产生长依赖问题,进而会发生梯度消失或者梯度爆炸现象。LSTM能克服RNN的以上问题,双向其核心思想是记忆细胞和门机制。如图所示,门机制中各个门和记忆细胞的表达式:

4019

4019

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?