李国春

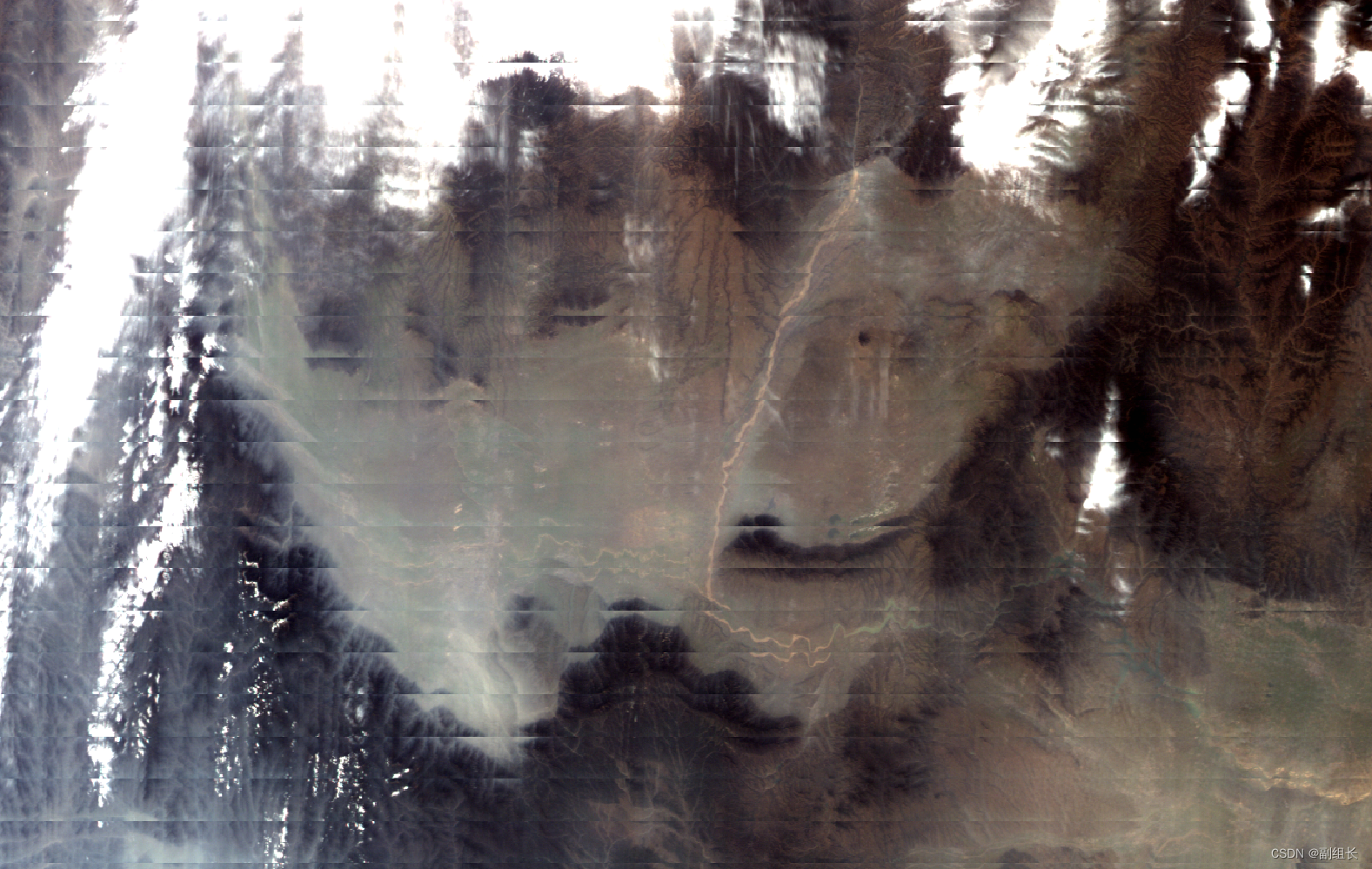

极轨气象卫星多为多扫描单元(比方10个SCAN)与卫星轨道垂直方向并行扫描。这就像冬天下雪我们拿个笤帚扫院子,一边往前走一边往两边扫。由于极轨气象卫星扫描刈幅(SWATH)宽、探测距离越往边缘越长,加之地球曲率的影响,会使SWATH边缘的像元变大。沿轨道方向最大甚至达到星下点像元直径的2.3倍,沿扫描方向大的就更多了。这样从星下点越往SWATH边缘,两个SCAN的交叉重叠就越来越多,扫描单元像素你中有我我中有你相互重叠。会把别的SCAN位置上的数据拿到自己的SCAN中,从图像看就发生了重复,所以有人也叫它“双眼皮”。见图1。

图1 FY3 MERSI L1B数据集的BOW-TIE现象

人们想了很多办法来消除这个双眼皮,最常用的办法是割掉重叠部分。但是这里的“割双眼皮”可不是像美容院里的割双眼皮将单眼皮割成双眼皮,而是将双眼皮割成单眼皮。 :)

RSD采用了将两个SCAN交叉部分相互插入的方法,不割除像元,不移动像元,不看像元的归属SCAN,是哪儿的像元就在哪儿原地插入。这种方法我们已经用了十几年了,但是一直没有取个名字,叫 原位插入法 怎样?以区别其它BOW-TIE处理方法。方法的具体描述参阅前期的一些相关介绍。

图2 像元插入临近SCAN后的结果

图2中,稀疏的条带是正常的扫描带(SCAN),密集的条带是上下两个扫描带重叠部分。RSD原位插入这些像元而不是简单删除提高了处理精度。

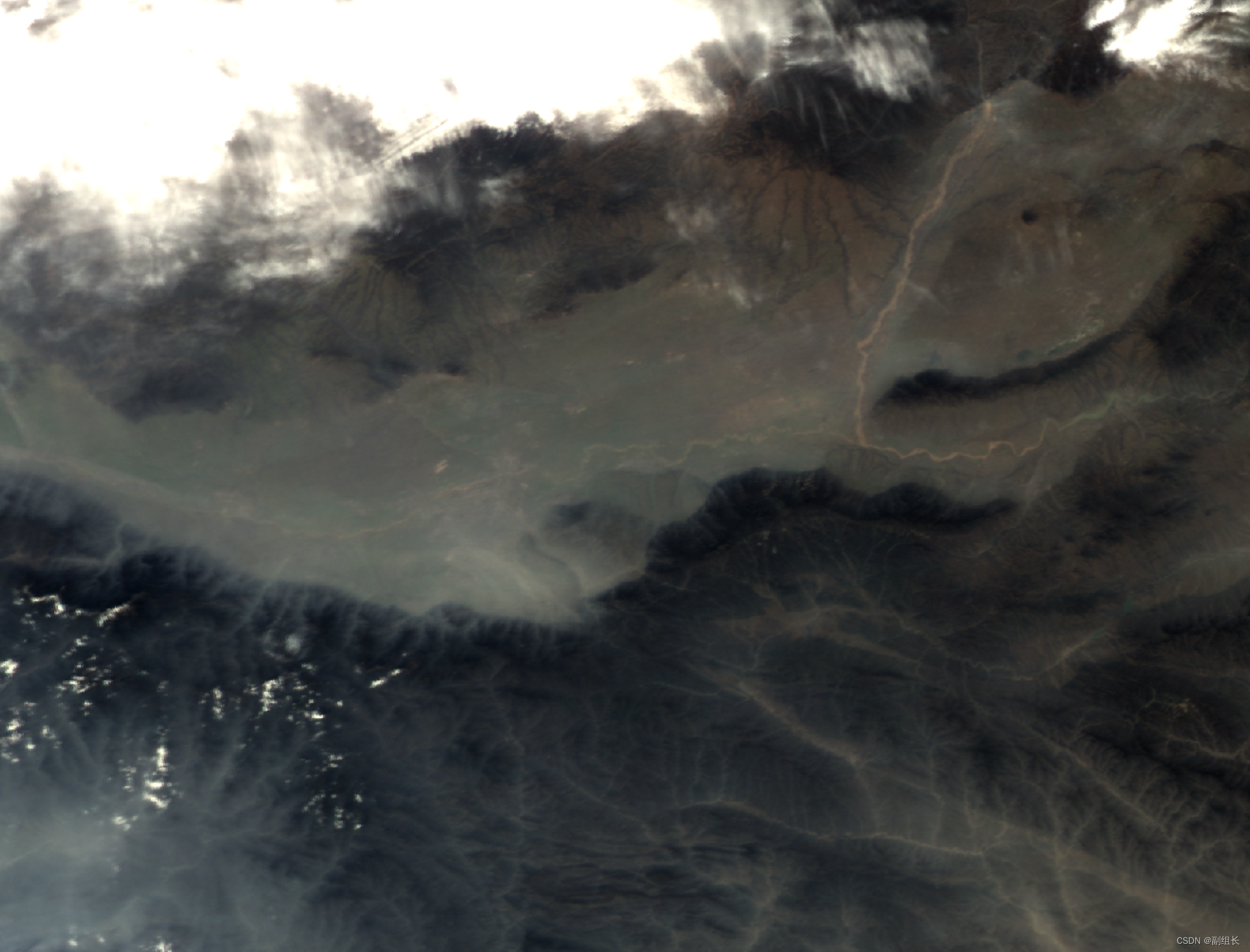

图3是图1相同区域处理后结果。

图3 FY3 MERSI L1B数据集消除BOW-TIE后的结果

可见这些SWATH边缘几乎具有星下点附近同样的精度。

有些卫星在星上就进行了BOW-TIE剪切和扫描位置调整,图4是suomi NPP VIIRS Imager的L1B数据集。

图4 经过星上剪切掉BOW-TIE的suomi NPP VIIRS Imager L1B数据集

图4相当于是图1的BOW-TIE,把重叠的数据在星上直接就剪掉了,并且在一个SCAN中对视场角进行了调整。

使用RSD原位插入方法处理后像元位置见图5。

图5 suomi NPP VIIRS Imager L1B数据集像元插入临近SCAN后的结果

图5从右至左由于裁剪重叠部分突然变少,像元变密。但是仍然存在少量重叠且有误伤的像元。从RSD原位插入方法处理BOW-TIE的角度,没有必要在星上裁剪和调整视场角,这样增加了星上设备的复杂程度。但是如果同时为了节省通讯成本,还是有意义的。

图6是RSD处理后的结果。

图6 suomi NPP VIIRS Imager L1B数据集消除BOW-TIE后的结果

可见,因为误伤了一些像元,在去BOW-TIE处理后,会出现少量裂隙。可以使用RSD的GRID修复工具很容易地将其修复。

这里夹带私货给我的伪3D渲染做个宣传。对图6的数据进行插补修复后,使用suomi NPP VIIRS数据自带的高程数据,用RSD的伪3D做个渲染。先把云提出来。伪3D渲染后再把云叠加回去。就是图7的结果。

图7 处理完毕的suomi NPP VIIRS Imager L1B数据集

顺便说一下,并非只有suomi NPP等自带高程数据的气象卫星才能进行伪3D渲染,可以使用任何DEM数据对所有高、中分数据进行类似处理,欢迎大家试用。

加758461012,原来的群满了。

9239

9239

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?