循环神经网络是为了更好的地处理时序信息而设计的。它引入状态变量来存储过去的信息,并用其与当前的输入共同决定当前的输出。

它并非刚性地记忆所有固定长度的序列,而是通过隐藏状态来存储之前时间步的信息。

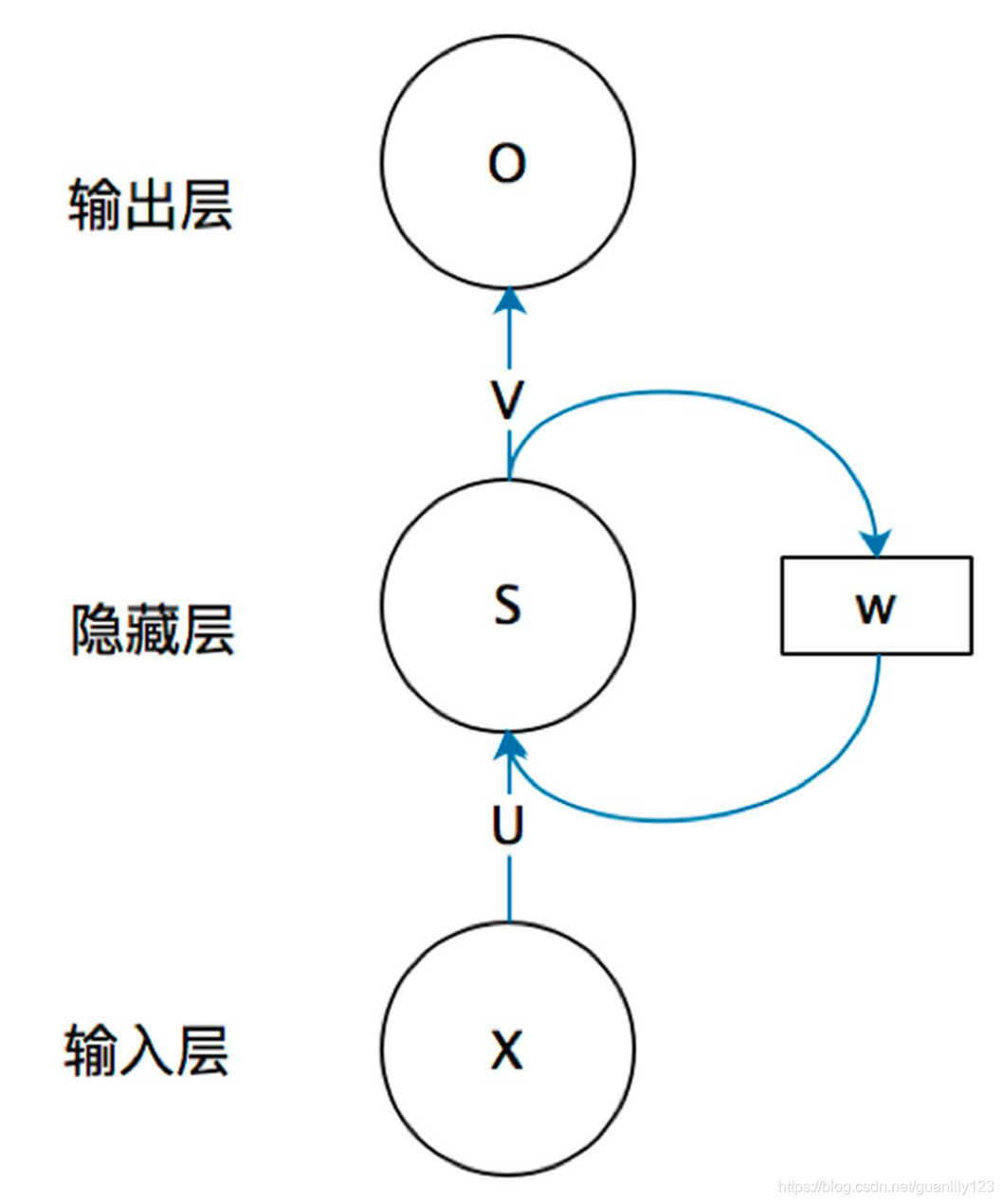

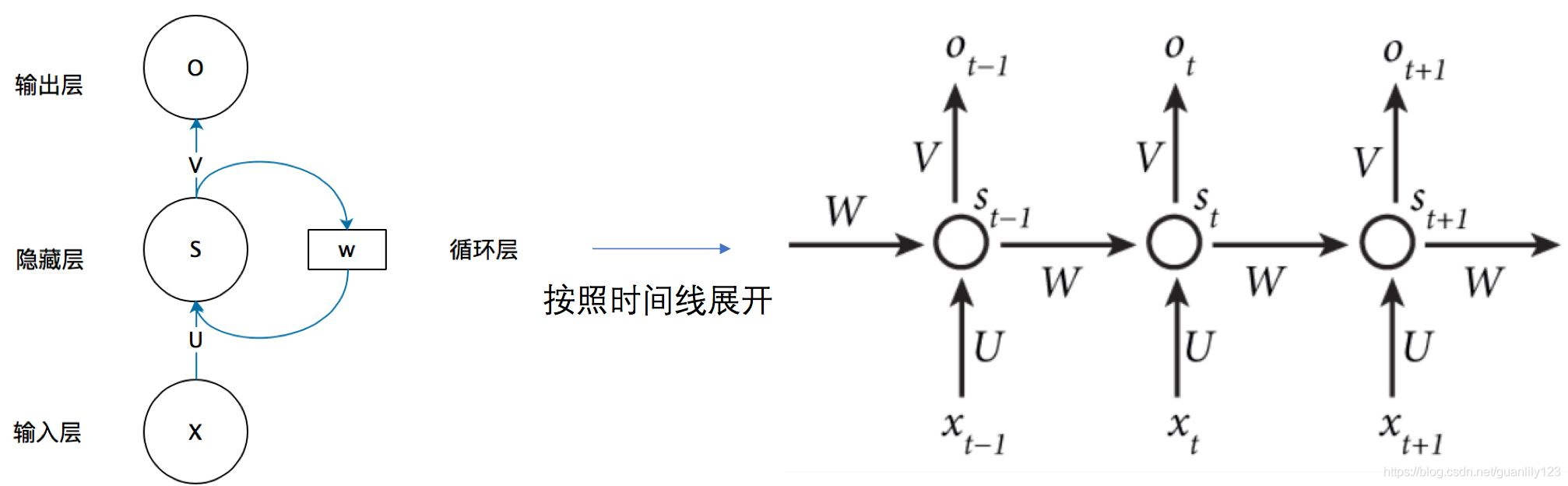

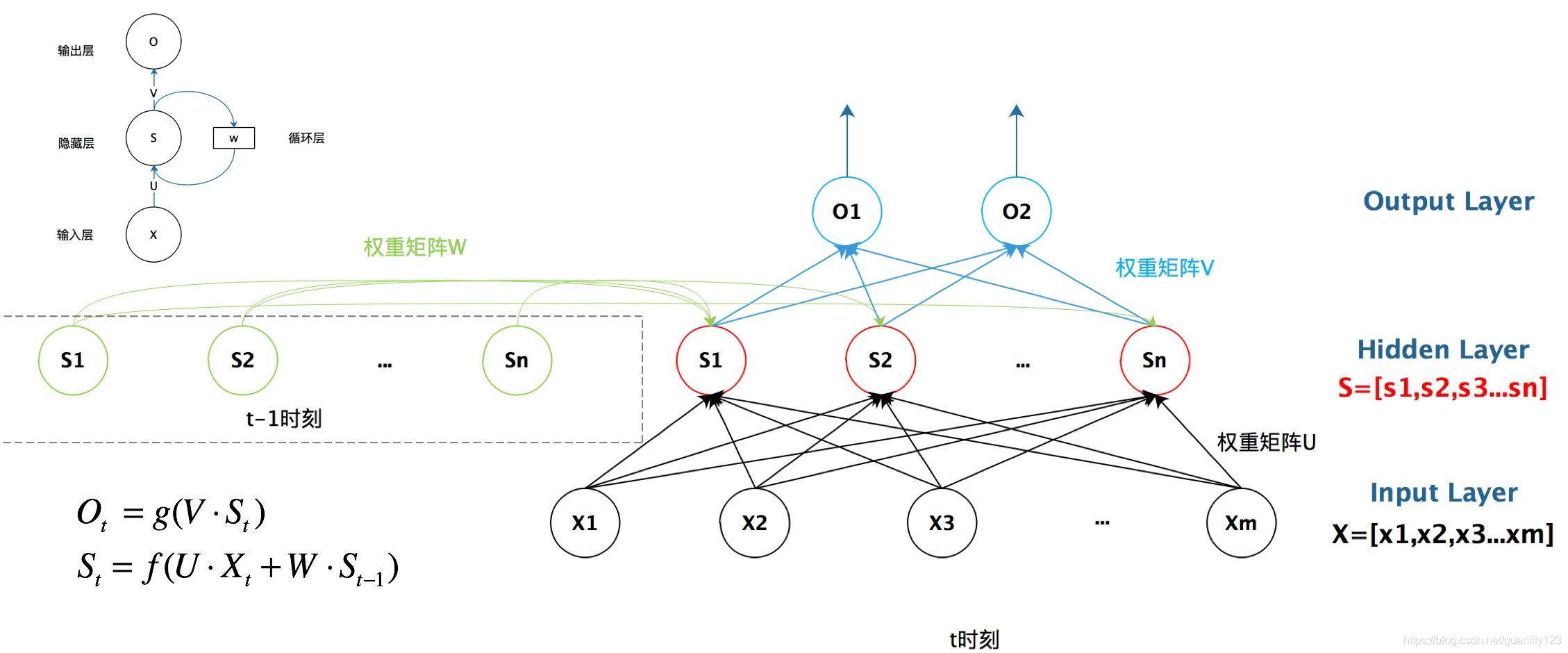

RNN结构:

其中,如果把上面有W的那个带箭头的圈去掉,它就变成了最普通的全连接神经网络。x是一个向量,它表示输入层的值(这里面没有画出来表示神经元节点的圆圈);s是一个向量,它表示隐藏层的值(这里隐藏层面画了一个节点,你也可以想象这一层其实是多个节点,节点数与向量s的维度相同),U是输入层到隐藏层的权重矩阵,o也是一个向量,它表示输出层的值;V是隐藏层到输出层的权重矩阵。这个图展开后是:

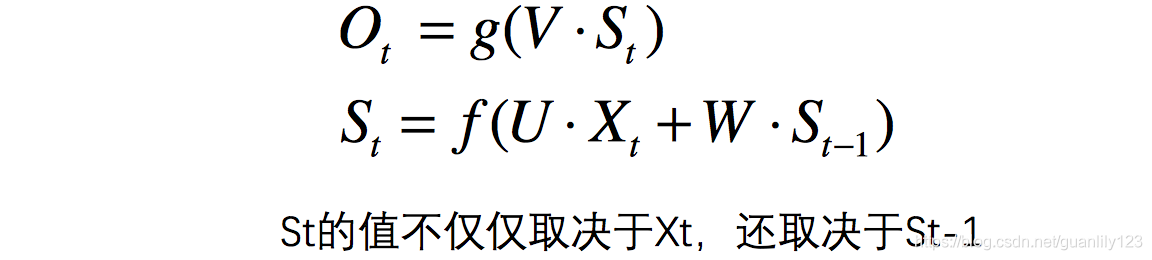

用公式表示如下:

RNN的总结图如下:

梯度裁剪

在深度神经网络采用链式法则进行参数求导的方式并不是绝对安全的,有时会出现梯度消失或者梯度爆炸的情况。其中解决的主要方式之一是——梯度裁剪,也就是通过“clip”方式来防止迭代中梯度值过大。详细请看博客

语言模型中困惑度(perplexity)的推导

具体详细看博客

困惑度是对交叉熵损失函数做指数运算后得到的值。特别地:

最佳情况下,模型总是把标签类别的概率预测为1,此时困惑度为1;

最坏情况下,模型总是把标签类别的概率预测为0,此时困惑度为正无穷;

基线情况下,模型总是预测所有类别的概率都相同,此时困惑度为类别个数。

显然,任何一个有效模型的困惑度必须小于类别个数。

pytorch中nn.RNN()中参数的解释有篇文章总结的比较好,请看博客

8498

8498

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?