在神经网络中,正则化是一种用于防止模型过拟合的技术。过拟合是指模型在训练数据上表现得很好,但是对于未见过的新数据,其泛化能力却很差。正则化通过在损失函数中添加一个额外的项来惩罚模型的复杂度,从而鼓励模型学习更加简单、更加泛化的特征。

正则化的含义

正则化通常有以下几种类型:

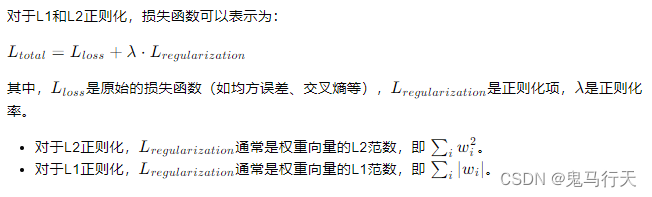

L1正则化:在损失函数中添加权重的绝对值之和。它倾向于产生稀疏权重矩阵,即许多权重会变为零。

L2正则化:在损失函数中添加权重的平方和。它倾向于使权重均匀地小,避免某些权重过大而其他权重过小。

Dropout:在训练过程中随机地“丢弃”(置零)一部分神经元的输出。这可以被看作是一种引入噪声的正则化方法,它迫使网络中的其他神经元学习更加鲁棒的特征。

数据增强:通过对训练数据进行变换(如旋转、缩放、裁剪等)来增加数据的多样性,从而提高模型的泛化能力。

早停(Early Stopping):在验证集上的性能不再提升时停止训练,以避免模型在训练集上过度拟合。

正则化率的含义

正则化率(Regularization Rate),也称为正则化参数或权重衰减,是正则化项前的系数,用于控制正则化项的强度。在数学表达式中,正则化率通常表示为λ(或有时为α)。

正则化率的选择

正则化率的选择对模型性能有很大影响:

如果正则化率过大,模型可能会过于简单,导致欠拟合,即模型在训练集上的误差也较大。

如果正则化率过小,模型可能会过于复杂,导致过拟合,即模型在训练集上的误差很小,但在新数据上的误差较大。

因此,正则化率的选择通常需要通过交叉验证等技术来进行调整,以便找到最佳的模型复杂度和泛化能力之间的平衡。

总结

正则化是一种重要的技术,用于提高神经网络模型的泛化能力,防止过拟合。正则化率是控制正则化强度的参数,需要仔细调整以获得最佳性能。通过正则化,我们可以鼓励模型学习更加简单、更加鲁棒的特征,从而提高模型在新数据上的表现。

本文介绍了正则化在神经网络中的作用,包括L1和L2正则化、Dropout、数据增强以及早停等方法,强调了正则化率选择的重要性,以达到模型复杂度与泛化能力的平衡,防止过拟合和欠拟合问题。

本文介绍了正则化在神经网络中的作用,包括L1和L2正则化、Dropout、数据增强以及早停等方法,强调了正则化率选择的重要性,以达到模型复杂度与泛化能力的平衡,防止过拟合和欠拟合问题。

2007

2007

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?