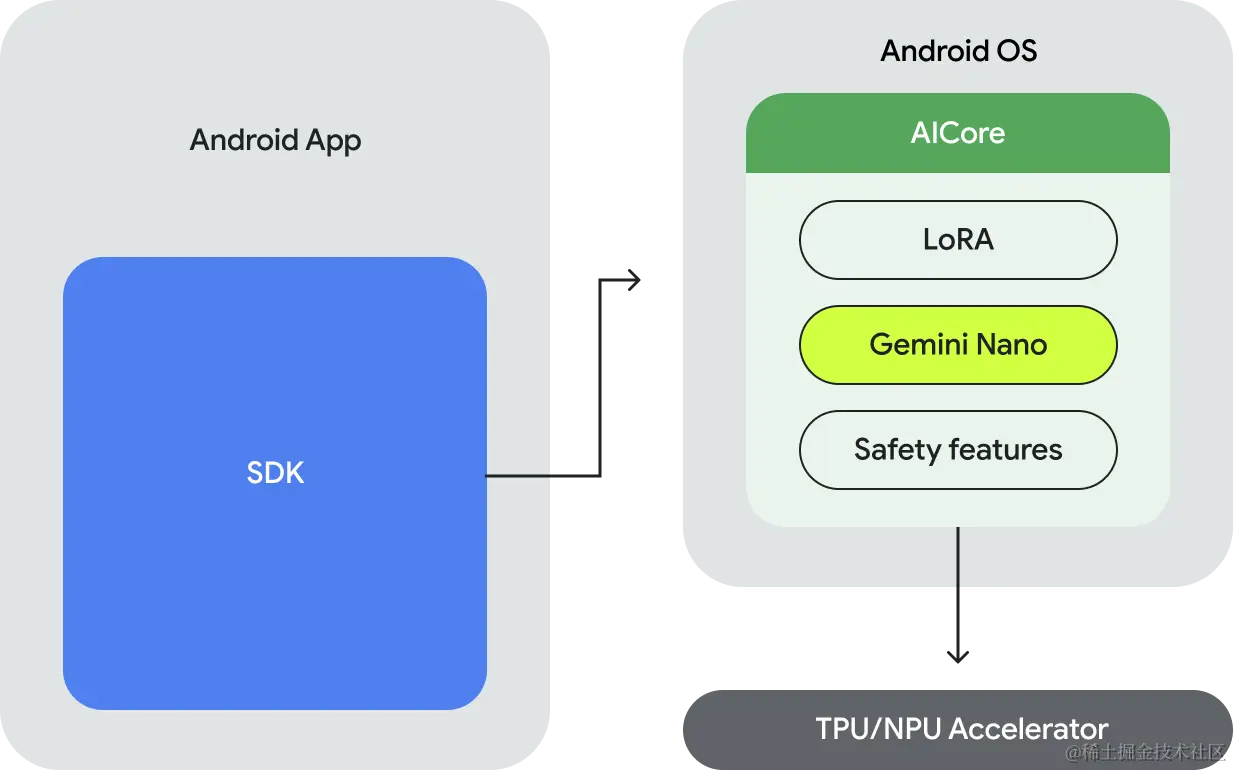

在Android的AICore系统服务中, LoRA、 Gemini Nano和 Safety Features是支撑端侧AI高效运行的三大核心组件。以下结合实际场景和技术原理,详细说明其作用与典型应用。

PART ONE:工作原理

一、LoRA(低秩适配):轻量化模型微调的引擎

作用与原理

LoRA(Low-Rank Adaptation)是一种参数高效微调技术,通过将模型权重分解为低秩矩阵(如ΔW = (α/r) * A·B),仅需调整极小部分参数即可适配新任务。在AICore中,LoRA允许开发者在不重新训练完整大模型的前提下,针对特定场景优化Gemini Nano等基础模型,显著降低计算成本和存储占用。

典型应用

-

Gboard智能回复个性化

- 当用户频繁使用特定俚语或行业术语时,LoRA会微调Gemini Nano的语言模型,使智能回复更贴合用户表达习惯。例如,程序员在Slack中输入“PR review”时,Gboard能优先推荐技术相关的回复模板。

订阅专栏 解锁全文

订阅专栏 解锁全文

9962

9962

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?