2016年8月20日,Ceph亚太地区路演首站——北京站的活动如期在英特尔中国研究院举办,会议吸引了各路国内外“英雄好汉”齐聚一堂,场面异常火爆。

参照去年参加Ceph Day的惯例(http://www.csdn.net/article/2015-06-08/2824891)对今天的会议做一个的总结。

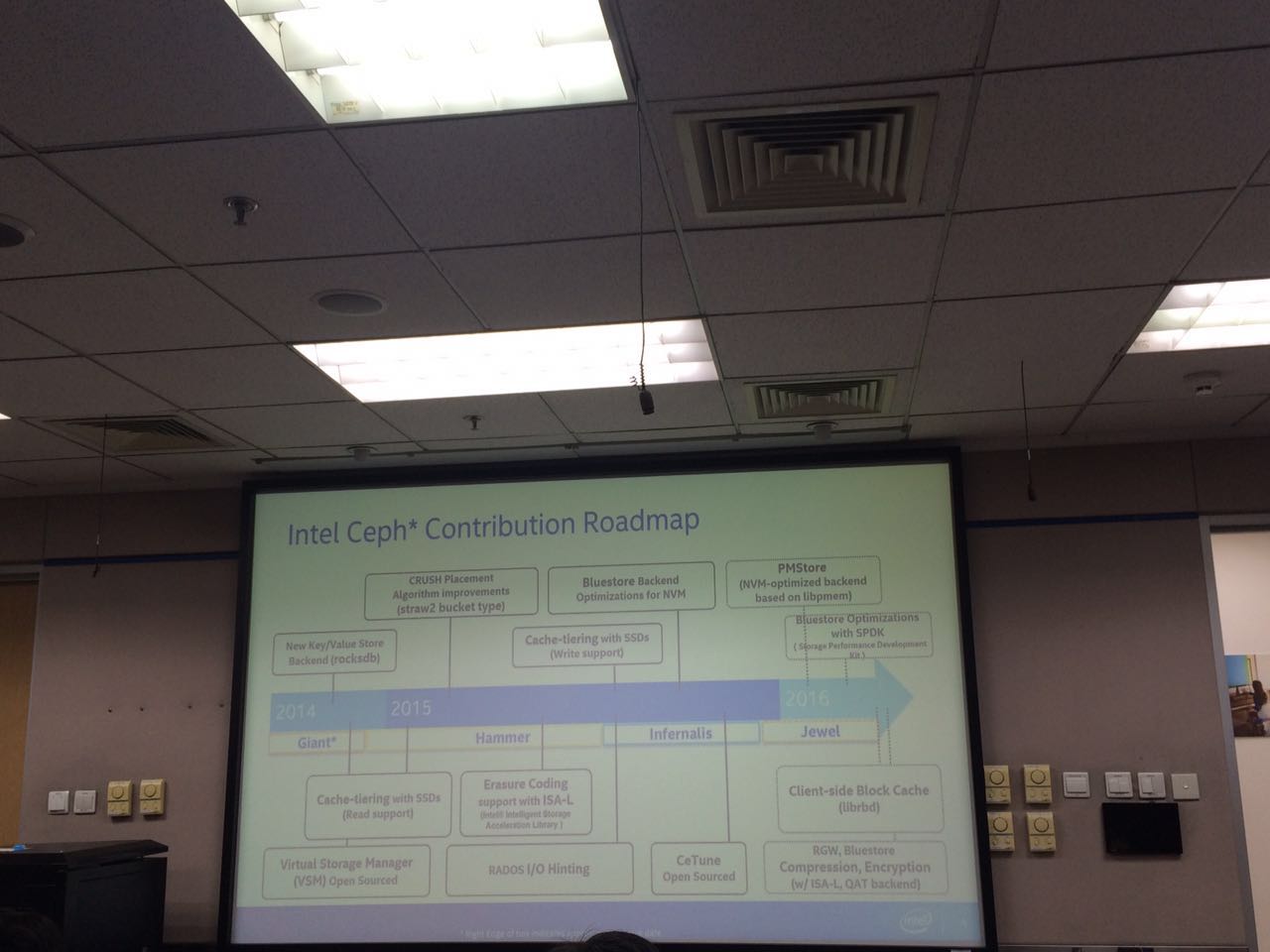

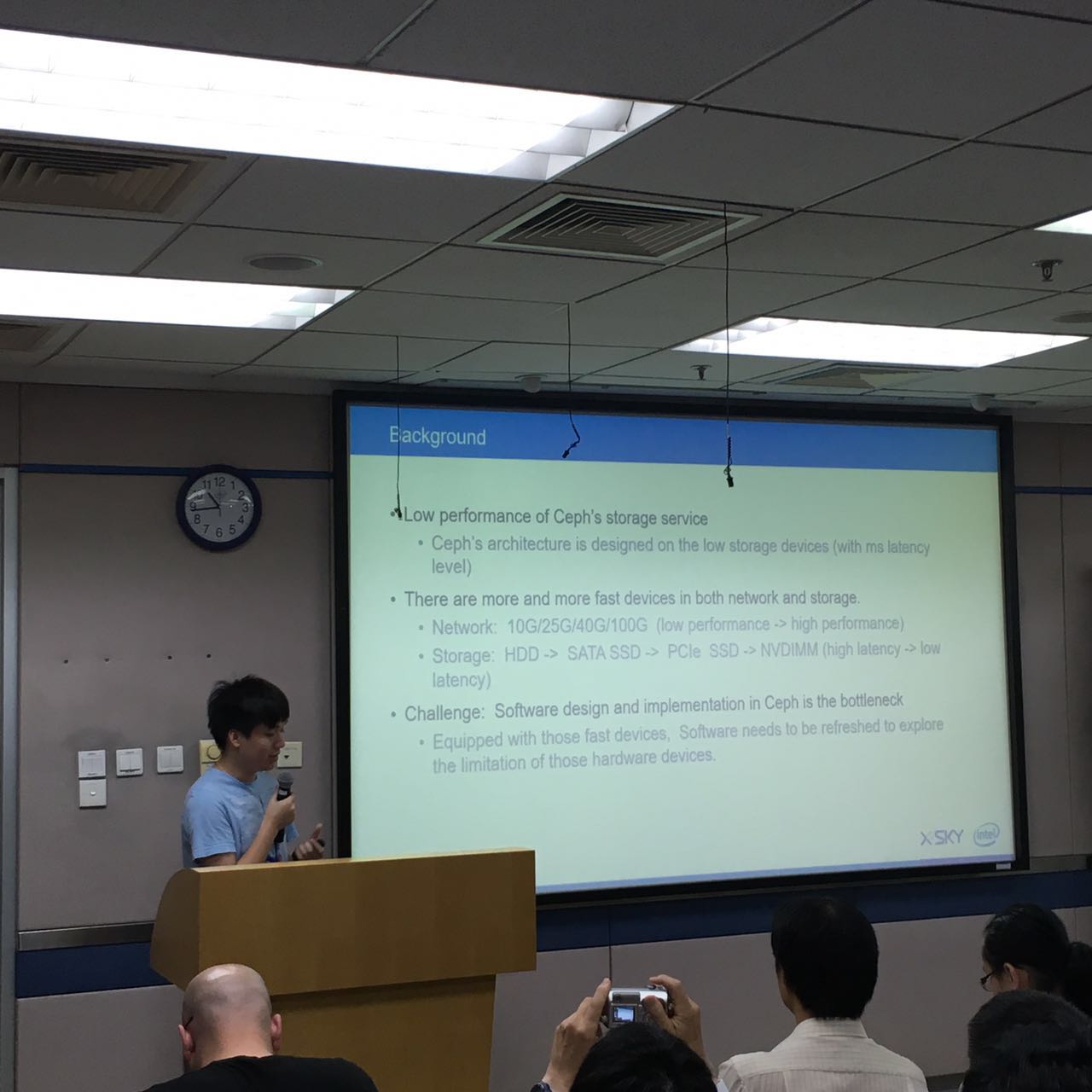

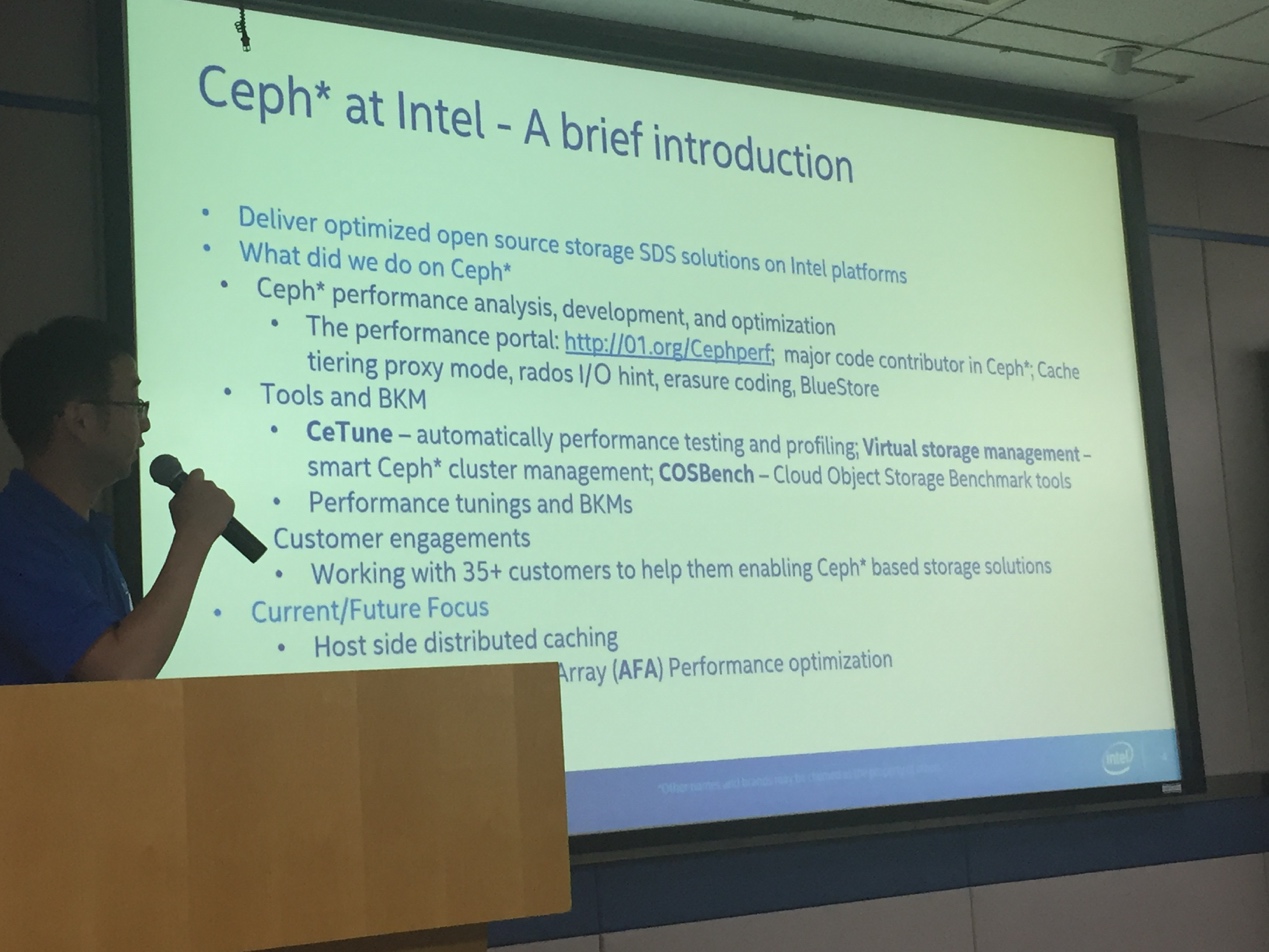

会议开始前,来自于Intel的Zhang Jian介绍了Intel对于Ceph社区的一些主要贡献。

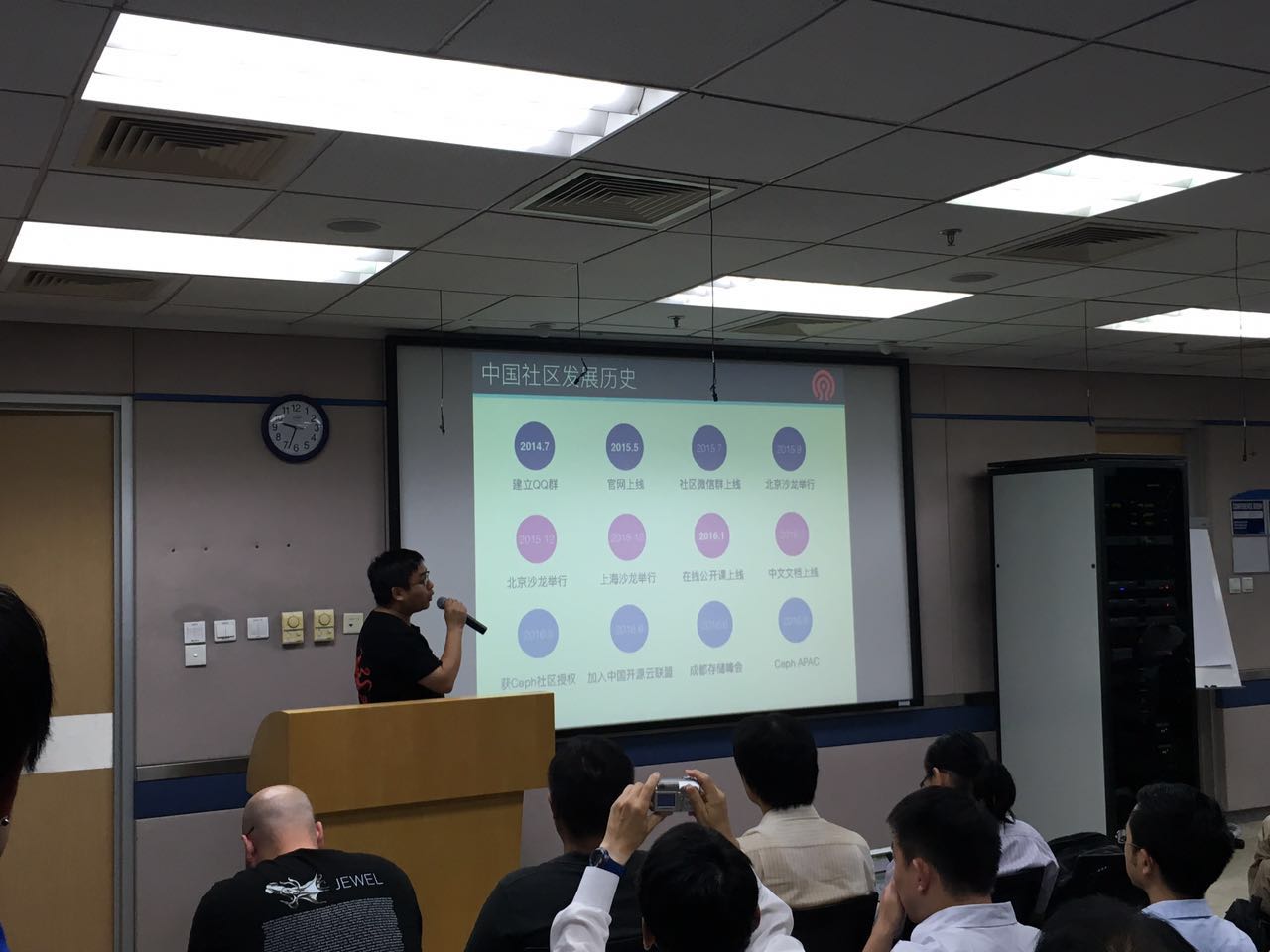

第二个演讲主题是来自于Ceph社区的Patrick大叔,开讲前放了一个很炫酷的Demo,大概就是讲述了Ceph是什么,然后介绍了一下Ceph社区当前的一些情况。接着Ceph中国社区联合创始人孙琦上台讲述了Ceph中国社区当前的一些状况,以及社区下一步的发展。

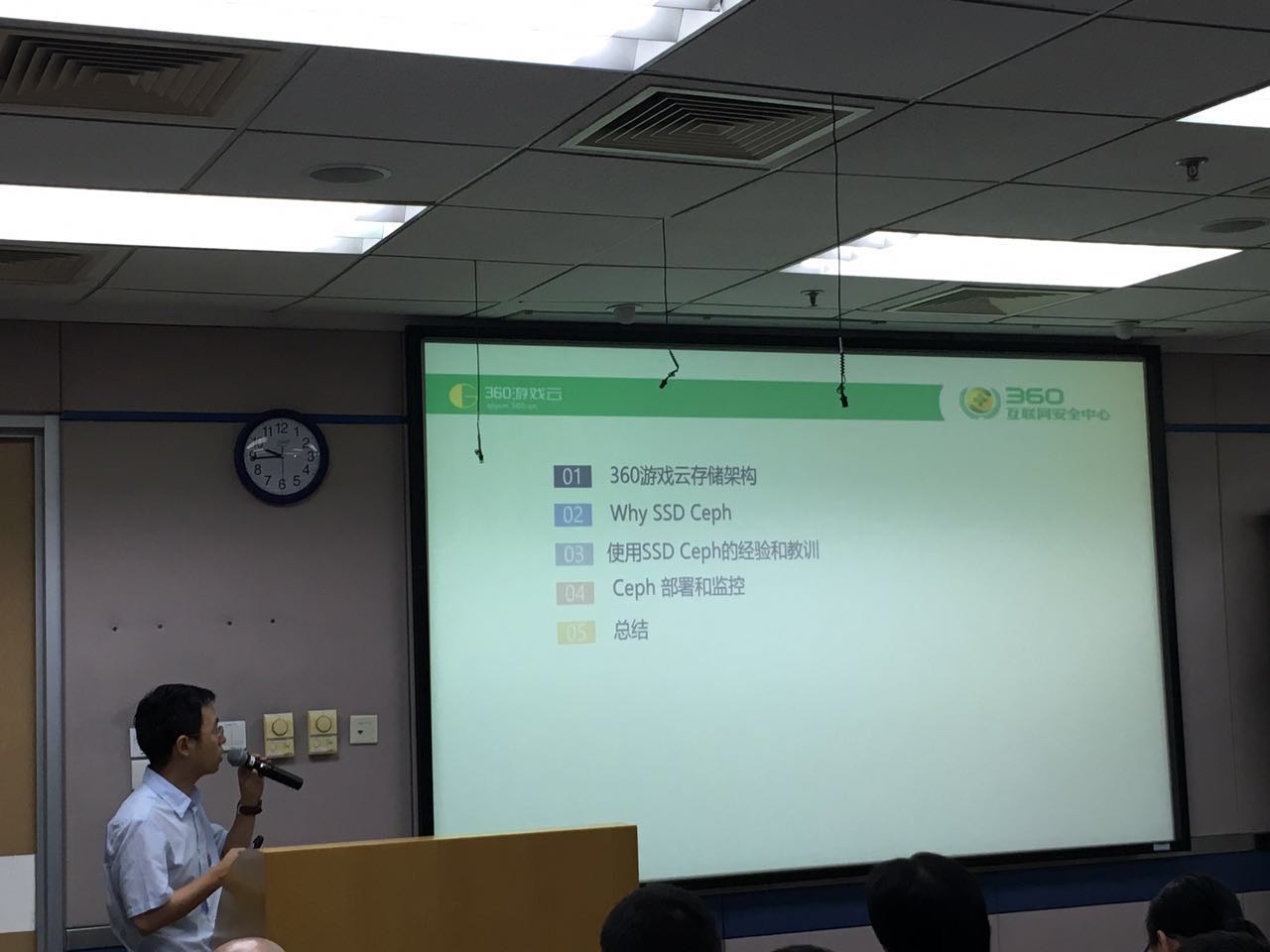

第三个演讲主题是来自于360的,讲述的是360云游戏Ceph使用架构以及全SSD的Ceph Cluster和他们在使用当中的一些经验分享、源码分析等,其中讲到Ceph的每一个硬盘被分配一个OSD,为了更好的发挥SSD的性能,要不要给每个SSD分配2个OSD?360认为目前还不够成熟,有些问题还没解决。笔者认为这个东西有利有弊,所谓鱼和熊掌不可兼得,如果追求性能,那么可以一块SSD分配两个OSD,通过Crushmap来规避一些问题,同时也节约了成本问题,但是这块SSD一旦出现故障,那么运维就很苦逼了。如果求稳定,那么你就一块SSD分配一个OSD,这样成本就会高很多,同时性能也有一些损耗。

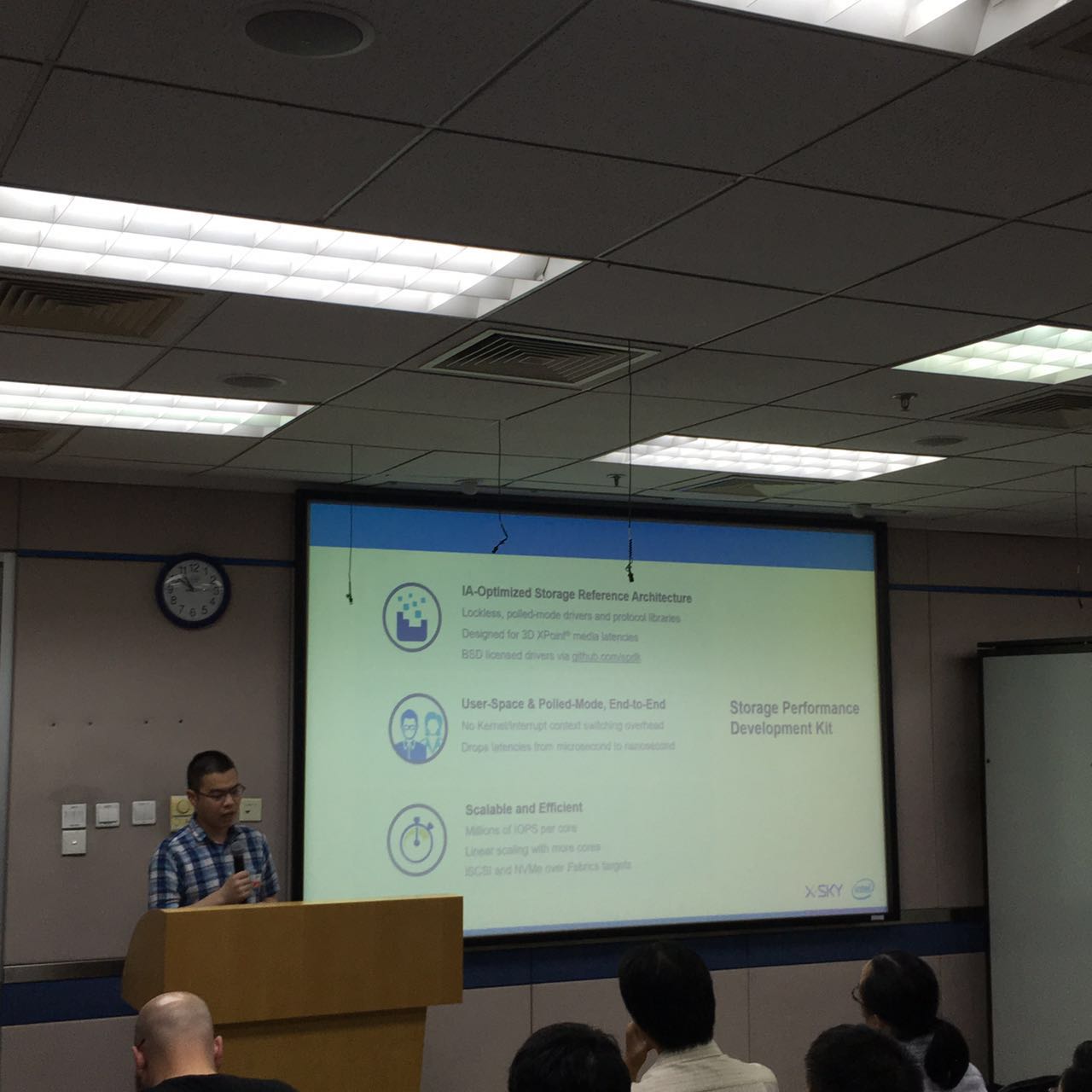

第四个演讲主题是来自Intel的Ziye Yang和XSKY的Haomai Wang,Ziye Yang讲述了SPDK的由来和当前SPDK的情况;Haomai Wang讲述了FileStore的一些不足,例如FileStore的双写问题以及FileStore依赖文件系统等,接着讲述了一下针对于SSD高性能的底层存储引擎BlueStore的设计,BlueStore存储引擎是直接管理裸盘,用RocksDB存储元数据,数据直接写入裸盘,少了中间层,性能方面根据Haomai的PPT测试数据,I/O性能比之前高了一倍。最后讲述了Ceph目前高性能面临的最大挑战是Ceph依赖的众多底层实现都不是针对SSD的,这是Ceph的一些历史原因,社区和业界正在逐步解决这些性能上的限制。

第五个演讲主题是来自台湾的一个大叔名字叫Thor Chin,他的Inwinstack公司的,这家公司我之前也是小有了解,在台湾挺活跃的,对于Ceph的宣传也是比较活跃的,之前在台湾某新闻网站看到过他们的文章。这位大叔讲述了下他们是如何使用Ceph Cache Tier的。

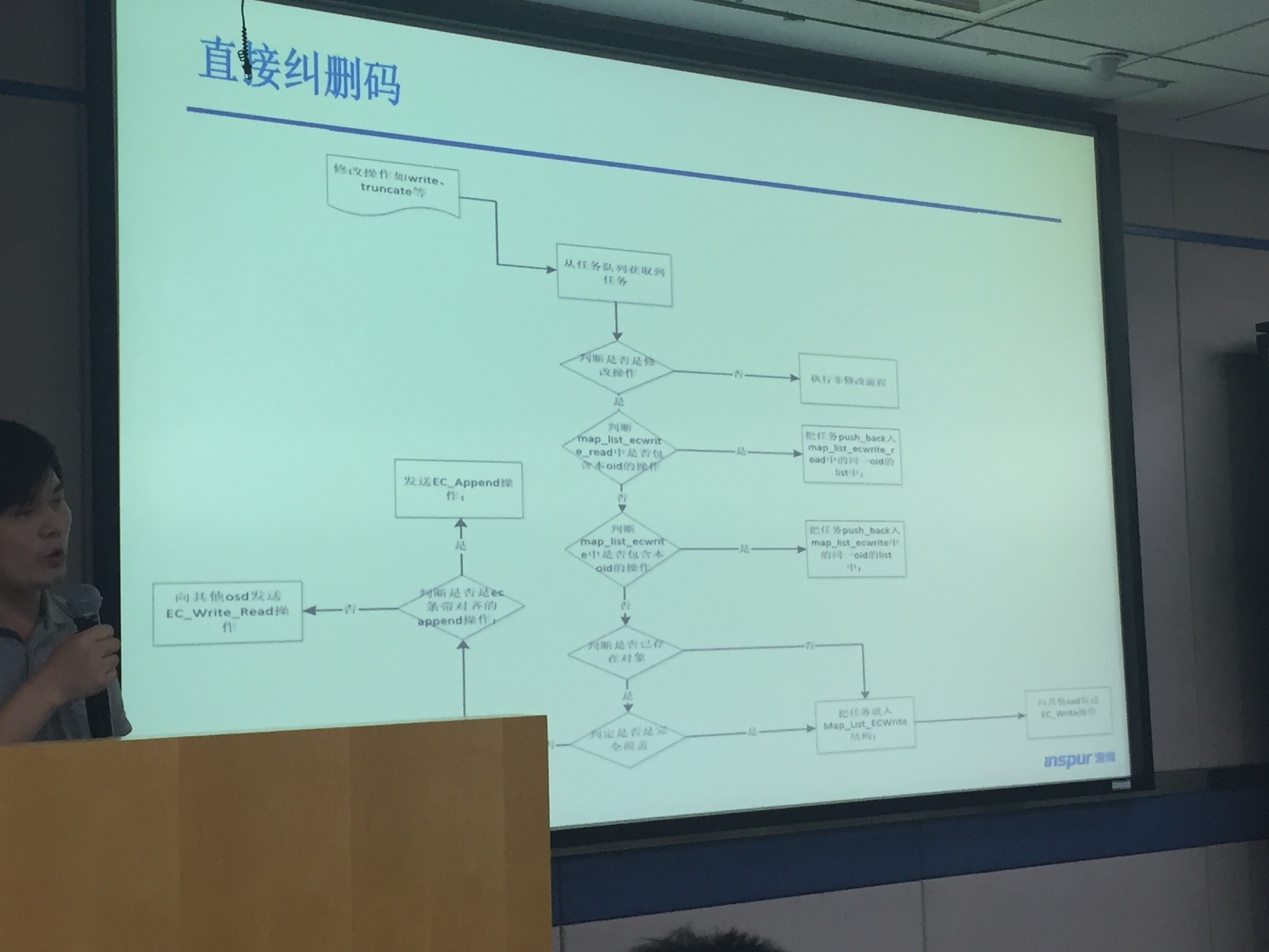

下午第一位演讲的是来自浪潮的Ying He,主要讲述了下他们对于Ceph的改进,双写纠删码、直接纠删码等等一些分享,貌似大家听得云里雾里的,这是我们社区需要努力的方向,我会在本文后面讲述下这个事情。

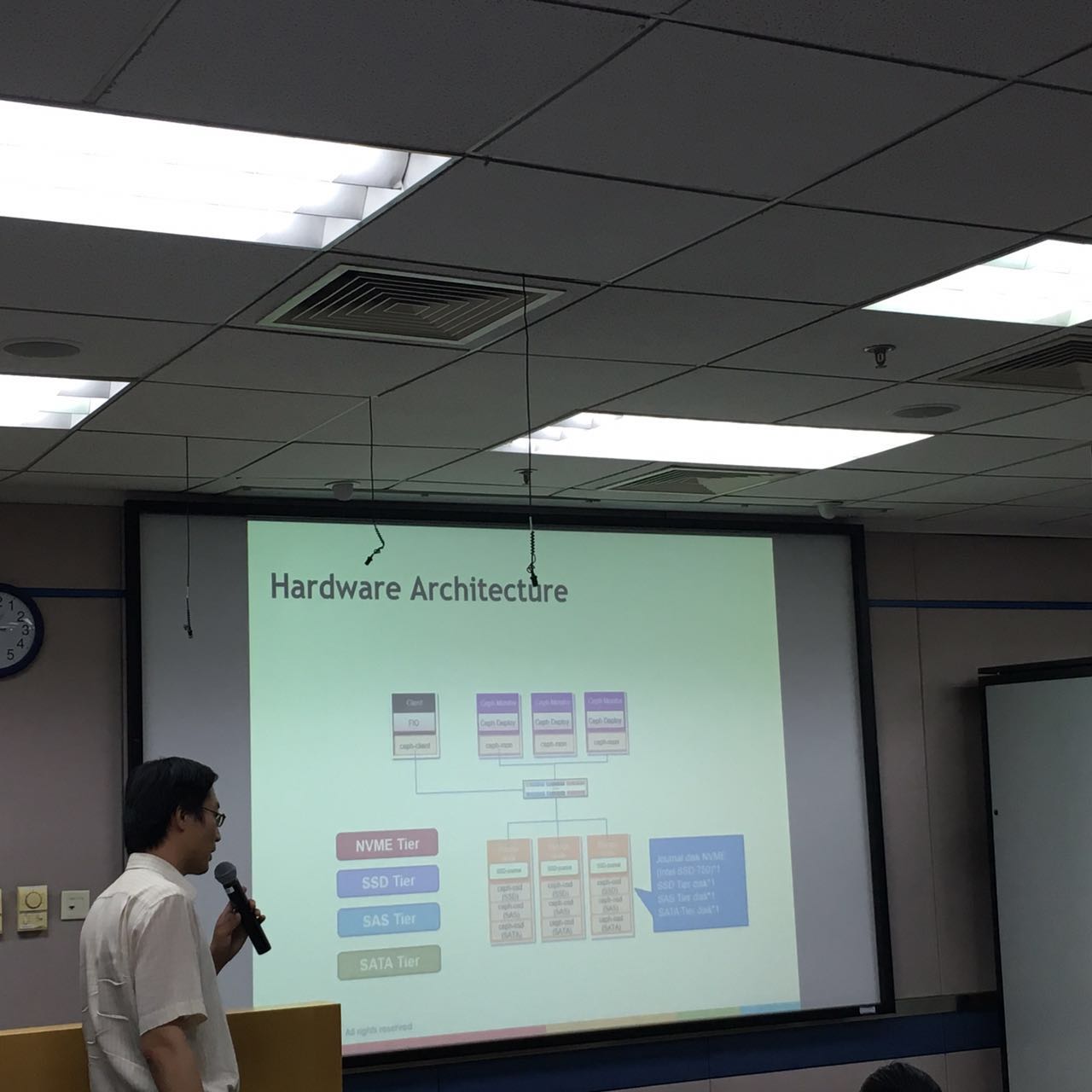

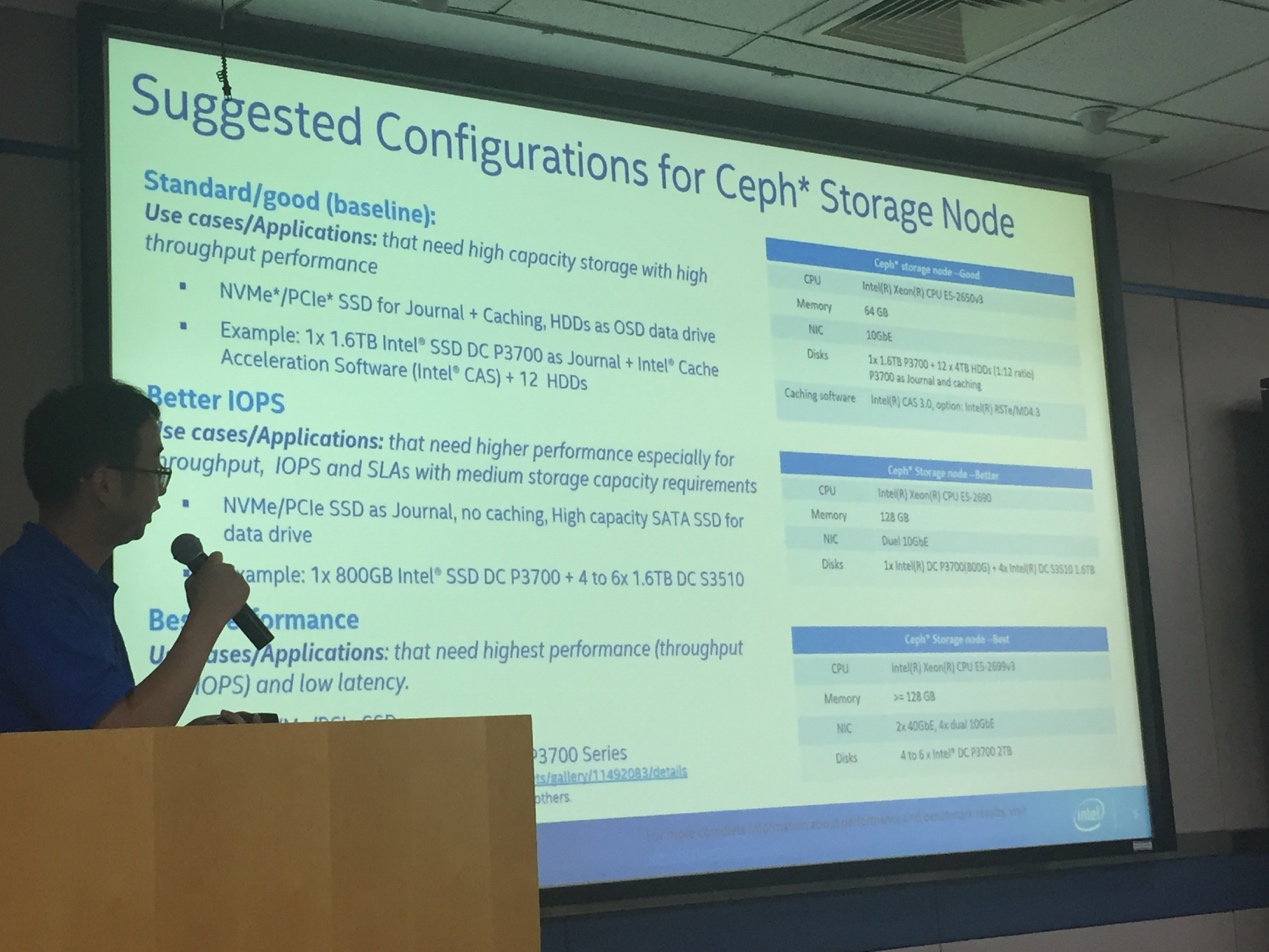

第二位演讲的是来自于Intel的Yuan Zhou和Jack Zhang,Yuan Zhou讲述了Intel在测试Ceph性能等一些方面的分享,他在讲述的时候就说到了上午360童鞋说的其中的一个问题,就是一块SSD分配两个OSD的事情,Intel在测试的时候直接给每个SSD分配了2个OSD,并列出了3种存储节点的配置:

1个PCIe NVMe SSD(Journal+Caching)和12个4TB硬盘,用E5-2650 v3+64GB内存;

1个PCIe NVMe SSD+4个SATA SSD,计算资源升到E5-2690(v3)+128GB内存;

4个PCIe NVMe SSD,用E5-2699 v3和128GB以上的内存,网络也在前面10GbE的基础上,增加了40GbE。

Jack Zhang讲述了Intel的存储进化史,其中讲到了3DxPoint技术,是一种多层线路构成的三维结构,每一层上线路互相平行,并与上下层的线路互成直角,层与层间的有“柱子”似的线在上下层的交错点连接。

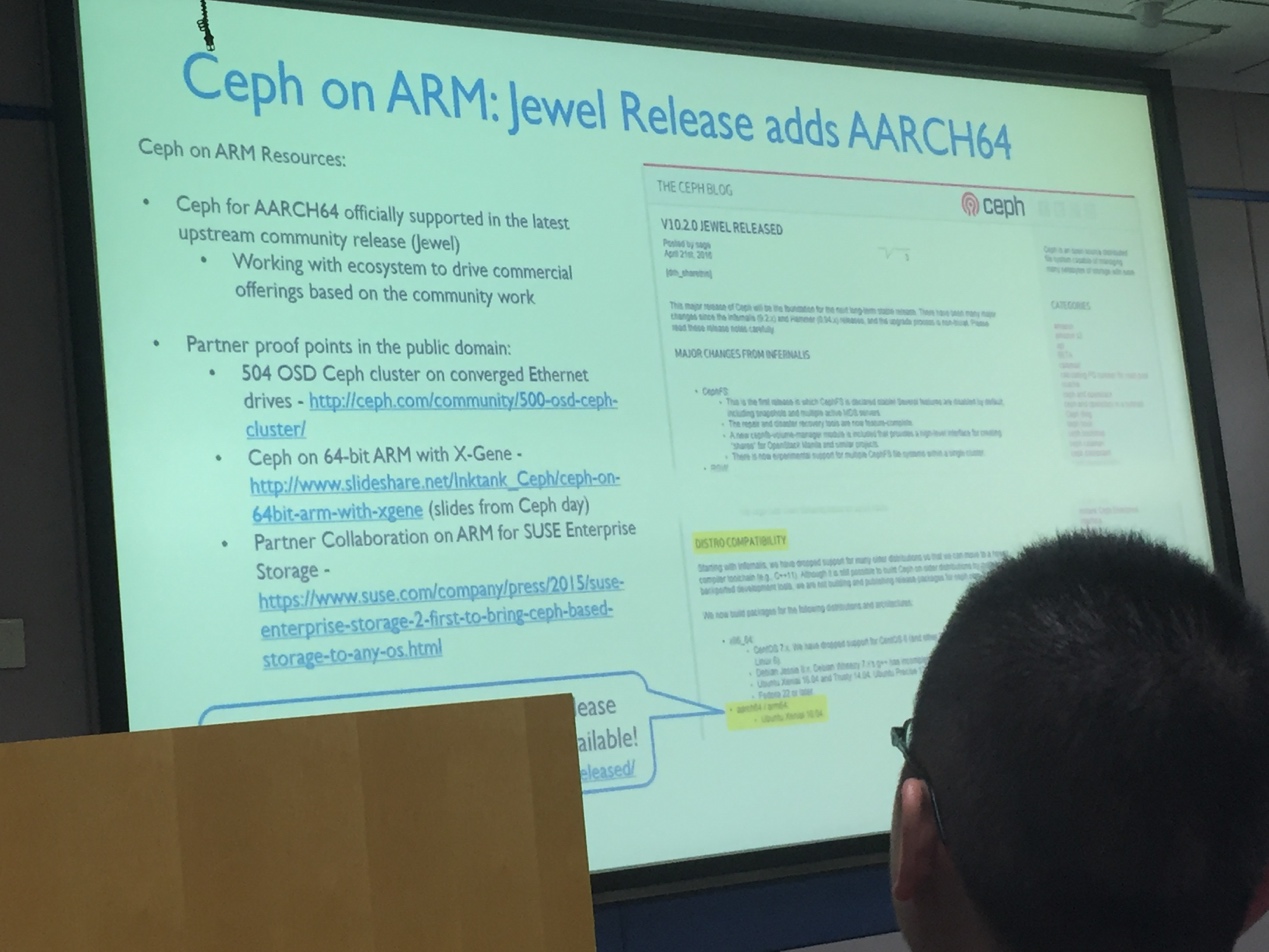

第三位演讲的是来自于ARM的Xu Luo,主要讲述了ARM的应用领域,以及Ceph on ARM架构,主要是APM(AppliedMicro)公司的一个案例。

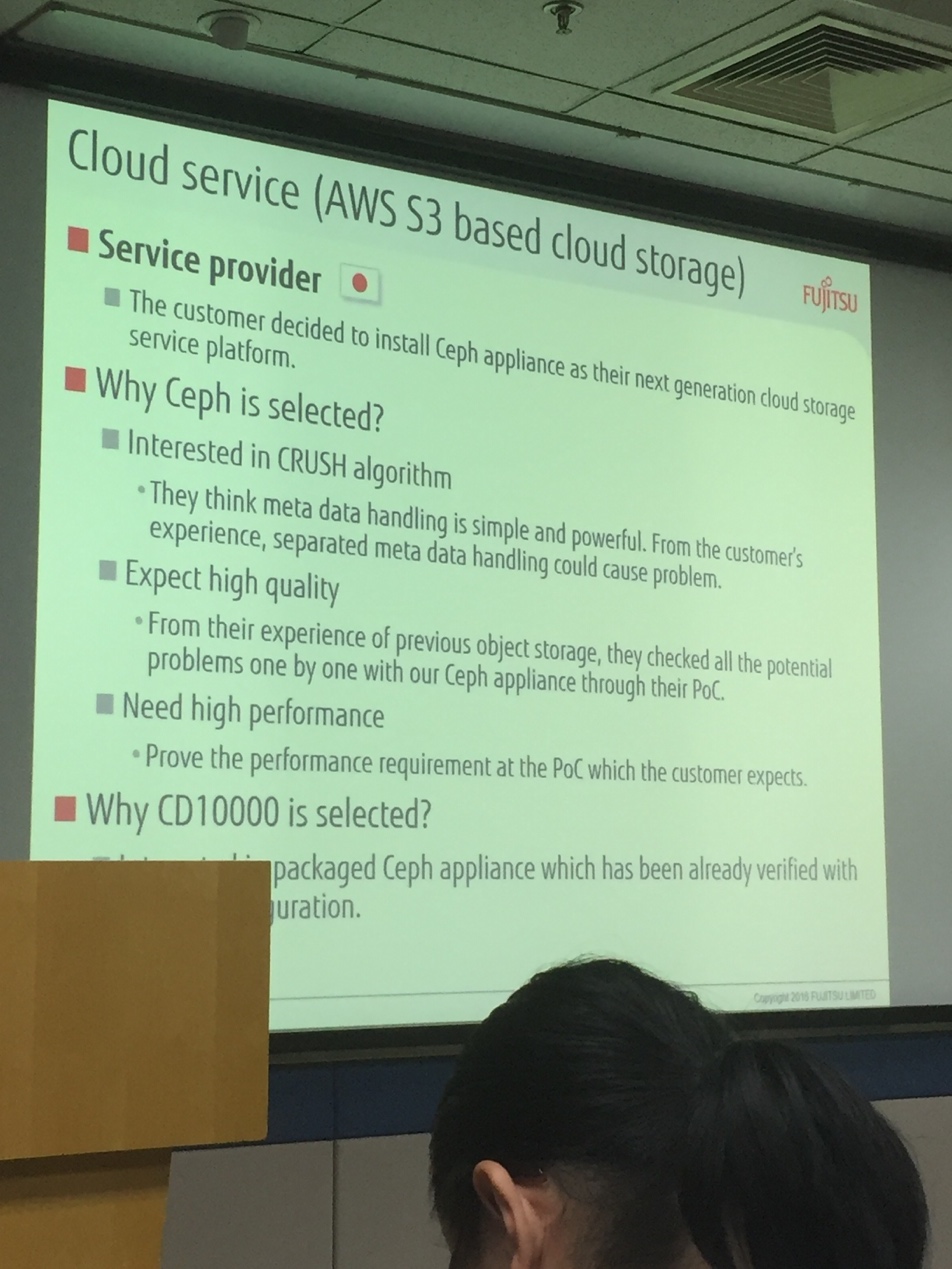

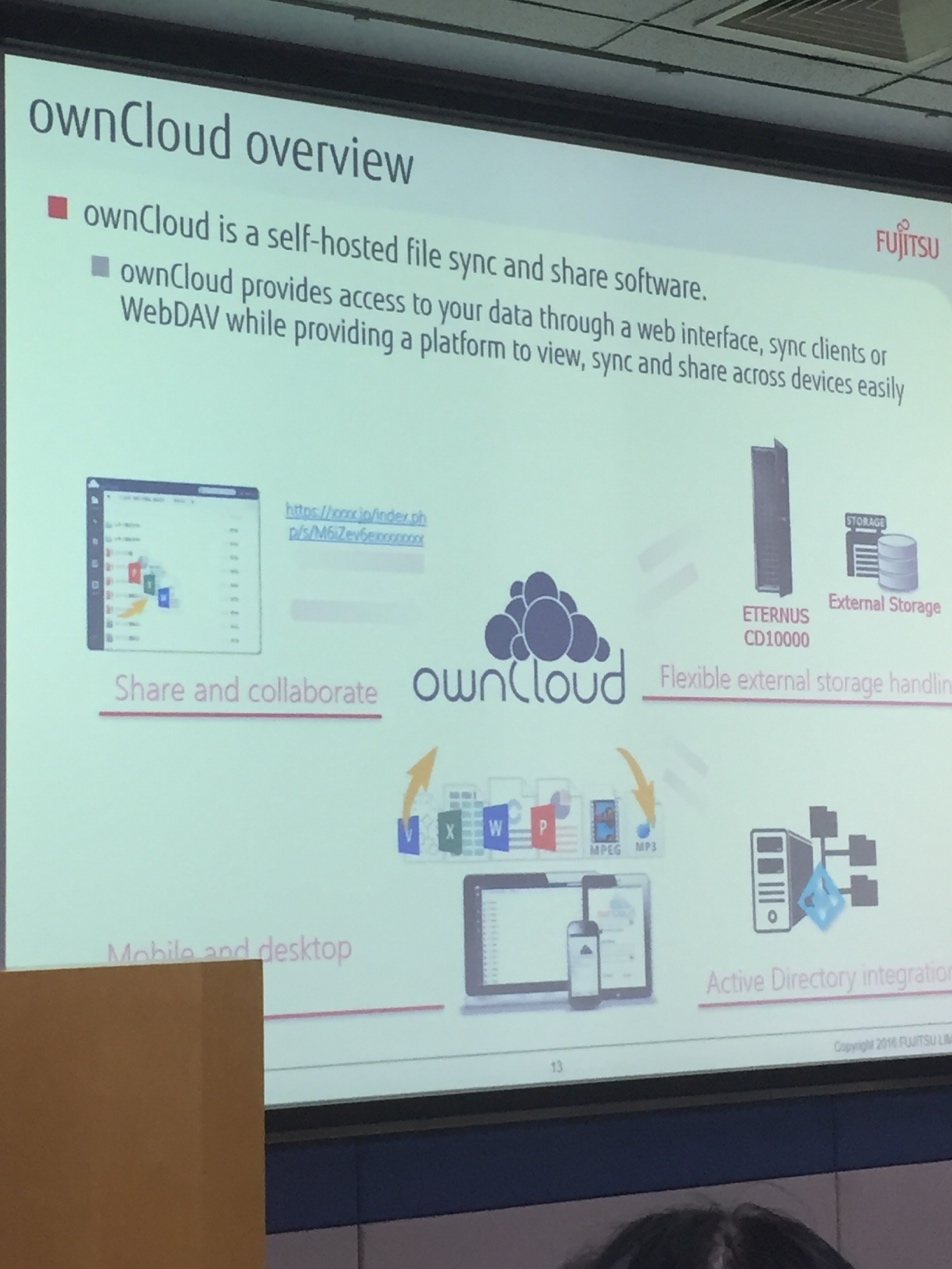

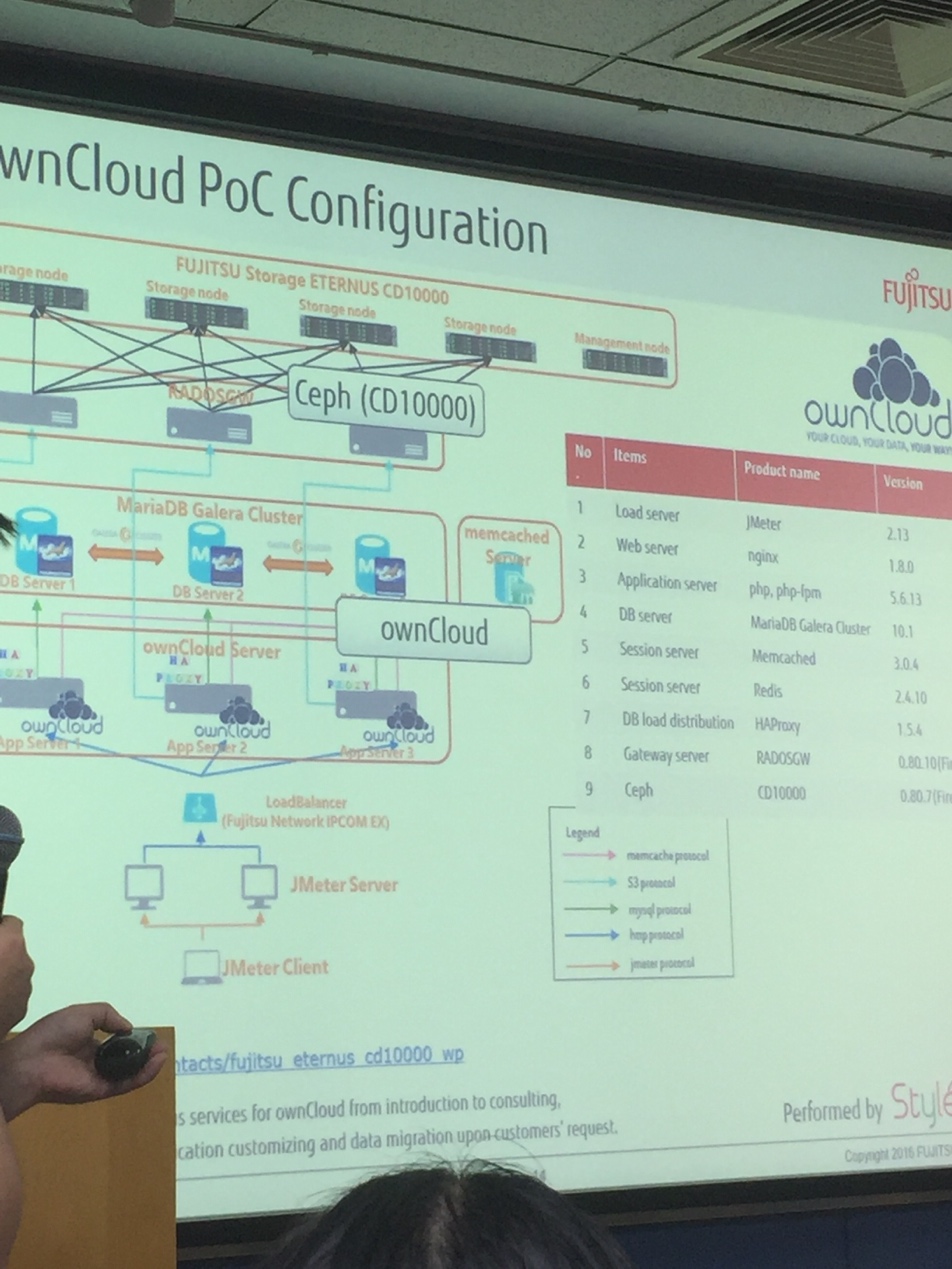

第四位演讲的是来自日本富士通的Zhigang Liu,主要讲述了下富士通基于Ceph的产品介绍以及他们的对象存储对接OwnCloud案例。同时也了解到在日本OwnCloud使用的很多。:)

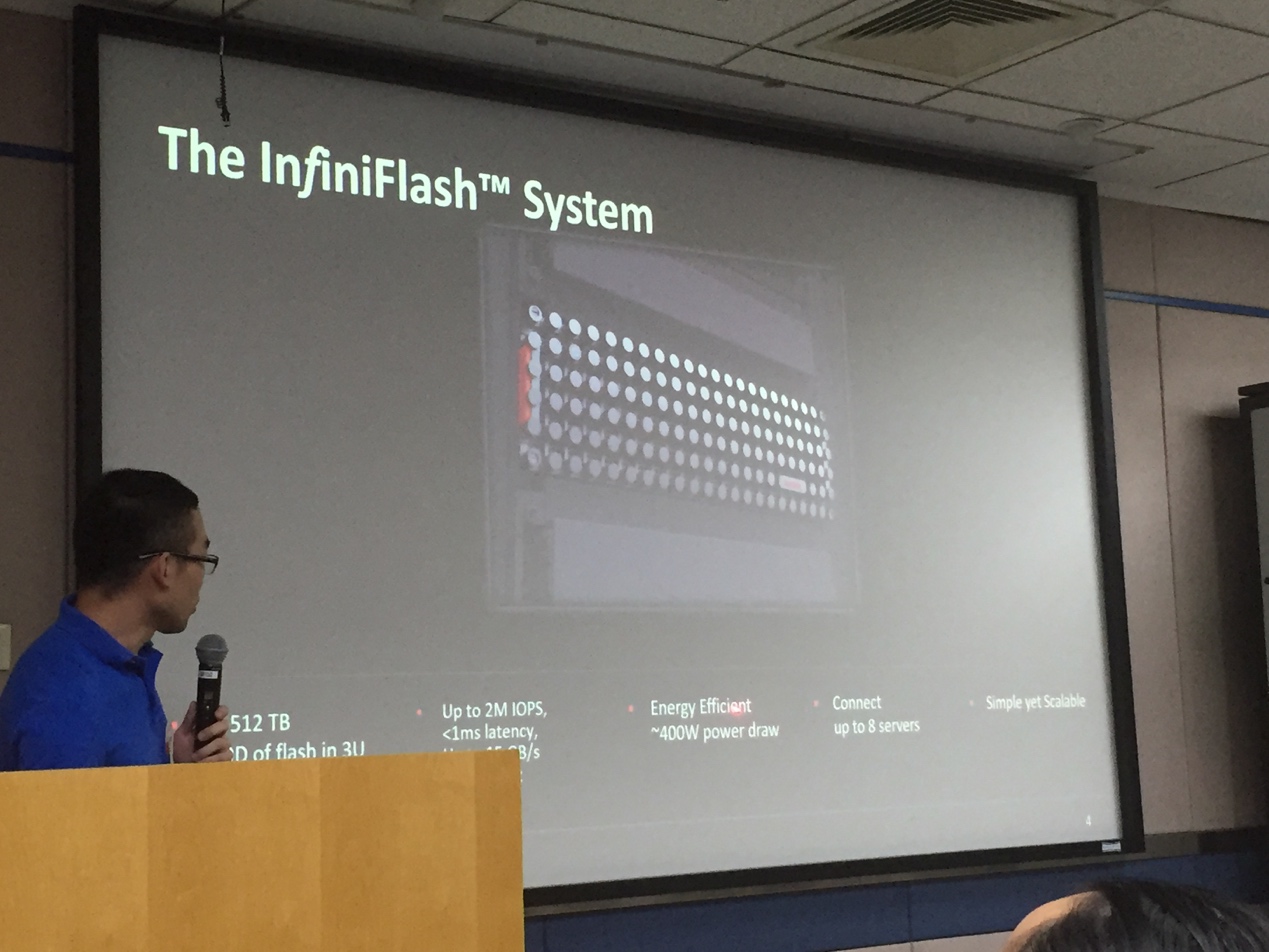

第五位演讲的是来自SanDisk的Hao Zhou,主要讲述了下他们的全闪存Ceph Cluster方案,OSD节点用的都是Mellanox的双40GbE端口网卡,以及他们在全闪存阵列上的测试数据,BlueStore能比FileStore高50%-70%的水平。

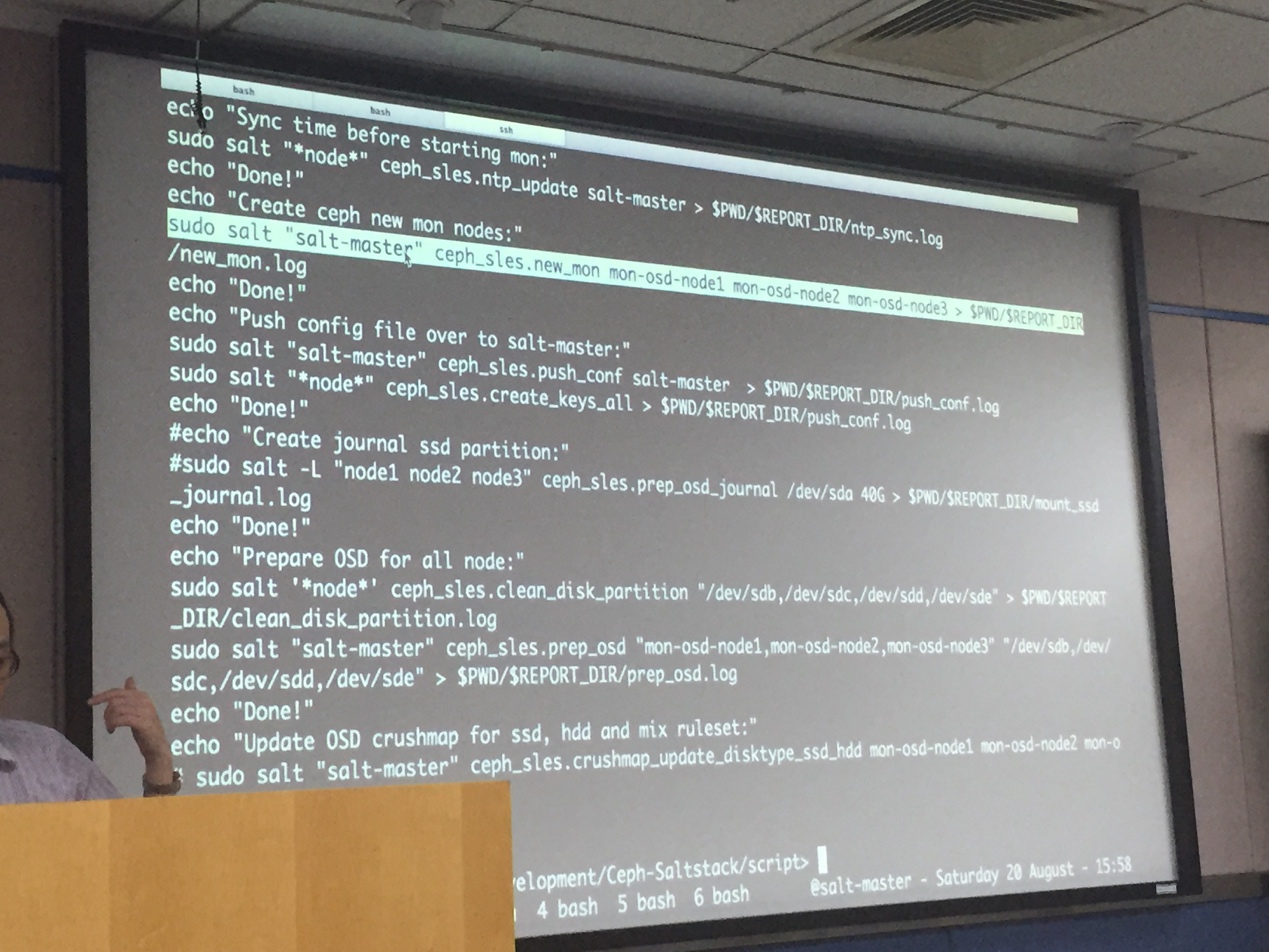

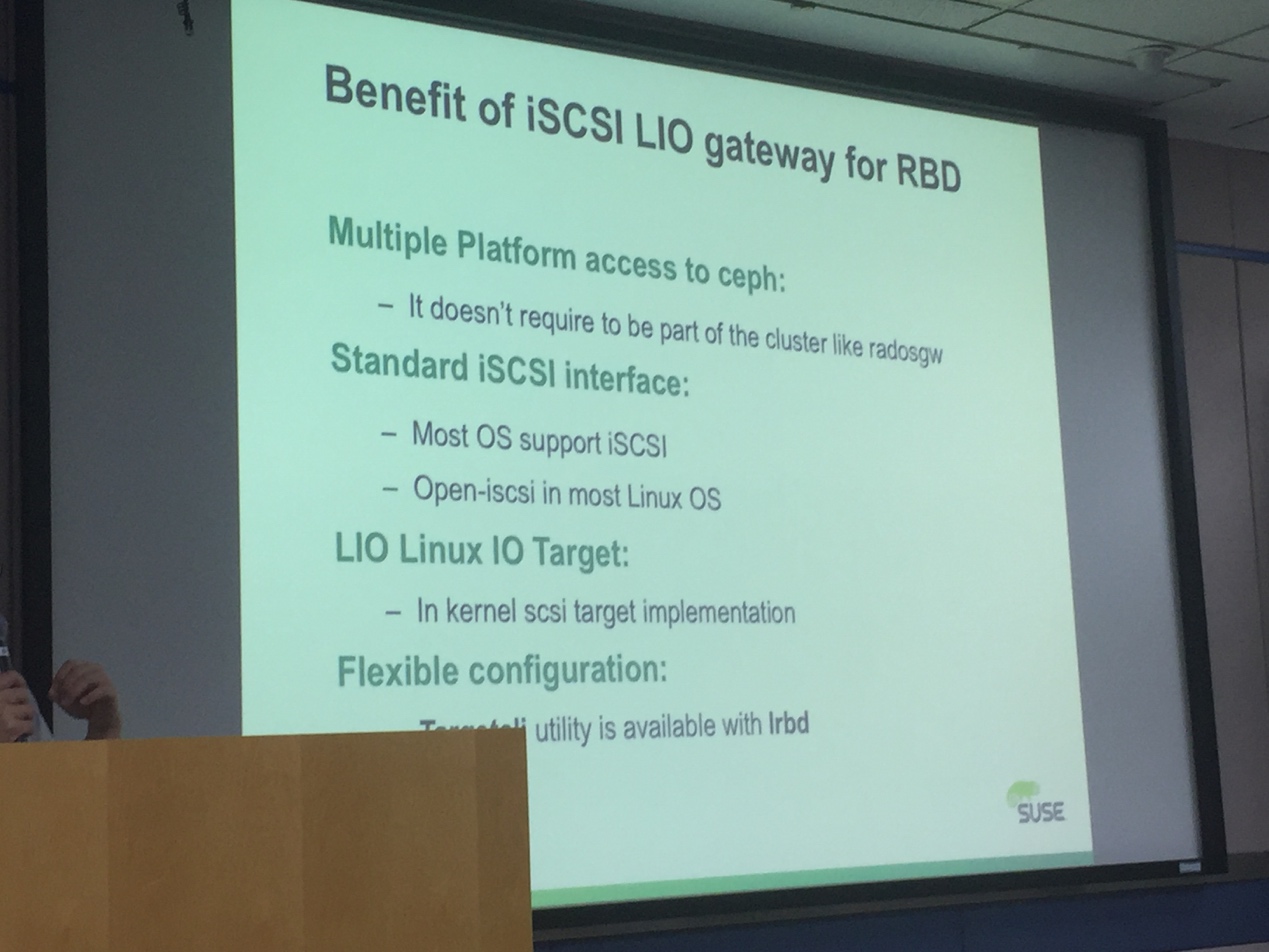

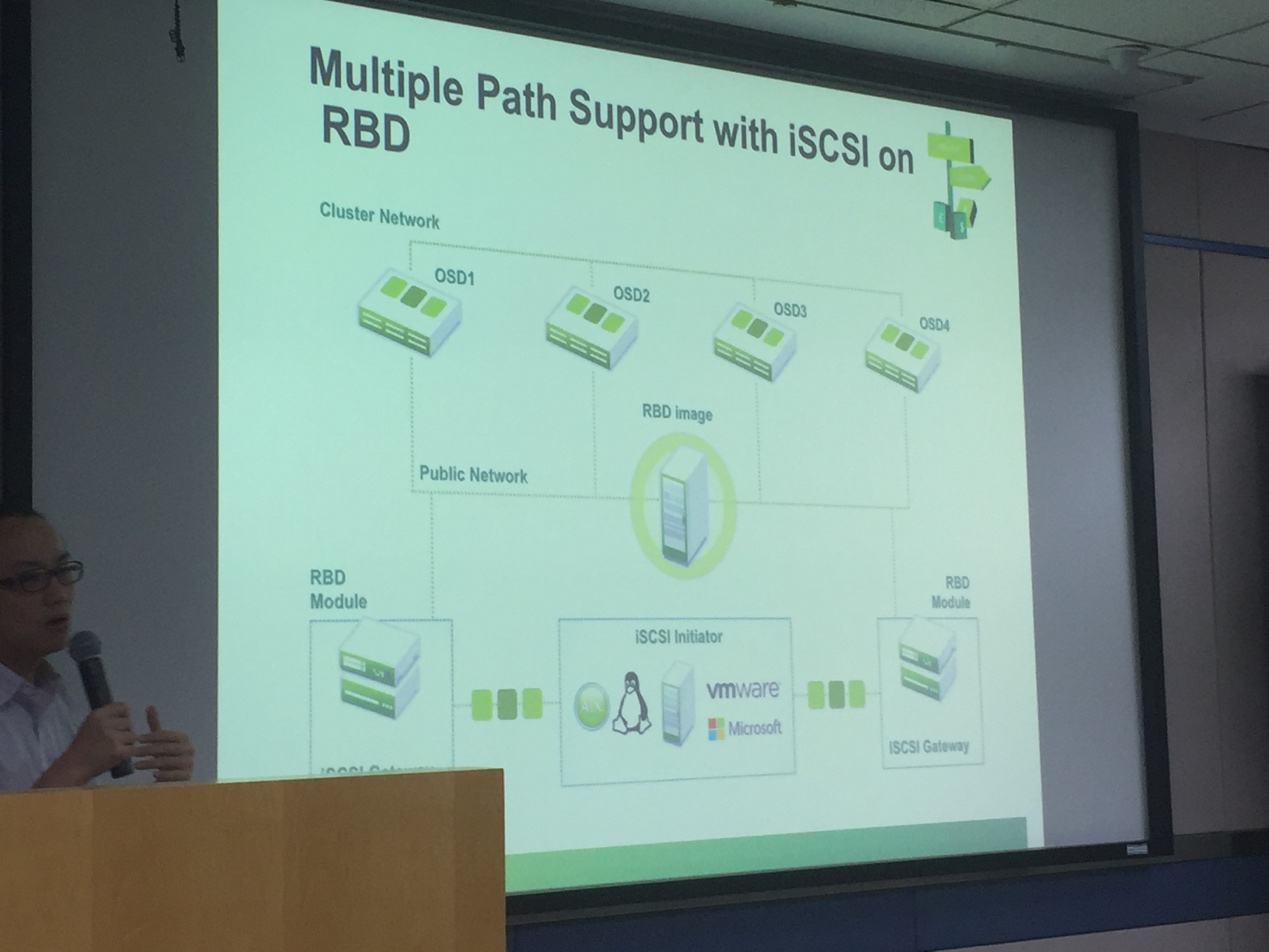

最后一位演讲的是来自SUSE的Alex Lau,他讲的比较有意思,刚上场带了个黑盒子,用来搭建Ceph集群,接着讲述了下SUSE基于Ceph做的一些企业级特性,比如ISCSI等等。

相较于去年的会议,本次会议更关注的是未来的Ceph发展趋势,例如SPDK, BlueStore、ARM架构等最前沿的社区热点,同时我们在分享中也看到了包括Ceph对象存储、大规模集群使用、成本测算等更精细化的分析。相较于去年的会议更关注Ceph调优、监控及测试的内容,今年Ceph Day的热点已经悄然发生了转变,企业用户的需求让Ceph不断的发展,我们相信未来的Ceph会更加接近Production Ready的水平。

本次会议中也是Ceph中国社区的正式亮相,来自社区的志愿者代表为参会的所有成员介绍了Ceph中国社区的发展历史、取得的成就以及未来的工作规划。社区在今年增加了CCTG小组,完成对国外新闻资讯、技术文章的本地化翻译、让国内用户更及时的了解国外的发展动态,对Ceph在国内的发展起到了良好的推进效果。

当前Ceph在中国的发展

同时也借着参加今年的Ceph Day活动,谈一谈当前Ceph在中国的发展,通过从去年Ceph Day、Ceph China Meetup等一系列布道,笔者认为当前中国Ceph形势对比前几年已经发生了决定性的变化,随着国内越来越多的各行业用户的使用,足以见证它的稳定性可靠性,如中国移动、腾讯、网易、乐视、YY、德邦物流、完美世界、国内众多Cloud公司等,正是由于众多用户的使用验证了它的稳定性和可靠性的同时也促进了Ceph的进步,使其出现了很多新东西,如Ceph for SPDK、BlueStore等等这些高性能底层技术,正是由于一些新趋势的出现,所以我们目前社区推广重心可以用六个字概括:案例、运维、培训。

为什么说是这六字呢,因为随着Ceph在中国的推广普及,更多的则是用户案例、集群维护,以及如何取之于Ceph,回归于Ceph,下面针对于这几方面展开讲述下。

用户案例

Ceph中国社区准备在今年开始逐步收集国内用户案例,并且组织甲方用户进行案例分享,从而让一些对Ceph持有犹豫想法的人产生改变的想法,更好的转变传统架构进入SDS时代。

集群维护

集群维护无论是什么时期,都是重中之重,因为数据是至高无上的,所以无论什么时候都必须保证集群的稳定。Ceph中国社区也将会在下半年展开Meetup继续让一线工程师分享最接地气的踩坑经验,同时社区在去年组织编写的《Ceph分布式存储系统实战》一书也将在今年10月份左右出版,可以让Ceph新手更快的熟悉Ceph。

如何取之于Ceph,回归于Ceph?

这时候就需要大量的Ceph ops以及Ceph developer,而目前国内Ceph市场从业人员严重稀缺,各家Ceph使用单位都需要Ceph ops&developer,就如同孙琦所说“当前Ceph在中国的发展就如同两年前OpenStack在中国的发展”目前国内已经涌现出大量的OpenStack案例、OpenStack ops&developer以及OpenStack Train ,当然有一部分功劳也是要归功于OpenStack Train培养了很多稀缺性人才,缓解了当前OS公司对于人才稀缺的问题,使得OS公司取之于OS社区,回归于OS社区。最明显的提升是OpenStack Mitaka版本相比于L版本来说来自中国的社区贡献幅度达42%,另外Ceph中国社区也将计划明年联合中国开源云联盟中的企业组织Ceph Hackathon活动,以此来促进国内Ceph公司对Ceph代码的良性循环,取之于Ceph社区,回归于Ceph社区。要让全世界的人看到中国企业不仅仅是在OpenStack中贡献幅度大,在Ceph社区中的贡献同样显著。

Ceph推广以及培训

现在Ceph的发展也一样,需要建立起一套标准的Ceph Train来缓解目前对Ceph人才的稀缺问题,针对于Ceph稀缺性人才问题,Ceph中国社区将在下半年也会进行Ceph校园行将以京津冀地区高校为试点辐射全国,所谓开源、Ceph宣传推广从校园开始,响应国家号召促进大学生就业和积极参与开源社区贡献。

通过今年下半年以及明年的努力,我相信Ceph在中国的发展也会像OpenStack一样如火如荼。让我们一同期待!

作者:耿航

1328

1328

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?