一、极限学习机的概念

极限学习机(Extreme Learning Machine) ELM,是由黄广斌提出来的求解单隐层神经网络的算法。

ELM最大的特点是对于传统的神经网络,尤其是单隐层前馈神经网络(SLFNs),在保证学习精度的前提下比传统的学习算法速度更快。

二、极限学习机的原理

ELM是一种新型的快速学习算法,对于单隐层神经网络,ELM可以随机初始化输入权重和偏置并得到相应的输出权重。

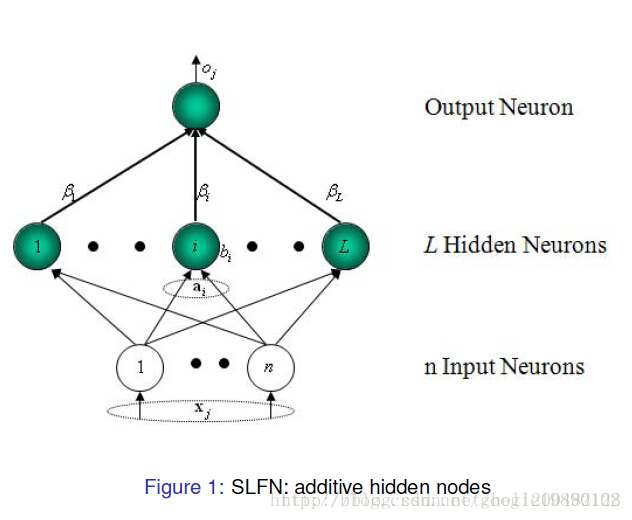

(选自黄广斌老师的PPT)

对于一个单隐层神经网络(见Figure 1),假设有

N

个任意的样本(

其中, g(x) 为激活函数, Wi=[wi1,wi2,...,win]T 为输入权重, βi 输出权重, bi 是第 i 个隐层单元的偏置。

单隐层神经网络学习的目标是使得输出的误差最小,可以表示为

∑j=1N||oj−tj||=0

即存在 βi , Wi 和 bi ,使得

∑i=1Lβig(Wi⋅Xj+bi)=tj,j=1,...,N

可以矩阵表示为

Hβ=T

其中, H 是隐层节点的输出,

β=⎡⎣⎢⎢βT1⋮βTL⎤⎦⎥⎥L×m,T=⎡⎣⎢⎢TT1⋮TTL⎤⎦⎥⎥L×m

为了能够训练单隐层神经网络,我们希望得到 W^i , b^i 和 β^i ,使得

||H(W^i,b^i)β^i−T||=minW,b,β||H(Wi,bi)βi−T||

其中, i=1,...,L ,这等价于最小化损失函数

E=∑j=1N(∑i=1Lβig(Wi⋅Xj+bi)−tj)2

传统的一些基于梯度下降法的算法,可以用来求解这样的问题,但是基本的基于梯度的学习算法需要在迭代的过程中调整所有参数。而在ELM算法中, 一旦输入权重 Wi 和隐层的偏置 bi 被随机确定,隐层的输出矩阵 H 就被唯一确定。训练单隐层神经网络可以转化为求解一个线性系统

β^=H+T

其中,是矩阵的Moore-Penrose广义逆。且可证明求得的解的范数是最小的并且唯一。

三 实验

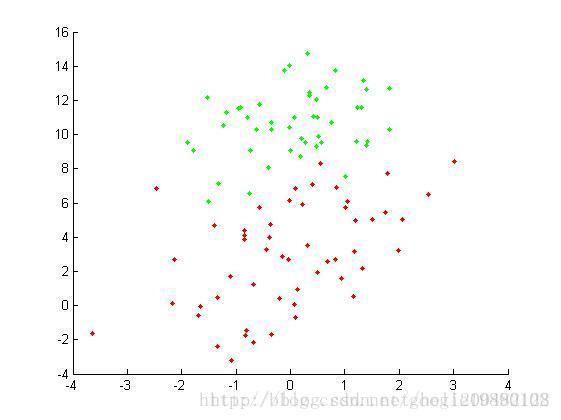

我们使用《简单易学的机器学习算法——Logistic回归》中的实验数据。

原始数据集

我们采用统计错误率的方式来评价实验的效果,其中错误率公式为:

errorRate=NumErrorNumAll

对于这样一个简单的问题,

errorRate=0

。

MATLAB代码

主程序

%% 主函数,二分类问题

%导入数据集

A = load('testSet.txt');

data = A(:,1:2);%特征

label = A(:,3);%标签

[N,n] = size(data);

L = 100;%隐层节点个数

m = 2;%要分的类别数

%--初始化权重和偏置矩阵

W = rand(n,L)*2-1;

b_1 = rand(1,L);

ind = ones(N,1);

b = b_1(ind,:);%扩充成N*L的矩阵

tempH = data*W+b;

H = g(tempH);%得到H

%对输出做处理

temp_T=zeros(N,m);

for i = 1:N

if label(i,:) == 0

temp_T(i,1) = 1;

else

temp_T(i,2) = 1;

end

end

T = temp_T*2-1;

outputWeight = pinv(H)*T;

%--画出图形

x_1 = data(:,1);

x_2 = data(:,2);

hold on

for i = 1 : N

if label(i,:) == 0

plot(x_1(i,:),x_2(i,:),'.g');

else

plot(x_1(i,:),x_2(i,:),'.r');

end

end

output = H * outputWeight;

%---计算错误率

tempCorrect=0;

for i = 1:N

[maxNum,index] = max(output(i,:));

index = index-1;

if index == label(i,:);

tempCorrect = tempCorrect+1;

end

end

errorRate = 1-tempCorrect./N; 激活函数

function [ H ] = g( X )

H = 1 ./ (1 + exp(-X));

end 黄老师提供的极限学习机的代码:http://www.ntu.edu.sg/home/egbhuang/elm_codes.html

836

836

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?