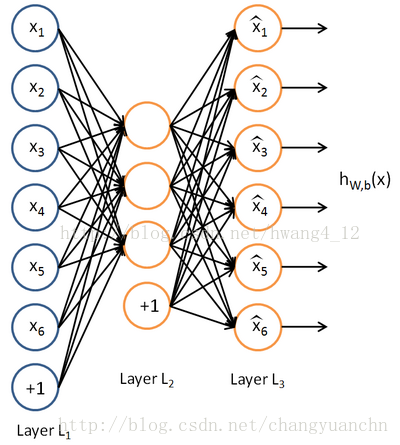

Auto-Encoder(AE)是20世纪80年代晚期提出的,它是一种无监督学习算法,使用了反向传播算法,让目标值等于输入值。基本的AE可视为一个三层神经网络结构:一个输入层、一个隐藏层和一个输出层,其中输出层与输入层具有相同的规模。

AE最初是作为一个降维手段来进行的,要是编码器那里没有使用非线性部分,那么就可以等价为PCA算法来使用。(初始的维数大于编码器输出的维数的时候)

而现在编码器的输出维数大于输入的维数(over-complete setting),获取更高维,更加有意义的表示。

AE有一个问题就是要是直接对上面的损失函数(平方误差或者交叉熵)进行训练的话,很可能就会得到一个恒等函数。解决此问题的常用的一些方法,有在损失函数里面引入稀疏性(sparse AE),或者在网络中引入随机性(如RBM,Denoising AE)。

标准自编码器(在基本的自编码器里面引入正则化项就行,一般是L1或者L2正则化项。)

标准自编码器实则是对权重的设置提出要求,限制权重,避免过大

最左边的是一个输入层,中间是隐藏层,最右边是输出层,输出层的神经元数量完全等于输入层神经元的数量。隐藏层的神经元数量少于输出层。 自编码网络的作用是,将输入样本压缩到隐藏层,再在输出端重建样本。其目标是使输出和输入之间尽量的小。

神经网络权重矩阵的初始化,经验之谈,xaviar initialization。如果权重初始化得太小,那信号在每层间传递是逐渐缩小而难以产生作用,但是如果权重初始化得太大,那信号将在每层间逐渐放大并且导致发散和失效。xaviar initialization就是让均值满足为0,方差是

损失函数:

本文介绍了自编码器(AutoEncoder, AE)的基本原理和用途,特别是降噪自编码器(Denoising AE)在解决恒等函数问题上的应用。AE通过非线性编码和解码过程学习数据的低维表示。当直接使用平方误差损失函数训练时,可能会得到恒等函数,为此引入了稀疏性正则化或随机性,如稀疏AE和RBM。文章还讨论了标准自编码器的正则化项,以及神经网络权重的初始化,如Xavier初始化。最后,概述了损失函数在自编码器训练中的作用。"

129290149,9284270,8255芯片实现键盘扫描与数码管显示,"['汇编', '硬件接口', '嵌入式开发']

本文介绍了自编码器(AutoEncoder, AE)的基本原理和用途,特别是降噪自编码器(Denoising AE)在解决恒等函数问题上的应用。AE通过非线性编码和解码过程学习数据的低维表示。当直接使用平方误差损失函数训练时,可能会得到恒等函数,为此引入了稀疏性正则化或随机性,如稀疏AE和RBM。文章还讨论了标准自编码器的正则化项,以及神经网络权重的初始化,如Xavier初始化。最后,概述了损失函数在自编码器训练中的作用。"

129290149,9284270,8255芯片实现键盘扫描与数码管显示,"['汇编', '硬件接口', '嵌入式开发']

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2092

2092

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?