美光(Micron)官宣要量产12层堆叠的HBM内存,还拿下了英伟达(NVIDIA)的订单!这波操作直接把对手三星和SK海力士卷懵了——毕竟这玩意儿可是AI芯片的“黄金搭档”,谁抢到英伟达的合同,谁就能在AI军备竞赛里躺赢。

美光的“叠叠乐”有多牛?

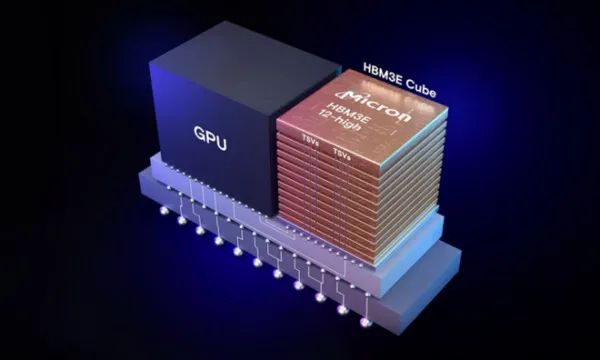

简单来说,HBM就是把内存芯片像乐高一样垂直堆起来,层数越多,性能越强。美光这次堆到了12层,直接甩出两大优势:

- 功耗暴降20%:同样跑AI模型,电费账单直接打八折。

- 容量飙升50%:对比友商的8层产品,相当于从“小背包”升级成“搬家货车”。

更狠的是,美光去年9月就搞定了样品测试,现在直接开足马力生产,下半年大部分HBM都要上12层。难怪英伟达果断签单——毕竟老黄的显卡就靠这内存喂数据呢!

三星掉队,SK海力士憋大招?

反观三星,画风就有点惨了……

- 8层HBM才刚小规模量产,12层连测试都没过,月底才能给英伟达送样品,能不能通过还是未知数。

- 隔壁SK海力士则已经开始猛攻HBM4,号称年内搞定。但美光也没闲着,直接预告明年上HBM4,这波“套娃式内卷”简直离谱。

说白了,技术迭代比翻脸还快。三星要是再磨蹭,别说抢单了,市场份额都得被美光啃掉一大块。

为什么HBM成了AI时代的香饽饽?

AI训练就像让GPU“干饭”,数据量越大越要吃得快。传统内存带宽不够,GPU容易“饿肚子”,HBM直接把饭碗怼到GPU嘴边——堆得越高,喂得越猛。

尤其是ChatGPT这类大模型爆火后,英伟达的显卡卖到断货,HBM也跟着躺赚。谁能堆得高、耗得少,谁就是AI产业链的“供氧机”。

未来看点:堆层数还是玩工艺?

现在各家路线开始分化:

- 美光:12层稳了,明年冲HBM4。

- 三星:咬牙追12层,同时押注10纳米第六代DRAM(听起来很唬人,但量产还早)。

- SK海力士:已经搞定12层,all in HBM4。

不过消费者可能更关心:这波堆叠大战,会不会让显卡价格继续起飞?(毕竟HBM成本摆在那儿……)

总之,美光这波操作算是给行业扔了颗炸弹。至于三星能不能绝地反杀?

小道消息:听说国内某大厂也在偷偷搞HBM,“国产12层”还要多久?(手动狗头)

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?