ollama是什么:

OLLAMA是一个开源框架,专为在本地机器上便捷部署和运行大型语言模型(LLM)而设计。这个框架提供了一套简单的工具和命令,使任何人都可以轻松地启动和使用各种流行的LLM,例如GPT-3、Megatron-Turing NLG和WuDao 2.0。Ollama的主要特点包括简化部署、丰富的模型库、跨平台支持以及灵活的自定义选项。它支持多种操作系统,包括Windows、macOS和Linux,使其能够满足不同用户的需求

开始:

部署OLLAMA框架以运行Llama3等大型语言模型(LLM)的过程主要包括以下几个步骤:

-

下载和安装OLLAMA:

对于windows用户,可以直接从OLLAMA官网下载安装包并运行。 -

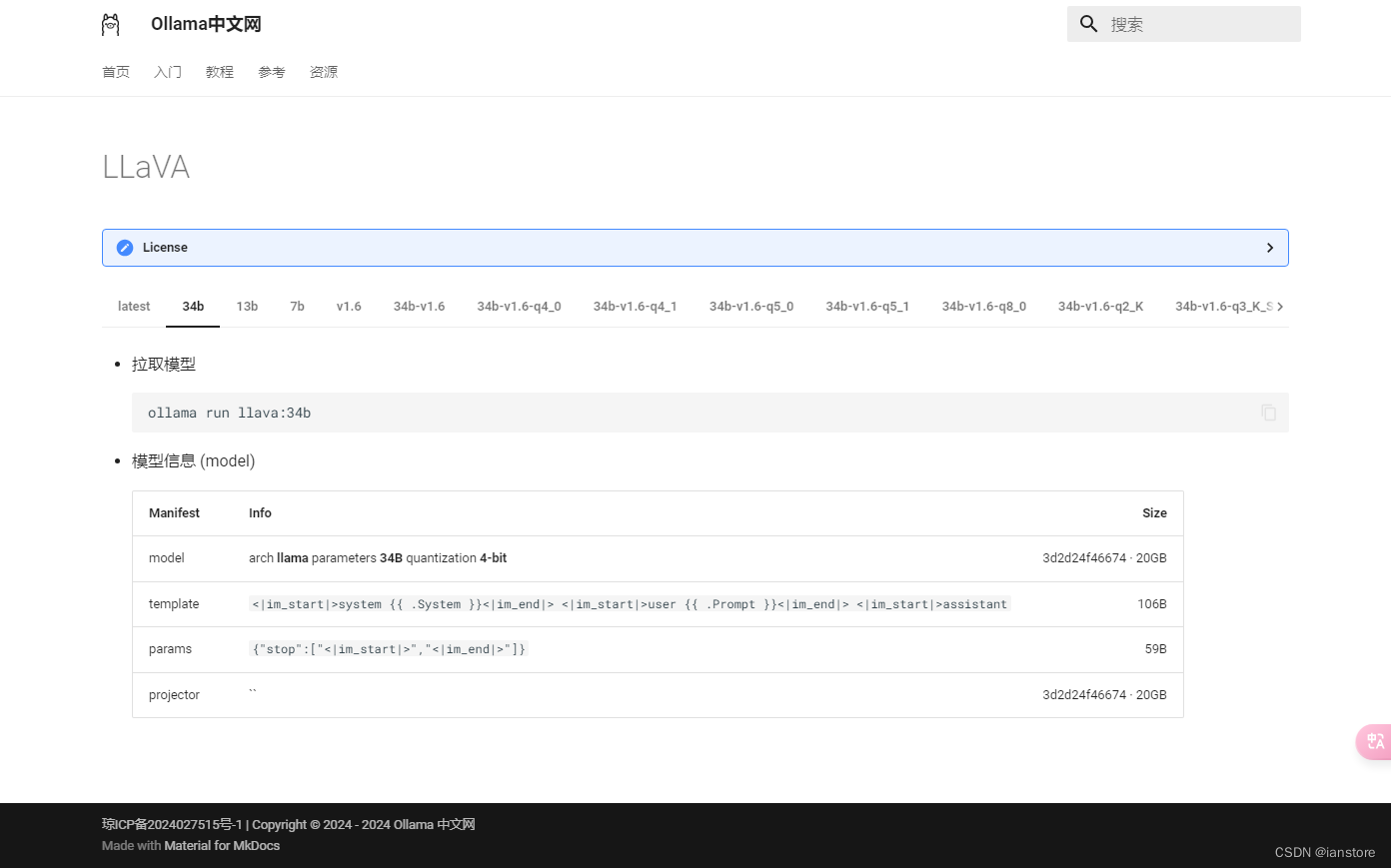

下载Llama3模型:

在OLLAMA中,您可以从提供的模型库中下载所需的模型,例如Llama 3、Llama 3 70B等。 这些模型的大小和参数量各不相同,因此需要的存储空间和计算资源也不同

如

更改模型保存路径:

默认的模型保存路径位于C盘空间有限的目录中。如果模型文件较大,可能会导致存储空间不足。更改路径到有更多可用空间的分区或目录可以帮助管理存储空间。

ollama 默认的模型保存路径如下::

Windows:C:\Users\%username%\.ollama\models

通过设置环境变量,添加 OLLAMA_MODELS 环境变量,例如 E:\ollama\models,设置完成后重启 ollama 或 PowerShell,即可完成模型位置的迁移,再次加载或拉取模型文件时生效

使用网页api:

运行

ollama serve

如果显示:Error: listen tcp 127.0.0.1:11434: bind: Only one usage of each socket address (protocol/network address/port) is normally permitted.

运行:

netstat -ano | findstr :11434

找到占用端口的进程;

然后运行 taskkill /PID <PID>,将"<PID>"替换成进程

显示:

PS D:\360MoveData\Users\2024-4-18\Desktop> taskkill /PID 16676 /F

成功: 已终止 PID 为 16676 的进程。

可以使用python库调用:

https://github.com/ollama/ollama-python

完成!

1047

1047

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?