Anthropic公司近日宣布推出两款全新AI模型:升级版Claude 3.5 Sonnet和全新Claude 3.5 Haiku。这次更新不仅带来了性能的全面提升,更引入了突破性的计算机使用功能。

介绍升级版的 Claude 3.5 Sonnet,以及新型号 Claude 3.5 Haiku。我们还推出了一项新的测试功能:计算机使用。 开发人员现在可以指示 Claude 像人类一样使用计算机——通过查看屏幕、移动光标、点击和输入文本。

上图UIUIHAO总结就是:

Sonnet 3.5 在 ChatLLM 上线,编码能力超越 O1-mini 和 O1-Preview。它在 Livebench AI 上得分最高,达 67.13 分。

O1-preview 仍是最佳整体模型,O1-mini 在某些复杂编码任务上表现更佳。

Claude 3.5 Sonnet:革命性突破

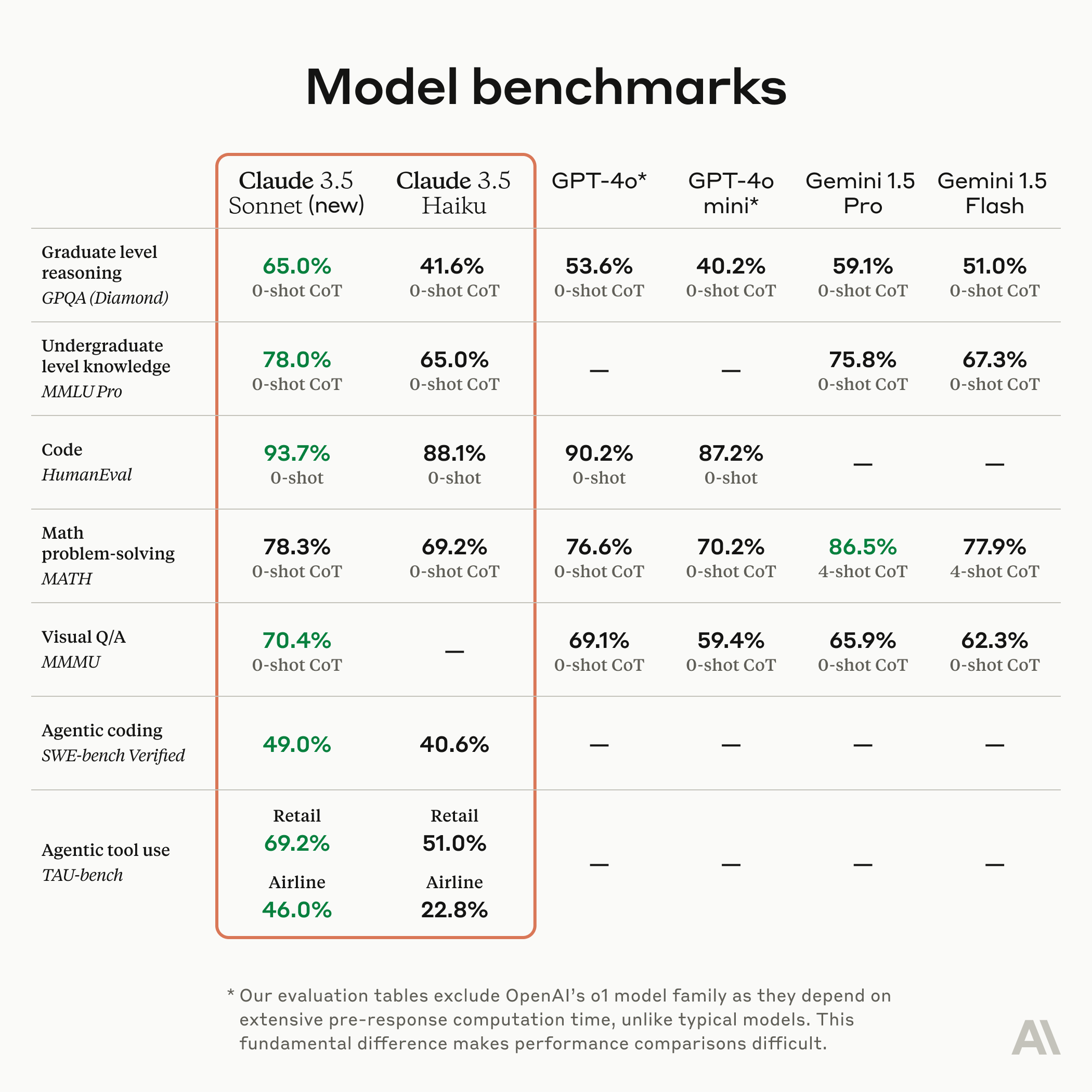

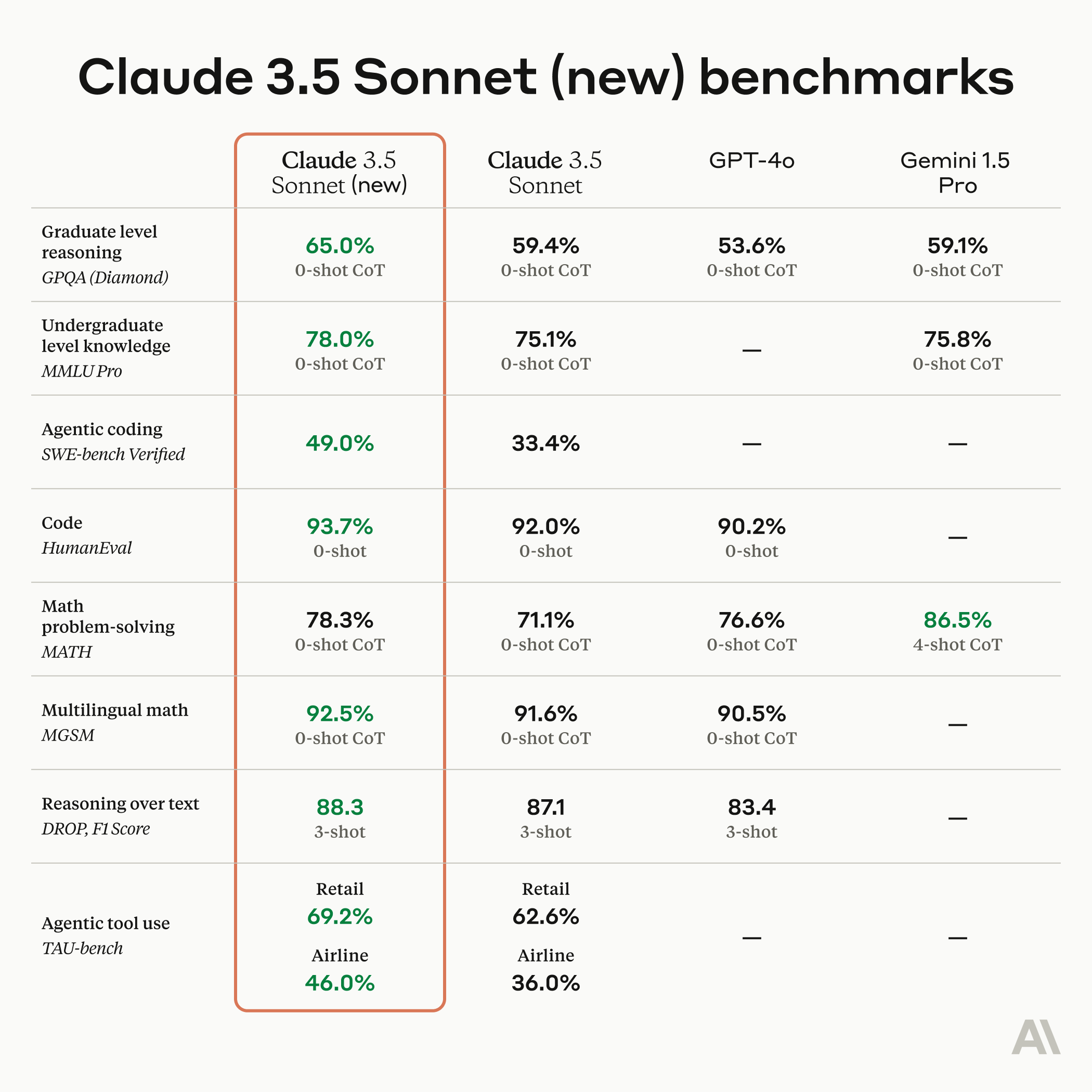

升级后的Claude 3.5 Sonnet在各方面都超越了前代版本,尤其是在编码领域取得了显著进展。在SWE-bench Verified测试中,其得分从33.4%跃升至49.0%,超越所有公开模型。在TAU-bench代理工具使用任务中也表现出色,零售和航空领域得分均大幅提升。

最引人注目的是Claude 3.5 Sonnet引入的计算机使用功能。通过Sonnet API,AI现在可以像人类一样操作计算机:查看屏幕、移动光标、点击按钮和输入文本。这一功能的工作原理包括四个主要步骤:

1. 明确工具和任务

2. Claude选择使用工具

3. 提取工具信息,运行工具并返回结果

4. 继续使用工具直到完成任务

在OSWorld基准测试中,Claude 3.5 Sonnet的表现远超其他AI系统,展示了其强大的计算机操作能力。

超越计算机使用,新版 Claude 3.5 Sonnet 在编码方面带来了显著的提升——这是它已经领先的领域。 Sonnet 在 SWE-bench Verified 上的得分高于所有可用模型,包括像 OpenAI o1-preview 这样的推理模型和专门的代理系统。

Claude 3.5 Sonnet的定价如下:

- 正常使用:输入$3/100万token,输出$15/100万token

- 命中缓存:输入$3.75/100万token,输出$0.30/100万token

Claude 3.5 Sonnet已正式上线于网页和App,并支持通过Anthropic API、Amazon Bedrock和Google Cloud进行调用。

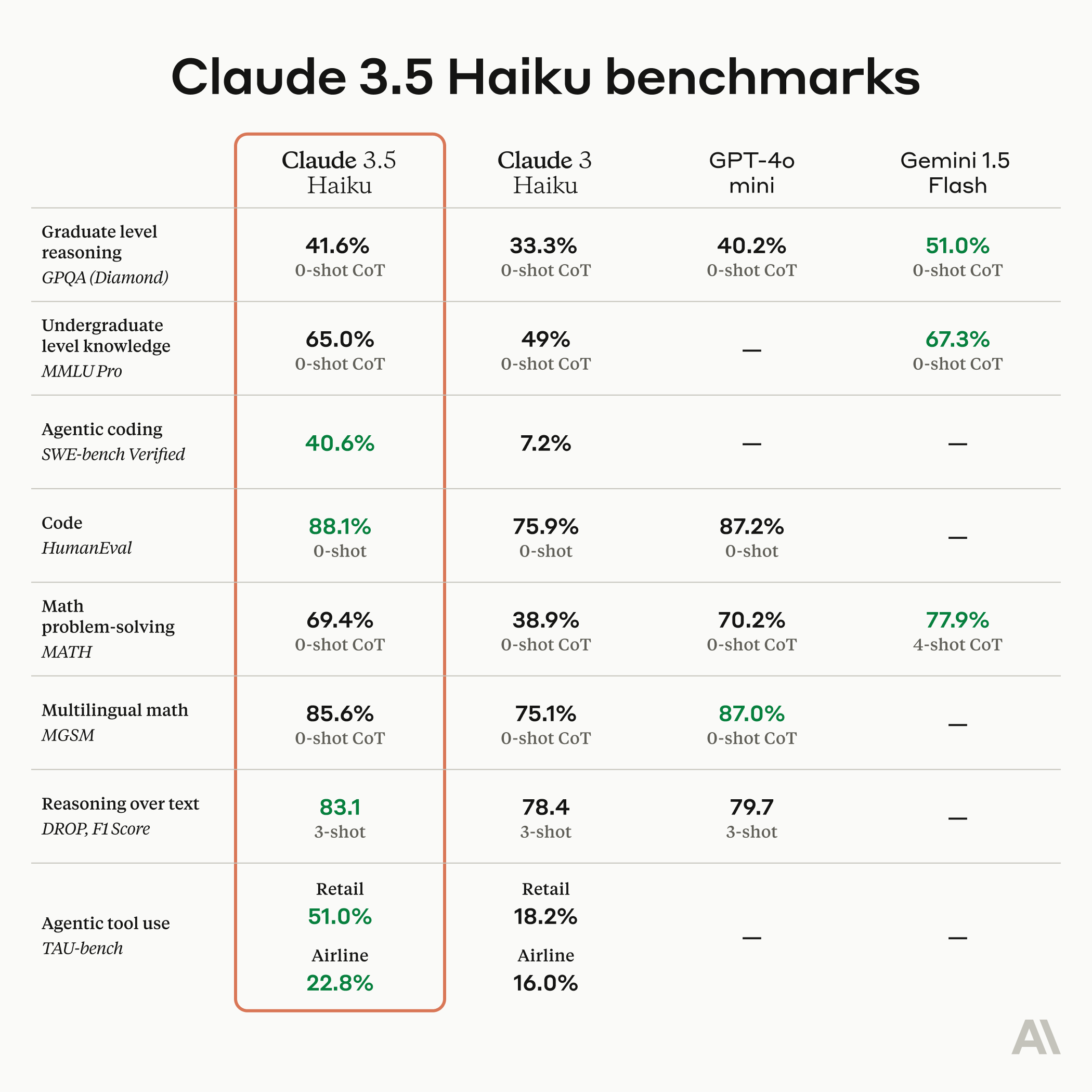

Haiku 现在在编码任务上超越了许多最先进的模型——包括原始的 Claude 3.5 Sonnet 和 GPT-4o——而成本与之前相同。 新的 Claude 3.5 Haiku 将于本月晚些时候发布。

Claude 3.5 Haiku:性能与效率的完美平衡

Claude 3.5 Haiku是Anthropic最快模型的下一代版本。在保持与前代相同成本和速度的同时,其性能达到了前代最强模型Claude 3 Opus的水平,甚至在多项测试中超越了GPT-4o-mini。

Claude 3.5 Haiku的定价如下:

- 正常使用:输入$0.25/100万token,输出$1.25/100万token

- 命中缓存:输入$0.3/100万token,输出$0.03/100万token

Claude 3.5 Haiku将于本月晚些时候推出,初期将以纯文本模型形式提供,后续将支持图像输入。

下面这是一段Claude 3.5 Sonnet API示例调用:

Python 流式

from openai import OpenAI

# 设置API密钥

api_key = "sk-HTdmSI6B2cNt***********************************

# 设置 BASE_URL接口地址

api_base = "https://sg.uiuiapi.com/v1"

client = OpenAI(api_key=api_key, base_url=api_base)

completion = client.chat.completions.create(

model="claude-3.5-sonne",

stream: True,

messages=[

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Hello!"}

]

)

for chunk in completion:

print(chunk.choices[0].delta)Python 非流

from openai import OpenAI

api_key = "sk-HTdmSI6B2cNt************************************"

# 设置 BASE_URL接口地址/开发者快速获取Claude3.5 APIKey参考 uiuiapi.com

api_base = "https://sg.uiuiapi.com/v1"

client = OpenAI(api_key=api_key, base_url=api_base)

completion = client.chat.completions.create(

model="claude-3.5-sonne",

stream: False,

messages=[

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Hello!"}

]

)

print(completion.choices[0].message)Anthropic强调,虽然计算机使用功能仍处于实验阶段,但公司正积极采取措施确保其安全部署。他们鼓励开发者从低风险任务开始探索,并开发了新的分类器来识别潜在的危害行为。

多家知名公司如Asana、Canva、Cognition、DoorDash、Replit和The Browser Company已开始探索这些新功能的潜力,将其应用于复杂的多步骤任务中。

总的来说,这次更新标志着AI技术的重大进步,尤其是在编码和计算机操作方面。随着这些新功能的不断完善,我们可以期待AI在更多领域发挥越来越重要的作用,为人类工作和生活带来革命性的变革。

2978

2978

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?