点击蓝字

关注我们

随着AI的发展,推动算力需求激增,同时高密度的发展也直接或间接推动冷却系统的革命进程。液冷的推动是基于节能考虑还是服务器散热需求所致,本篇从液冷系统的基本原理介绍到目前行业巨头液冷架构的实践间接,进行了详细分析,并对未来浸没式液冷和两相冷板技术进行了简要概述,相信读完会有更深的认识。

现在让我们来讨论一下英伟达的路线图,以及数据中心设计的近期和长期未来,以及影响的设备供应商。我们相信,采用液体冷却背后的真正驱动因素仍然被误解了,对于推理和训练数据中心的冷却系统的未来也被误解了。我们经常听说,采用液体冷却技术是由优越的能源效率驱动的,或者因为用空气冷却>1000W芯片是不可能的。我们也经常听说,推理将需要低功耗的服务器和空气冷却。

01

AIDC液体冷却的兴起以及GenAI系统路线图

大规模采用液体冷却背后的真正驱动因素是GenAI计算的总拥有成本(TCO)。虽然有些人认为液体冷却是昂贵的,但与一个系统的生命周期(~15年)的总成本相比,IT设备在类似的时间框架内的总寿命成本要低得多。充分利用IT设备是真正重要的——这就是液体冷却的全部意义,使GPU和人工智能加速器在物理上更接近彼此,允许更多的加速器作为一个计算团队一起工作。

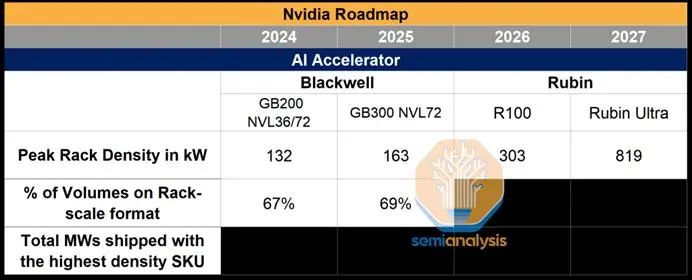

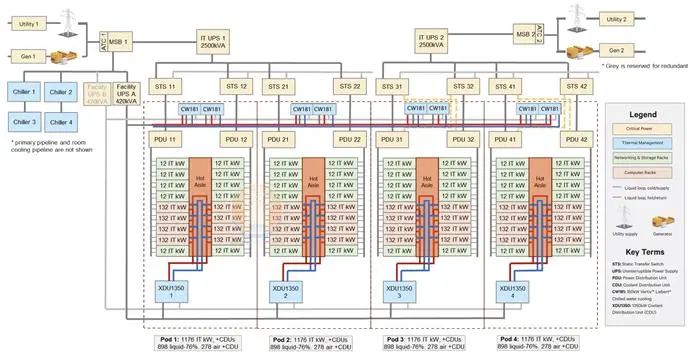

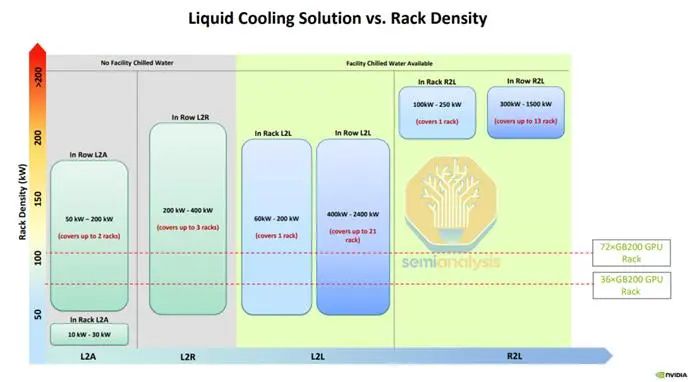

英伟达的GB200 NVL72为LLM推断提供了最佳的TCO,与Hopper系统相比,其性能提高了高达10倍。这在很大程度上是由于可扩展的网络NVlink从8个GPU扩展到72个GPU——只有通过增加机架密度和每个机架内的数千个铜链路才能实现。英伟达的路线图是明确的,并逐步将通过NVlink连接的500+图形处理器的机架密度推向1MW。像trainiumandtpu这样的定制AI加速器共享类似的路线图——增加密度,通过更快的扩展和扩展网络实现更高的性能。下面来自维谛的幻灯片提供了英伟达路线图的简化概述。

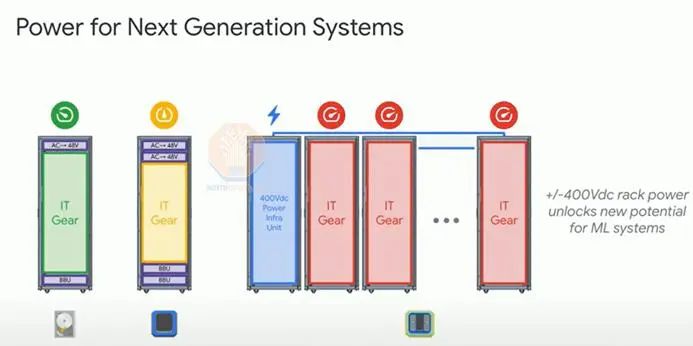

而关键的客户也有同样的抱负。在2024年OCP全球峰会上,谷歌讨论了开发多达1兆瓦IT机架的计划。为了实现这一点,动力机架将离开机架,并将引入侧板“动力机架”。配电电压将从48V DC上升到+-400V DC。英伟达与Rubin有类似的计划,但保留48V。

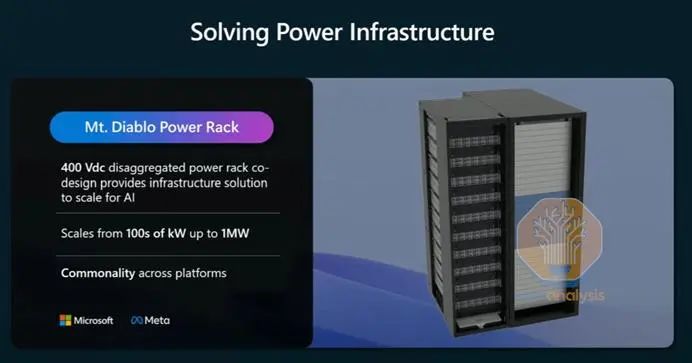

Meta和微软最近建立了一个伙伴关系,开发一个类似的解决方案——Mt。暗黑破坏神的项目。关键概念是“分解电源”,电源架从机架上移到一个专用的侧板。

微软和Meta也对他们的1MW野心非常开放,如下所示。和谷歌一样,一个关键的原因是不断上升的配电电压——48V DC配电母线将被+-400V DC取代。除了提高效率,这是增加密度的关键:一个48V DC铜气泡驱动500 kW机架需要56毫米直径和重量47公斤/ 103磅,而+-400V DC(即有效电压800V)只有14毫米直径和重量3公斤/ 6.5磅!

现在让我们退一步,讨论一下液体冷却到底是什么,以及它与空气冷却的比较。这份报告将主要集中在冷板式液冷(DLC)——我们将在最后简要介绍浸没,但未来的文章将更深入地研究这个主题。

首先,当我们谈到液体冷却时,我们特别指的是芯片或服务器的液体冷却,而不是空气处理器和风扇的液体冷却。如前所述,许多数据中心已经使用设施中的水回路(液体)来去除数据大厅里的热量,但很少有人使用液体来去除芯片或服务器上的热量。几十年来,液体冷却已经为不同行业的小众用例实现了,包括60年代用于冷却IBM大型机的数据中心!然而,在现代数据中心,空气冷却主要是首选,因为:

● 它通常更便宜,更简单,空气冷却的供应链已经建立。

● 随着设备规模的扩大,风冷技术也得到了改进,并在保持能源效率的同时,每个机架的功率密度也不断上升。

因此,虽然许多参与者同意液体冷却通过降低能源消耗(通常通过减少或移除服务器风扇功率)可以实现运营成本节省(约10%),但与液体冷却更高的资本支出、增加的复杂性和运营风险以及不太了解的供应链相比,这不足以成为转向液体冷却的强烈动机。众所周知,液体冷却可以实现更高密度,从而节省空间——但物理空间对数据中心来说是一个小成本项目,因为大多数成本是由关键IT功率衡量的。

液体之所以更有效率,并且可以允许更高的密度,是因为它每单位体积吸收的能量比空气多4000倍。在能源效率方面,这被泵和复杂的管道需求部分抵消:水的密度比空气大830倍,这使得移动更加困难。

注意,液体流量和泵送能量有线性关系。然而,通过DLC增加机架密度有它自己的一系列挑战——特别是在管道和管道工程。超高的密度可能需要非常大的管道和昂贵的材料。

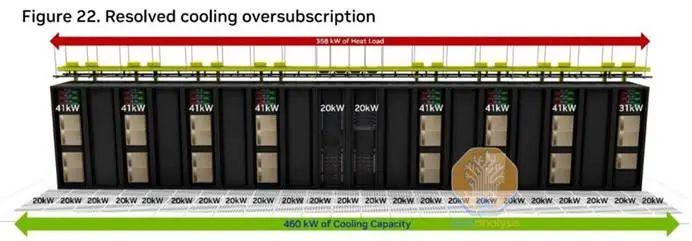

如今,风冷仍然是人工智能领域的主导技术。英伟达针对H100数据中心部署的参考设计为每个机架最多提供4台风冷服务器,总计41 kW。参考设计解释说,在大多数风冷数据中心,冷却过载经常限制操作员每行安装8个GPU服务器机架(以及另外两个用于存储和网络设备),这意味着在这个设计中有8个机架是空的!然而,也有可能进一步增加密度——一些技术,如冷门背板(RDHx)或柜内空气密封技术,如DDC柜技术,使每个机架的密度超过50kW。

密度的主要限制原因之一是在服务器级别。高TDP芯片需要一个更大的散热器——这就是为什么拥有8个图形处理器的英伟达 HGX服务器往往非常大(8RU),而这种TDP和散热需求将在未来一代中增加,如风冷的Blackwell SKUs.

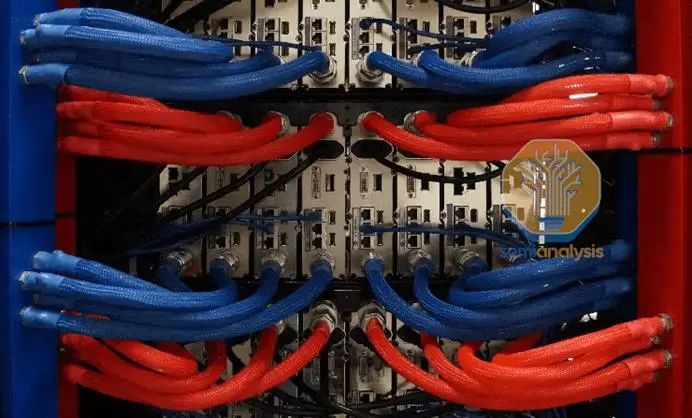

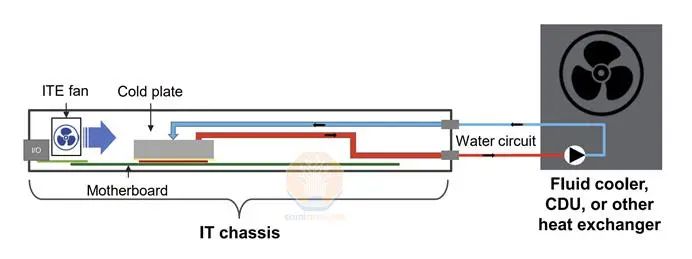

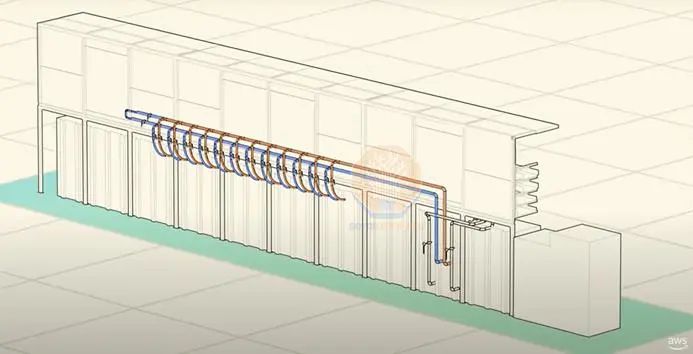

相比之下,在服务器中引入液体可以在类似的功率消耗下实现更紧凑的设计。英伟达为 Blackwell的大多数sku选择了直接到芯片的单相技术:这种设计包括使用直接放置在最热门的芯片(GPU和CPU)上的铜板。风扇仍然需要风扇移除非液体冷却过的部件中剩余的热量,如网卡、存储器和收发器——最高可达机架总散热量的15%。

这些金属板被提供了冷水,送出温水。这个水环管通过机架内的一个分集水器流动。

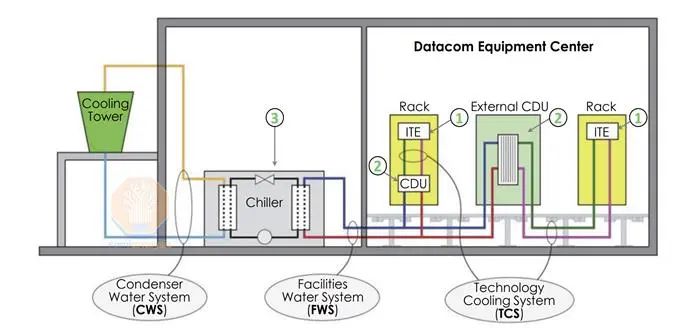

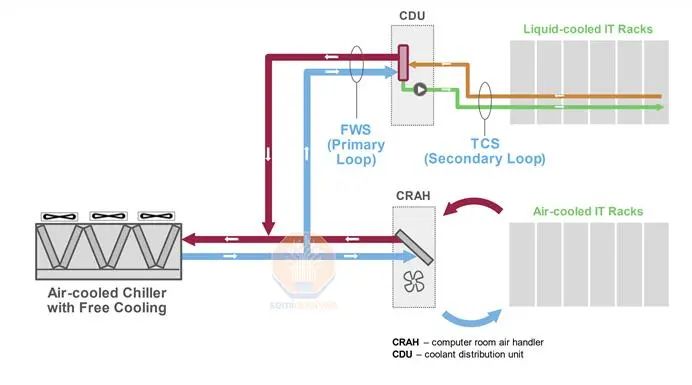

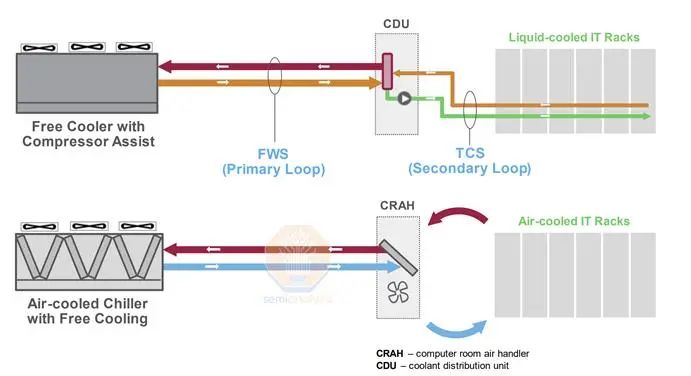

该回路通常由一个冷却液分配单元(CDU)来处理,如下图所示。

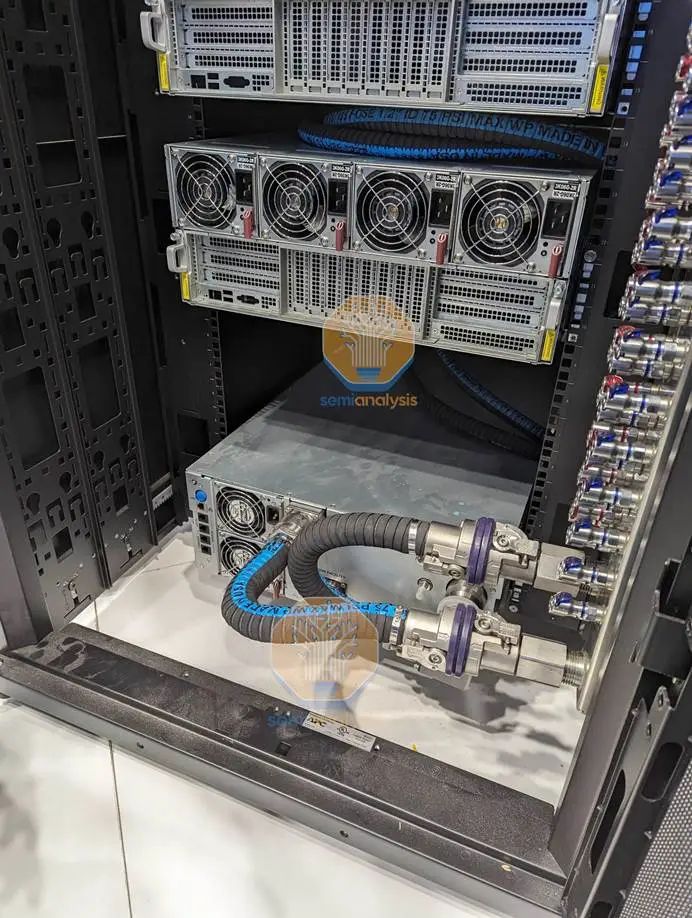

CDU可以是大的和集中的排在列内的单元(1MW+容量),也可以是更小的机架内的单元(~100kW为4U)。对于大型部署,行内部署通常是首选,因为它更便宜,而且维护更容易(组件更少)。然而,考虑到上市时间的基本价值,以及供应链相对较新,如果出现问题,终端客户希望“指向”一家供应商,而不是进行长时间的指责会议,试图确定故障所在。因此,像超微这样的OEM的集成机架解决方案供应商在大规模部署中获得了一定的吸引力。在这两种情况下,CDU都位于IT机房内。

下图显示了真实生活中的CDU:一个是Rittal的行CDU(1MW冷却能力),另一个是机柜底部机架内的CDU,冷却能力为80 kW。

02

数据中心冷却系统的未来

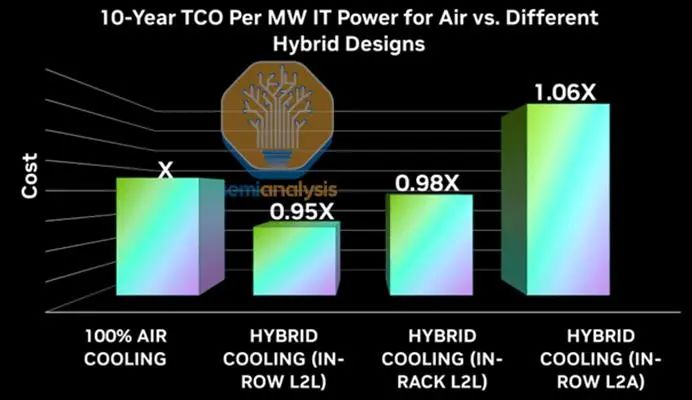

在设施层面上,未来两年将会出现三种主要类型的部署。第一种是使用液对空气(L2A)热交换器。由于L2A系统的高成本和固有的低效率,这是效率最低也是最昂贵的选择。由于GB200 NVL36/72需求与适合DLC的数据中心容量不匹配,这可以被认为是一个“桥梁”。

许多为空冷而优化的数据中心(如我们之前介绍的微软和AWS设计)仍在建设中,但其任务是部署GB200——这里唯一的解决方案是使用L2A。L2A热交换器不需要设施水平的管道。在L2A侧和IT机架的DLC系统之间运行一个封闭的液体冷却回路,将热回液泵入L2A侧,从而冷却液体并将其送回IT机架。然后,L2A单元使用散热器和强大的风扇将热量从液体转移到热空气到热通道。标准的设施级系统,如免费空气冷却,然后可以从数据大厅去除热量。

根据英伟达的说法,这种L2A系统的TCO明显更高,甚至比标准的风冷系统更高。我们不知道这个计算背后的基本假设是什么,但我们暂且赞同这个结果。

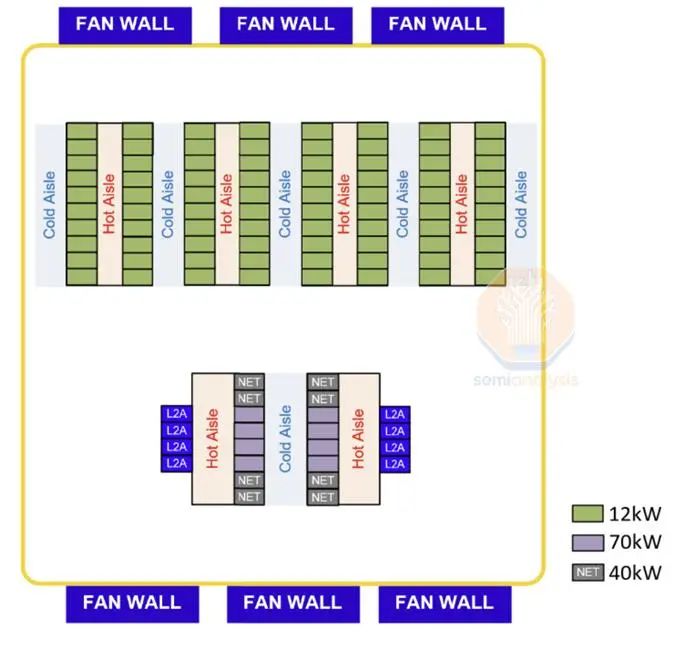

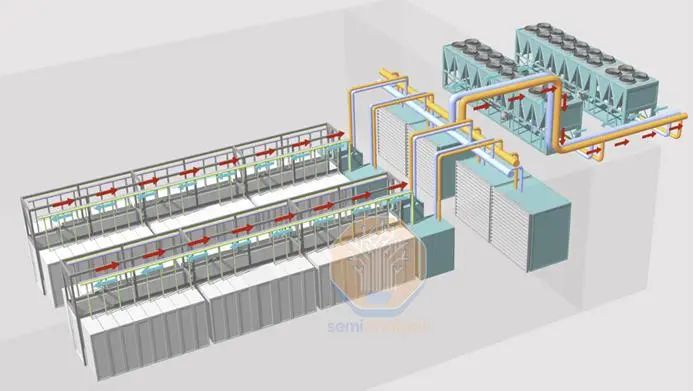

正在采用的第二种选择是一个“混合”冷却系统,其中一个集中冷水系统厂可以从空气和液体中去除热量。CDU (L2L,无论是机架内还是行内)和CRAH/风扇墙与普通冷冻水管道系统交换热量-如维谛的以下设计所示。正如我们在GB200硬件架构报告中解释的,只有GPU和NVLink开关是DLC冷却的,而 NICs, CPUs和许多其他各种IT设备仍然是风冷的。英伟达的GB200设计要求运营商通过DLC提供85%的冷却,剩下的15%仍然通过空冷。

下面来自维谛的示例展示了这样的布局的样子。

我们预计大多数数据中心将在2025年和2026年采用这种混合部署。许多人仍然不确定确切的液体和空气冷却混合,而混合动力系统提供了灵活性来处理这个比率的轻微变化。许多数据中心运营商目前正在宣传他们部署和改造DLC的能力。这是因为,如前所述,大多数主机托管数据中心已经有了一个集中冷水系统。

理论上,改造工作很简单--在数据机房内新建管道系统,并让CDU从现有的集中水系统中“断开”。在实践中,我们认为许多运营商由于缺乏标准化而陷入困境,尽管可以完成改造工作,但成本相对较高。数据中心有不同的集中水管道系统(流量、压力、直径等)和流体混合(用于设施冷却的水,而水和乙二醇的混合物用于DLC内部回路,但会有所不同)。 市场上可获得的CDU可能不符合所需的规格,而且大多数CDU由于缺乏标准而彼此不同。因此,大多数运营商必须使用新的设计来构建数据中心,以容纳L2L液体冷却。另一个问题是,使用一个共享设施水循环意味着数据大厅冷却设备(CDU和空气处理机)被迫使用相同的设施水,其温度可能对于两者都不是最优的。

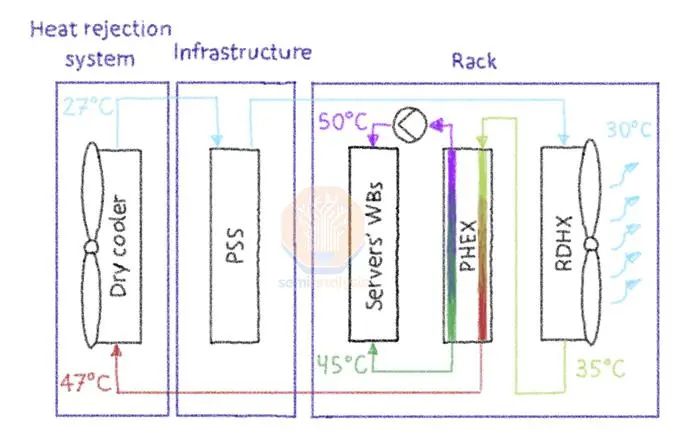

混合动力系统的第二个问题是能源效率。下图来自OVHCloud,这是一家法国云服务提供商,它使用DLC进行CPU冷却已经超过20年了!虽然密度远低于英伟达的>130KW,但我们仍然可以看到这个问题。

混合冷却的问题是需要适应具有不同传热性能的系统。液对液热交换器(如板式热交换器)具有最好的性能,而空气对液(A2L)热交换器的效率明显较低。在这种情况下,OVH同时使用DLC和RDHx(即机架内的A2L)与相同的设施水系统。由于传热性能较差,我们必须在明显较低的入口温度下操作RDHx(或中央风扇墙或CRAH)。在这种情况下,相比于DLC系统的温度为45℃,这个需要采用30℃。由于这两个系统共享一个共同的中央水系统,OVH被迫将设施中的水冷却到27℃。它们的1.26度仍然令人羡慕,但这得益于它们的地理位置在法国特别偏北部地区。

专用冷却系统

在这种配置下,DLC专用系统可以在明显更高的温度下运行。施耐德的参考设计指向一个37℃的入口温度和47℃的出口温度。在这些条件下,DLC冷却回路很可能可以使用没有绝热辅助的干式冷却器全年运行——能量和水被最小化。低PUE的影响可能是显著的——在人工智能时代,持续的电力短缺,每一个兆瓦都很数。通过电网保护200兆瓦的数据中心运营商将在1.15峰值为IT设备提供174MW,而在1.3峰值为154MW。

专用的冷却系统通常通过放大余量满足一定程度的灵活性。例如,一个100MW的数据中心可以有85MW的DLC冷却能力和25MW的空气冷却能力。然而,运营商建造这样一个设施的风险是,GenAI和液体冷却系统的采用会逐渐消失。

专用的冷却系统通常通过过大尺寸涉及一定程度的灵活性。例如,一个100MW的数据中心可以有85MW的DLC冷却能力和25MW的空气冷却能力。然而,运营商建造这样一个设施的风险是,GenAI和液体冷却系统的采用会逐渐消失。

03

行业巨头的设计和路线图-CDU的终结?

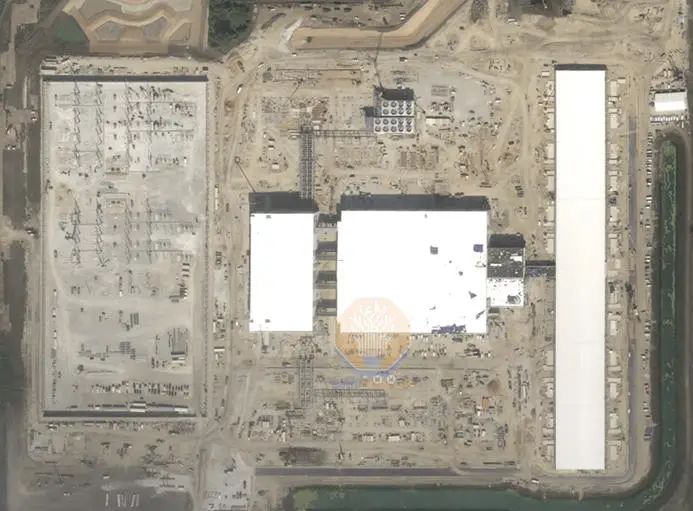

我们之前解释过,微软、Meta和AWS数据中心通常经过风冷优化。因此,L2A是快速部署GB200 NVL36/72的主要选择。但展望2025年的部署,行业巨头已经做出了反应,推出了新的设计。最引人注目的转变是Meta,正在建造的“H”被废弃,转而建造一个新的人工智能设计——建造速度更快,密度更大,并且有专用的水系统。

新的设计采用了风冷冷却器和一个同时处理空气和水的“混合”系统。它将保持同行业最好的水利用效率,但我们预计PUE会上升——我们不确定到底有多少,可能从目前的1.08水平上升至超过1.10。

微软最初采用了一种不同的策略。该公司继续开发其“巴拉德”数据中心,但仅选定地点的在很少部分引入了一种新的超密集设计。

新设计采用了水冷冷却器和干冷却器(绝热辅助)——后者的“V型”设计类似于开式冷却塔,与典型的干冷却器相比,提高了空间利用效率。

最近,这家科技巨头推出了巴拉德设计的变体,在亚利桑那州凤凰城推出。这是一个“混合”系统,CDU和风墙共享一个集中的设施水系统,并依赖于传统的风冷冷水机。

AWS也宣布向DLC转变,但我们还没有看到该公司的任何新的数据中心设计提供足够的设施水平流体冷却器,如干冷却器或冷却塔。该公司的下一代设施仍然为空气冷却进行了优化。因此,我们相信,该公司在2025年进行的大部分GB200部署都将使用L2A系统。

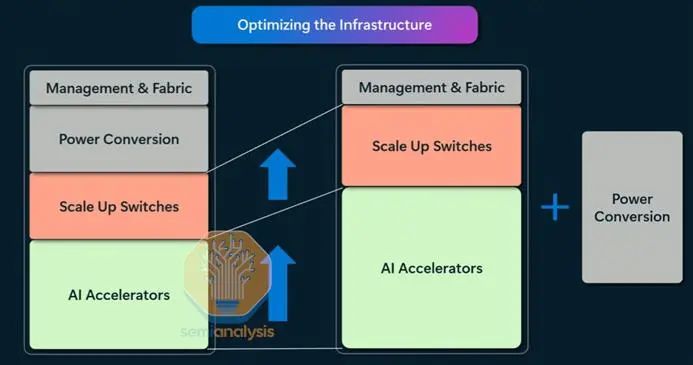

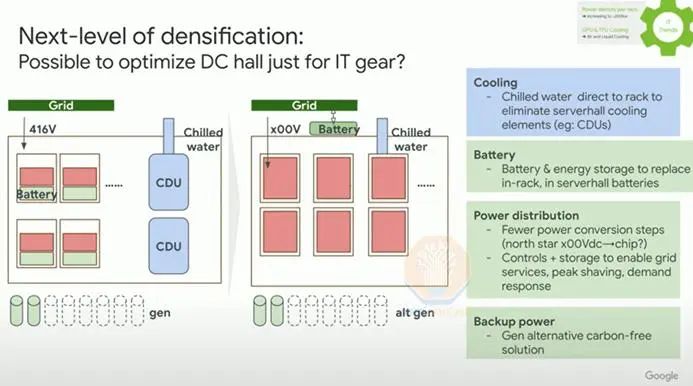

最后,让我们讨论谷歌。该公司已经部署液冷芯片已经十多年了。其目前的数据中心设计是一个同时容纳空气和液体的混合系统,但该公司在OCP 2024上披露了一个有趣的路线图。随着机架密度向1兆瓦移动,机架内CDU将不是一个选择,甚至行内CDU也将不够。这种设备通常的容量为1MW,最高容量为2MW——每个机架将需要一个专用的侧板CDU。

谷歌正在评估完全清除CDU,并将设施中的冷冻水直接送入机架。我们之前讨论了该行业缺乏标准化的问题,我们认为“冷冻水直接到机架”的解决方案不太可能出现在更广泛的生态系统中。然而,像谷歌这样的上下游整合公司控制着从芯片(TPU)到数据中心的整个系统,可以从头开始设计一个系统来满足这些要求。

04

设备供应商形势

在本报告的最后一部分中,我们将讨论供应商的情况。我们已经建立了一个供应商跟踪器,覆盖了150个+设备和服务供应商,与数据中心的收入暴露和产品细分。

数据中心冷却空间有两个不同的类别:传统的设施级设备和液体冷却专用系统。

在第一类中,市场动态类似于电气系统,但通常在一个更加分散和竞争激烈的环境中。在这一类有许多非常大的公司,包括数据中心设备巨头,如维谛技术和施耐德电气,还有全球领先的暖通公司,如开利、江森自控和特灵,以及一些大型数据中心和纯空调设备,如世图兹。与电气设备供应商相比,这种市场结构导致毛利率较低,但营业利润率仍然很健康,每个人都将从市场动态中受益。数据中心的资本支出的繁荣仍然被低估了。

在这个市场中,一些公司专注于特定类别,有赢家也有输家。例如,过度暴露于空气侧节能系统的公司可能会相对损失,因为超大规模的自建设计从自由空气冷却转向设施水循环。

另一个可能相对损失的产品类别是开式冷却塔,因为数据中心规模的激增将限制有足够可用水的场地。如果谷歌转向干式系统,一家美国上市供应商将受到严重的影响。

另一个关键领域是液体冷却设备-引发了大量的关注和讨论,特别是许多来自台湾的新进入者试图挑战像Vertiv这样的老牌公司,而一些巨头在技术和设备组合方面因依赖并购而措手不及(施耐德电气/Motivair)。虽然L2A解决方案应被视为“桥梁”,但它们仍可能在2025年大规模采用,这将推动最大供应商的收入大幅增长-原因是每MW的价格非常高。 对于L2L系统,我们认为有几家公司正面临可靠性问题,但一家在美国上市的公司表现特别出色,并有望获得显著的市场份额。

05

DLC是一个可以被浸没式所取代的临时解决方案吗?

最后,我们想简要介绍一下未来的冷却技术。虽然今天的单相DLC将会出现大规模增长,但目前正在进行研发工作,以开发两相解决方案和浸没式冷却。我们经常听到浸没式冷却是最终的解决方案,或者两相比单相DLC更有效。

我们将在今后的报告中详细探讨这些技术。作为一个简短的预告片,我们只能说,我们相信市场正在误解这些系统背后的物理原理。浸入式通常被描述为进一步增加机架密度的下一个解决方案,但我们不同意。强迫水对流即DLC比自由对流具有更好的传热性能。虽然目前仍在努力改善浸没式散热器,但其峰值密度仍然低于DLC。

两相的DLC也被探索,虽然有警告和短期问题,但该技术更有前途。英伟达数据中心冷却和基础设施主管的演示显示,两相已成为扩展其系统机架密度的关键技术。

06

甲骨文和字节跳动在PTC 2025上热议

上周,我们派遣了两位出色的团队成员参加了在夏威夷檀香山举行的 2025 年太平洋电信会议。有一些重量级公司出席了会议,包括 Microsoft、Oracle、DayOne (FKA GDS)、CtrlS、AirTrunk、Ciena、STT 和 ByteDance。这是一场不容错过的活动。

在那里,我们听到了很多关于冷却领域即将到来的发展,以及关于未来 GPU 部署和地理风险的讨论。在柔佛州,我们确认,只要获得 NVEU 例外,Oracle 应该会在 2025 年上半年部署其液冷集群。总体而言,只有少数运营商进行了液冷部署,而且许多运营商仍然保持谨慎。我们仍然认为,马来西亚的 130kW 机架建设仍然是全球最激进的建设项目之一。许多运营商指出,实施 Direct-to-Chip 液体冷却的成本非常高且难度很大,尤其是当 DtC 的入口温度需要使用冷水机冷却时,增加了成本并恶化了 PUE。此外,许多主机托管提供商向我们证实,他们更愿意与成熟的设备供应商合作(特别点名施耐德电气和维谛),而不是引入新贵冷却组件供应商。

来源:DeepKnowledge

5781

5781

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?