教程是本人学习吴恩达老师DeepLearing系列课程中整理的最为详细的学习笔记。学习视频主要来自B站[双语字幕]吴恩达深度学习deeplearning.ai_哔哩哔哩_bilibili?,以及DeepLearning官方网站Deep Learning by deeplearning.ai | Coursera。该系列课程总共有180多个,我会将学习笔记陆续分享出来,为有兴趣深度学习的同仁提供便利。再次由衷感谢吴恩达老师的精彩讲解和无私奉献!

特别说明:图片来源于吴恩达老师视频截图。

附文本

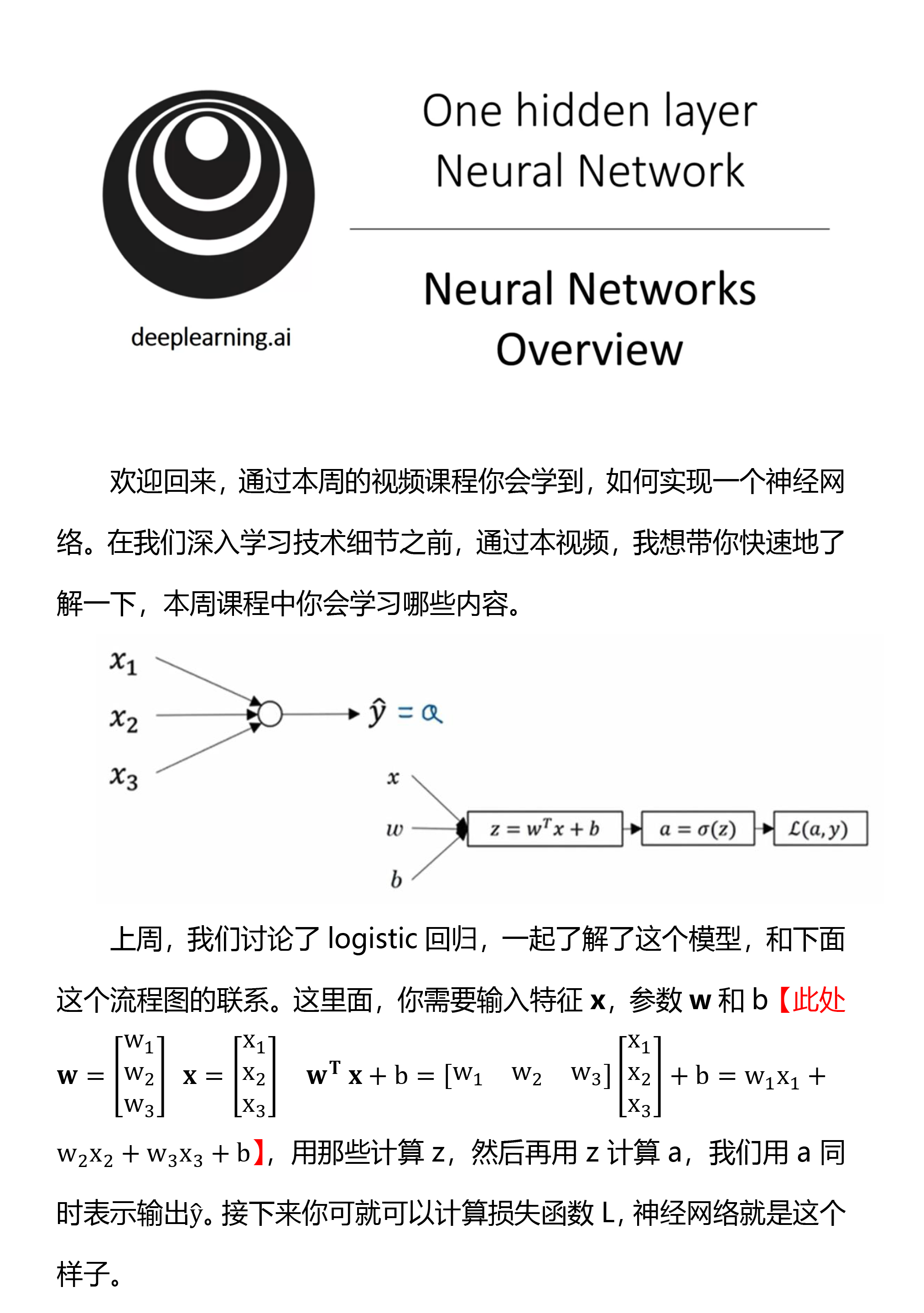

欢迎回来,通过本周的视频课程你会学到,如何实现一个神经网络。在我们深入学习技术细节之前,通过本视频,我想带你快速地了解一下,本周课程中你会学习哪些内容。

上周,我们讨论了logistic回归,一起了解了这个模型,和下面这个流程图的联系。这里面,你需要输入特征x,参数w和b【此处w=[■(w_1@w_2@w_3 )] x=[■(x_1@x_2@x_3 )] w^T x+b=[■(w_1&w_2&w_3 )][■(x_1@x_2@x_3 )]+b=w_1 x_1+w_2 x_2+w_3 x_3+b】,用那些计算z,然后再用z计算a,我们用a同时表示输出y ̂。接下来你可就可以计算损失函数L,神经网络就是这个样子。

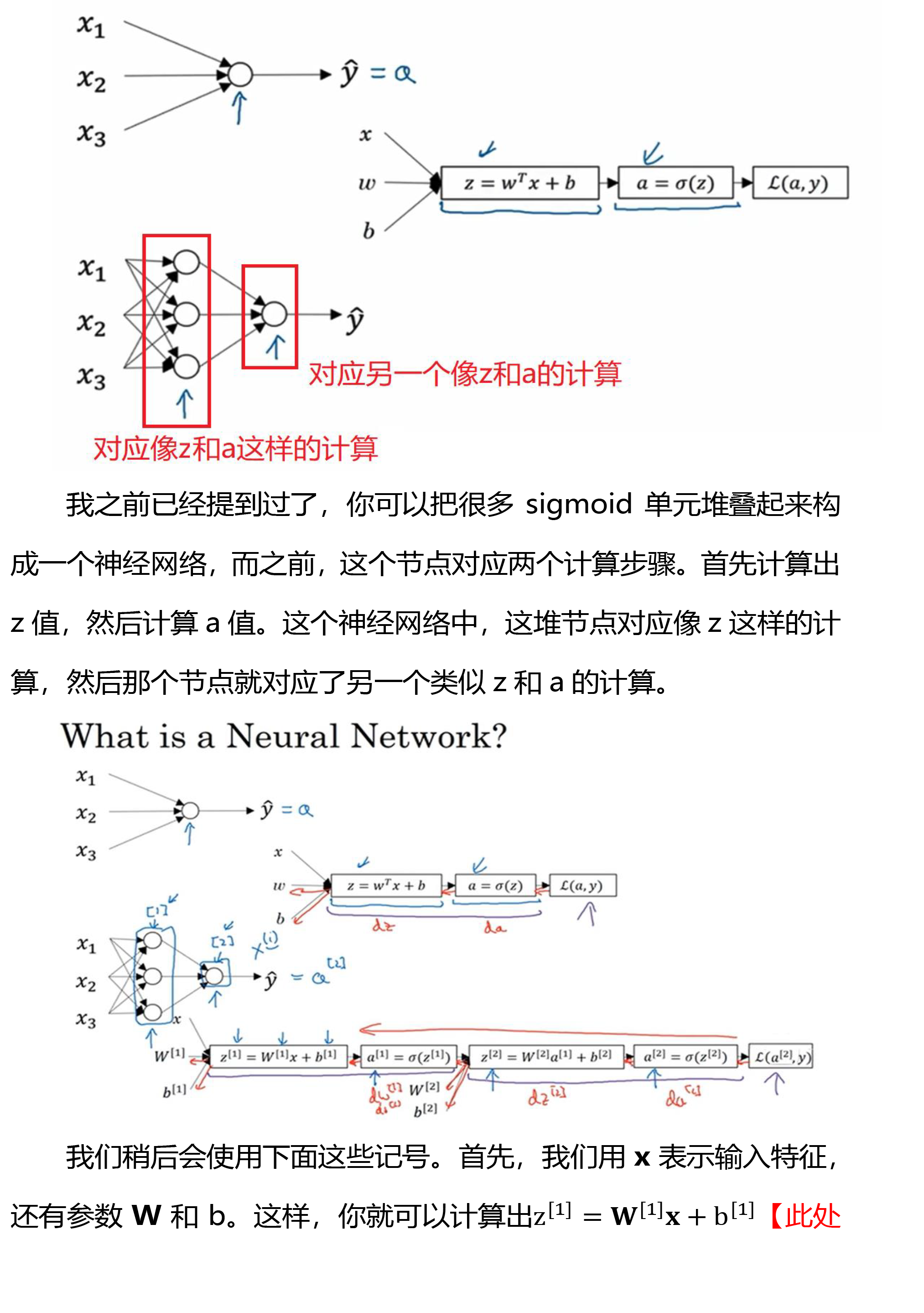

我之前已经提到过了,你可以把很多sigmoid单元堆叠起来构成一个神经网络,而之前,这个节点对应两个计算步骤。首先计算出z值,然后计算a值。这个神经网络中,这堆节点对应像z这样的计算,然后那个节点就对应了另一个类似z和a的计算。

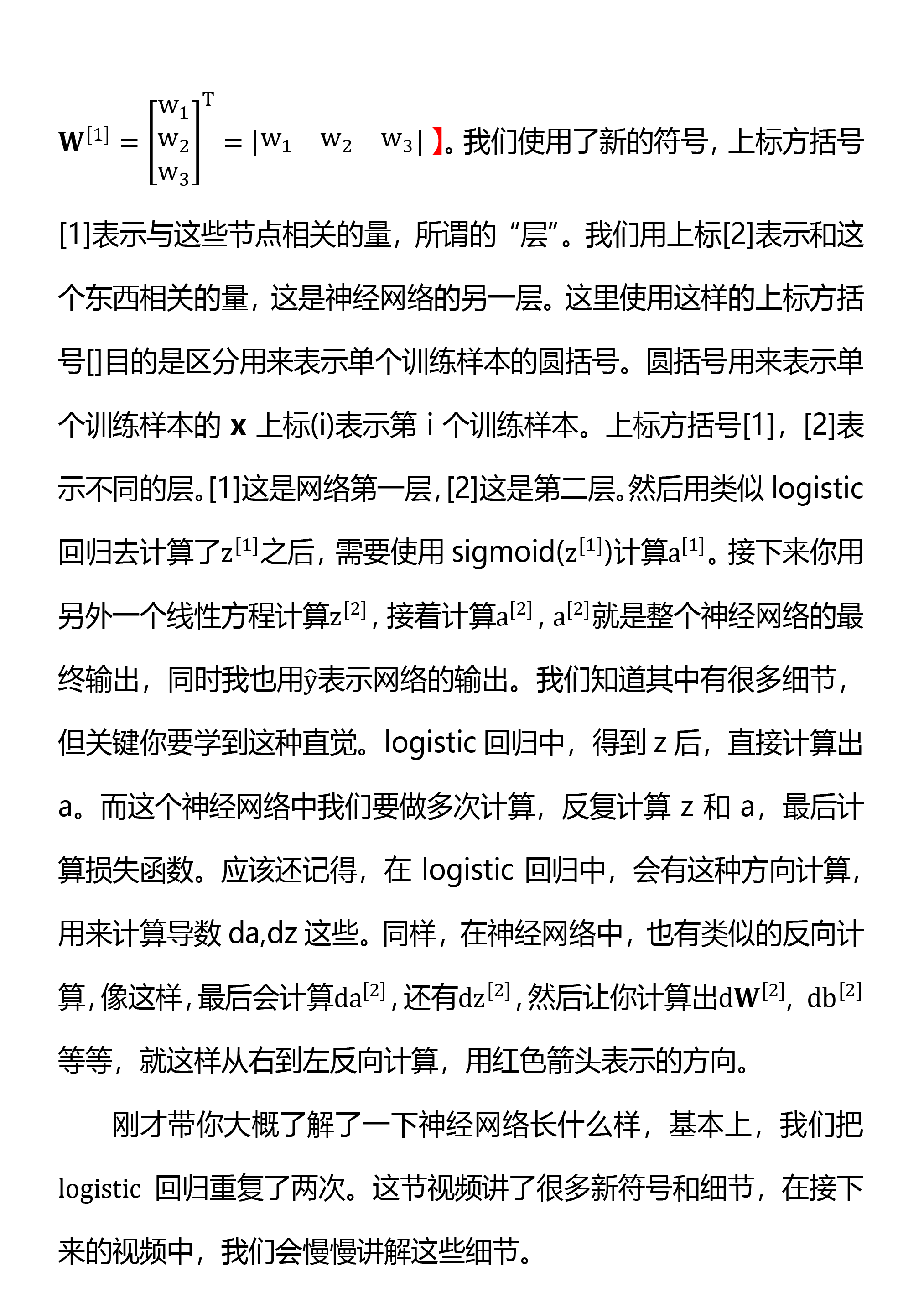

我们稍后会使用下面这些记号。首先,我们用x表示输入特征,还有参数W和b。这样,你就可以计算出z^([1])=W^([1]) x+b^([1])【此处W^([1])=[■(w_1@w_2@w_3 )]^T=[■(w_1&w_2&w_3 )] 】。我们使用了新的符号,上标方括号[1]表示与这些节点相关的量,所谓的“层”。我们用上标[2]表示和这个东西相关的量,这是神经网络的另一层。这里使用这样的上标方括号[]目的是区分用来表示单个训练样本的圆括号。圆括号用来表示单个训练样本的x上标(i)表示第i个训练样本。上标方括号[1],[2]表示不同的层。[1]这是网络第一层,[2]这是第二层。然后用类似logistic回归去计算了z^([1])之后,需要使用sigmoid(z^([1]))计算a^([1])。接下来你用另外一个线性方程计算z^([2]),接着计算a^([2]),a^([2])就是整个神经网络的最终输出,同时我也用y ̂表示网络的输出。我们知道其中有很多细节,但关键你要学到这种直觉。logistic回归中,得到z后,直接计算出a。而这个神经网络中我们要做多次计算,反复计算z和a,最后计算损失函数。应该还记得,在logistic回归中,会有这种方向计算,用来计算导数da,dz这些。同样,在神经网络中,也有类似的反向计算,像这样,最后会计算da^([2]),还有dz^([2]),然后让你计算出〖dW〗^([2]), db^([2])等等,就这样从右到左反向计算,用红色箭头表示的方向。

刚才带你大概了解了一下神经网络长什么样,基本上,我们把logistic回归重复了两次。这节视频讲了很多新符号和细节,在接下来的视频中,我们会慢慢讲解这些细节。

758

758

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?