教程是本人学习吴恩达老师DeepLearing系列课程中整理的最为详细的学习笔记。学习视频主要来自B站[双语字幕]吴恩达深度学习deeplearning.ai_哔哩哔哩_bilibili?,以及DeepLearning官方网站Deep Learning by deeplearning.ai | Coursera。该系列课程总共有180多个,我会将学习笔记陆续分享出来,为有兴趣深度学习的同仁提供便利。再次由衷感谢吴恩达老师的精彩讲解和无私奉献!

特别说明:图片来源于吴恩达老师视频截图。

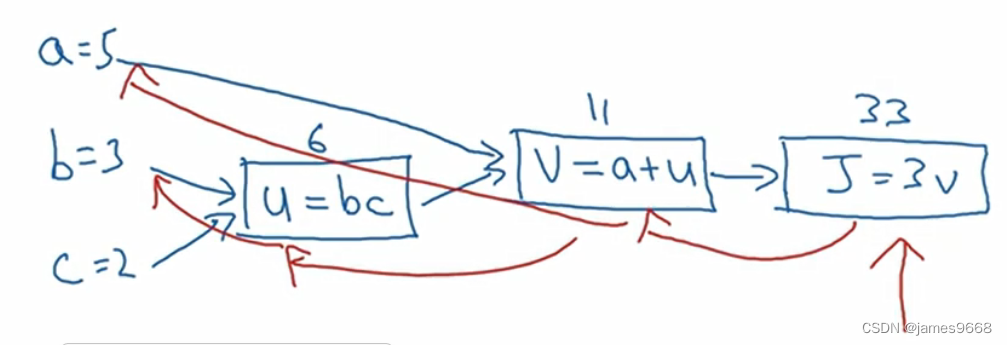

可以说一个神经网络的计算都是按照前向或反向传播过程来实现的。首先计算出神经网络的输出,紧接着进行一个反向传输操作。后者我们用来计算出对应的梯度或者导数。这个流程图解释了为什么用这样的方式来实现。在这个视频中,我们将看一个例子。

为了阐明这个计算过程,举一个比logistic回归更加简单的、不那么正式的神经网络的例子。我们尝试计算函数J,J是三个变量a,b,c的函数,这个函数是J(a,b,c)=3(a+bc)。 计算这个函数,实际上有三个不同的步骤,第一个首先是计算b乘以c,我们把它储存在变量u中,因此u=b*c。然后计算v=a+u,最后计算J就是3*v。这

计算这个函数,实际上有三个不同的步骤,第一个首先是计算b乘以c,我们把它储存在变量u中,因此u=b*c。然后计算v=a+u,最后计算J就是3*v。这 就是要计算的函数J。

就是要计算的函数J。

我们可以把这三步画成如下的流程图。 第一步先计算u=b*c,它的输入是b和c。接着第二步v=a+u,这个的输入就是u和a。最后一步J=3*v。举个例子a=5,b=3,c=2。那么u就等于6,v=5+6=11,J等于33。

第一步先计算u=b*c,它的输入是b和c。接着第二步v=a+u,这个的输入就是u和a。最后一步J=3*v。举个例子a=5,b=3,c=2。那么u就等于6,v=5+6=11,J等于33。

这个流程图用起来很方便,有不同的,或者一些特殊的输出变量时,比如J也是我们想要优化,在logistic回归中,J是想要最小化的成本函数。可以看出,通过一个从左到右的过程你可以计算出J的值。在接下来的幻灯片中我们会看到为了计算导数,从右到左的这个过程和这个蓝色箭头的过程相反, 这会是用于计算导数最自然的方式。

这会是用于计算导数最自然的方式。

因此概括一下,流程图使用蓝色箭头画出来的,从左到右的计算,看看下一个视频怎么做。这个反向红色箭头画的也就是从右到左的导数计算。

9290

9290

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?