SVM -支持向量机原理详解与实践之四

-

SVM原理分析

-

SMO算法分析

-

SMO即Sequential minmal optimization, 是最快的二次规划的优化算法,特使对线性SVM和稀疏数据性能更优。在正式介绍SMO算法之前,首先要了解坐标上升法。

-

坐标上升法(Coordinate ascent)

坐标上升法(Coordinate Ascent)简单点说就是它每次通过更新函数中的一维,通过多次的迭代以达到优化函数的目的。

-

坐标上升法原理讲解

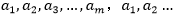

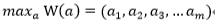

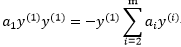

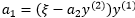

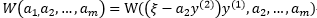

为了更加通用的表示算法的求解过程,我们将算法表示成:

| | (3.13-1) |

坐标上升法的算法为:

这个算法中最为关键的地方就是内循环对于

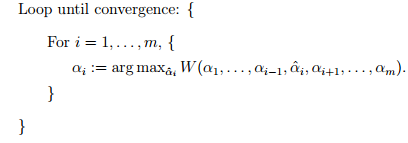

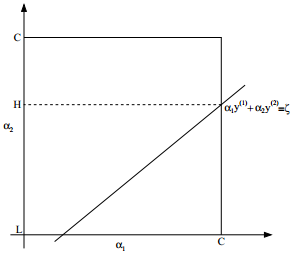

当函数W在内循环中能够最快的达到最优,则坐标上升是一个有效的算法,下面是一个坐标上升的示意图:

上图中的椭圆形线代表我们需要优化问题的二次函数的等高线,变量数为2,起始坐标是(2,2),途中的直线是迭代优化的路径,可以看到每一步都会相最优值前进一步,而且前进的路线都是平行与相应的坐标轴的,因为每次只优化一个变量。

-

C++算法编程实践

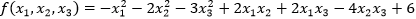

问题:求解函数

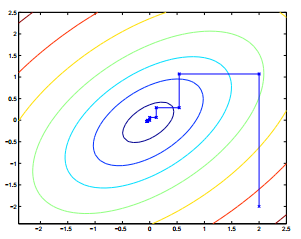

解:回顾我们前面分析的求取函数最大值的关键是,求解每一个迭代变量的导数,当求解某一变量的导数的时候,其他的变量看做是常数:

VS2013控制台工程参考代码如下:

// Coordinate ascent.cpp : Defines the entry point for the console application.

//

#include"stdafx.h"

#include<iostream>

usingnamespace std;

#definef(x1,x2,x3) (-x1*x1-2*x2*x2-3*x3*x3+2*x1*x2+2*x1*x3-4*x2*x3+6)

int_tmain(intargc,_TCHAR*argv[])

{

double x1 = 1;

double x2 = 1;

double x3 = 1;

double f0 =f(x1, x2, x3);

double err = 1.0e-10;

while (true)

{

x1 = x2 + x3;//对x1求导的表达式,每次迭代后更新

x2 = 0.5*x1 - x3;//对x2求导的表达式,每次迭代后更新

x3 = 1.0 / 3 * x1 - 2.0 / 3 * x2;//对x3求导的表达式,每次迭代后更新

double ft =f(x1, x2, x3);//求函数值

if (abs(ft - f0)<err)//判断f是否收敛

{

break;//收敛即完成求解过程

}

f0 = ft;//更新f0

}

cout <<"\nmax{f(x1,x2,x3)}=" <<f(x1, x2, x3) << endl;

cout <<"取得最大值时的坐标:\n(x1,x2,x3)=(" << x1 <<"," << x2 <<"," << x3 <<")" << endl;

system("pause");

return 0;

}

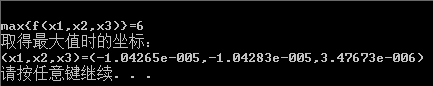

运行结果如下:

-

SMO算法详解

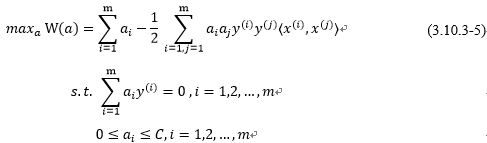

回到我们软间隔与正则化章节(还有最优间隔分类器),我们的对偶问题,就是通过固定拉格朗日乘子a,得到w和b的最优化表达式(关于a的表达式),所以最后我们只需要确认a,我们就可以最终确定w和b,但是在讨论SMO算法之前,我们并没有真正求解出

做出一个求解,也就是在参数

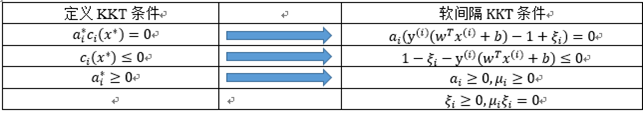

按照前面介绍的坐标上升的思路,我们首先固定除了

-

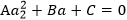

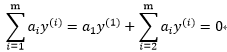

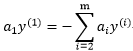

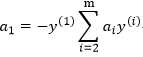

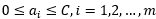

首先由优化问题的约束条件

可知:

即可推出

| | |||

| 两边乘以: | | ||

| | (3.13.2-1) | ||

因为

因此如果我们想要更新一些

重复大括号中的操作直到收敛{

- 选择一对

和

来更新下一个(用启发式的方法,也就是尝试选取两个允许我们朝着全局最大方向做最大前进的参数)。

- 固定所有其它的参数

,优化关于和

的函数W(a)。

}

为了测试该算法的收敛性,我们可以检查KKT条件:

是否满足收敛容错参数,典型值为0.1~0.001之间。

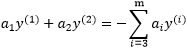

SMO作为一个高效的算法的关键原因在于计算更新

| |

由于右边固定,我们可以直接用一个常数表示,例如用

于是我可以将

根据约束条件:

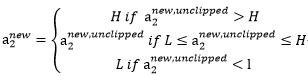

可知上图中表示

下面用

其中

所以目标问题W可以表示为:

其中

实际的问题中W展开后就是一个关于

-

支持向量机实践

这里限于篇幅,实践的内容将在下一篇展开…

1555

1555

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?