近期在探索AI应用时,我发现诸如Claude等模型若仅局限于问答交互,其潜力远未充分发挥。要让AI真正执行实际任务——例如抓取网页数据或操作代码仓库——需要借助MCP(Model Context Protocol)服务器。这种协议能让AI突破封闭环境,与外部工具和服务交互。本文将介绍五款开源MCP服务器,它们已通过实际测试验证,可显著增强AI的实用价值。。

一、什么是MPC服务器?

MCP 服务器即模型上下文协议服务器,它基于 MCP 协议,在 AI 模型与外部工具、系统间起桥梁作用,通过标准化交互方式,提供资源访问、工具调用和工作流组合等功能,在开发、生活、商业等多领域应用广泛。

在使用 MCP 服务器的情况下,我们只需对 Claude 说:“Claude,查看我 GitHub 上的问题。”Claude 就能轻松实现这一操作。首次完成时,感觉挺震撼,接下来,我就将五款搜罗到的MCP服务器分享给大家

二、分享几款MCP服务器

Stagehand服务器

Stagehand 是 Browserbase 开发的一款很棒的工具。它能让你的 AI 模拟打开浏览器的操作,比如点击链接、提取文本等。我在做一个项目时,用它从一个美食博客上抓取了很多食谱标题,这可比我自己写脚本轻松多了。

安装和启动方法:

git clone https://github.com/browserbase/stagehand-mcp

cd stagehand-mcp

npm install

npm start

在本地 3000 端口运行。给 Claude 下指令 “访问新闻网站,获取头条新闻”,Stagehand 很快抓取到标题,Claude 即可反馈。查询价格、提取数据时较为方便,无需写代码。

Jupyter MCP 服务器

Jupyter MCP服务器可让AI在Jupyter Notebook(专业数据处理工具)中运行。作为技术爱好者,让 Claude 查看咖啡店消费记录的 CSV 文件,然后让它给我分析。

安装和启动方法:

git clone https://github.com/jjsantos01/jupyter-notebook-mcp

cd jupyter-notebook-mcp

pip install -r requirements.txt

python server.py

本地主机的 8000 端口上运行,提示Claude:

Open coffee.csv and tell me how much I spent on lattes.

Claude 创建了一个文档,运行了一些 Python 代码,提示:

You dropped 87.50 on lattes this month. Ouch.

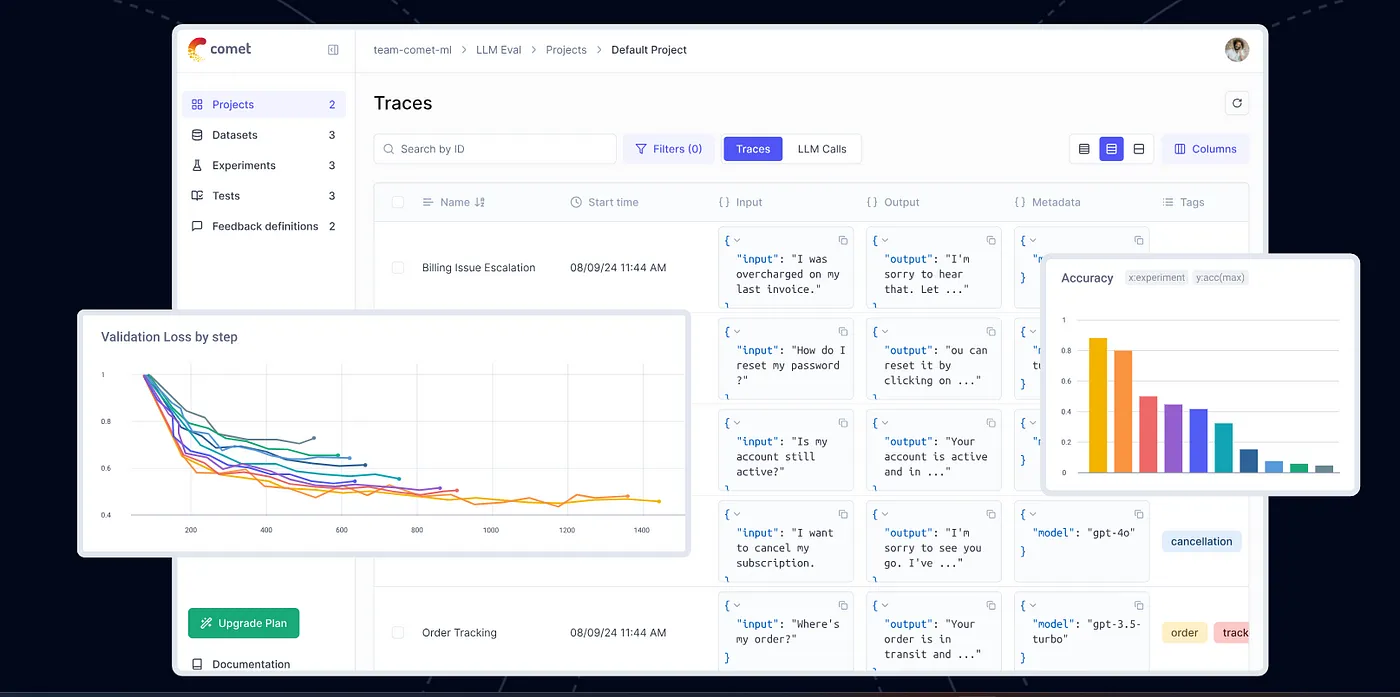

OPik服务器

Opik 来自 Comet公司,主要用于监控 AI 运行情况。比如说,如果 AI 的运行开始出现异常,Opik 能解释其中的原因。我之前有个 AI 机器人老给错误答案, 根据Opik提示,原来它在调用某些 API 时达到了使用限制。

安装和启动方法:

git clone https://github.com/comet-ml/opik

cd opik

./opik.sh

然后我把它添加到了一些代码中:

import opik

opik.configure(use_local=True)

@opik.track

def ask_something(question):

return "You asked: " + question

ask_something("What’s for dinner?")I asked Claude to check the logs:

Show me what my AI’s been up to.

它向我展示了每一次调用API,耗费时常等因信息

GitHub-MCP

由GitHub官方提供的MCP服务器,支持通过自然语言指令直接与代码仓库交互。其核心功能包括:

仓库状态实时查询:无需手动浏览多个页面,快速获取Issue、PR等关键信息

智能摘要生成:自动归纳代码变更内容及协作进展

部署流程:

git clone https://github.com/github/github-mcp-server

cd github-mcp-server

npm install

export GITHUB_TOKEN=你的个人访问令牌

npm start

服务启动后(默认端口4000),通过AI代理(如Claude)发送指令:

查看仓库'side-hustle'的未解决问题

系统将返回结构化响应:

当前存在2个未解决问题:

1. [BUG] 登录模块出现身份验证异常(标签:高优先级)

2. [功能请求] 需要新增分享按钮(标签:用户体验优化)

该工具可节省约70%的仓库管理时间,尤其适用于多项目并行开发场景,有效规避信息过载风险。

FastAPI-MCP服务器

FastAPI-MCP提供了一种创新的FastAPI服务集成方式,使AI能够直接调用自定义API接口。通过该方案,开发者可将现有业务系统(如待办事项管理、订单查询等)快速转化为AI可操作的工具。以下为完整实现流程:

核心功能

零代码接口暴露:通过装饰器标记API端点,自动生成AI可识别的工具描述

动态服务发现:支持热加载,实时同步API变更至AI代理

类型安全校验:基于FastAPI的类型注解,确保输入输出合规性

部署与集成

- 环境初始化

git clone https://github.com/jlowin/fastmcp

cd fastmcp

pip install fastapi-mcp # 注意此处无换行

**2.服务端改造**

在FastAPI应用中添加MCP适配层:

from fastapi import FastAPI

from fastmcp import mcp # 导入MCP扩展模块

app = FastAPI()

# 定义原生API端点

@app.get("/todo/{item_id}")

async def get_todo(item_id: int) -> dict:

"""获取待办事项详情"""

return {"id": item_id, "task": f"Task {item_id}"}

# 通过装饰器声明AI可访问工具

@mcp.tool()

async def get_todo_tool(item_id: int) -> dict:

"""查询指定ID的待办任务"""

return await get_todo(item_id)

3. 服务启动

uvicorn main:app --reload # 热加载模式运行于localhost:8000

4. 交互示例

向AI代理(如Claude)发送指令:

查询待办列表中第5项任务内容

系统返回结构化数据:

{

"id": 5,

"task": "Call mom."

}

三、总结

使用这些服务器的过程中我收获了很多乐趣:Stagehand 很适合处理网页相关的工作,Jupyter 在数据处理方面堪称一绝,Opik 能让一切运行透明可靠,GitHub 是程序员的梦想工具,而 FastAPI-MCP 则让我可以随心所欲地构建任何东西。它们全部免费,而且如果你想玩点高级的,还可以对它们进行自定义调整。

AI大模型学习路线

如果你对AI大模型入门感兴趣,那么你需要的话可以点击这里大模型重磅福利:入门进阶全套104G学习资源包免费分享!

微信扫描下方二维码获取哦!

这是一份大模型从零基础到进阶的学习路线大纲全览,小伙伴们记得点个收藏!

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

100套AI大模型商业化落地方案

大模型全套视频教程

200本大模型PDF书籍

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

LLM面试题合集

大模型产品经理资源合集

大模型项目实战合集

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

91

91

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?