这里写自定义目录标题

- 欢迎使用Markdown编辑器

- 1.综述系列

- 2.SOTA

- 3.TTS经典论文

- 4.语音合成论文调研

- 2021.5.13\_Grad-TTS: A Diffusion Probabilistic Model for Text-to-Speech

- \[ 🔊ICML 2021 \]2021.06.06\_Meta-StyleSpeech : Multi-Speaker Adaptive Text-to-Speech Generation

- \[ 🔊ICML 2022 \]2022.07.10.v4\_Guided-TTS: A Diffusion Model for Text-to-Speech via Classifier Guidance

- 2022.05.30.v1\_Guided-TTS 2: A Diffusion Model for High-quality Adaptive Text-to-Speech with Untranscribed Data

- \[🫧ICASSP 2022 \] 2022.11.17\_**Grad-StyleSpeech**

- 2023.01.05\_VALL-E

- 2023.03.07\_VALL-E X

- \[ ✨Interspeech 2023 \]2023.05.20\_EE-TTS: Emphatic Expressive TTS with Linguistic Information

- \[🫧ICASSP 2023 \] 2023.08.31\_LightGrad: Lightweight Diffusion Probabilistic Model for Text-to-Speech

- 2023.09.22.v2\_IMPROVING LANGUAGE MODEL-BASED ZERO-SHOT TEXT-TO-SPEECH SYNTHESIS WITH MULTI-SCALE ACOUSTIC PROMPTS

- 2023.09.10\_**VoiceFlow**

- **2023.10.P-Flow: A Fast and Data-Efficient Zero-Shot TTS through Speech Prompting**

- **2023.11 Diff-HierVC: Diffusion-based Hierarchical Voice Conversion with Robust Pitch Generation and Masked Prior for Zero-shot Speaker Adaptation**

- **2023.12.Schrodinger Bridges Beat Diffusion Models on Text-to-Speech Synthesis**

- 5.TTS创新论文

- 6.语音合成细小分支

- 7.学习资料

- 参考文献

- References

- 新的改变

- 功能快捷键

- 合理的创建标题,有助于目录的生成

- 如何改变文本的样式

- 插入链接与图片

- 如何插入一段漂亮的代码片

- 生成一个适合你的列表

- 创建一个表格

- 创建一个自定义列表

- 如何创建一个注脚

- 注释也是必不可少的

- KaTeX数学公式

- 新的甘特图功能,丰富你的文章

- UML 图表

- FLowchart流程图

- 导出与导入

欢迎使用Markdown编辑器

----------------------------------🗣️ 其他语音合成 调研 直达 🗣️ -------------------------------------

Text-to-speech(TTS)文本到语音,也就是语音合成。本文主要介绍一些语音合成的综述以及一系列经典论文,及最新语音合成调研。现有的语音合成的模型大多基于以下模型的核心思想,关于论文的详细内容以及项目实现请移步主页~~✨✨

会议标识如下:【🔊ICML 】【🫧ICASSP】【✨Interspeech 】

目录

目录

1.综述系列

2021_A Survey on Neural Speech Synthesis

论文从两个方面对神经语音合成领域的发展现状进行了梳理总结(逻辑框架如图1所示):

核心模块:分别从文本分析(textanalysis)、声学模型(acoustic model)、声码器(vocoder)、完全端到端模型(fully end-to-end model)等方面进行介绍。

进阶主题:分别从快速语音合成(fast TTS)、低资源语音合成(low-resourceTTS)、鲁棒语音合成(robust TTS)、富有表现力的语音合成(expressive TTS)、可适配语音合成(adaptive TTS)等方面进行介绍。

TTS 核心模块

研究员们根据神经语音合成系统的核心模块提出了一个分类体系。每个模块分别对应特定的数据转换流程:

1)文本分析模块将文本字符转换成音素或语言学特征;

2)声学模型将语言学特征、音素或字符序列转换成声学特征;

3)声码器将语言学特征或声学特征转换成语音波形;

4)完全端到端模型将字符或音素序列转换成语音波形。

2021_A Survey on Audio Synthesis and Audio-Visual Multimodal Processing(音频合成与视听多模态处理综述)

2.SOTA

(数据来源papers with code)

2.1.Text-To-Speech Synthesis on LJSpeech

2022_NaturalSpeech: End-to-End Text to Speech Synthesis with Human-Level Quality

2.2.Zero-Shot Multi-Speaker TTS:YourTTS(coqui-ai)

3.TTS经典论文

3.1.WAVENET系列

2016_WAVENET:A GENERATIVE MODEL FOR RAW AUDIO

【3,4】本文的四大特点如下:

-

WaveNet 直接生成自然的语音波形。

-

提出了一种可以学习和生成长语音波形的新结构。

-

训练的模型可以产生各种特征语音,因为状态建模。

-

它在**各种语音生成(**包括音乐)中也表现出色。

WaveNet模型结构

WaveNet 具有 30 个救援块的结构。 将整数数组作为输入,从第一个区域块到第 30 个区域性块依次进入。 从每个区域块生成的输出通过 Skip 连接合并,并将其用作模型的输出。

wavenet相关子论文

2018_NATURAL TTS SYNTHESIS BY CONDITIONING WAVENET ON MEL SPECTROGRAM PREDICTIONS

随着深度学习方法(如 WaveNet 和 Tacotron)的应用,TTS (TTS) 发展迅速。 因此,现在无需复杂的工作流程即可训练数据,从而从文本中生成高质量的语音【1,2】。

论文的三大特点如下:

-

基于 Attention 的 Seq-to-Seq提出了TTS模型结构。

-

<端到端模型>,只需对<语句、语音和对的数据即可进行训练,无需执行任何操作。

-

在语音合成质量测试 (MOS) 中得分较高。合成质量好。

3.2.Deep Voice系列

2017.3_Deep Voice: Real-time Neural Text-to-Speech

2017.5_Deep Voice 2: Multi-Speaker Neural Text-to-Speech

2018_DEEP VOICE 3: SCALING TEXT-TO-SPEECH WITH CONVOLUTIONAL SEQUENCELEARNING

3.3.Fastspeech系列

2019_Fastspeech

Paper:https://arxiv.org/pdf/1905.09263.pdf

Code:xcmyz/FastSpeech: The Implementation of FastSpeech based on pytorch. (github.com)

2022_Fastspeech2

Paper:https://arxiv.org/pdf/2006.04558.pdf

Code:[GitHub - ming024/FastSpeech2: An implementation of Microsoft’s “FastSpeech 2: Fast and High-Quality End-to-End Text to Speech”](https://github.com/ming024/FastSpeech2 “GitHub - ming024/FastSpeech2: An implementation of Microsoft’s “FastSpeech 2: Fast and High-Quality End-to-End Text to Speech””)

模型框架

项目实现请参考

3.4.Tacotron系列

Tacotron

Paper:Tacotron: A Fully End-to-End Text-To-Speech Synthesis Model.

Tacotron[7],是一个序列到序列的结构,可以从一系列的字符产生频谱图,简化了传统语音合成流程,仅仅根据数据训练的单个网络来代替了语言和声学特征。

Tacotron是第一个端对端的TTS神经网络模型,输入raw text,Tacotron可以直接输出mel-spectrogram,再利用Griffin-Lim算法就可以生成波形了。总体来说,模型和sequence-to-sequence模型非常相似,大体上由encoder和decoder组成,raw text经过pre-net, CBHG两个模块映射为hidden representation,之后decoder会生成mel-spectrogram frame。

实际上Tacotron的卖点主要是在end-to-end,其表现虽然比传统方法要好,但是相比Wavenet并没有明显的提升(甚至不如Wavenet),因此也就有了后面的Tacotron2。

Tacotron2:一个完整神经网络语音合成方法。模型主要由三部分组成: 1. 声谱预测网络:一个引入注意力机制(attention)的基于循环的Seq2seq的特征预测网络,用于从输入的字符序列预测梅尔频谱的帧序列。 2. 声码器(vocoder):一个WaveNet的修订版,用预测的梅尔频谱帧序列来生成时域波形样本。 3. 中间连接层:使用低层次的声学表征-梅尔频率声谱图来衔接系统的两个部分。

2017_Tacotron2

Paper:Tacotron: Towards end-to-end speech synthesis

Tacotron2[8]:一个完整神经网络语音合成方法。模型主要由三部分组成: 1. 声谱预测网络:一个引入注意力机制(attention)的基于循环的Seq2seq的特征预测网络,用于从输入的字符序列预测梅尔频谱的帧序列。 2. 声码器(vocoder):一个WaveNet的修订版,用预测的梅尔频谱帧序列来生成时域波形样本。 3. 中间连接层:使用低层次的声学表征-梅尔频率声谱图来衔接系统的两个部分。

Tacotron2仍然使用了一个seq2seq的Tacotron模型,通过这个模型产生mel图,将mel图输入改进的WaveNet Vocoder生成波形。

优点:

直接对规范化的<text, audio>对进行训练,Tacotron可以合成非常自然的语音(几乎很难和真实的人类语音相区别)。

Tacotron****相关子论文

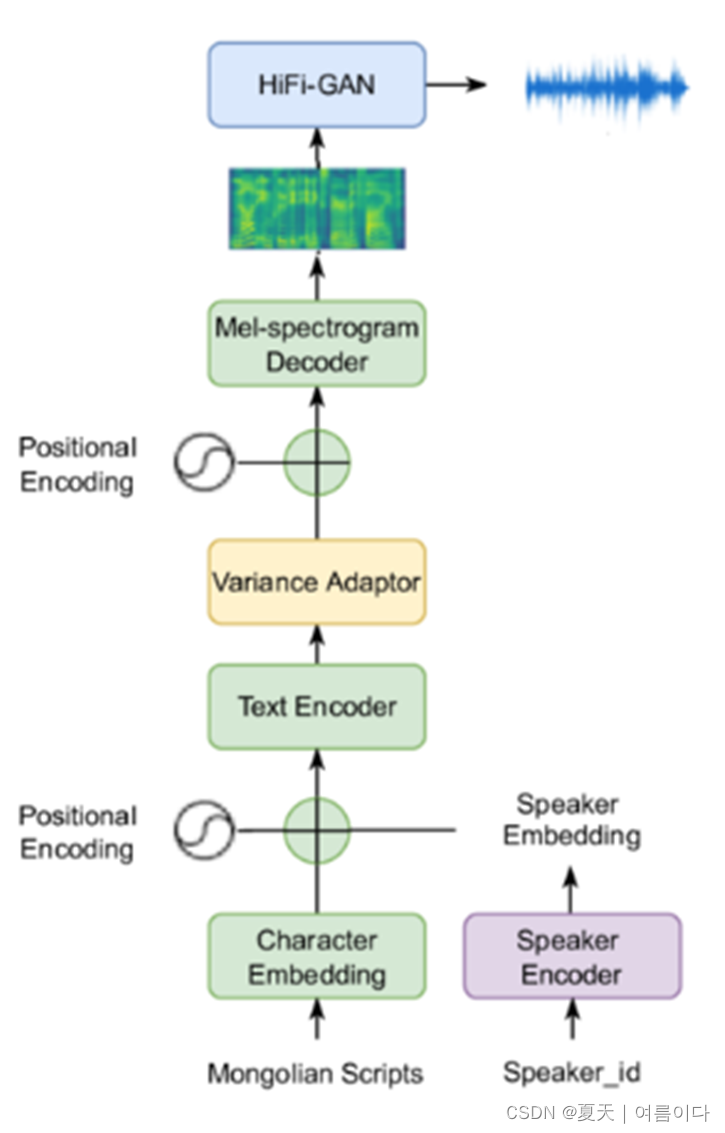

2023_A Novel End-to-End Turkish Text-to-Speech (TTS) System via Deep Learning,paper

论文文本转语音 (TTS) 系统取得了长足的进步,但创建听起来自然的人声仍然具有挑战性。现有方法依赖于仅具有单层非线性变换的非综合模型,这对于处理语音、图像和视频等复杂数据的效率较低。为了克服这个问题,已经为TTS提出了基于深度学习(DL)的解决方案,但需要大量的训练数据。不幸的是,土耳其语TTS没有可用的语料库,不像英语,它有充足的资源。为了解决这个问题,我们的研究重点是使用DL方法开发土耳其语音合成系统。我们从一位男性演讲者那里获得了一个大型语料库,并为TTS系统提出了Tacotron 2 + HiFi-GAN结构。真实用户使用平均意见得分 (MOS) 将合成语音的质量评为 4.49。此外,MOS听力质量目标客观地评估了语音质量,获得了4.32分。语音波形推理时间由实时因子确定,在1.0 s内合成92 s语音数据。据我们所知,这些发现代表了土耳其TTS的第一个记录在案的深度学习和基于HiFi-GAN的TTS系统。

3.5.Transformer-TTS

Paper:"Neural Speech Synthesis with Transformer Network

Code:[soobinseo/Transformer-TTS: A Pytorch Implementation of “Neural Speech Synthesis with Transformer Network” (github.com)](https://github.com/soobinseo/Transformer-TTS “soobinseo/Transformer-TTS: A Pytorch Implementation of “Neural Speech Synthesis with Transformer Network” (github.com)”)

把Transformer和Tacotron2融合,就形成了Transformer-TTS。模型的主体是原始的Transformer,只是在输入阶段和输出阶段为了配合语音数据的特性做了改变。首先是Encoder的输入阶段,先将text逐字符转化为token,方便Embedding,然后进入Encoder PreNet,这层网络由一个Embedding layer和三层卷积层构成,转化为512维的向量后,进入Transformer Encoder。其次是Transformer的Decoder部分,分为输入和输出。输入通过一个PreNet将80维的梅尔声谱图转化为512维向量,这里的PreNet是一个三层的全连接网络。输出部分与Tacotron2的设计完全一致。基于Transformer的TTS模型已是现在主流的End-to-End TTS系统的baseline,它的实现必不可少,而且因为Transformer本身优异的结构,也能大大加快实验的速度。

3.6.VITS系列

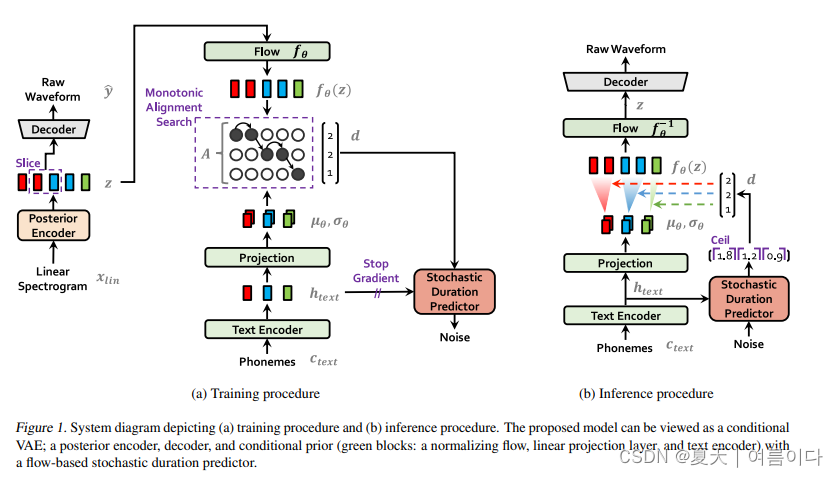

2020_VITS

论文:Conditional Variational Autoencoder with Adversarial Learning for End-to-End Text-to-Speech

详情请参考这篇博客内容请查看【VITS论文概述及代码实现】。

VITS2

Paper:VITS2: Improving Quality and Efficiency of Single-Stage Text-to-Speech with Adversarial Learning and Architecture Design

Demo:[Audio samples from “VITS2: Improving Quality and Efficiency of Single Stage Text to Speech with Adversarial Learning and Architecture Design” (vits-2.github.io)](https://vits-2.github.io/demo/ “Audio samples from “VITS2: Improving Quality and Efficiency of Single Stage Text to Speech with Adversarial Learning and Architecture Design” (vits-2.github.io)”)

最近对单阶段文本到语音转换模型进行了积极研究,其结果优于两阶段管道系统。 虽然之前的单阶段模型取得了长足的进步,但在间歇性不自然性、计算效率以及对音素转换的强烈依赖方面仍有改进空间。 在这项工作中,我们介绍了 VITS2,这是一种单阶段文本到语音转换模型,通过改进先前工作的几个方面来有效地合成更自然的语音。 我们提出了改进的结构和培训机制,并提出所提出的方法是有效的 提高多说话人模型中语音特征的自然性、相似性以及训练和推理的效率。 此外,我们证明了使用我们的方法可以显着减少以前工作中对音素转换的强烈依赖,这允许完全端到端的单阶段方法。

VITS相关子论文

Paper:2022_Lightweight and High-Fidelity End-to-End Text-to-Speech with Multi-Band Generation and Inverse Short-Time Fourier Transform with Multilingual Cleaners

3.7.NaturalSpech系列

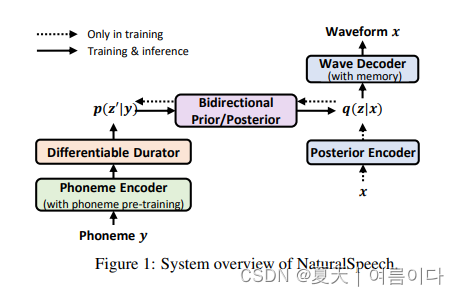

202205_NaturalSpech

论文题目:NaturalSpeech: End-to-End Text to Speech Synthesis with Human-Level Quality

论文地址:[2205.04421] NaturalSpeech: End-to-End Text to Speech Synthesis with Human-Level Quality (arxiv.org)

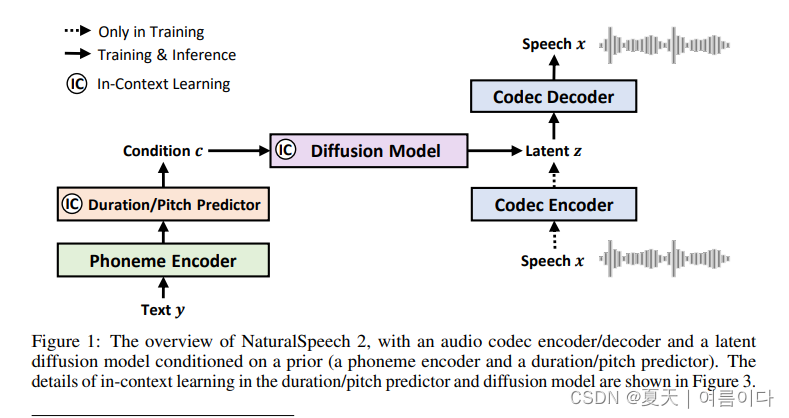

202304_NaturalSpech2

** 论文题目:NaturalSpeech 2: Latent Diffusion Models are Natural and Zero-Shot Speech and Singing Synthesizers潜在扩散模型是自然和零样本的语音和歌唱合成器**

4.语音合成论文调研

2021.5.13_Grad-TTS: A Diffusion Probabilistic Model for Text-to-Speech

Grad-TTS: A Diffusion Probabilistic Model for Text-to-Speech

论文地址:Grad-TTS: A Diffusion Probabilistic Model for Text-to-Speech (arxiv.org)

最近,去噪扩散概率模型和生成分数匹配在模拟复杂数据分布方面显示出巨大的潜力,而随机演算为这些技术提供了统一的观点,从而实现了灵活的推理方案。在本文中,我们介绍了Grad-TTS,这是一种新颖的文本转语音模型,具有基于分数的解码器,通过逐渐转换编码器预测的噪声来生成梅尔频谱图,并通过单调对齐搜索与文本输入对齐。随机微分方程的框架有助于我们将传统的扩散概率模型推广到从具有不同参数的噪声中重建数据的情况,并允许通过明确控制音质和推理速度之间的权衡来使这种重建变得灵活。主观的人工评估表明,就平均意见得分而言,Grad-TTS 与最先进的文本转语音方法相比具有竞争力。

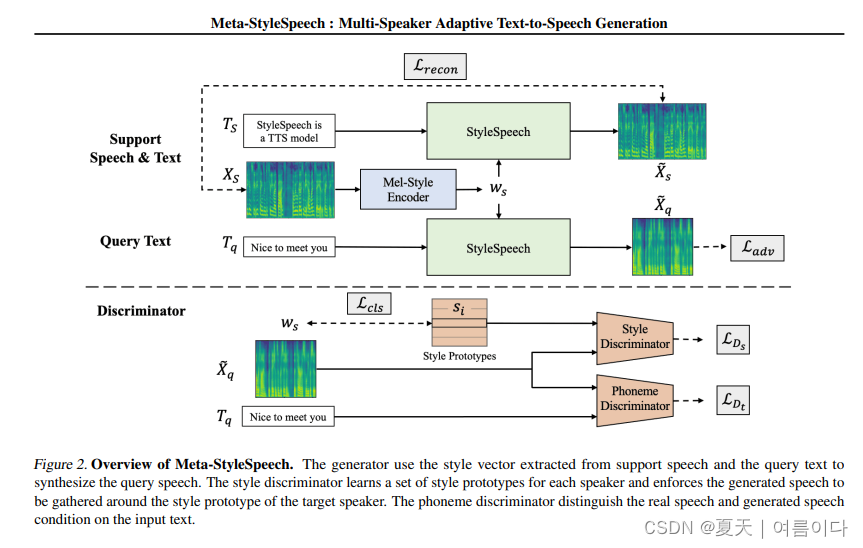

[ 🔊ICML 2021 ]2021.06.06_Meta-StyleSpeech : Multi-Speaker Adaptive Text-to-Speech Generation

论文地址:Meta-StyleSpeech : Multi-Speaker Adaptive Text-to-Speech Generation (arxiv.org)

随着神经文本转语音 (TTS) 模型的快速发展,个性化语音生成现在对许多应用的需求量很大。为了实现实际适用性,TTS 模型应该仅使用来自给定说话者的几个音频样本来生成高质量的语音,这些样本的长度也很短。然而,现有方法要么需要对模型进行微调,要么在不进行微调的情况下实现低适应质量。在这项工作中,我们提出了一种新的TTS模型StyleSpeech,它不仅可以合成高质量的语音,还可以有效地适应新的说话者。具体来说,我们提出了风格自适应层归一化(SALN),它根据从参考语音音频中提取的风格来对齐文本输入的增益和偏置。借助 SALN,我们的模型可以有效地合成目标说话人的语音,即使是从单个语音音频中也是如此。此外,为了增强 StyleSpeech 对新说话者语音的适应能力,我们通过引入两个使用风格原型训练的判别器并执行情景训练,将其扩展到 Meta-StyleSpeech。实验结果表明,我们的模型生成高质量的语音,通过单个短时(1-3秒)语音音频准确地跟随说话者的声音,性能明显优于基线。

[ 🔊ICML 2022 ]2022.07.10.v4_Guided-TTS: A Diffusion Model for Text-to-Speech via Classifier Guidance

论文地址:[2111.11755] Guided-TTS: A Diffusion Model for Text-to-Speech via Classifier Guidance (arxiv.org)

我们提出了 Guided-TTS,这是一种高质量的文本转语音 (TTS) 模型,它不需要使用分类器指导对目标说话人进行任何转录。Guided-TTS 将无条件扩散概率模型与单独训练的音素分类器相结合,用于分类器指导。我们的无条件扩散模型学习从未转录的语音数据中生成没有任何上下文的语音。对于TTS合成,我们使用在大规模语音识别数据集上训练的音素分类器来指导扩散模型的生成过程。我们提出了一种基于范数的缩放方法,该方法可以减少 Guided-TTS 中分类器引导的发音错误。我们表明,Guided-TTS 实现了与最先进的 TTS 模型 Grad-TTS 相当的性能,而无需任何 LJSpeech 的成绩单。我们进一步证明,Guided-TTS 在各种数据集上表现良好,包括长篇未转录数据集。

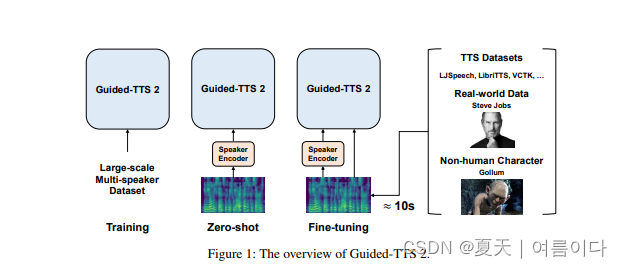

2022.05.30.v1_Guided-TTS 2: A Diffusion Model for High-quality Adaptive Text-to-Speech with Untranscribed Data

我们提出了 Guided-TTS 2,这是一种基于扩散的生成模型,用于使用未转录数据的高质量自适应 TTS。Guided-TTS 2 将说话人条件扩散模型与说话人相关的音素分类器相结合,以实现自适应文本到语音转换。我们在大规模未转录数据集上训练说话人条件扩散模型,以获得无分类器的引导方法,并在目标说话人的参考语音上进一步微调扩散模型以进行适应,这只需要 40 秒。我们证明,Guided-TTS 2 在语音质量和说话人相似性方面表现出与高质量单扬声器 TTS 基线相当的性能,只有 10 秒的未转录数据。我们进一步表明,即使在零样本适应设置下,Guided-TTS 2 在多说话人数据集上也优于自适应 TTS 基线。Guided-TTS 2 只能使用未转录的语音来适应各种声音,这使得 TTS 能够使用非人类角色的声音进行自适应 TTS,例如 \textit{“The Lord of the Rings”} 中的咕噜。

[🫧ICASSP 2022 ] 2022.11.17_Grad-StyleSpeech

Grad-StyleSpeech:使用扩散模型的任意说话人自适应文本到语音合成

论文地址:2211.09383.pdf (arxiv.org)

论文代码:暂无

**Demo:**https://nardien.github.io/grad-stylespeech-demo

近年来,由于神经生成建模的进步,文本转语音 (TTS) 合成技术取得了重大进展。然而,现有的任何说话人自适应TTS方法在模仿目标说话人的风格方面都取得了不理想的性能,因为它们在模仿目标说话人的风格方面精度不理想。在这项工作中,我们提出了 Grad-StyleSpeech,这是一个基于扩散模型的任意说话人自适应 TTS 框架,该模型可以生成高度自然的语音,与目标说话人的声音具有极高的相似性,给定几秒钟的参考语音。在英语基准测试中,Grad-StyleSpeech 明显优于最近的说话人自适应 TTS 基线。音频示例可在此 https URL 中找到。

Grad-StyleSpeech 由三个组件组成,如上图所示。

- MEL 风格的编码器将参考语音嵌入为样式向量

- 分层转换器编码器,用于使用文本和样式向量创建条件中间表示

- 一种扩散模型,将这些中间表示映射到梅尔频谱图作为去噪步骤

2023.01.05_VALL-E

论文题目:Neural Codec Language Models are Zero-Shot Text to Speech Synthesizers

VALL-E 将语音合成视为一种条件语言建模(Conditional Language Modeling)的任务,使用神经网络音频编解码器的中间结果作为音频的离散表征,在此表征的基础上进行语言建模。VALL-E 使用 6 万小时量级的英语语音数据(语音合成的数据量也卷起来了)进行预训练,在对未见过的目标说话人进行 zero-shot 推理时,只需要 3 秒的音频作为 prompt(也可称为前缀),即可实现高自然度 + 高音色相似度的语音合成,在语音的情感、声学环境等方面也能和 prompt 的语音保持一致,体现出 VALL-E 已经具备 in-context learning 的能力。

2023.03.07_VALL-E X

论文代码:Speak Foreign Languages with Your Own Voice: Cross-Lingual Neural Codec Language Modeling

论文地址:2303.03926.pdf (arxiv.org)

Demo:https://aka.ms/vallex

多语言 TTS:用三种语言说话 - 英语、中文和日语 - 具有自然和富有表现力的语音合成。

零样本语音克隆:用一个未训练的 3~10 秒录音,可生成个性化、高质量的语音!

[ ✨Interspeech 2023 ]2023.05.20_EE-TTS: Emphatic Expressive TTS with Linguistic Information

论文地址:Submitted to INTERSPEECH (arxiv.org)

Demo:EE-TTS: Emphatic Expressive TTS with Linguistic Information (expressive-emphatic-ttsdemo.github.io)

虽然当前的TTS系统在合成高质量语音方面表现良好,但产生高度表现力的语音仍然是一个挑战。重音作为决定言语表现力的关键因素,如今越来越受到关注。以往的作品通常通过增加中间特征来增强重点,但不能保证演讲的整体表现力。为了解决这个问题,我们提出了强调表达TTS(EE-TTS),它利用了来自句法和语义的多层次语言信息。EE-TTS 包含一个重音预测器,可以从文本中识别适当的重音位置,以及一个条件声学模型,以合成具有重音和语言信息的富有表现力的语音。实验结果表明,EE-TTS的表现力和自然度分别提高了0.49和0.67。根据 AB 测试结果,EE-TTS 在不同数据集上也显示出很强的泛化性。

[🫧ICASSP 2023 ] 2023.08.31_LightGrad: Lightweight Diffusion Probabilistic Model for Text-to-Speech

论文标题:LightGrad:轻量级文语转换扩散概率模型

论文链接:https://arxiv.org/abs/2308.16569

论文代码:thuhcsi/LightGrad

LightGrad配备了轻量级的U-Net扩散解码器和免训练快速采样技术,减少了模型参数和推理延迟。流式推理也在LightGrad中实现,以进一步减少延迟。与Grad-TTS相比,LightGrad在参数上减少了62.2%,延迟减少了65.7%,同时在4个去噪步骤中保持了汉语普通话和英语相当的语音质量。

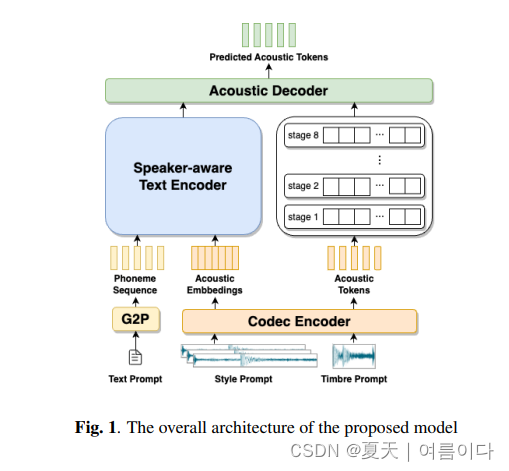

2023.09.22.v2_IMPROVING LANGUAGE MODEL-BASED ZERO-SHOT TEXT-TO-SPEECH SYNTHESIS WITH MULTI-SCALE ACOUSTIC PROMPTS

零样本文本转语音 (TTS) 合成旨在克隆任何看不见的说话者的声音,而无需自适应参数。通过将语音波形量化为离散的声学标记并使用语言模型对这些标记进行建模,最近基于语言模型的 TTS 模型显示了零样本说话人适应能力,只需 3 秒的看不见说话人的声学提示。然而,它们受到声音提示长度的限制,这使得克隆个人说话风格变得困难。在本文中,我们提出了一种基于神经编解码语言模型VALL-E的具有多尺度声学提示的新型零样本TTS模型。提出了一种说话人感知文本编码器,从由多个句子组成的风格提示中学习音素级别的个人说话风格。然后,利用基于VALL-E的声学解码器在帧级对音色提示的音色进行建模并生成语音。实验结果表明,所提方法在自然度和说话人相似度方面优于基线,并且可以通过扩展到更长的风格提示来实现更好的性能。

2023.09.10_VoiceFlow

论文题目:VoiceFlow:通过校正流匹配实现高效的文本转语音

论文地址:2309.05027.pdf (arxiv.org)

论文代码:[Audio Samples from “Unsupervised Word-Level Prosody Tagging for Controllable Speech Synthesis” (cantabile-kwok.github.io)](https://cantabile-kwok.github.io/VoiceFlow/ “Audio Samples from “Unsupervised Word-Level Prosody Tagging for Controllable Speech Synthesis” (cantabile-kwok.github.io)”)

Demo:[X-LANCE/VoiceFlow-TTS: [ICASSP 2024] This is the official code for “VoiceFlow: Efficient Text-to-Speech with Rectified Flow Matching” (github.com)](https://github.com/X-LANCE/VoiceFlow-TTS “X-LANCE/VoiceFlow-TTS: [ICASSP 2024] This is the official code for “VoiceFlow: Efficient Text-to-Speech with Rectified Flow Matching” (github.com)”)

尽管文本转语音中的扩散模型因其强大的生成能力而成为一种流行的选择,但从扩散模型中采样的内在复杂性损害了其效率。或者,我们提出了 VoiceFlow,这是一种声学模型,它利用整流匹配算法以有限的采样步骤实现高合成质量。VoiceFlow 将生成 mel-spectrogram 的过程表述为以文本输入为条件的常微分方程,然后估计其向量场。然后,精流流技术有效地拉直了其采样轨迹,以实现高效合成。对单说话人和多说话人语料库的主观和客观评估表明,与扩散语料库相比,VoiceFlow 的合成质量更胜一筹。消融研究进一步验证了VoiceFlow中整流流技术的有效性。

2023.10.P-Flow: A Fast and Data-Efficient Zero-Shot TTS through Speech Prompting

论文地址:https://neurips.cc/virtual/2023/poster/69899

2023.11 Diff-HierVC: Diffusion-based Hierarchical Voice Conversion with Robust Pitch Generation and Masked Prior for Zero-shot Speaker Adaptation

论文地址:https://arxiv.org/abs/2311.04693

摘要:Diff-HierVC,一个基于两个扩散模型的分层VC系统;DiffPitch可以有效地生成具有目标语音风格的F0,DiffVoice再将语音转换为目标语音风格。

2023.12.Schrodinger Bridges Beat Diffusion Models on Text-to-Speech Synthesis

论文地址:https://arxiv.org/abs/2312.03491

利用从文本输入中获得的潜在表示作为先验知识,并在它和真实梅尔频谱图之间建立一个完全易于处理的薛定谔桥,从而实现数据到数据的过程。

5.TTS创新论文

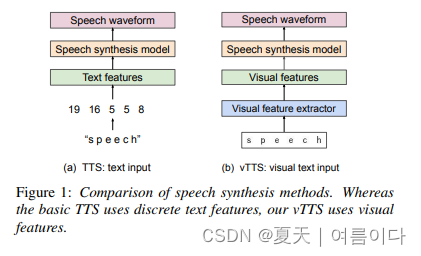

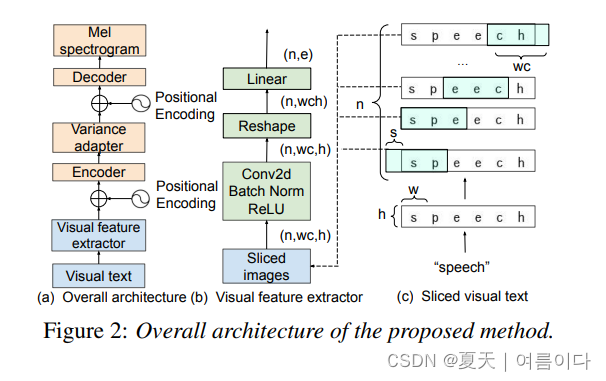

2022_vTTS: visual-text to speech

将文本处理转为视觉特征进行语音生成。

模型构架如下

论文中使用了3种语言(英韩日)的数据集,效果较好。

6.语音合成细小分支

6.1.情绪控制语音合成

2022_Cross-speaker Emotion Transfer through Information Perturbation in Emotional Speech Synthesis

更多情绪相关语音合成请查看TTS | 2019~2023年最新增强/生成情绪的语音合成调研(20231211更新版)-CSDN博客

参考【5】

6.2.语言到语言翻译

[ ✨Interspeech 2023 ]2023.6.25_StyleS2ST: Zero-shot Style Transfer for Direct Speech-to-speech Translation

直接语音到语音翻译 (S2ST) 逐渐流行起来,因为它与级联 S2ST 相比具有许多优势。然而,目前的研究主要集中在语义翻译的准确性上,而忽略了从源语言到目标语言的语音风格迁移。由于缺乏高保真表现力的并行数据,这种风格转换具有挑战性,尤其是在更实际的零样本场景中。为了解决这个问题,我们首先使用多语言多说话人文本到语音合成(TTS)系统构建了一个并行语料库,然后在直接S2ST系统框架上提出了基于风格适配器的具有跨语言语音风格迁移能力的StyleS2ST模型。StyleS2ST 通过并行语料库训练和非并行 TTS 数据增强实现声学模型的连续风格空间建模,捕获从源语言到目标语言的跨语言声学特征映射。实验表明,StyleS2ST在集内和集外零样本场景中都实现了良好的风格相似度和自然度。

[ ✨Interspeech 2023 ]2023_STEN-TTS: Improving Zero-shot Cross-Lingual Transfer for Multi-Lingual TTS with Style-Enhanced Normalization Diffusion Framework

7.学习资料

7.1.斯坦福cs224s课程

(303) Lecture 12: End-to-End Models for Speech Processing - YouTube

CS224s Deep Learning for TTS (stanford.edu)

7.2.微软相关课程讲座等

Generative Models for TTS (microsoft.com)

关于一些语音合成模型的经验总结请查看【语音合成模型经验总结】!

参考文献

【1】[논문리뷰]Tacotron2 - 새내기 코드 여행 (joungheekim.github.io)

【2】[Speech Synthesis] Tacotron 논문 정리 (hcnoh.github.io)

【3】[논문리뷰]WaveNet - 새내기 코드 여행 (joungheekim.github.io)

【4】Understanding WaveNet architecture | by Satyam Kumar | Medium

【5】论文推介:情感语音合成中基于信息扰动的跨说话人情感迁移 - 知乎 (zhihu.com)

【6】huawei-noah/Speech-Backbones: This is the main repository of open-sourced speech technology by Huawei Noah’s Ark Lab. (github.com) 【7】DmitryRyumin/INTERSPEECH-2023-Papers: INTERSPEECH 2023 Papers: A complete collection of influential and exciting research papers from the INTERSPEECH 2023 conference. Explore the latest advances in speech and language processing. Code included. Star the repository to support the advancement of speech technology! (github.com)

References

[1] Sercan Ömer Arik, Mike Chrzanowski, Adam Coates, Gregory Frederick Diamos, Andrew Gibiansky, Yongguo Kang, Xian Li, John Miller, Andrew Y. Ng, Jonathan Raiman, Shubho Sengupta, Mohammad Shoeybi: Deep Voice: Real-time Neural Text-to-Speech. ICML 2017: 195-204

[2] Wei Ping, Kainan Peng, Andrew Gibiansky, Sercan O.Arık, Ajay Kannan, Sharan Naran: DEEP VOICE 3: 2000-SPEAKER NEURAL TEXT-TO-SPEECH. CoRR abs/1710.07654 (2017)

[3] Sercan Ömer Arik, Gregory F. Diamos, Andrew Gibiansky, John Miller, Kainan Peng, Wei Ping, Jonathan Raiman, Yanqi Zhou: Deep Voice 2: Multi-Speaker Neural Text-to-Speech. CoRR abs/1705.08947 (2017)

[4] Aäron van den Oord, Sander Dieleman, Heiga Zen, Karen Simonyan, Oriol Vinyals, Alex Graves, Nal Kalchbrenner, Andrew W. Senior, Koray Kavukcuoglu: WaveNet: A Generative Model for Raw Audio. CoRR abs/1609.03499 (2016)

[5] Soroush Mehri, Kundan Kumar, Ishaan Gulrajani, Rithesh Kumar, Shubham Jain, Jose Sotelo, Aaron C. Courville, Yoshua Bengio: SampleRNN: An Unconditional End-to-End Neural Audio Generation Model. CoRR abs/1612.07837 (2016)

[6] Sotelo, J., Mehri, S., Kumar, K., Santos, J. F., Kastner, K., Courville, A., & Bengio, Y. (2017). Char2Wav: End-to-end speech synthesis.

[7] Yuxuan Wang, R. J. Skerry-Ryan, Daisy Stanton, Yonghui Wu, Ron J. Weiss, Navdeep Jaitly, Zongheng Yang, Ying Xiao, Zhifeng Chen, Samy Bengio, Quoc V. Le, Yannis Agiomyrgiannakis, Rob Clark, Rif A. Saurous: Tacotron: A Fully End-to-End Text-To-Speech Synthesis Model. CoRR abs/1703.10135 (2017)

[8] Y. Wang, R. Skerry-Ryan, D. Stanton, Y. Wu, R. J. Weiss, N. Jaitly, Z. Yang, Y. Xiao, Z. Chen, S. Bengio et al., “Tacotron: Towards end-to-end speech synthesis,” Proc. Interspeech 2017, pp. 4006–4010, 2017.

[9]Y. Ren, C. Hu, X. Tan, T. Qin, S. Zhao, Z. Zhao, and T.-Y. Liu, “Fastspeech 2: Fast and high-quality end-to-end text to speech,” in International Conference on Learning Representations, 2020.

[10]Wang, W., Xu, S., & Xu, B. (201 6). First Step Towards End-to-End Parametric TTS Synthesis: Generating Spectral Parameters with Neural Attention. INTERSPEECH.

你好! 这是你第一次使用 Markdown编辑器 所展示的欢迎页。如果你想学习如何使用Markdown编辑器, 可以仔细阅读这篇文章,了解一下Markdown的基本语法知识。

新的改变

我们对Markdown编辑器进行了一些功能拓展与语法支持,除了标准的Markdown编辑器功能,我们增加了如下几点新功能,帮助你用它写博客:

- 全新的界面设计 ,将会带来全新的写作体验;

- 在创作中心设置你喜爱的代码高亮样式,Markdown 将代码片显示选择的高亮样式 进行展示;

- 增加了 图片拖拽 功能,你可以将本地的图片直接拖拽到编辑区域直接展示;

- 全新的 KaTeX数学公式 语法;

- 增加了支持甘特图的mermaid语法1 功能;

- 增加了 多屏幕编辑 Markdown文章功能;

- 增加了 焦点写作模式、预览模式、简洁写作模式、左右区域同步滚轮设置 等功能,功能按钮位于编辑区域与预览区域中间;

- 增加了 检查列表 功能。

功能快捷键

撤销:Ctrl/Command + Z

重做:Ctrl/Command + Y

加粗:Ctrl/Command + B

斜体:Ctrl/Command + I

标题:Ctrl/Command + Shift + H

无序列表:Ctrl/Command + Shift + U

有序列表:Ctrl/Command + Shift + O

检查列表:Ctrl/Command + Shift + C

插入代码:Ctrl/Command + Shift + K

插入链接:Ctrl/Command + Shift + L

插入图片:Ctrl/Command + Shift + G

查找:Ctrl/Command + F

替换:Ctrl/Command + G

合理的创建标题,有助于目录的生成

直接输入1次#,并按下space后,将生成1级标题。

输入2次#,并按下space后,将生成2级标题。

以此类推,我们支持6级标题。有助于使用TOC语法后生成一个完美的目录。

如何改变文本的样式

强调文本 强调文本

加粗文本 加粗文本

标记文本

删除文本

引用文本

H2O is是液体。

210 运算结果是 1024.

插入链接与图片

链接: link.

图片:

带尺寸的图片:

居中的图片:

居中并且带尺寸的图片:

当然,我们为了让用户更加便捷,我们增加了图片拖拽功能。

如何插入一段漂亮的代码片

去博客设置页面,选择一款你喜欢的代码片高亮样式,下面展示同样高亮的 代码片.

// An highlighted block

var foo = 'bar';

生成一个适合你的列表

- 项目

- 项目

- 项目

- 项目

- 项目1

- 项目2

- 项目3

- 计划任务

- 完成任务

创建一个表格

一个简单的表格是这么创建的:

| 项目 | Value |

|---|---|

| 电脑 | $1600 |

| 手机 | $12 |

| 导管 | $1 |

设定内容居中、居左、居右

使用:---------:居中

使用:----------居左

使用----------:居右

| 第一列 | 第二列 | 第三列 |

|---|---|---|

| 第一列文本居中 | 第二列文本居右 | 第三列文本居左 |

SmartyPants

SmartyPants将ASCII标点字符转换为“智能”印刷标点HTML实体。例如:

| TYPE | ASCII | HTML |

|---|---|---|

| Single backticks | 'Isn't this fun?' | ‘Isn’t this fun?’ |

| Quotes | "Isn't this fun?" | “Isn’t this fun?” |

| Dashes | -- is en-dash, --- is em-dash | – is en-dash, — is em-dash |

创建一个自定义列表

-

Markdown

- Text-to- HTML conversion tool Authors

- John

- Luke

如何创建一个注脚

一个具有注脚的文本。2

注释也是必不可少的

Markdown将文本转换为 HTML。

KaTeX数学公式

您可以使用渲染LaTeX数学表达式 KaTeX:

Gamma公式展示 Γ ( n ) = ( n − 1 ) ! ∀ n ∈ N \Gamma(n) = (n-1)!\quad\forall n\in\mathbb N Γ(n)=(n−1)!∀n∈N 是通过欧拉积分

Γ ( z ) = ∫ 0 ∞ t z − 1 e − t d t . \Gamma(z) = \int_0^\infty t^{z-1}e^{-t}dt\,. Γ(z)=∫0∞tz−1e−tdt.

你可以找到更多关于的信息 LaTeX 数学表达式here.

新的甘特图功能,丰富你的文章

- 关于 甘特图 语法,参考 这儿,

UML 图表

可以使用UML图表进行渲染。 Mermaid. 例如下面产生的一个序列图:

这将产生一个流程图。:

- 关于 Mermaid 语法,参考 这儿,

FLowchart流程图

我们依旧会支持flowchart的流程图:

- 关于 Flowchart流程图 语法,参考 这儿.

导出与导入

导出

如果你想尝试使用此编辑器, 你可以在此篇文章任意编辑。当你完成了一篇文章的写作, 在上方工具栏找到 文章导出 ,生成一个.md文件或者.html文件进行本地保存。

导入

如果你想加载一篇你写过的.md文件,在上方工具栏可以选择导入功能进行对应扩展名的文件导入,

继续你的创作。

注脚的解释 ↩︎

2111

2111

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?