demo地址:https://github.com/tensorflow/examples/tree/master/lite/examples/object_detection/android

环境要求:

Android Studio

官方说的是3.2 以上,我的旧AS版本是3.5也不行,所以更新到了当前最新的稳定版。

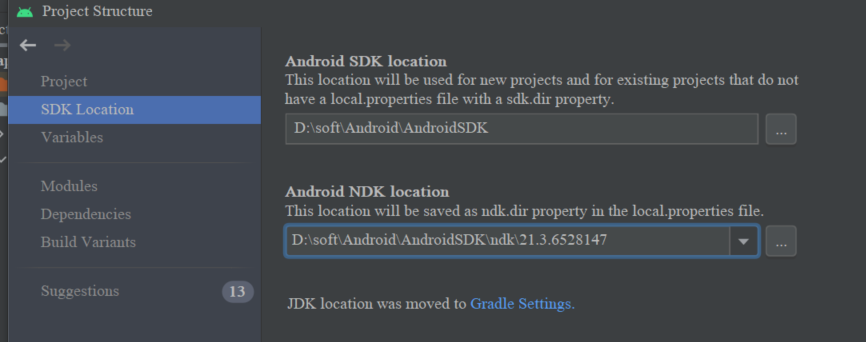

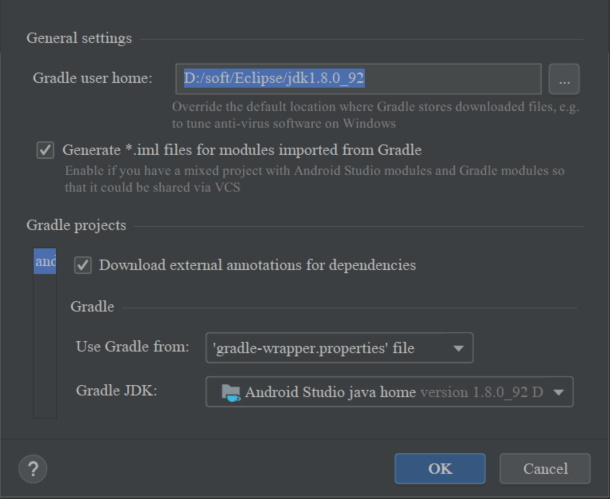

更新完了gradle同步时报错,需要再次设置JDK和NDK的path,打开project manager,找到自己的JDK和NDK目录进行配置。

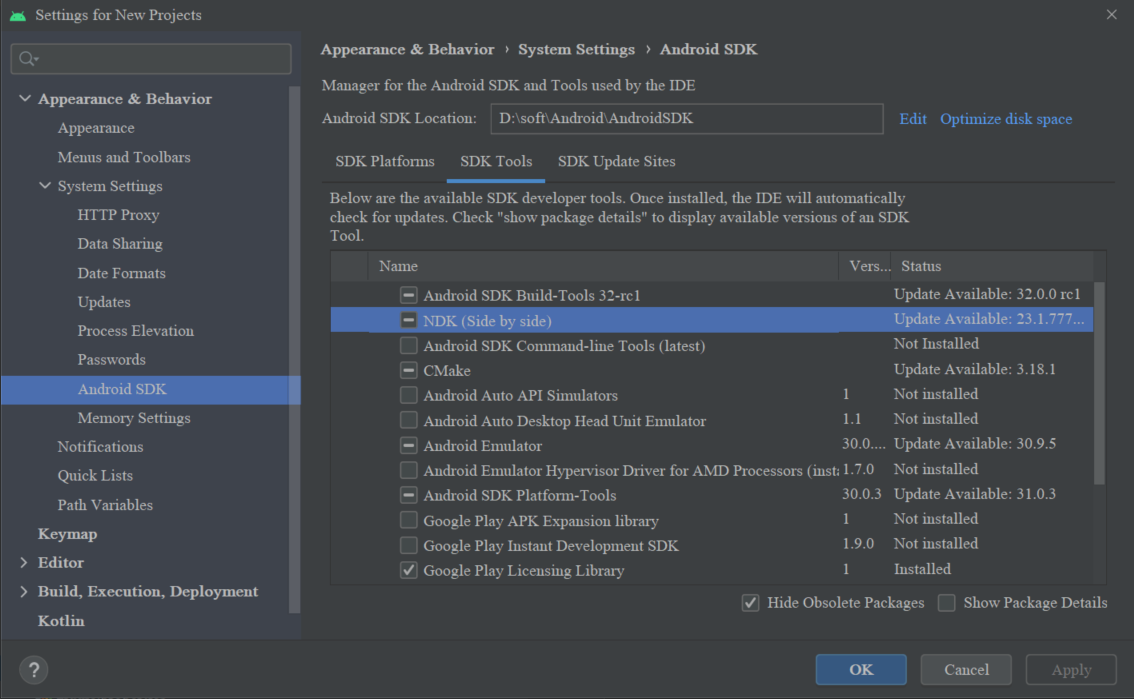

如果没有安装NDK,打开SDK Manager安装

Run App

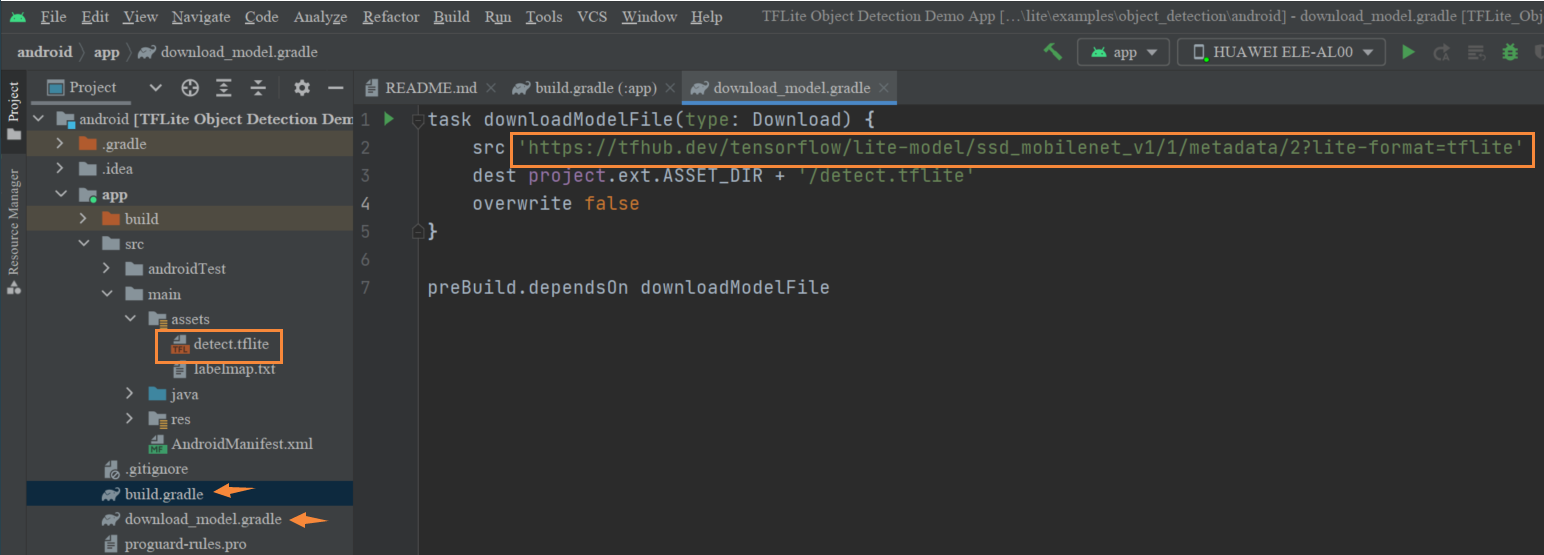

安装App时,要先下载一个目标检测的tflite模型,如果长时间没有响应,可以先自行下载

- 在app文件夹下的download_model.gradle中找到下载地址

- 下载完成后拷贝到assets中,并重命名为“detect.tflite”

- 在app文件夹下build.gradle找到

apply from:'download_model.gradle',注释掉

运行效果

2041

2041

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?