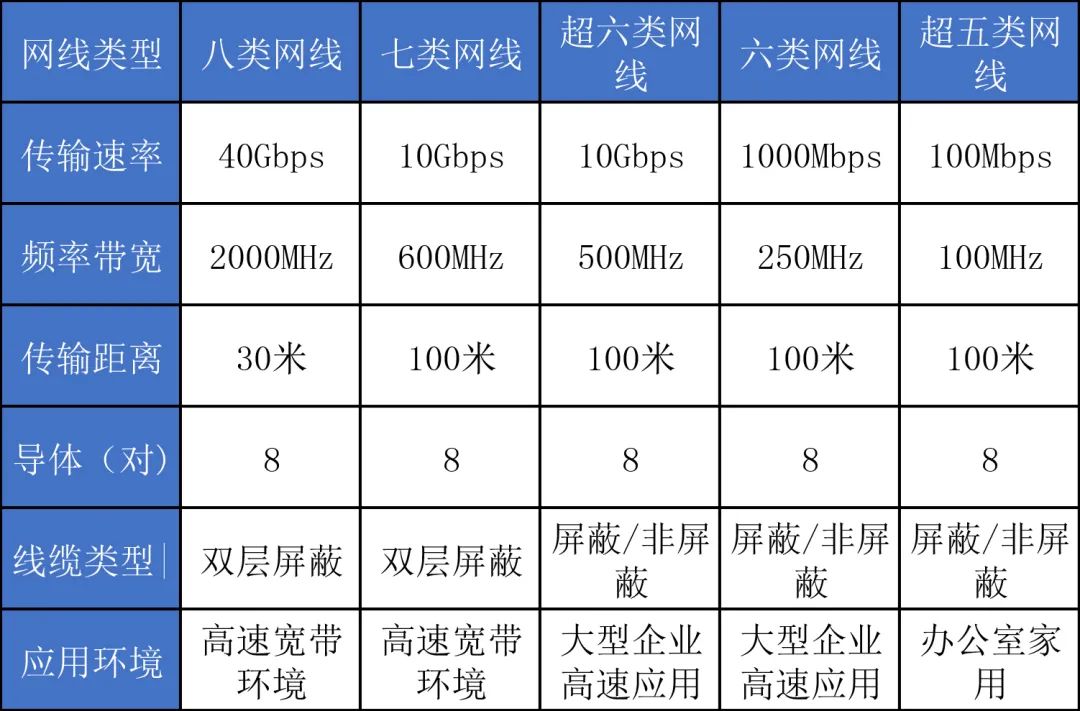

超5类线与6类线的属性对比

为什么6类线比超5类线的传输速率快?这是个好问题,做很多项目时,我们都有个错觉,觉得超超5类线与6类线区别不大,6类线与超5类线的区别在那里。

五类线(CAT5):

传输频率为100MHz,用于语音传输和最高传输速率为100Mbps的数据传输,主要用于100BASE-T和10BASE-T网络。这是最常用的以太网电缆,该类电缆增加了绕线密度,外套一种高质量的绝缘材料,现在5类线基本上用的不多了。

超五类线(CAT5e):

传输频率为100MHz,主要用于百兆或千兆位以太网(千兆比较勉强,标准的线才能达到)。具有衰减小,串扰少,并且具有更高的衰减与串扰的比值(ACR)和信噪比(StructuralReturn Loss)、更小的时延误差,性能得到很大提高。实际项目中,超五类线虽然也能传千兆,但只建议短距离传千兆使用,长距离传输千兆可能会出现不稳定的情况,这也是项目中常出现的故障,而又容易忽略的问题。

六类线(CAT6):

传输频率为250MHz,最适用于传输速率高于1Gbps的应用,主要用于千兆位以太网(1000Mbps)。六类双绞线在外形上和结构上与五类或超五类双绞线都有一定的差别,不仅增加了绝缘的十字骨架,将双绞线的四对线分别置于十字骨架的四个凹槽内,而且电缆的直径也更粗。

超六类或6A(CAT6A):

传输频率是500 MHz,最大传输速度也可达到1000 Mbps,主要应用于千兆位网络中。超六类线是六类线的改进版,同样是ANSI/EIA/TIA-568B.2和ISO 6类/E级标准中规定的一种非屏蔽双绞线电缆,在串扰、衰减和信噪比等方面有较大改善。

七类线(CAT7):

传输频率至少可达600 MHz,传输速率可达10 Gbps,它主要为了适应万兆位以太网技术的应用和发展。该线是ISO 7类/F级标准中最新的一种屏蔽双绞线。

超5类线与6类线的区别

区别一:

损耗的不同,六类线和超五类网线一个重要的不同点是改善了串扰及回波损耗方面的性能。家庭装修建议直接使用六类网线。

区别二:

线芯的粗细不同,超五类网线的线芯在0.45mm~0.51mm之间,六类网线的线芯在0.56mm~0.58mm之间,外观上六类网线要比超五类网线粗很多;

区别三:

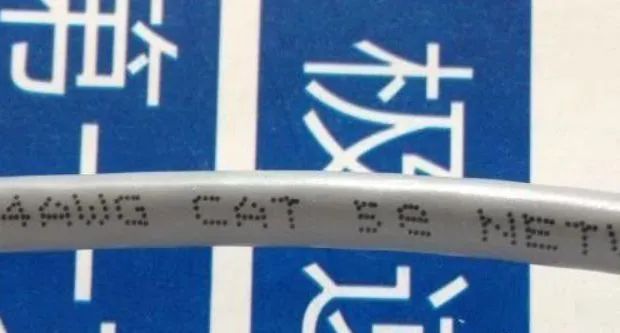

线结构不同,超五类网线的外表皮有”CAT.5e“的标识,六类网线最明显的就是有“十字骨架”,表皮有“CAT.6”的标识。

虽然超五类非屏蔽双绞线也能提供高达1000Mb/s的传输带宽,但是往往需要借助于价格高昂的特殊设备的支持。

"六类"是指六类非屏蔽双绞线(CAT6)

六类非屏蔽双绞线的各项参数都有大幅提高,带宽也扩展至250MHz或更高。六类双绞线在外形上和结构上与五类或超五类双绞线都有一定的差别,不仅增加了绝缘的十字骨架,将双绞线的四对线分别置于十字骨架的四个凹槽内,而且电缆的直径也更粗。

电缆中央的十字骨架随长度的变化而旋转角度,将四对双绞线卡在骨架的凹槽内,保持四对双绞线的相对位置,提高电缆的平衡特性和串扰衰减。另外,保证在安装过程中电缆的平衡结构不遭到破坏。六类非屏蔽双绞线裸铜线径为0.57mm(线规为23AWG),绝缘线径为1.02mm,UTP电缆直径为6.53mm。当然越粗越好。信号稳定。

超六类线与七类线的区别

01.超六类线:

最高传输频率达500MHz,是六类线的两倍,主要用于万兆(10G)网络,外表皮标注“CAT.6A”,此外,超六类网线支持10G以太网,在外观上会有10Gigabit的类似标识;

6类线有两种,一般单股裸铜丝直径为23AWG,约等于0.573毫米,也有24AWG的6类线,粗度约为0.511毫米。

02.七类线:

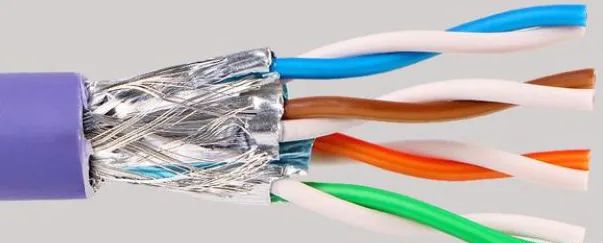

七类线与超六类网线的性能接近,采用纯铜8芯,拥有屏蔽层,性能更加强大,传输速率可以达到10Gbps,用于数据中心等场合。

每对都有一个屏蔽层 (一般为金属箔屏蔽 ),然后8根芯外还有一个屏蔽层(一般为金属编织丝网屏蔽Braided Shield),接口与RJ-45相同。总屏蔽(一般为金属编织丝网屏蔽)+ 线对屏蔽(一般为金属箔屏蔽) 七类线 S/FTP Cat.7(HSYVP-7) 最高传输频率 600MHz,超七类线的传输频率为1000MHz,七类完全支持万兆。

七类线线芯使用的是直径近 0.58mm 优质无氧铜为传输导体,比6类线稍粗一点点,选用化学发泡绝缘,极大提高了单根导体传输才能。

从网线的线芯来看,5类线、6类线,7类线,线芯的直径都有所增加,使用的铜质越优质,传输的速率越快,越稳定。

8290

8290

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?