网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

Flink Client -> 一个JobManager(协调调度中心) -> N个TaskManager(工作节点)

多个备用 JobManager

Flink是一个非常灵活的处理框架,它支持多种不同的部署场景,还可以和不同的资源管理平台方便地集成

集群搭建:

集群规划:

| 节点服务器 | hadoop102 | hadoop103 | hadoop104 |

| 角色 | JobManager,TaskManager | TaskManager | TaskManager |

下载解压安装包

eg:flink-1.17.0-bin-scala_2.12.tgz

vim flink-conf.yaml

jobmanager.rpc.address: hadoop102 (rpc连接的地址)

jobmanager.bind-host: 0.0.0.0 (任何机器都可以访问)

rest.address: hadoop102 (Rest Api访问地址)

rest.bind-address: 0.0.0.0

taskmanager.bind-host: 0.0.0.0

taskmanager.host: hadoop102 (不同服务器配置相应的ip)

还可更改

jobmanager.rpc.port:6123

jobmanager.memory.process.size:48g (jobmanager进程可使用的全部内存,包括JVM和其他开销,默认1600M)

taskmanager.memory.process.size:8g (taskmanager进程可使用的全部内存,包括JVM和其他开销,默认1728M)

taskmanager.numberOfTaskSlots: 24 (对每个taskmanager能够分配的slot数量进行配置,默认1,可根据cpu进行决定)

parellelism.default: 8 # 并行数量,默认1,优先级低于代码中进行的并行度配置

high-availability: zookeeper

high-availability.storageDir: ftp://sjsy:chianoly@139.6.0.224:6600/flink/ha/

high-availability.zookeeper.quorum: zk01:2181,zk02:2181,zk03:2181

jobmanager.execution.failover-strategy: region

#历史服务器

jobmanager.archive.fs.dir: ftp://sjsy:chianoly@139.6.0.224:6600/flink/completed-jobs/

historyserver.web.address: 0.0.0.0

historyserver.web.port: 8082

historyserver.archive.fs.dir: ftp://sjsy:chianoly@139.6.0.224:6600/flink/completed-jobs/

heartbeat.timeout: 180000

akka.ask.timeout: 60s

web.timeout: 1000000

state.checkpoints.num-retained: 3

vim workers

hadoop102

hadoop103

hadoop104

vim masters(jobmanager)

hadoop102:8081

//可以多个

hadoop105:8081

hadoop106:8081

...

命令行启动(也可以手动上传)

1 上传

2

bin/flink run -m hadoop102:8081 -c com.chinaoly.wc.WordCountStream ./FlinkTutorial-1.17-1.0-SNAPSHOT.jar

-m :后面跟 jobmanager的ip端口

-c : 后面跟全类名

最后,相对路径或者绝对路径

部署模式

会话模式(Session Mode

单作业模式(Per-Job Mode)

应用模式(Application Mode)

会话模式(Session Mode)

最符合常规思维,我们先启动一个集群,保持一个会话,在这个会话中通过客户端提交作业。

集群启动时所以资源都已经确定,所以所有提交的作业会竞争集群中的资源。

会话模式比较适用于: 单个规模小,执行时间短的大量作业

单作业模式(Per-Job Mode)

会话模式因为资源共享会导致很多问题,所以为了更好地隔离资源,我们可以考虑为每个提交的作业启动一个集群,这就是所谓的单作业模式

作业完成后,集群就会关闭,所以资源也会释放

这些特性使得单作业模式在生产环境运行中更加稳定,所以是 实际应用的首选模式

需要注意:Flink本身无法直接这样允许,所以单作业模式一般需要借助一些资源管理框架来启动集群,比如 YARN,Kubernates(K8S)

应用模式(Application Mode)

前面提到的两种模式下,应用代码都是在客户端执行,然后由客户端提交到JobManager的。但是这种方式客户端需要占用大量网络带宽,去下载依赖和把二进制数据发送给JobManager;加上很多情况下我们提交作业用的是同一个客户端,就会加重客户端所在节点的资源消耗。

所以解决方法是: 我们不要客户端了,直接把应用提交到JobManager上运行。 而这也就代表着,我们需要为每一个提交的应用单独启动一个JobManager,也就是创建一个集群。这个JobManager只为执行一个应用而存在,执行结束后JobManager也就关闭了。这就是所谓的应用模式。

应用模式与单作业模式,都是提交作业后才创建集群;单作业模式是通过客户端来提交的,客户端解析出的每一个作业对应一个集群;而应用模式下,是直接由JobManager执行应用程序的。

运行模式

standalone运行模式

yarn运行模式

K8S运行模式

独立(Standalone)运行模式

独立模式是独立运行的,不依赖任何外部的资源管理平台;当然独立也是有代价的: 如果资源不足,或者出现故障,没有自动扩展或重分配资源的保证,必须手动处理,所以独立模式一般只使用在开发测试或者作业非常少的情景下。

此模式Flink自己管理资源

比如页面提交运行,打包成一个完成的jar,命令运行等。

| 会话模式 | 支持,默认 |

| 单作业模式 | 不支持,单作业模式需要借助一些资源管理平台 |

| 应用模式 | 可是实现,应用模式下不会提前创建集群,所以不能调用start-cluster.sh脚本。我们可以使用同样在bin目录下的standalone-job.sh来创建一个JobManager |

启动/停止,参考standalone脚本

Yarn运行模式(重点)

yarn上部署过程: 客户端把flink应用提交给yarn的ResourceManager,Yarn的ResourceManager会启动ApplicationMaster,ApplicationMaster会向ResourceManager注册,申请NodeManager申请资源和容器,并且监控;这些容器上,Flink会部署JobManager和TaskMAnager的实例,从而启动集群。

Flink会根据运行在JobManager上的作业所需要的Slot数量动态分配TaskManager资源

注意:确保安装hadoop,至少在2.2版本以上,并且集群中由HDFS服务

flink和hadoop的依赖集成,配置,加上

sudo vim /etc/profile.d/my_env.sh

HADOOP_HOME=/opt/moduae/hadoop-3.3.4

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

# flink需要的

export HADOOP_CONF_DIR=${HADOOP_HOME}/etc/hadoop

export HADOOP_CLASSPATH=`hadoop classpath`

source /etc/profile.d/my_env.sh

Yarn的运行模式需要先申请一个YARN会话(Yarn Session)来启动Flink集群

bin/yarn-session.sh -nm mytest

查看可以使用的参数

bin/yarn-session.sh --help

-d: 分离模式,如果不想让Flink YARN客户端一致前台运行,可以使用这个参数,即后台运行

-j: 指定jar包

-jm(-jobManagerMemory): 配置JobManager所需内存,默认单位MB

-nm(-name): 配置在YARN UI界面上显示的任务名

-qu: 指定Yarn队列

-tm(-taskManagerMemory): 配置TaskManager所需内存,默认单位MB

在hadoop里查看任务,hadoop里代理了端口,此处进入

注意:yarn模式会自动覆盖flink配置信息

Session部署模式

bin/flink run -c com.全类名.WordCount lib/FlinkTutorial-1.17-1.0-SNAPSHOT.jar

关闭

1 去yarn的WebUi页面关闭

2 启动的时候会打印

echo "stop" | ./bin/yarn-session.sh -id application_2322223334_003(yarn页面的应用id)

Per-job部署模式(标记为过时,但还能用)

启动

bin/flink run -d -t yarn-per-job -c lib/com.全类名.WordCount FlinkTutorial-1.0-SNAPSHOT.jar

查看

bin/flink list

bin/flink list -t yarn-per-job -Dyarn.application.id=application_XXX_YY

取消/停止(页面也可以停止)

bin/flink cancel -t yarn-per-job -Dyarn.application.id=application_XXX_YY <jobId>

注意:application_XXX_YY 是当前应用的ID,<jobId>是作业的id,如果取消作业,这个Flink集群也会停止

如果报错,但不影响

Trying to access closed classloader...

解决方法:

flink-conf.yml中配置:

classloader.check-leaked-classloader: false

WebUI访问:

http://hadoop102:8081/

脚本

停止运行

bin/stop-cluster.sh

查看

xcall jps

jps

standalone模式脚本

standalone模式下运行,需要把jar包放到lib下面

bin/standalone-job.sh start --job-classname com.chinaoly.SocketStreamWordCount

停止standalone

bin/standalone-job.sh stop

taskmanager脚本

启动taskmanager

bin/taskmanager.sh start

停止taskmanager

bin/taskmanager.sh stop

yarn运行模式脚本

session部署模式

bin/flink run -c com.全类名.WordCount lib/FlinkTutorial-1.17-1.0-SNAPSHOT.jar

per-job部署模式

**既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!**

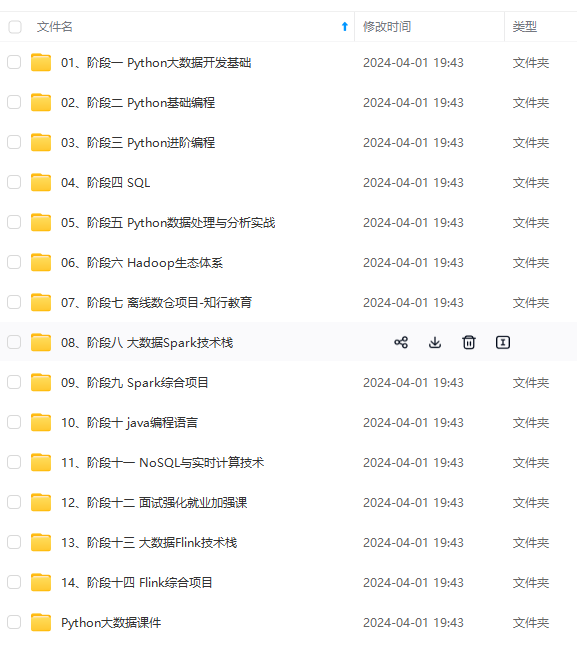

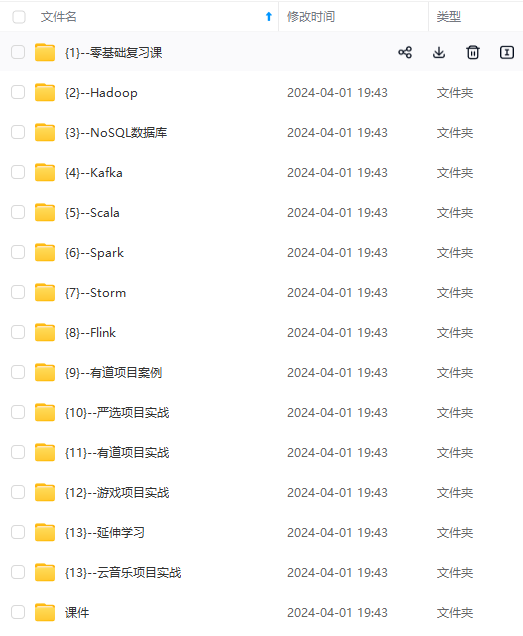

**由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新**

**[需要这份系统化资料的朋友,可以戳这里获取](https://bbs.csdn.net/topics/618545628)**

jar

per-job部署模式

[外链图片转存中...(img-7bX8L9Xm-1715794191013)]

[外链图片转存中...(img-E3ZY7IpC-1715794191014)]

[外链图片转存中...(img-FnUjG3SD-1715794191014)]

**既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!**

**由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新**

**[需要这份系统化资料的朋友,可以戳这里获取](https://bbs.csdn.net/topics/618545628)**

935

935

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?