第三章 线性代数

以下内容为第 6 节“矩阵运算:数字的编织术”。本节将基于前面关于向量的运算和概念,进一步探讨矩阵的基本运算规则及其几何含义,并通过经典与现代 AI 场景中的案例展示矩阵运算如何在数据处理、建模与推理中扮演关键角色。

6 矩阵运算:数字的编织术

在向量空间中,如果说向量是“方向”的抽象,那么矩阵则是“变换”的核心表达。矩阵能将多个向量有序地组合在一起,也能被视为一种对空间进行映射(transformation)的算子。我们可以把矩阵想象成“数字的编织机”:它将一行行或一列列数字(向量)编织起来,通过各种运算实现对高维空间的映射、变形、压缩或拉伸。

本节将介绍矩阵加法、数乘、转置、乘法、逆矩阵等基本运算,并结合人工智能与数据科学的应用示例,让读者更直观地感受这些运算在实际场景中的重要性。

6.1 矩阵加法与数乘

6.1.1 矩阵加法

案例:图像像素矩阵的叠加

在计算机视觉中,彩色图像通常可以表示为三个通道(RGB)的矩阵或张量。当我们想将一幅图像中的像素亮度与另一幅相同尺寸的滤波矩阵叠加时,就会对这两个矩阵进行对应位置的加法运算。比如,为了实现简单的亮度提升,可以将原图像的矩阵 I 与一个常数矩阵 C(每个元素都为某个固定亮度值)相加,从而得到一幅“更亮”的新图像。

6.1.2 矩阵的数乘

案例:突显/削弱特征权重

在机器学习的特征工程中,经常需要对某些特征矩阵(如某类特征在输入数据集中的分布矩阵)进行放大或缩小,以突出或削弱其影响。通过选择合适的数乘因子,可以快速地对特征做线性缩放,从而帮助模型更好地捕捉模式或减少噪声。

6.2 矩阵的转置

6.2.1 定义与几何意义

几何意义

对于 2×2 或 3×3 矩阵,转置在某种程度上可以理解为对“行向量”和“列向量”进行互换操作。有时也可视为对坐标轴进行一定的“翻转”或“反射”,在更多情况下是对矩阵结构的重排。

6.2.2 案例:协方差矩阵在机器学习中的应用

在机器学习的统计分析中,数据集的协方差矩阵 Σ 是对各个特征之间相关性的一个度量。由于协方差矩阵本身是对称矩阵(即 ),它的转置与自身相等,体现了特征两两相关所具有的对称性。在实际中,我们时常利用对称矩阵的属性(如特征值皆为实数,可对其进行特征分解等)来完成降维、白化(whitening)等操作。

6.3 矩阵乘法

矩阵乘法是最核心的矩阵运算之一,它赋予了矩阵将一个向量或另一个矩阵“变形”或“映射”的能力,也是所有线性变换和线性系统分析的基础。在 AI 算法中,矩阵乘法尤其重要,因为它广泛应用于神经网络的前向传播和反向传播、图像卷积(在本质上可以看成“局部”矩阵乘法)等计算过程中。

6.4 逆矩阵与可逆性

6.5 特殊矩阵与常用运算

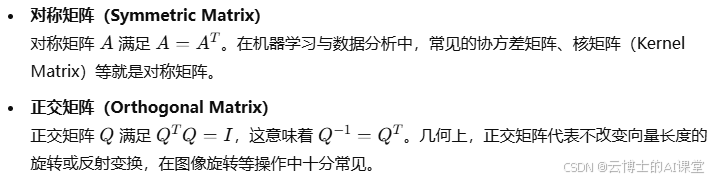

6.5.1 对称矩阵与正交矩阵

6.5.2 分块矩阵操作

在处理大型数据时,为了提高计算效率,我们经常把矩阵分割为若干子块来进行运算(例如块状矩阵乘法)。这在分布式机器学习或大规模矩阵计算中非常有用。

案例:并行计算中的块矩阵

在深度学习训练中,尤其是分布式训练方式里,大型的权重矩阵会被分割成多个子块放到不同的设备中进行并行运算,最后再将结果合并。这种思想在矩阵乘法、矩阵分解等场合都能显著提升效率。

6.6 小结与展望

本节介绍了矩阵的基本运算与核心概念,包括矩阵的加法、数乘、转置、乘法、逆矩阵等。矩阵作为一种强大的线性映射工具,在 AI 中无所不在:从最基本的线性回归到深度神经网络,从图像变换到协方差分析,矩阵为我们提供了高效的结构化表示和变换手段。

在后续的章节中,我们将深入讨论与矩阵运算相关的更高级主题,比如特征值分解(Eigendecomposition)、奇异值分解(SVD)、主成分分析(PCA)和张量分解等。它们都是构建在矩阵运算的基础之上,并在现代数据分析和机器学习中起到至关重要的作用。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?