前文已经部署好了Ollama,今天我们来体验一下,安装AnythingLLM调用我们的模型,来搭建本地的知识库。

AnythingLLM 是最容易使用的一体化 AI 应用程序,可以执行 RAG、AI 代理等,而无需代码或基础设施问题。

为什么使用 AnythingLLM?

如果你希望将本地 LLM、RAG 和 AI 代理的零设置、私有和一体化 AI 应用程序集中在一个地方,而无需开发人员进行繁琐的设置。

或

如果你需要为您的企业或组织提供一个完全可定制的、私有的、多合一的 AI 应用程序,它基本上是一个具有权限的完整 ChatGPT,但具有任何 LLM、嵌入模型或矢量数据库。

那么,你可以尝试看看~~~~

1、安装AnythingLLM

AnythingLLM | The all-in-one AI application for everyone![]() https://anythingllm.com/

https://anythingllm.com/

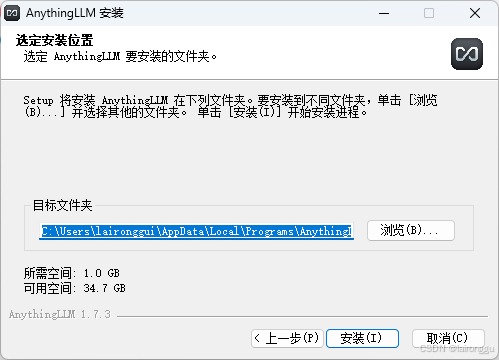

去官网下载安装包,双击安装即可,该软件支持自定义安装路径。

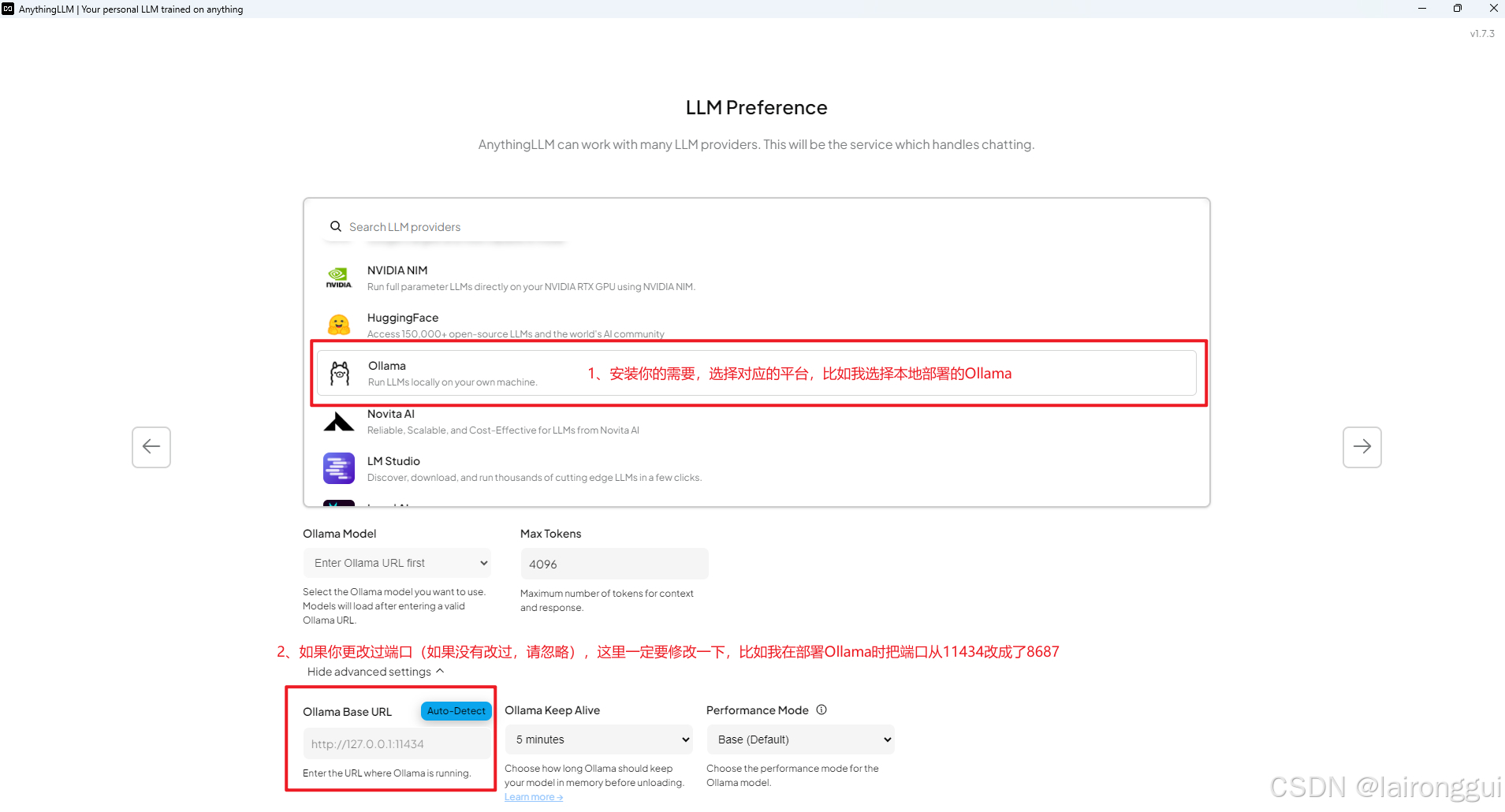

2、打开软件进行相关设置

双击桌面快捷方式,开始按照向导点击 Get Started, 按向导进行相关的设置即可。

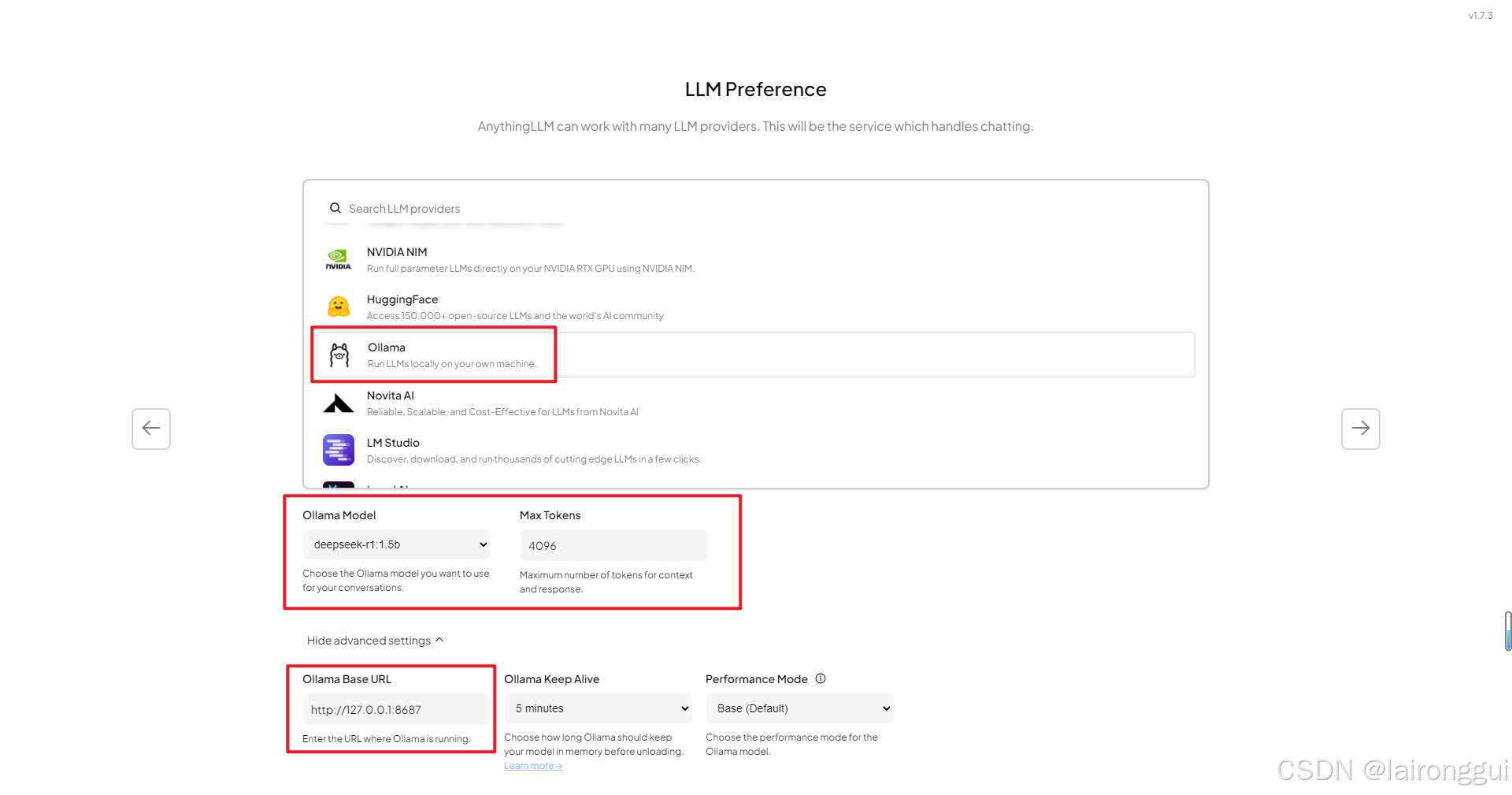

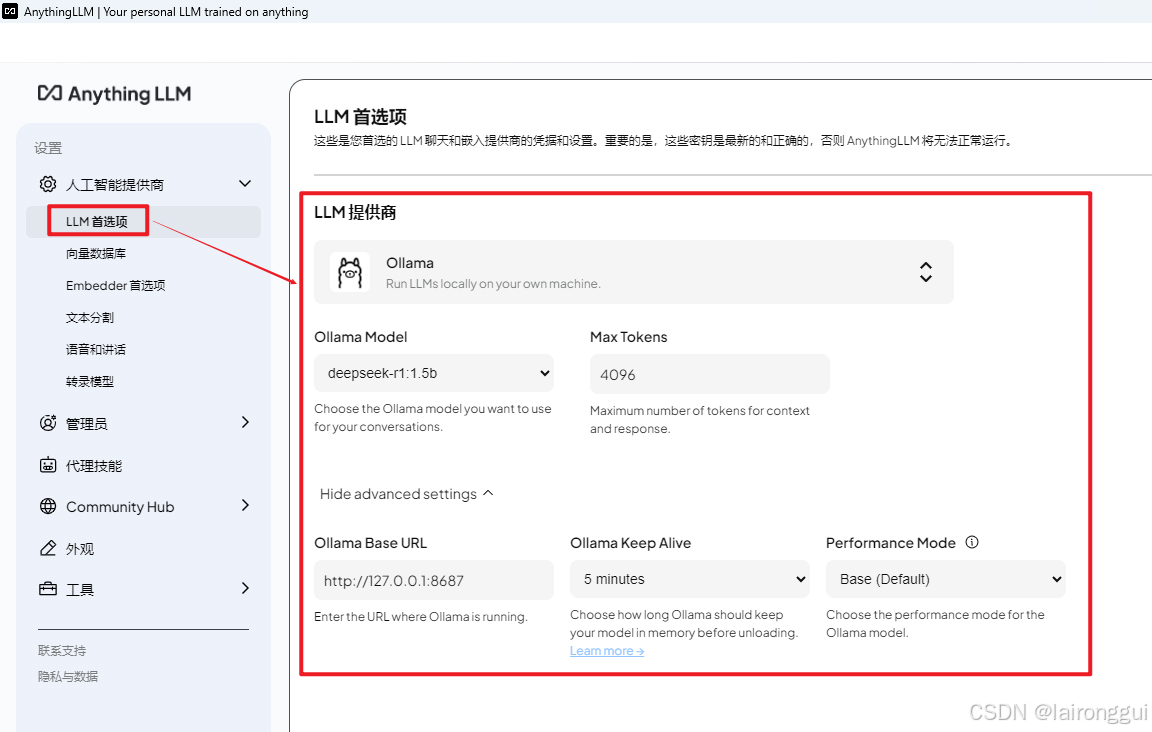

如下图,选择本地的Ollama,如果修改过端口,记得调整一下IP和端口,才能选择模型

下图为我设置的参数,供参考:

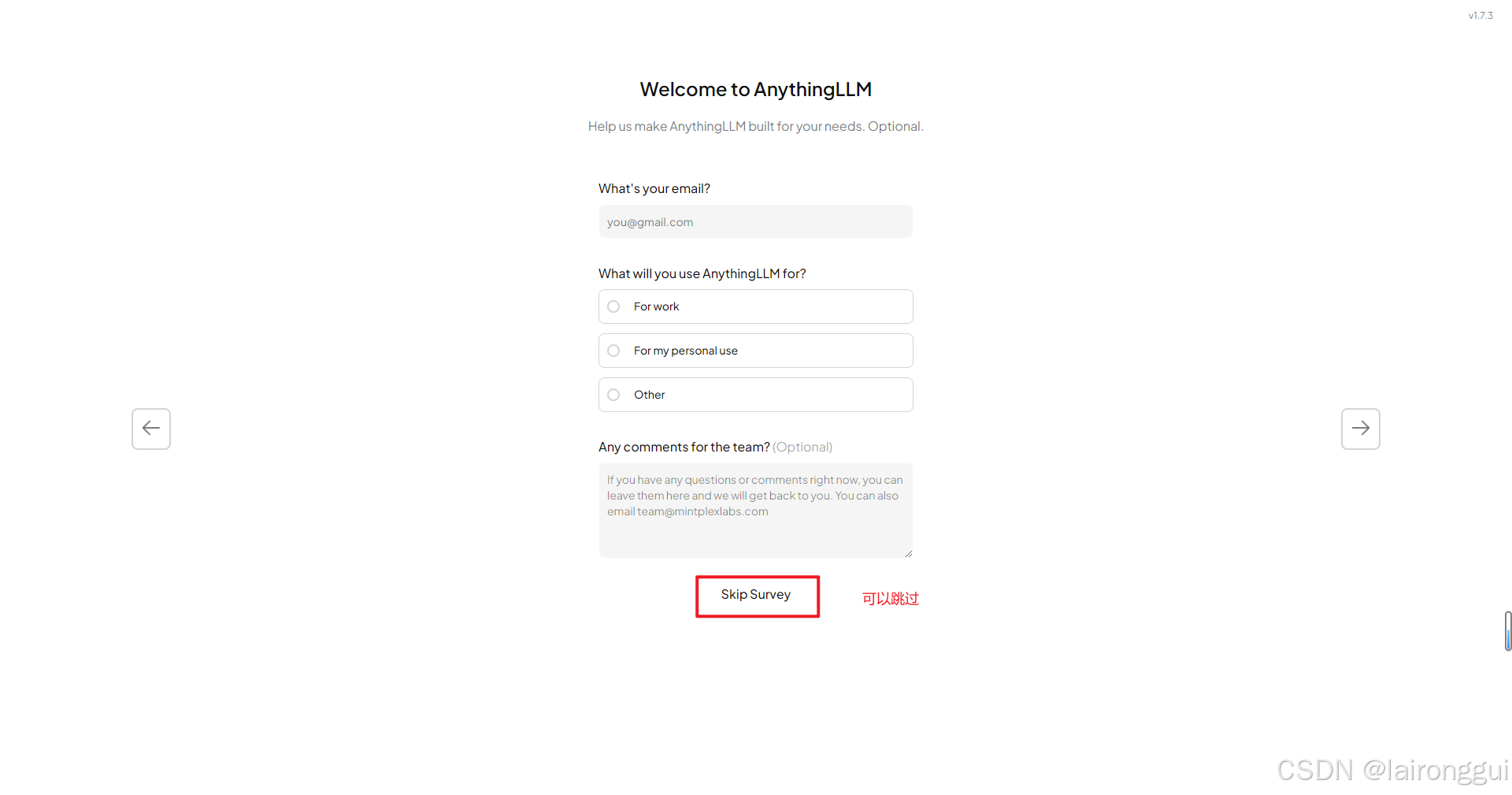

然后默认下一步,最后那步可以不填,可以跳过:

3、设置工作区名称,以及系统参数设置

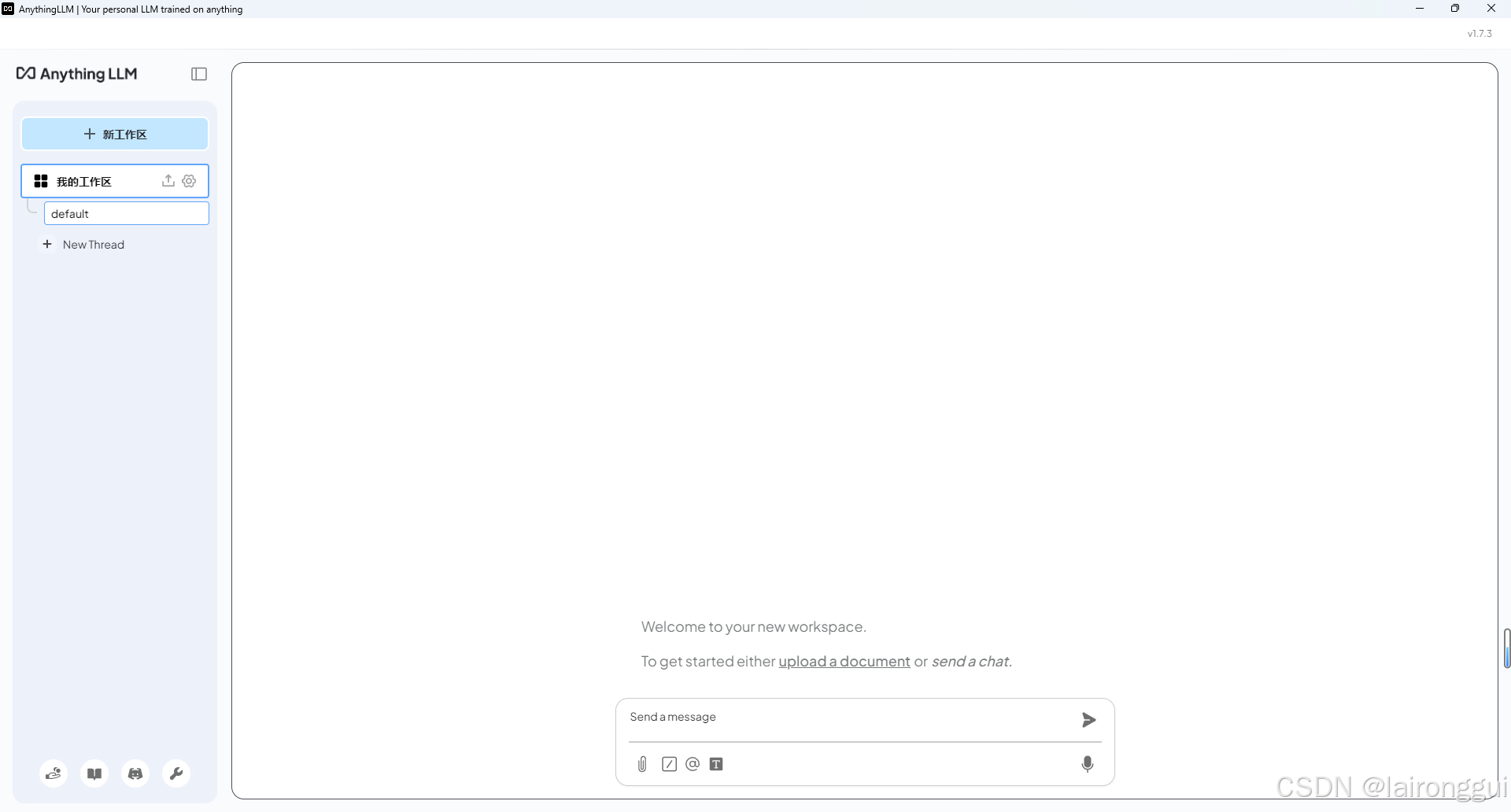

3.1 进入软件,弹窗填写第一个工作区名称,可以按照你自己的习惯填写

设置完工作区以后,进图看到如下界面:

3.2 系统参数设置

点击左下角,小齿轮按钮,进行参数设置

3.2.1 首选项参数检查一下,就是一开始安装时填的参数是否正确

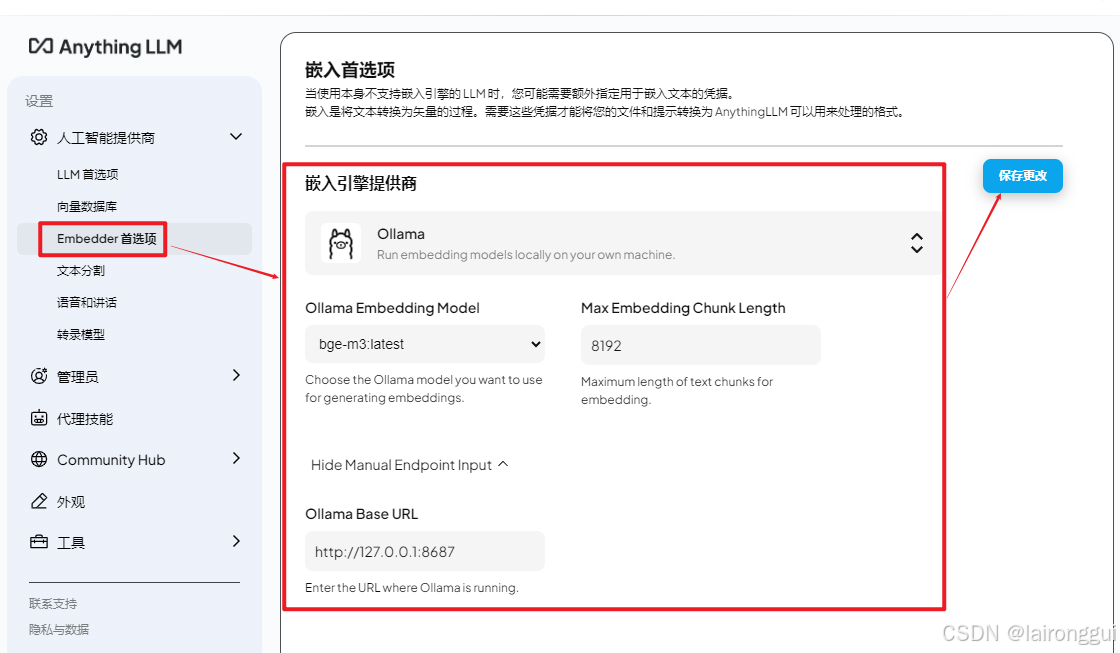

3.2.2 Embedder首选项,一定要修改为嵌入式的模型

如下图,我选择了我本地部署的bge-m3,保存更改

3.2.3 外观中文显示修改

至于其他参数,大家自己按需调整即可。

设置完以后,返回:

4、工作区设置

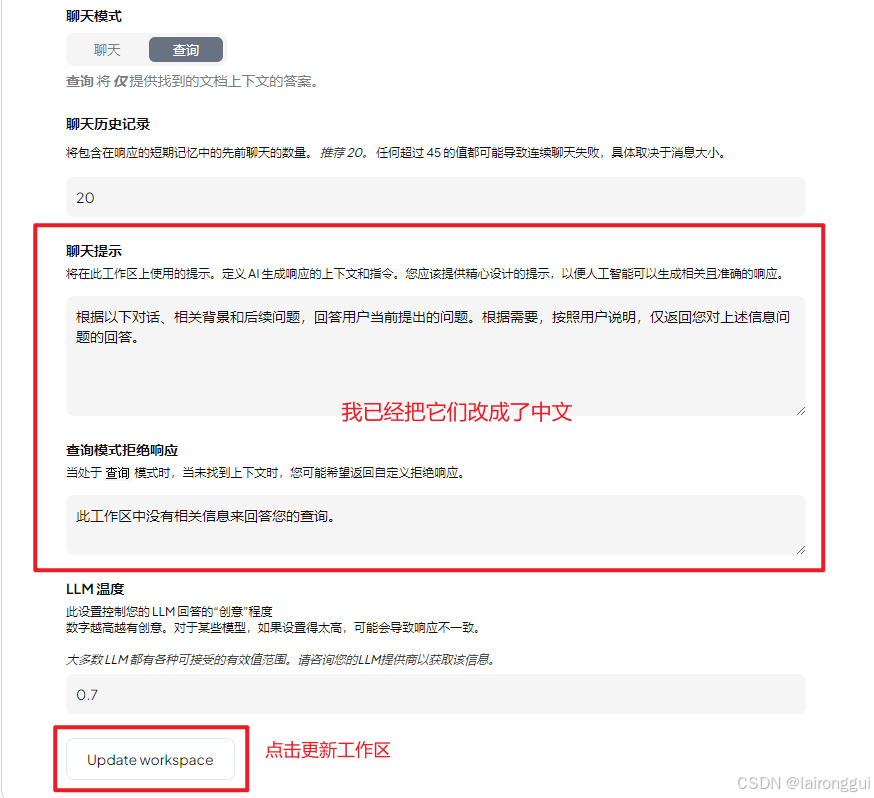

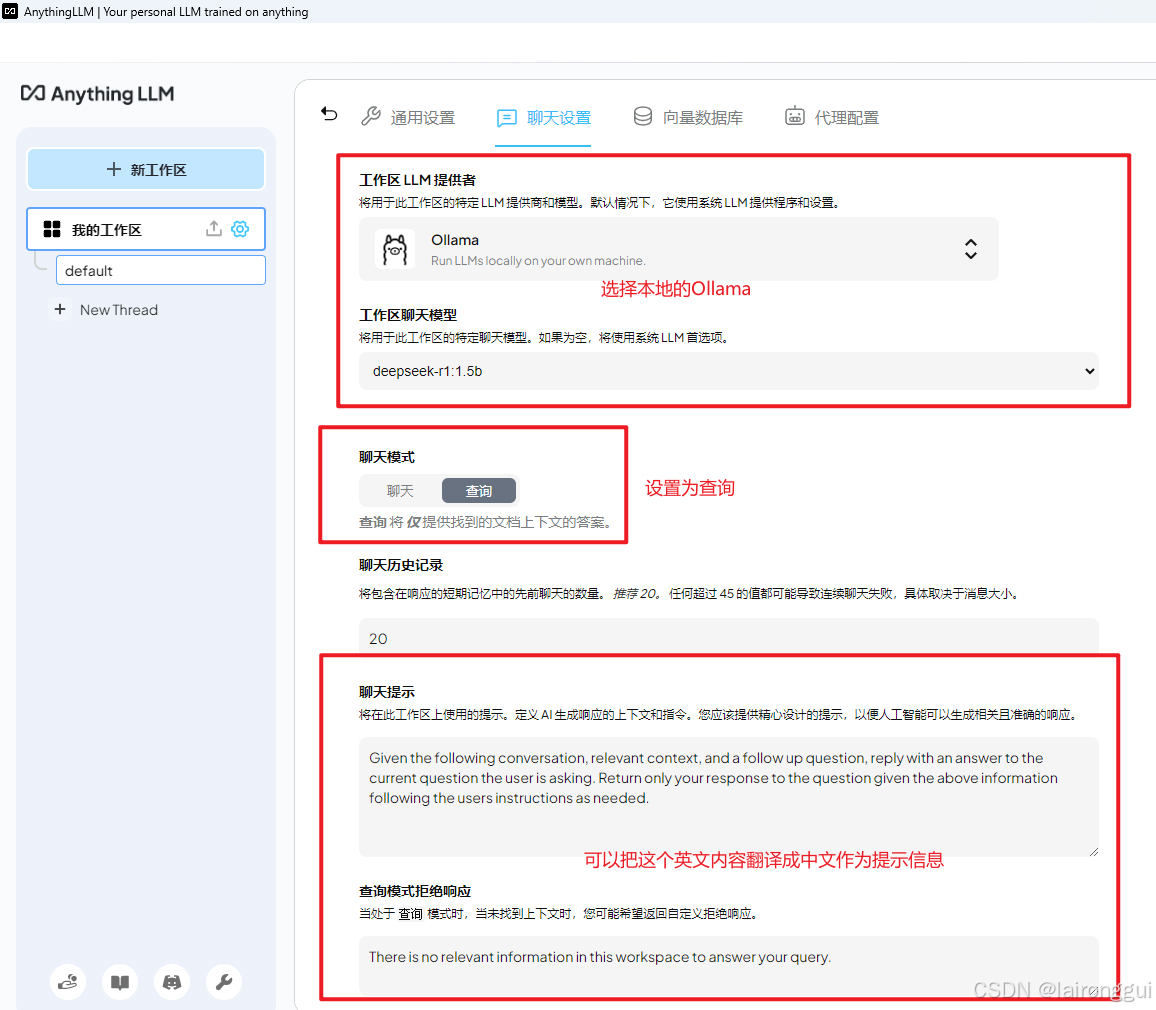

点击左侧我的工作区边上的小齿轮按钮,找到聊天设置,如果选择本地的Ollama,并将聊天模式设置为查询,同时可以将聊天提示的信息翻译成中文来展示。

拖到最底下,点击 更新工作区 按钮即可。

5、添加知识库文本文件

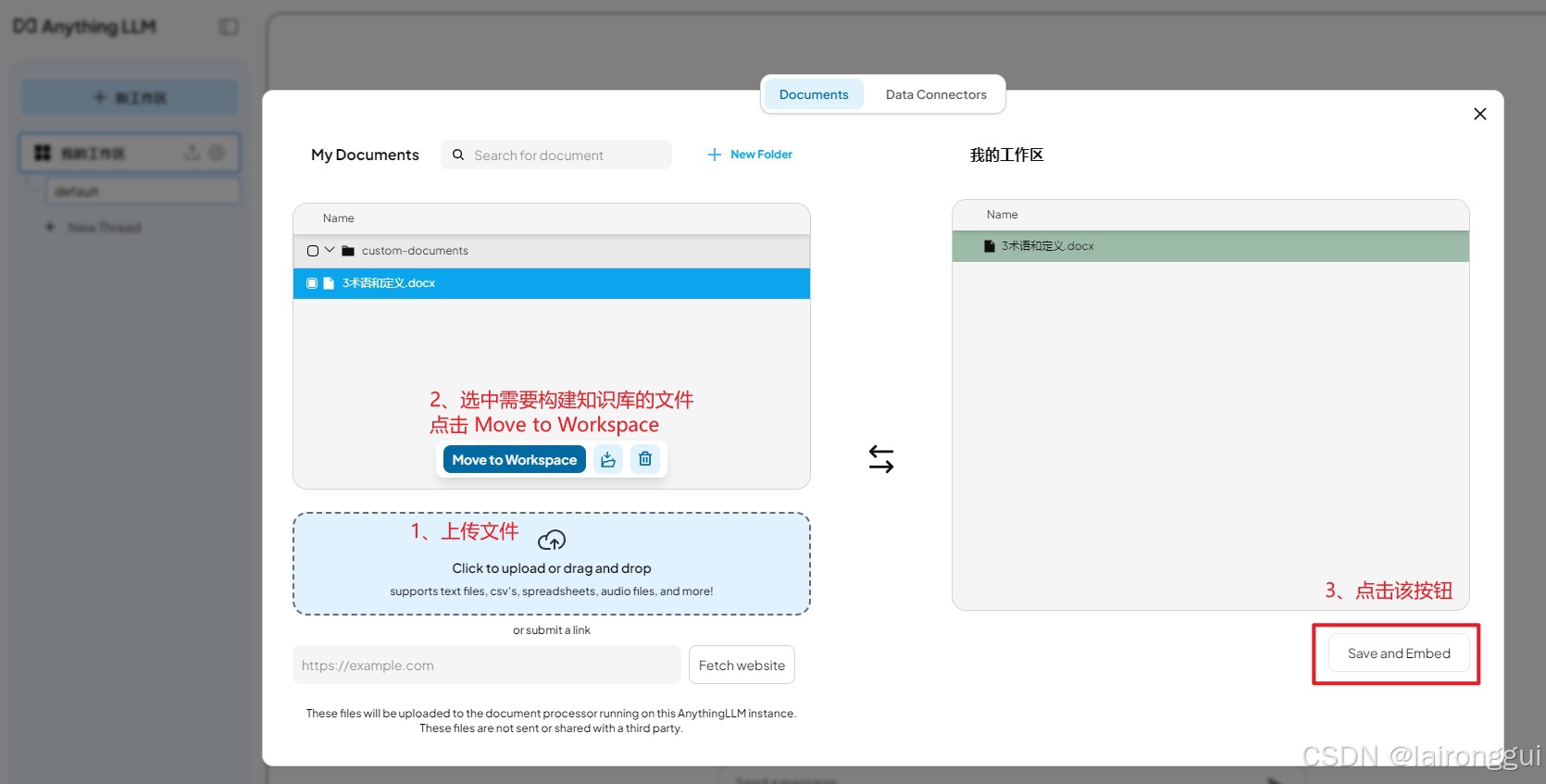

点击我的工作区齿轮按钮坐标的上传按钮,弹出下图窗口,上传文件,选中并移动到工作区,嵌入即可。

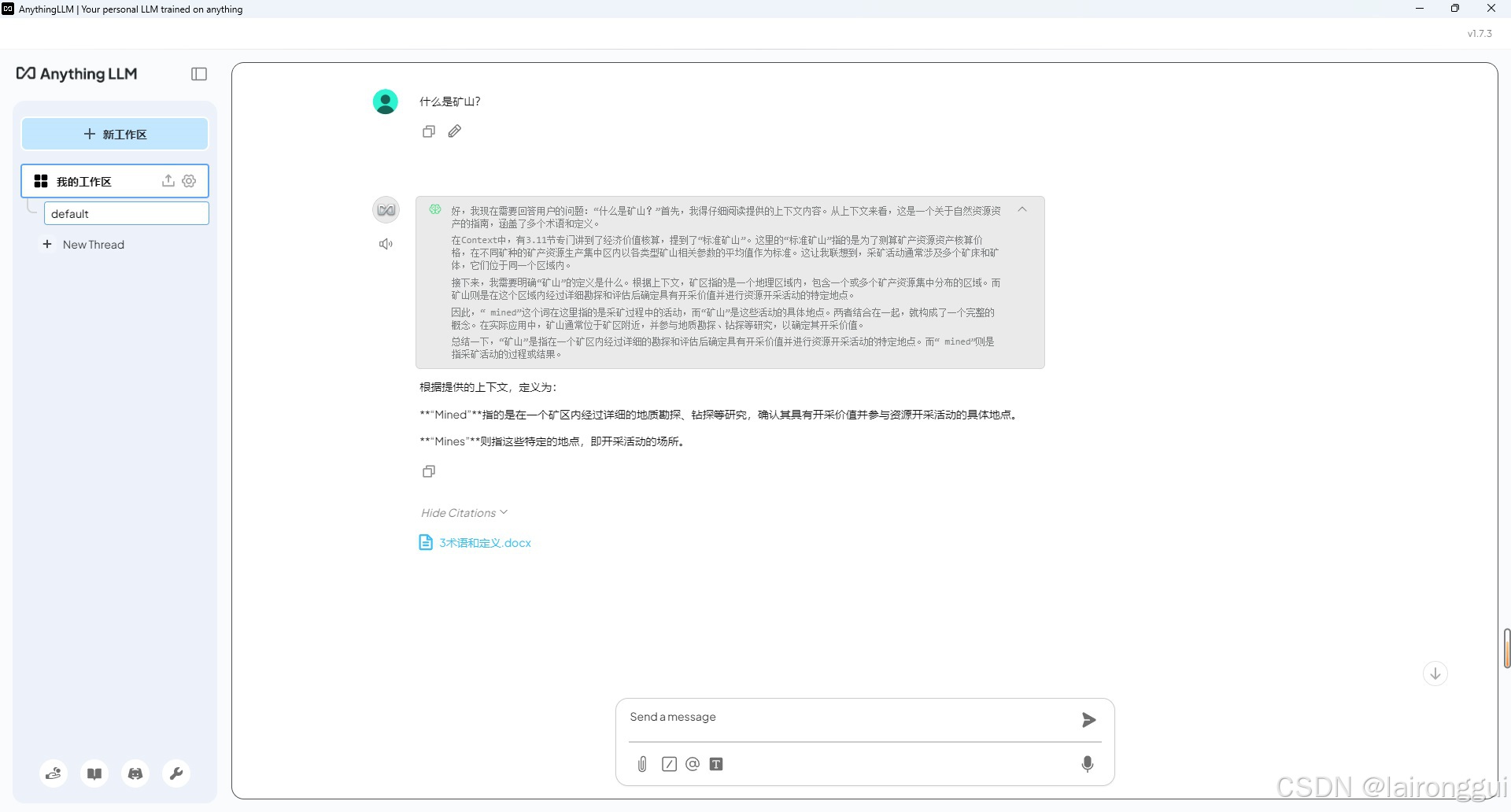

6、开始查询测试

OK,基本完成!细化的功能,就需要进一步研究了~~加油!

1652

1652

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?