这是关于模型压缩的一篇文章,文章提出了一个压缩深度神经网络的三步走pipline:剪枝,量.化和霍夫曼编码

1、剪枝:

因为这是篇2016年的文章,所以剪枝方法比较粗暴:直接删除阈值低于某一值的连接,再进行下fine-tuning,这种剪枝方法能压缩近十倍的model size,但笔者对这种剪枝方法能否胜任新近的网络(DenseNet等)的剪枝任务存疑,因为这种剪枝方法的基于的理论是:绝对值小的weights不重要,绝对值越大的weights越重要。这理论在冗余的网络中,比如AlexNet和VGG16中可行,但是在其他精细化构造的网络中是否可行就要打一个?了。

2、量化:

这是这篇文章的重点,也可以说是创新点。量化体现在两个方面,一是对weights的values(包括weights和gradients)的量化共享,而是对weights的index的量化共享。见下图:

文章的创新点在:

1、存储weights的index时候存储他们的diff而不是原来的值,且diff超过8的value会被置0以防overflow。

2、量化weights的values时先进行k-均值聚类,同一类的值会进行相同的更新,更新值也一样

这样的方法也显得有点简单粗暴:相同的bins同时更新会导致在量化的retrain过程中单个权重的颜色属性不会改变,可能导致精度下降。

3、霍夫曼编码

这个步骤可以节约20%——30%的内存,但取决于weights的分布。

4、讨论

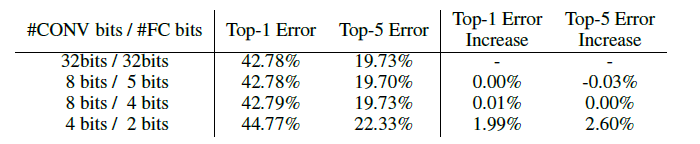

文章中主实验对conv层用了8位量化,对fully-connected层用了5位量化,得出的网络没有精度损失。也做了其他的对比实验,有个有趣的现象是对conv层用4位量化+对fully-conected层用2位量化并不会过多地损失精度。所以改进的方向可以在这方面入手:优化量化方式。

5、总结

这篇文章更偏重于应用,但值得改进的地方还有很多。随着越来越多的冗余度越来越小的紧凑型网络的提出,这篇文章所提出的方法将会不再适用。但其量化index方式仍然会是个散光点。

3万+

3万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?