pyspark本地环境配置教程配置成功后,可以通过spark dataframe笔记练习pyspark的用法,不过最好是通过spark官网练习语法使用。下面写个小案例,供自己以后查阅:

#!/usr/bin/python

# -*- coding: utf-8 -*-

"""

@author:

@contact:

@time:

"""

from __future__ import print_function

from pyspark.sql import SparkSession

import os, time

if __name__ == "__main__":

# 设置spark_home环境变量,路径不能有中文、空格

os.environ['SPARK_HOME'] = "E:/data_page/spark-2.0.2-bin-hadoop2.7"

# 运行在本地(local),2个线程,一行写不完换行时用“\”

spark = SparkSession.builder\

.appName("test")\

.master("local[2]")\

.getOrCreate()

# 如果想看函数源码,可以通过ctrl+点击函数的形式跳转到函数详情界面

datas = ["hi I love you", "hello", "ni hao"]

sc = spark.sparkContext

rdd = sc.parallelize(datas)

# 查看数据类型 type()

print(type(datas))

print(type(rdd))

#获取总数,第一条数据

print(rdd.count())

print(rdd.first())

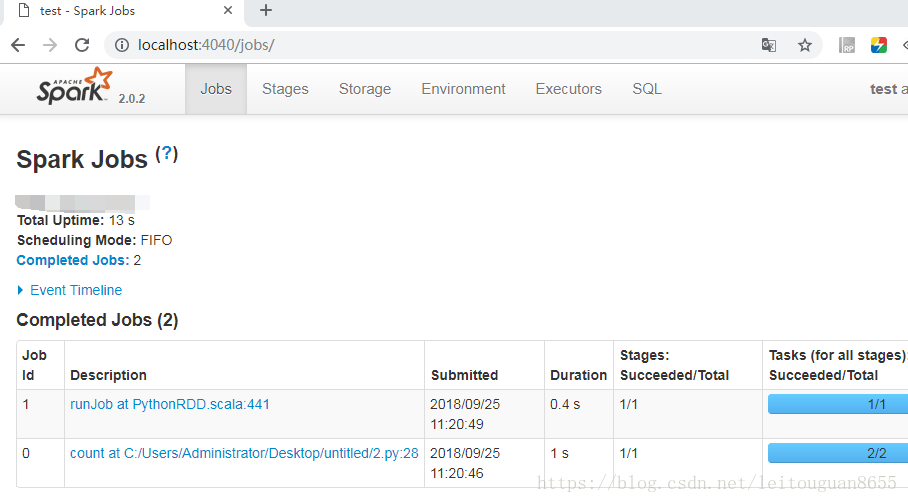

# 每个spark运行会有一个监控界面(WEB UI4040),为了监控,让线程休眠一段时间,然后打开localhost:4040页面

time.sleep(100)

spark.stop()

打印的结果如下:

<type 'list'>

<class 'pyspark.rdd.RDD'>

3

hi I love you

localhost:4040界面如下:

855

855

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?