定义:Apache Spark是用于大规模数据(large-scala data)处理的统一(unified)分析引擎。

简单来说,Spark是一款分布式的计算框架,用于调度成百上千的服务器集群,计算TB、PB乃至EB级别的海量数据。Spark作为全球顶级的分布式计算框架,支持众多的编程语言进行开发。 而Python语言,则是Spark重点支持的方向。

PySpark库的安装

在”CMD”命令提示符程序内,输入:

pip install pyspark 或使用国内代理镜像网站(清华大学源)

pip install -i https://pypi.tuna.tsinghua.edu.cn/simple pyspark构建PySpark执行环境入口对象

想要使用PySpark库完成数据处理,首先需要构建一个执行环境入口对象。 PySpark的执行环境入口对象是:类 SparkContext 的类对象

# 导包

from pyspark import SparkConf, SparkContext

# 创建SparkConf类对象

conf = SparkConf().setMaster("local[*]").setAppName("test_spark_app")

# 基于SparkConf类对象创建SparkContext对象

sc = SparkContext(conf=conf)

# 打印PySpark的运行版本

print(sc.version)

# 停止SparkContext对象的运行(停止PySpark程序)

sc.stop()

PySpark的编程模型

数据输入:通过SparkContext完成数据读取

数据计算:读取到的数据转换为RDD对象,调用RDD的成员方法完成计算

数据输出:调用RDD的数据输出相关成员方法,将结果输出到list、元组、字典、文本文件、数据库等

数据输入

RDD对象

PySpark支持多种数据的输入,在输入完成后,都会得到一个:RDD类的对象

RDD全称为:弹性分布式数据集(Resilient Distributed Datasets)

PySpark针对数据的处理,都是以RDD对象作为载体,即:

数据存储在RDD内

各类数据的计算方法,也都是RDD的成员方法

RDD的数据计算方法,返回值依旧是RDD对象

PySpark的编程模型(下图)可以归纳为: 准备数据到RDD -> RDD迭代计算 -> RDD导出为list、文本文件等 即:源数据 -> RDD -> 结果数据

Python数据容器转RDD对象

PySpark支持通过SparkContext对象的parallelize成员方法,将: list tuple set dict str 转换为PySpark的RDD对象

注意: 字符串会被拆分出1个个的字符,存入RDD对象 字典仅有key会被存入RDD对象

eg:

"""

演示通过PySpark代码加载数据,即数据输入

"""

from pyspark import SparkConf, SparkContext

conf = SparkConf().setMaster("local[*]").setAppName("test_spark")

sc = SparkContext(conf=conf)

# # 通过parallelize方法将Python对象加载到Spark内,成为RDD对象

rdd1 = sc.parallelize([1, 2, 3, 4, 5])

rdd2 = sc.parallelize((1, 2, 3, 4, 5))

rdd3 = sc.parallelize("abcdefg")

rdd4 = sc.parallelize({1, 2, 3, 4, 5})

rdd5 = sc.parallelize({"key1": "value1", "key2": "value2"})读取文件转RDD对象

PySpark也支持通过SparkContext入口对象,来读取文件,来构建出RDD对象。

# 用过textFile方法,读取文件数据加载到Spark内,成为RDD对象

rdd = sc.textFile("D:/hello.txt")

print(rdd.collect())

sc.stop()数据计算

map方法

PySpark的数据计算,都是基于RDD对象来进行的,是依赖RDD对象内置丰富的:成员方法(算子)

1、map算子(成员方法)

接受一个处理函数,可用lambda表达式快速编写

对RDD内的元素逐个处理,并返回一个新的RDD

2. 链式调用 对于返回值是新RDD的算子,可以通过链式调用的方式多次调用算子。

eg:

"""

演示RDD的map成员方法的使用

"""

from pyspark import SparkConf, SparkContext

#环境变量

import os

os.environ['PYSPARK_PYTHON'] = "E:/tools/Anaconda3/python.exe"

conf = SparkConf().setMaster("local[*]").setAppName("test_spark")

sc = SparkContext(conf=conf)

# 准备一个RDD

rdd = sc.parallelize([1, 2, 3, 4, 5])

# 通过map方法将全部数据都乘以10

rdd2 = rdd.map(lambda x: x * 10).map(lambda x: x + 5)

print(rdd2.collect())flatMap方法

flatMap算子 计算逻辑和map一样 可以比map多出,解除一层嵌套的功能

from pyspark import SparkConf, SparkContext

import os

os.environ['PYSPARK_PYTHON'] ="E:/tools/Anaconda3/python.exe"

conf = SparkConf().setMaster("local[*]").setAppName("test_spark")

sc = SparkContext(conf=conf)

# 准备一个RDD

rdd = sc.parallelize(["itheima itcast 666", "itheima itheima itcast", "python itheima"])

# 需求,将RDD数据里面的一个个单词提取出来

rdd2 = rdd.flatMap(lambda x: x.split(" "))

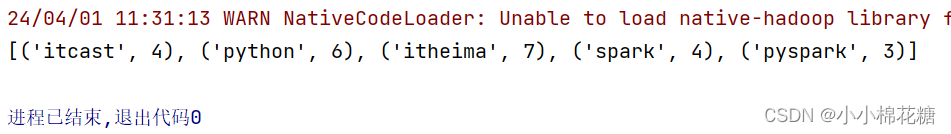

print(rdd2.collect())reduceByKey方法

功能:针对KV型RDD,自动按照key分组,然后根据你提供的聚合逻辑,完成组内数据(value)的聚合操作.

接受一个处理函数,对数据进行两两计算

使用PySpark进行单词计数的案例

使用学习到的内容,完成: 读取文件以及统计文件内,单词的出现数量

# 1. 构建执行环境入口对象

from pyspark import SparkContext, SparkConf

import os

os.environ['PYSPARK_PYTHON'] = "E:/tools/Anaconda3/python.exe"

conf = SparkConf().setMaster("local[*]").setAppName("test_spark")

sc = SparkContext(conf=conf)

# 2. 读取数据文件

rdd = sc.textFile("D:/hello.txt")

# 3. 取出全部单词

word_rdd = rdd.flatMap(lambda x: x.split(" "))

# 4. 将所有单词都转换成二元元组,单词为Key,value设置为1

word_with_one_rdd = word_rdd.map(lambda word: (word, 1))

# 5. 分组并求和

result_rdd = word_with_one_rdd.reduceByKey(lambda a, b: a + b)

# 6. 打印输出结果

print(result_rdd.collect())

filter方法

功能:过滤想要的数据进行保留

接受一个处理函数,可用lambda快速编写

函数对RDD数据逐个处理,得到True的保留至返回值的RDD中

eg:

# 准备一个RDD

rdd = sc.parallelize([1, 2, 3, 4, 5])

# 对RDD的数据进行过滤

rdd2 = rdd.filter(lambda num: num % 2 == 0) #提出偶数

print(rdd2.collect())distinct方法

功能:对RDD数据进行去重,返回新RDD

# 准备一个RDD

rdd = sc.parallelize([1, 1, 3, 3, 5, 5, 7, 8, 8, 9, 10])

# 对RDD的数据进行去重

rdd2 = rdd.distinct()

print(rdd2.collect())sortBy方法

功能:对RDD数据进行排序,基于你指定的排序依据.

from pyspark import SparkConf, SparkContext

import os

os.environ['PYSPARK_PYTHON'] = "E:/tools/Anaconda3/python.exe"

conf = SparkConf().setMaster("local[*]").setAppName("test_spark")

sc = SparkContext(conf=conf)

# 1. 读取数据文件

rdd = sc.textFile("D:/hello.txt")

# 2. 取出全部单词

word_rdd = rdd.flatMap(lambda x: x.split(" "))

# 3. 将所有单词都转换成二元元组,单词为Key,value设置为1

word_with_one_rdd = word_rdd.map(lambda word: (word, 1))

# 4. 分组并求和

result_rdd = word_with_one_rdd.reduceByKey(lambda a, b: a + b)

# 5. 对结果进行排序

final_rdd = result_rdd.sortBy(lambda x: x[1], ascending=True, numPartitions=1)

print(final_rdd.collect())

练习案例2的开发

{"id":1,"timestamp":"2019-05-08T01:03.00Z","category":"平板电脑","areaName":"北京","money":"1450"}|{"id":2,"timestamp":"2019-05-08T01:01.00Z","category":"手机","areaName":"北京","money":"1450"}|{"id":3,"timestamp":"2019-05-08T01:03.00Z","category":"手机","areaName":"北京","money":"8412"}

{"id":4,"timestamp":"2019-05-08T05:01.00Z","category":"电脑","areaName":"上海","money":"1513"}|{"id":5,"timestamp":"2019-05-08T01:03.00Z","category":"家电","areaName":"北京","money":"1550"}|{"id":6,"timestamp":"2019-05-08T01:01.00Z","category":"电脑","areaName":"杭州","money":"1550"}

{"id":7,"timestamp":"2019-05-08T01:03.00Z","category":"电脑","areaName":"北京","money":"5611"}|{"id":8,"timestamp":"2019-05-08T03:01.00Z","category":"家电","areaName":"北京","money":"4410"}|{"id":9,"timestamp":"2019-05-08T01:03.00Z","category":"家具","areaName":"郑州","money":"1120"}

{"id":10,"timestamp":"2019-05-08T01:01.00Z","category":"家具","areaName":"北京","money":"6661"}|{"id":11,"timestamp":"2019-05-08T05:03.00Z","category":"家具","areaName":"杭州","money":"1230"}|{"id":12,"timestamp":"2019-05-08T01:01.00Z","category":"书籍","areaName":"北京","money":"5550"}

{"id":13,"timestamp":"2019-05-08T01:03.00Z","category":"书籍","areaName":"北京","money":"5550"}|{"id":14,"timestamp":"2019-05-08T01:01.00Z","category":"电脑","areaName":"北京","money":"1261"}|{"id":15,"timestamp":"2019-05-08T03:03.00Z","category":"电脑","areaName":"杭州","money":"6660"}

{"id":16,"timestamp":"2019-05-08T01:01.00Z","category":"电脑","areaName":"天津","money":"6660"}|{"id":17,"timestamp":"2019-05-08T01:03.00Z","category":"书籍","areaName":"北京","money":"9000"}|{"id":18,"timestamp":"2019-05-08T05:01.00Z","category":"书籍","areaName":"北京","money":"1230"}

{"id":19,"timestamp":"2019-05-08T01:03.00Z","category":"电脑","areaName":"杭州","money":"5551"}|{"id":20,"timestamp":"2019-05-08T01:01.00Z","category":"电脑","areaName":"北京","money":"2450"}

{"id":21,"timestamp":"2019-05-08T01:03.00Z","category":"食品","areaName":"北京","money":"5520"}|{"id":22,"timestamp":"2019-05-08T01:01.00Z","category":"食品","areaName":"北京","money":"6650"}

{"id":23,"timestamp":"2019-05-08T01:03.00Z","category":"服饰","areaName":"杭州","money":"1240"}|{"id":24,"timestamp":"2019-05-08T01:01.00Z","category":"食品","areaName":"天津","money":"5600"}

{"id":25,"timestamp":"2019-05-08T01:03.00Z","category":"食品","areaName":"北京","money":"7801"}|{"id":26,"timestamp":"2019-05-08T01:01.00Z","category":"服饰","areaName":"北京","money":"9000"}

{"id":27,"timestamp":"2019-05-08T01:03.00Z","category":"服饰","areaName":"杭州","money":"5600"}|{"id":28,"timestamp":"2019-05-08T01:01.00Z","category":"食品","areaName":"北京","money":"8000"}|{"id":29,"timestamp":"2019-05-08T02:03.00Z","category":"服饰","areaName":"杭州","money":"7000"}

需求,复制以上内容到文件中,使用Spark读取文件进行计算:

各个城市销售额排名,从大到小 全

部城市,有哪些商品类别在售卖

北京市有哪些商品类别在售卖

rom pyspark import SparkConf, SparkContext

import os

import json

os.environ['PYSPARK_PYTHON'] = "E:/tools/Anaconda3/python.exe"

conf = SparkConf().setMaster("local[*]").setAppName("test_spark")

sc = SparkContext(conf=conf)

# TODO 需求1: 城市销售额排名

# 1.1 读取文件得到RDD

file_rdd = sc.textFile("D:/生成文件/python练习/资料/第15章资料/资料/orders.txt")

# 1.2 取出一个个JSON字符串

json_str_rdd = file_rdd.flatMap(lambda x: x.split("|"))

# 1.3 将一个个JSON字符串转换为字典

dict_rdd = json_str_rdd.map(lambda x: json.loads(x))

# 1.4 取出城市和销售额数据

# (城市,销售额)

city_with_money_rdd = dict_rdd.map(lambda x: (x['areaName'], int(x['money'])))

# 1.5 按城市分组按销售额聚合

city_result_rdd = city_with_money_rdd.reduceByKey(lambda a, b: a + b)

# 1.6 按销售额聚合结果进行排序

result1_rdd = city_result_rdd.sortBy(lambda x: x[1], ascending=False, numPartitions=1)

print("需求1的结果:", result1_rdd.collect())

# TODO 需求2: 全部城市有哪些商品类别在售卖

# 2.1 取出全部的商品类别

category_rdd = dict_rdd.map(lambda x: x['category']).distinct()

print("需求2的结果:", category_rdd.collect())

# 2.2 对全部商品类别进行去重

# TODO 需求3: 北京市有哪些商品类别在售卖

# 3.1 过滤北京市的数据

beijing_data_rdd = dict_rdd.filter(lambda x: x['areaName'] == '北京')

# 3.2 取出全部商品类别

result3_rdd = beijing_data_rdd.map(lambda x: x['category']).distinct()

print("需求3的结果:", result3_rdd.collect())

数据输出

输出为Python对象

Spark的编程流程就是:

将数据加载为RDD(数据输入)

对RDD进行计算(数据计算)

将RDD转换为Python对象(数据输出)

数据输出的方法

collect:将RDD内容转换为list

reduce:对RDD内容进行自定义聚合

take:取出RDD的前N个元素组成list

count:统计RDD元素个数

eg:

from pyspark import SparkConf, SparkContext

import os

import json

os.environ['PYSPARK_PYTHON'] = "E:/tools/Anaconda3/python.exe"

conf = SparkConf().setMaster("local[*]").setAppName("test_spark")

sc = SparkContext(conf=conf)

# 准备RDD

rdd = sc.parallelize([1, 2, 3, 4, 5])

# collect算子,输出RDD为list对象

rdd_list: list = rdd.collect()

print(rdd_list)

print(type(rdd_list))

# reduce算子,对RDD进行两两聚合

num = rdd.reduce(lambda a, b: a + b)

print(num)

# take算子,取出RDD前N个元素,组成list返回

take_list = rdd.take(3)

print(take_list)

# count,统计rdd内有多少条数据,返回值为数字

num_count = rdd.count()

print(f"rdd内有{num_count}个元素")

sc.stop()

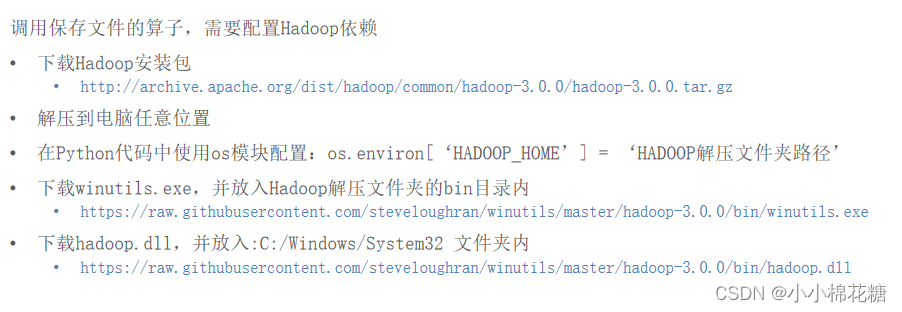

输出到文件中

RDD输出到文件的方法

rdd.saveAsTextFile(路径)

输出的结果是一个文件夹

有几个分区就输出多少个结果文件

注意事项

修改rdd分区为1个

SparkConf对象设置conf.set("spark.default.parallelism", "1")

创建RDD的时候,sc.parallelize方法传入numSlices参数为1

该学习笔记由观看 黑马程序员python教程,8天python从入门到精通,学python看这套就够了-哔哩哔哩】 https://b23.tv/fDS6HWr 而做

该学习笔记由观看 黑马程序员python教程,8天python从入门到精通,学python看这套就够了-哔哩哔哩】 https://b23.tv/fDS6HWr 而做

3290

3290

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?