引言

GPT(Generative Pre-Trained Transformer)系列是OpenAI开发的一系列以Transformer[2]为基础的生成式预训练模型,这个系列目前包括文本预训练模型GPT-1[3],GPT-2[4],GPT-3[5],InstructGPT[7]、ChatGPT[8](这两个工作可以看作GPT-3.5的延伸),图像预训练iGPT[6],GPT-4[1]。

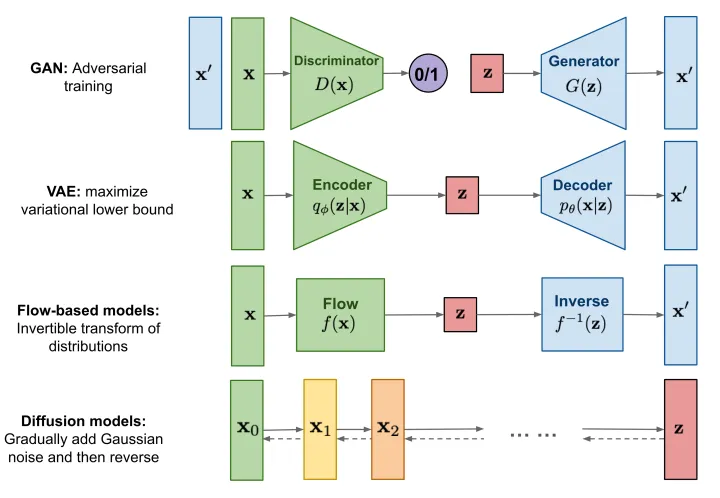

生成式任务主流的五种算法

图1 不同生成模型概览

生成任务的核心思想就是保证生成的样本的分布要与训练数据的分布接近,这样生成出来的数据和原有的数据就会十分相似,可以以假乱真的地步。当今深度学习领域最主流的模型包括自回归模型Autoregressive Model (AR)、生成对抗网络Generative Adversarial Network (GAN)、标准化流模型Normalizing Flow (Flow)、自编码器Auto-Encoder (AE)与变分自编码器Variational Auto-Encoder (VAE)、去噪扩散模型Denoising Diffusion Probablistic Model (Diffusion)等等。如图1所示 ,展示了不同模型的处理流程。为了避免出现大量的数学公式,这里只是形式化得说明不同生成框架的基本处理流程,如果大家对算法细节感兴趣

订阅专栏 解锁全文

订阅专栏 解锁全文

4514

4514

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?