Cult of Mac网站的出品人Leander Kahney正在写一本Apple传奇设计师的传记“Jony Ive: The Genius Behind Apple's Greatest Products”,他在Medium上公布了书中关于iPhone产品诞生历程的章节“The Birth of the iPhone”,内容非常详尽,36kr发表了这篇文章的编译。

比较重要的细节包括: 采用触摸屏技术的想法最早来自设计师Duncan Kerr在2003年年底的一次演示。(Kerr本人非常低调,网上甚至找不到一张照片。在Business Insider对Ive团队的整体亮相报道中,只能贴上他没什么信息的LinkedIn抓屏。)

Jony Ive团队由此设计和实现了模型035,外观非常接近iPad。但当时并未得到高层的重视,他们的注意力都在iPod上。

等高管们认识到手机可能取代iPod时,他们的第一选择是2005年与摩托罗拉合作,但结果令Jobs大为失望。

Apple终于自己组建了两个团队同时开发手机,项目代号Purple。在2005年初,Apple偷偷收购了手势识别公司FingerWorks,这消息直到一年多后FingerWorks的创始人为Apple申请的专利曝光才为人所知。(36Kr的翻译说创始人和Apple打官司云云完全理解错了。)

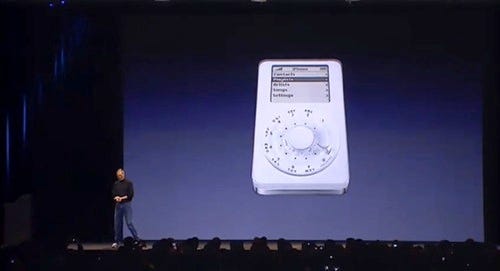

一个是Fadell团队基于iPod nano的P1,一个是Jony Ive的P2。P1体验糟糕,而且无法上网,不能运行应用,而且Fadell对多点触摸不认可。他们的项目被终止了。它只在Jobs后来iPhone的发布会上作为笑料出现了一下:

P2成为Apple公司的顶级项目,抽调了Fadell负责硬件,Forstall负责新操作系统的开发。

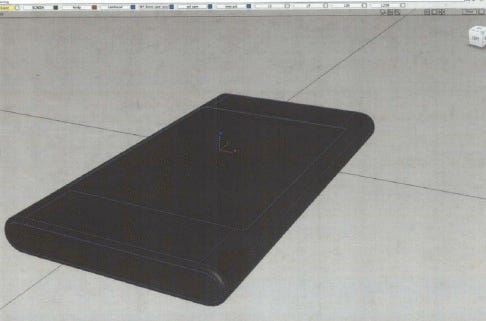

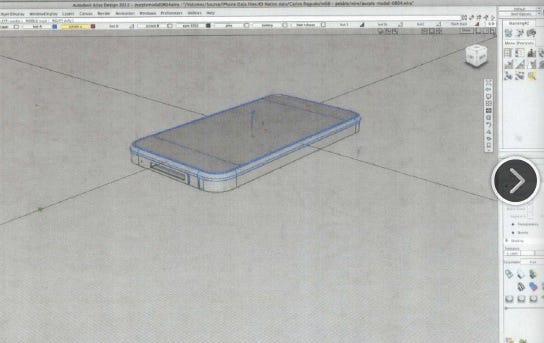

设计上当时有两个方案,分别是Chris Stringer领导的Extrudo和Richard Howarth领导的Sandwich。

更像iPod Mini的Extrudo的早期CAD渲染效果

Sandwich早期CAD渲染效果

很奇怪,最开始Ive更重视不那么突出大屏幕的Extrudo,投入了很多精力,但锋利的边缘和天线等工程问题无法解决,它被终止了。Sandwich最终成了iPhone,但它的原型非常臃肿,Apple一面瘦身,一面为这个小小的设备加入了惊人丰富的功能,传奇诞生了。

1021

1021

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?