【人工智能全栈学习】机器学习基础知识——传统机器学习(看完就全懂了)

本系列文章不可转载!!!

一、问题

| 本章问题导读,如果面试前以下题目还有不会的建议看本篇文章 |

|---|

| 1.写出朴素贝叶斯的公式,说出朴素贝叶斯的成立条件和优缺点 |

| 2.什么是超平面,超平面工作的原理 |

| 3.解释一下SVM分类的原则,SVM如何解决多分类问题 |

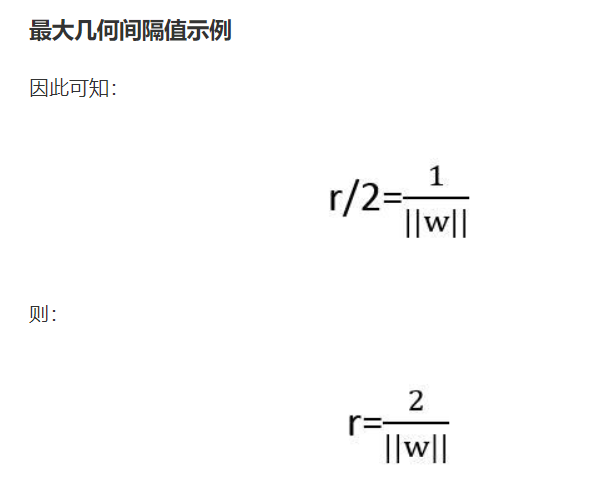

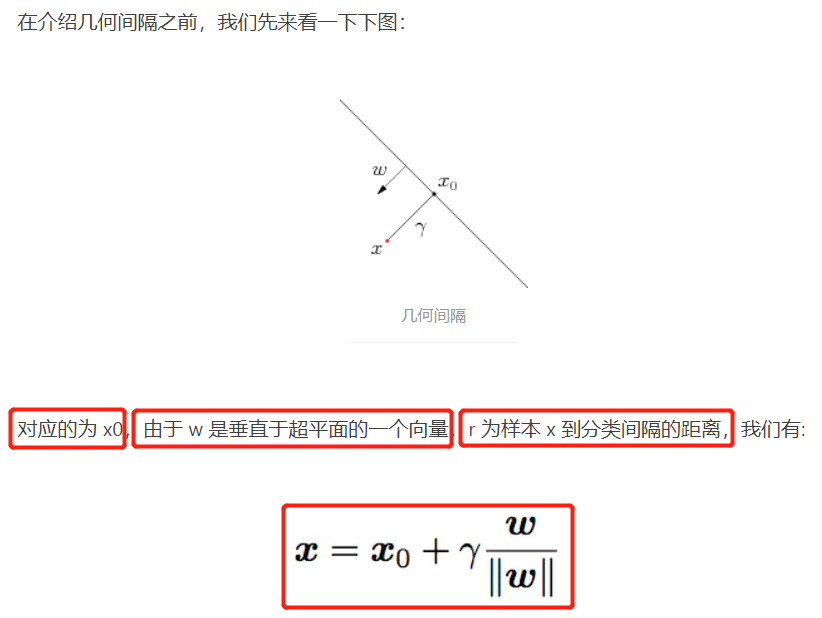

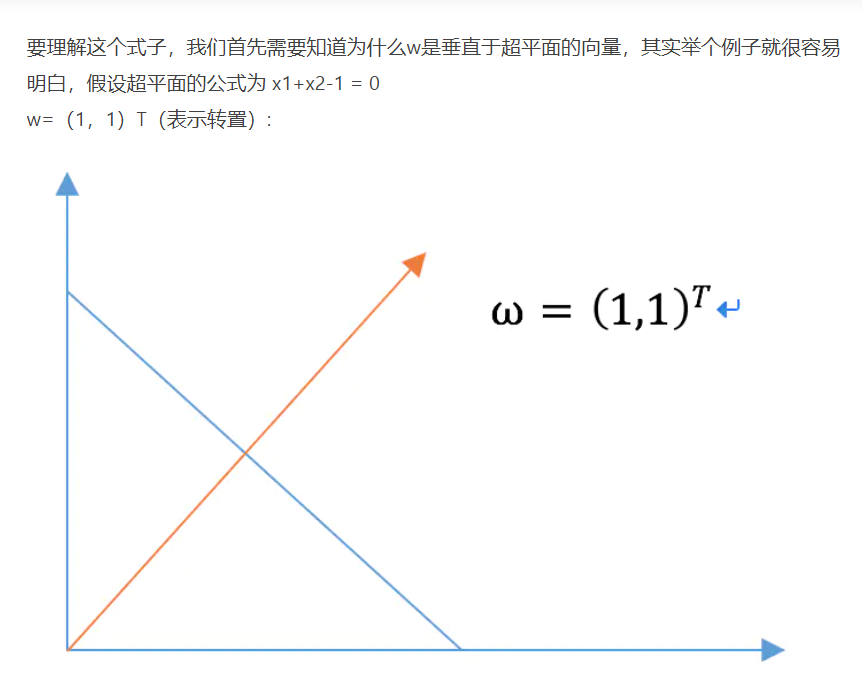

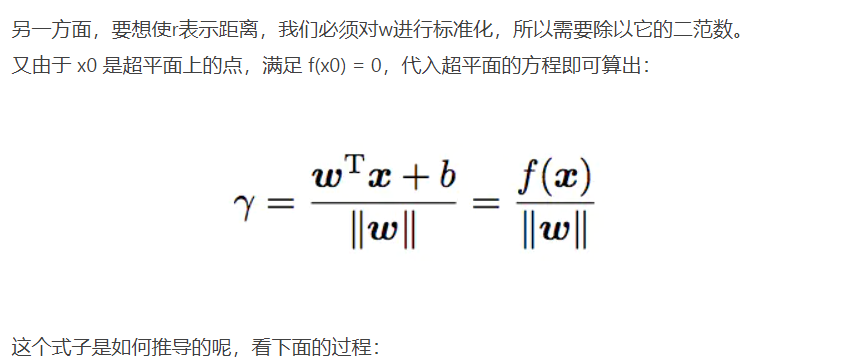

| 4.什么是函数间隔,什么是几何间隔,阐述 ∥ ω ∥ \|\omega\| ∥ω∥的具体含义 |

| 5.核函数是什么,它的出现简化了什么操作,举一个核函数的例子 |

| 6.逻辑回归能不能用核函数 |

二、人工智能全栈学习系列课程

【人工智能全栈学习】机器学习基础知识——线性回归与逻辑回归(看完就全懂了)

【人工智能全栈学习】机器学习基础知识——传统机器学习(看完就全懂了)

【人工智能全栈学习】机器学习基础知识——分类器和机器学习三大定律(看完就全懂了)

【人工智能全栈学习-情感分析】BiLSTM(看完就全懂了)

【人工智能全栈学习-情感分析】Bert(看完就全懂了)

【人工智能全栈学习-知识图谱】零基础实践——动手学关系抽取

【人工智能全栈学习-知识图谱】零基础理论——动手学关系抽取:TextCNN&LSTM

【人工智能全栈学习-计算机视觉】Yolo系列(看完就全懂了)

【人工智能全栈学习-图像分割】语义分割和实例分割(看完就全懂了)

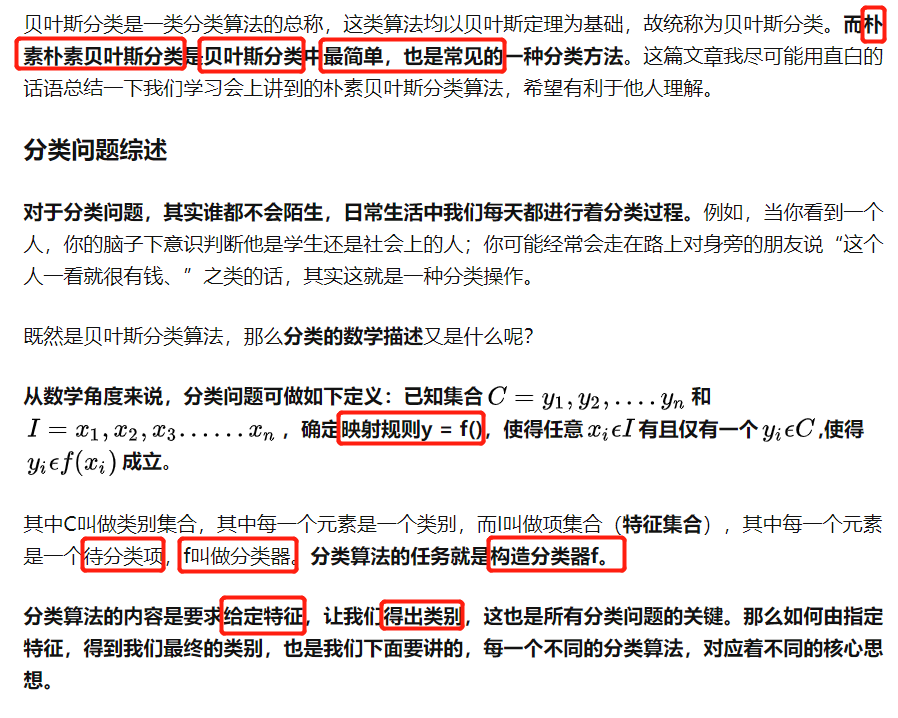

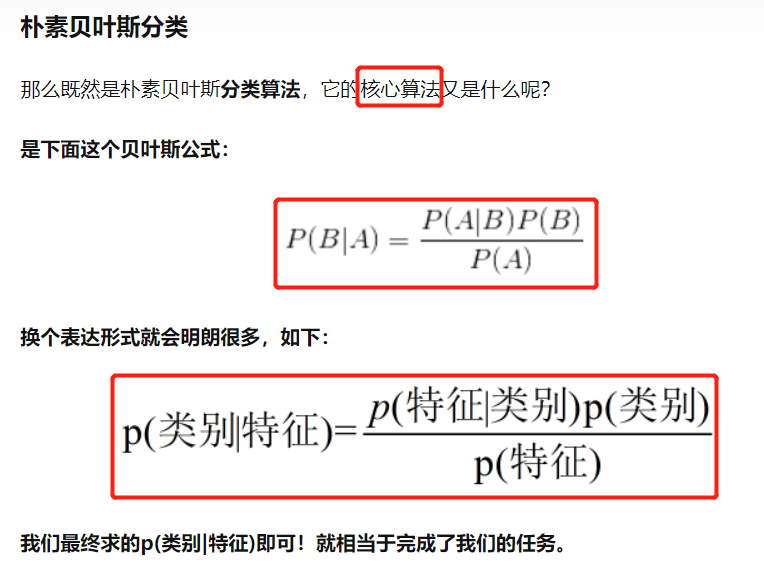

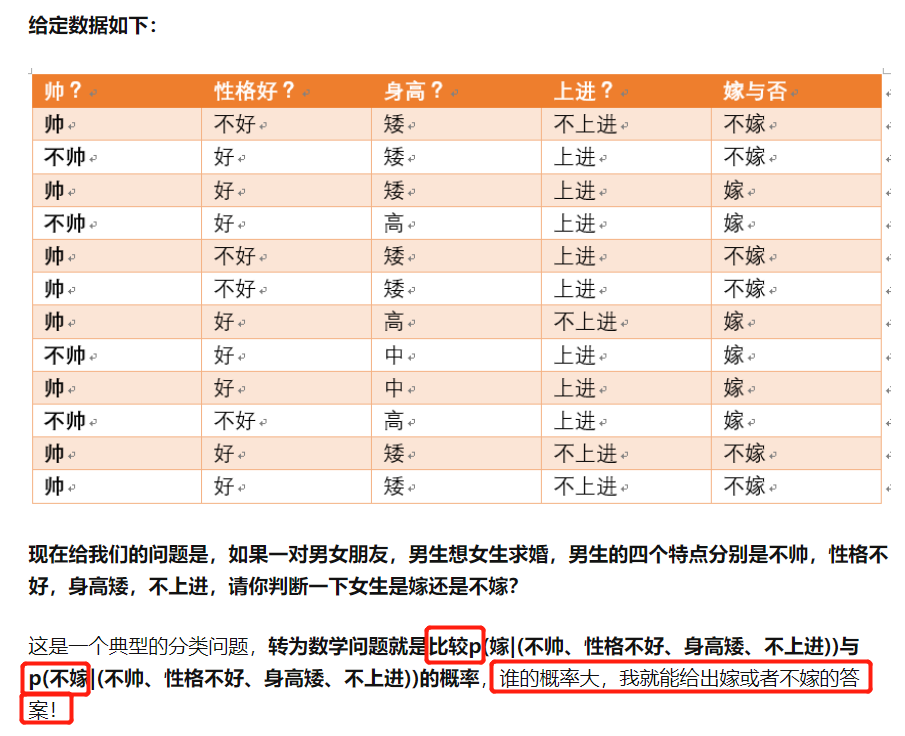

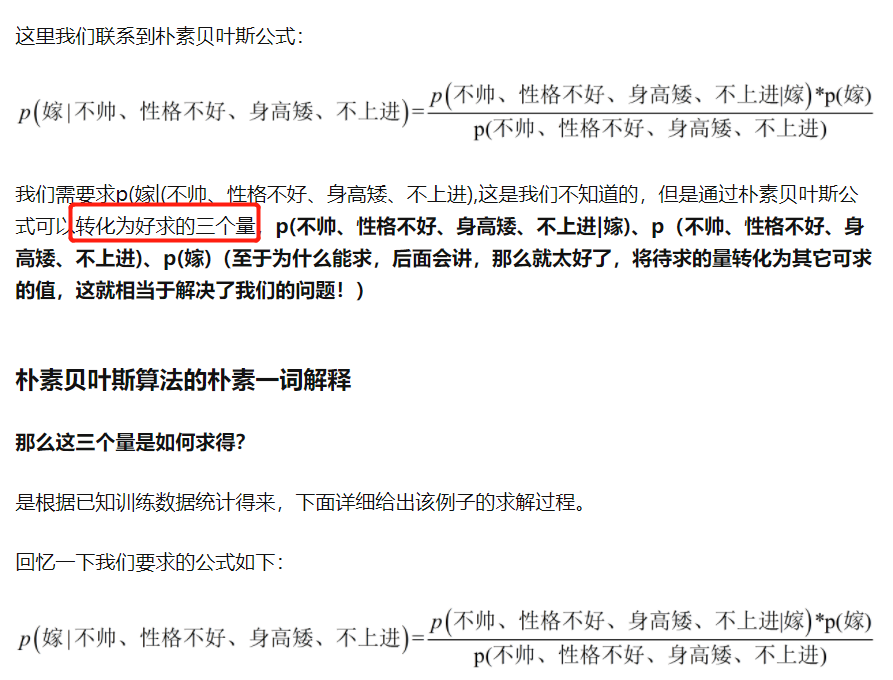

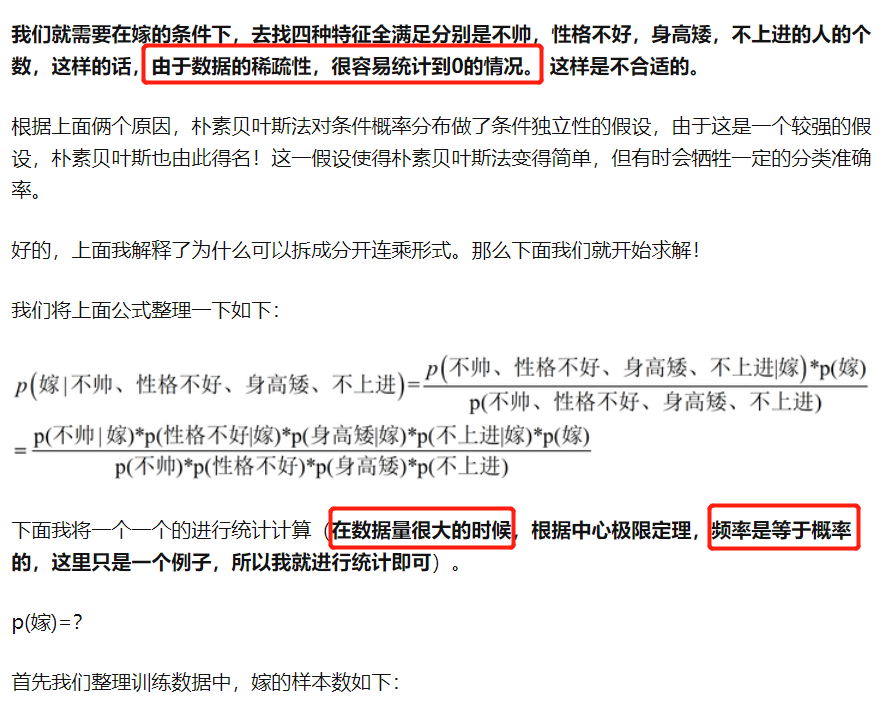

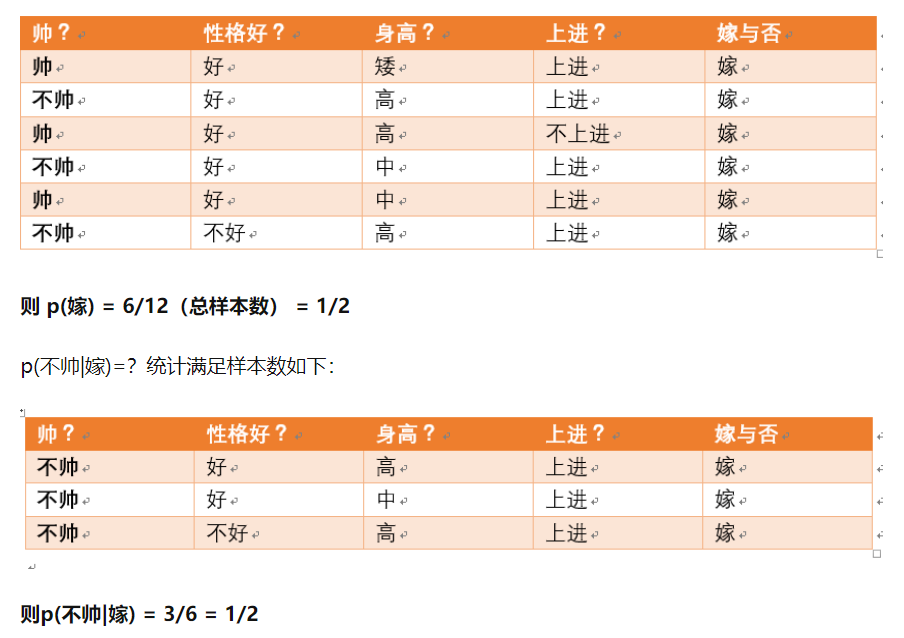

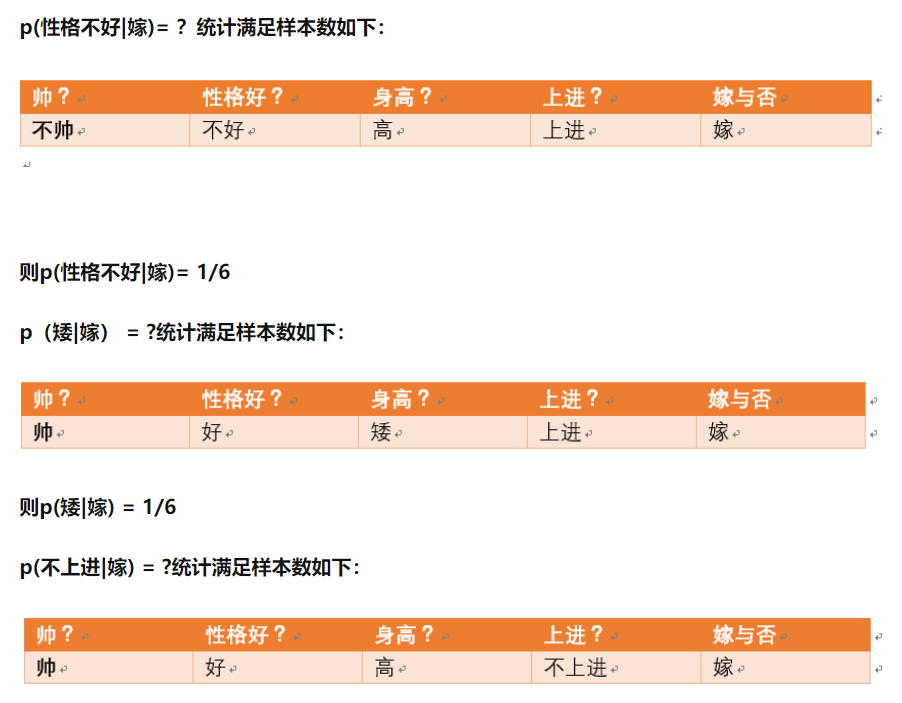

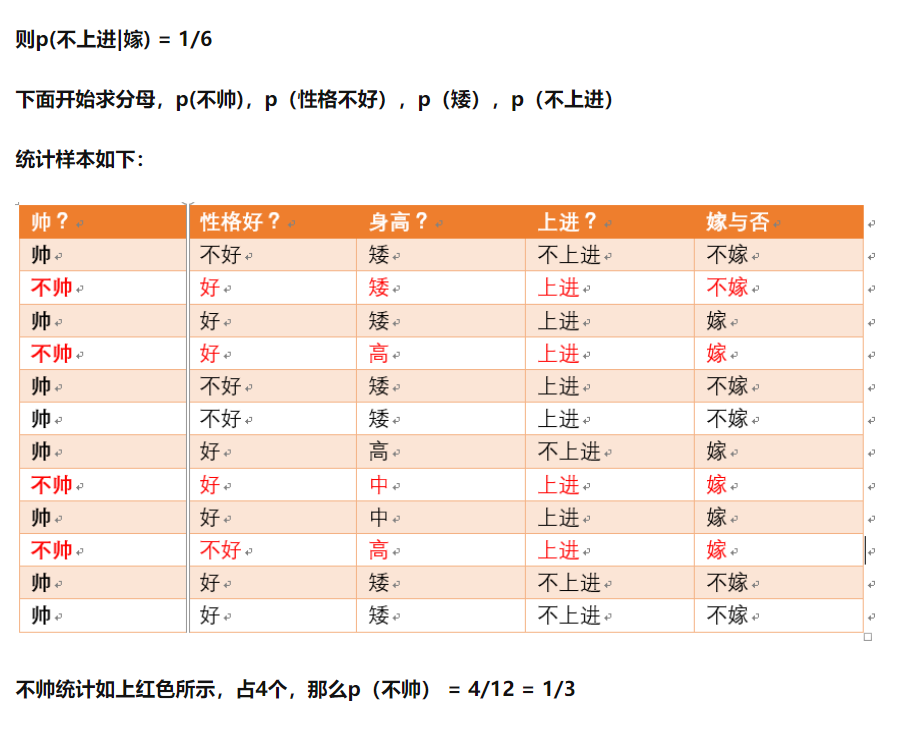

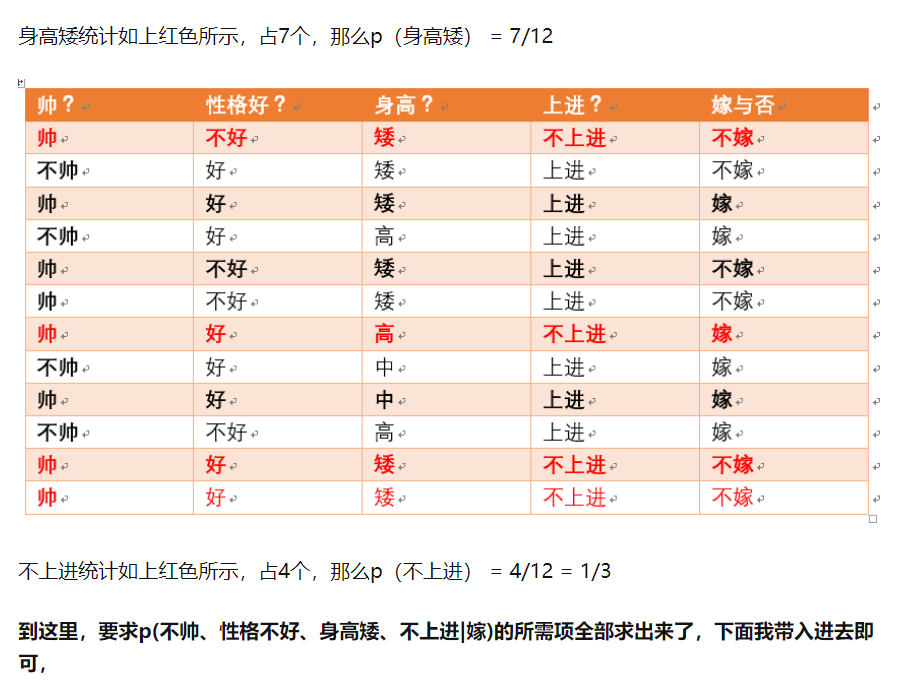

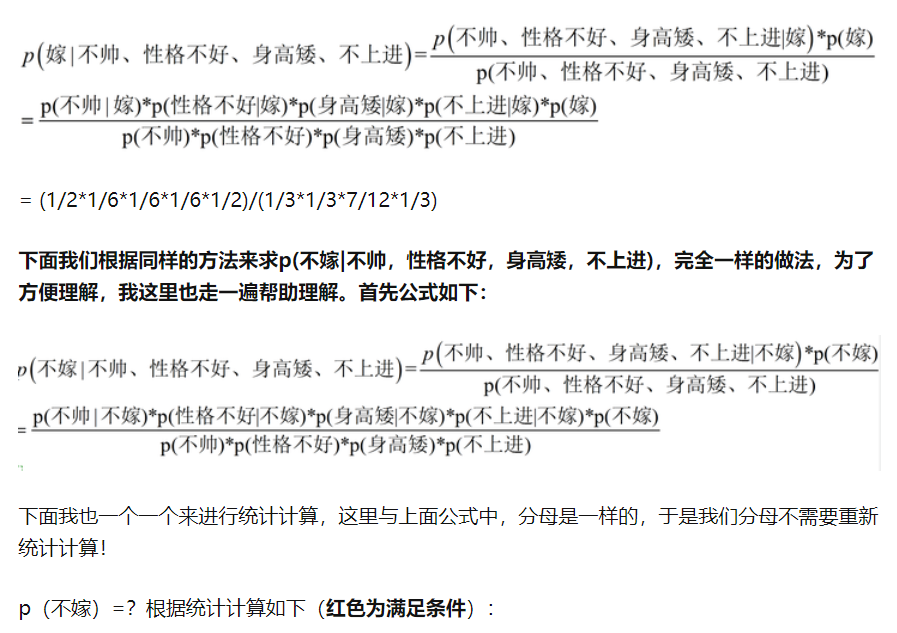

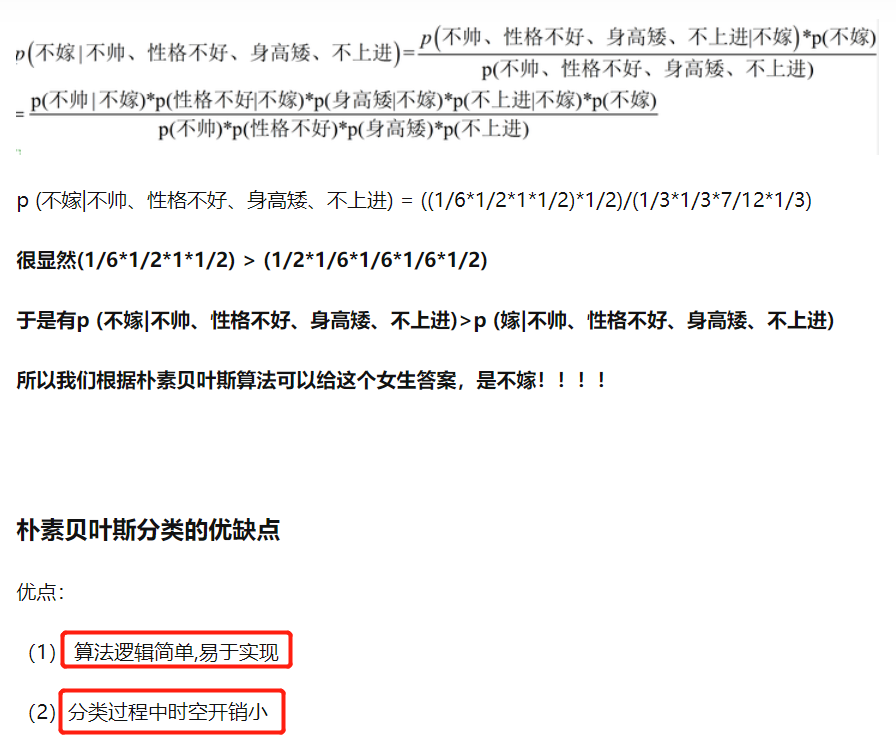

三、朴素贝叶斯

分类算法

朴素贝叶斯分类

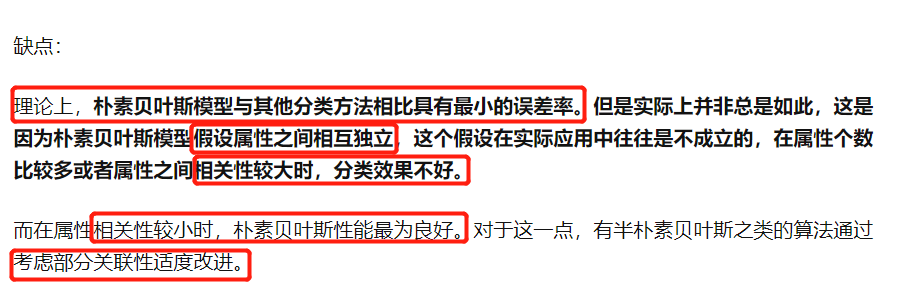

朴素贝叶斯缺点:粗暴认为属性之间相互独立

优点:由于粗暴认为属性之间相互独立,当数据缺失的时候可以进行解耦。

四、SVM

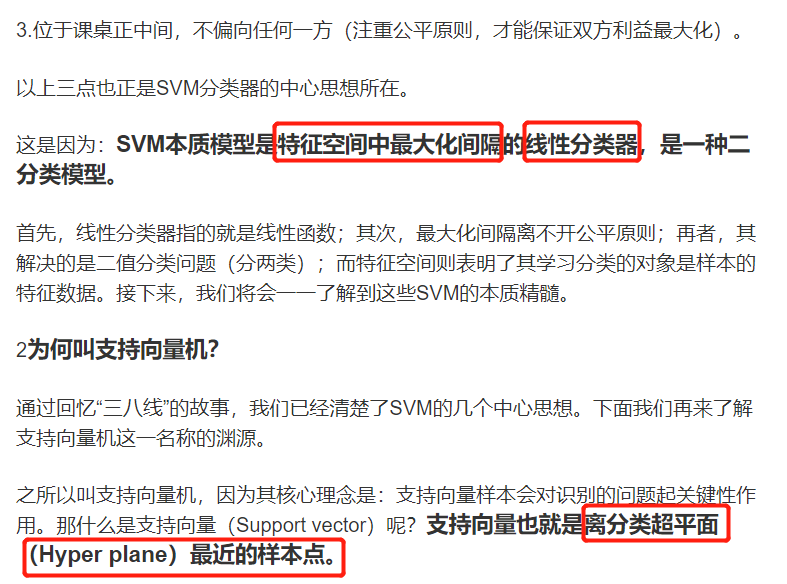

SVM本质:线性分类器

支持向量

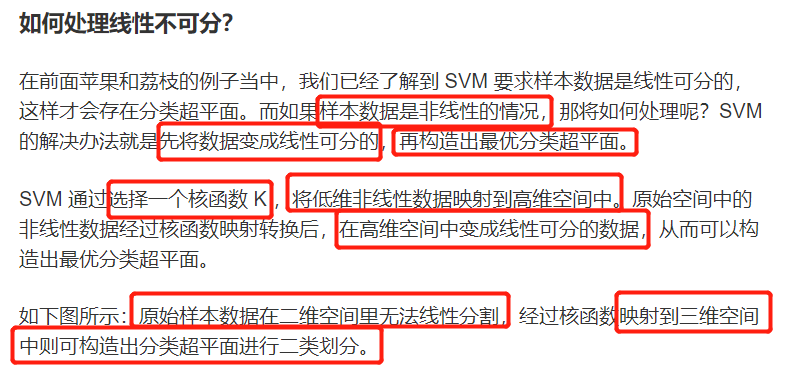

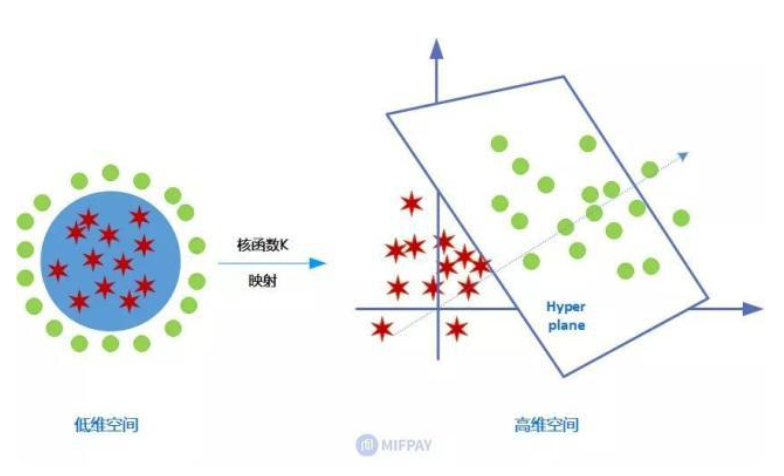

线性可分与线性不可分

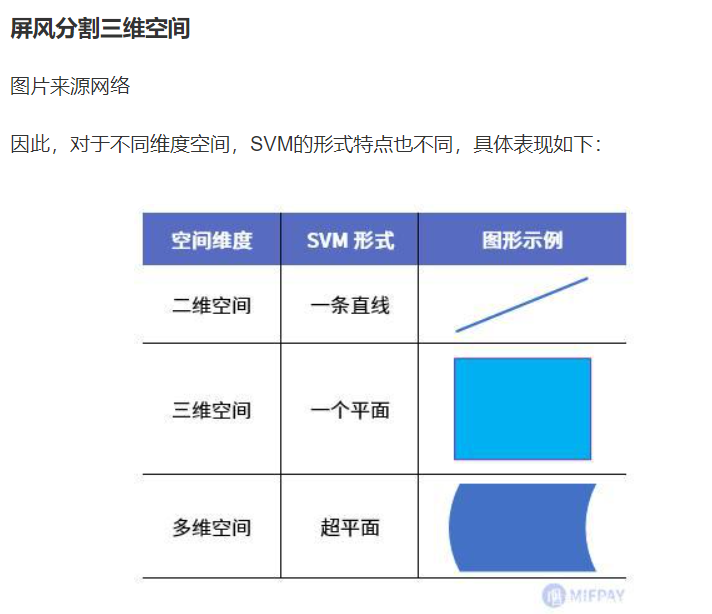

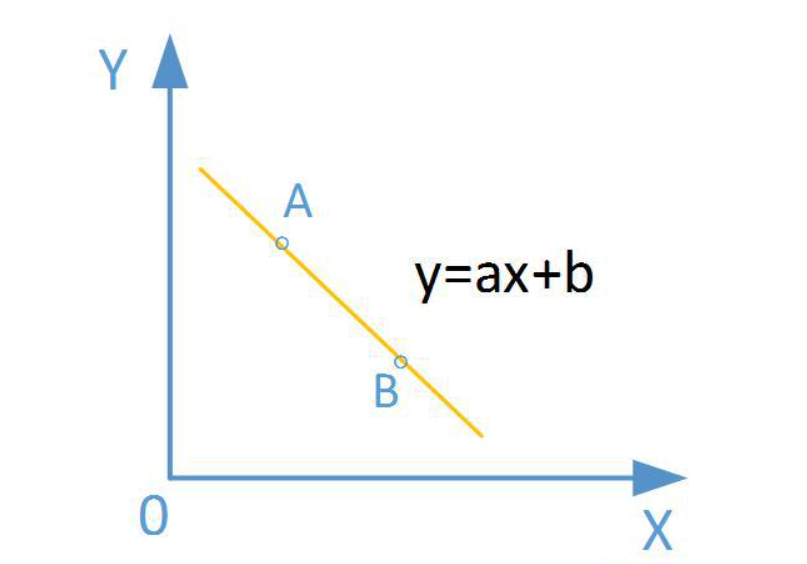

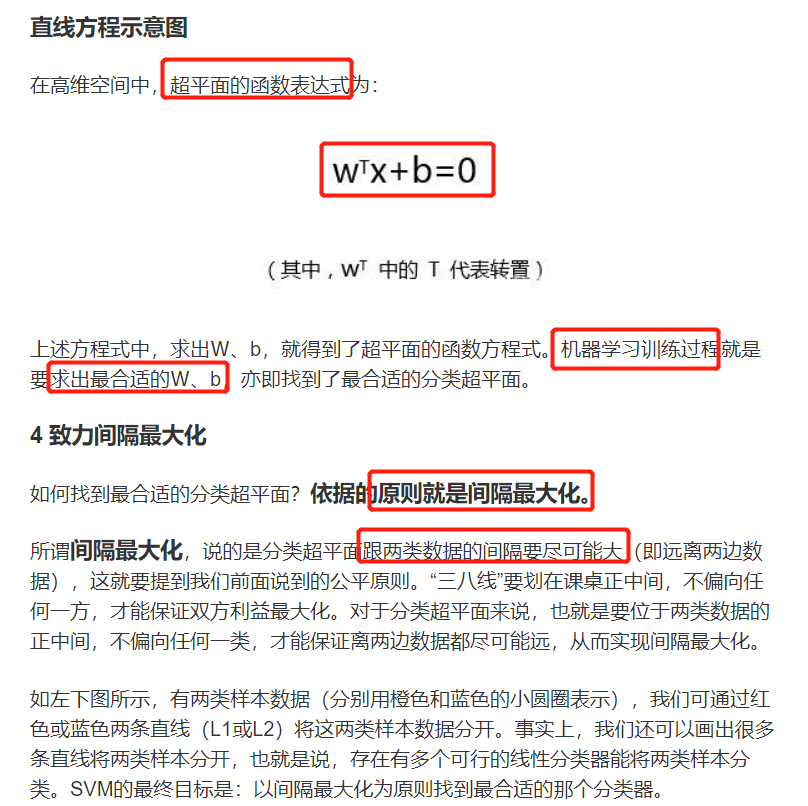

超平面

定义:对于高维空间,无法用图画出,可将数据一分为二的平面

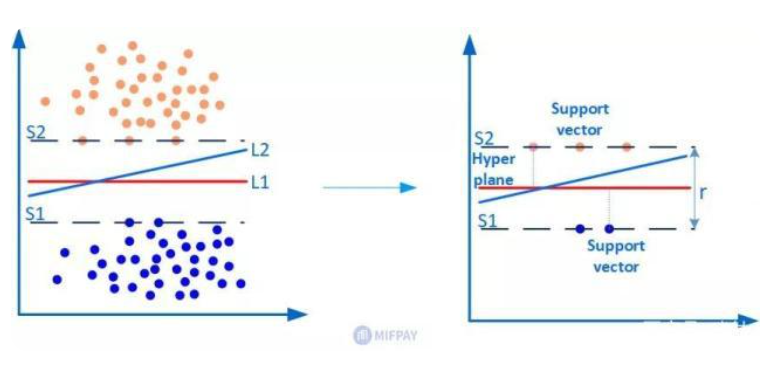

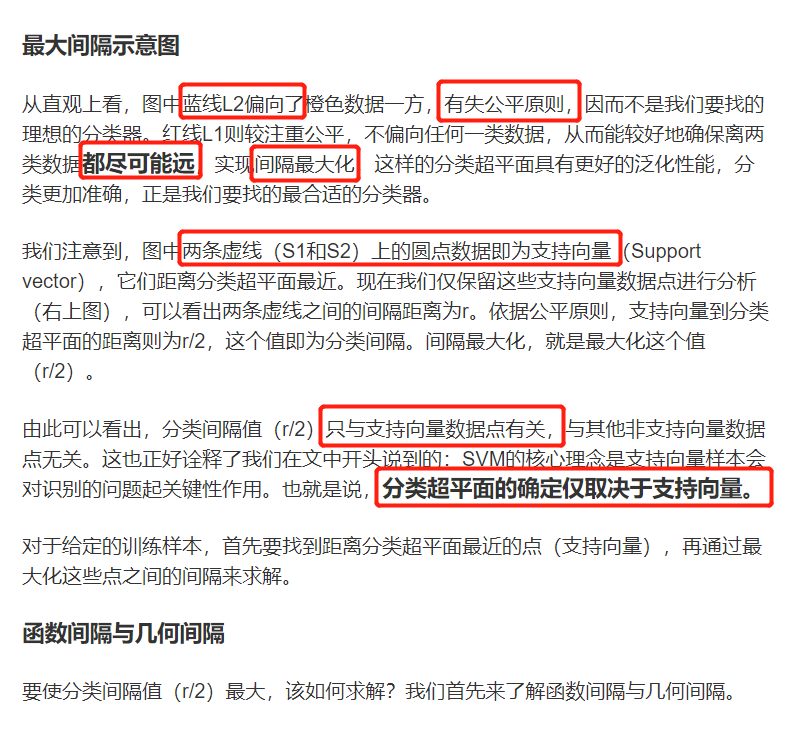

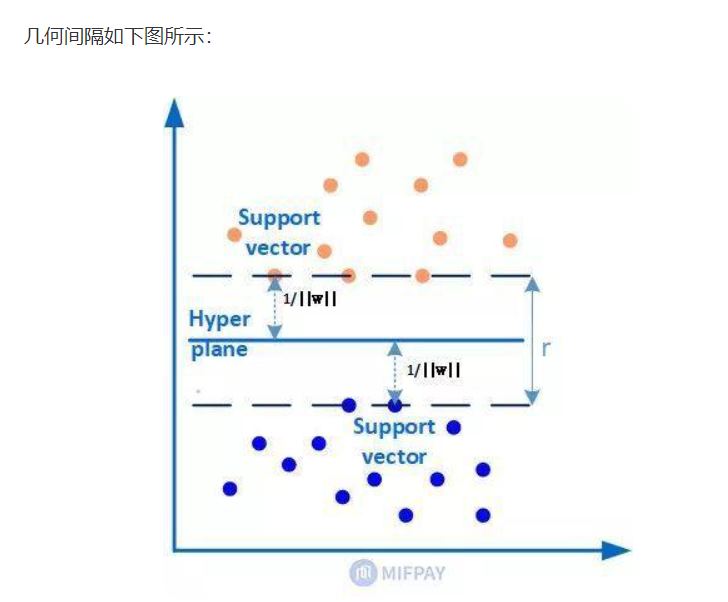

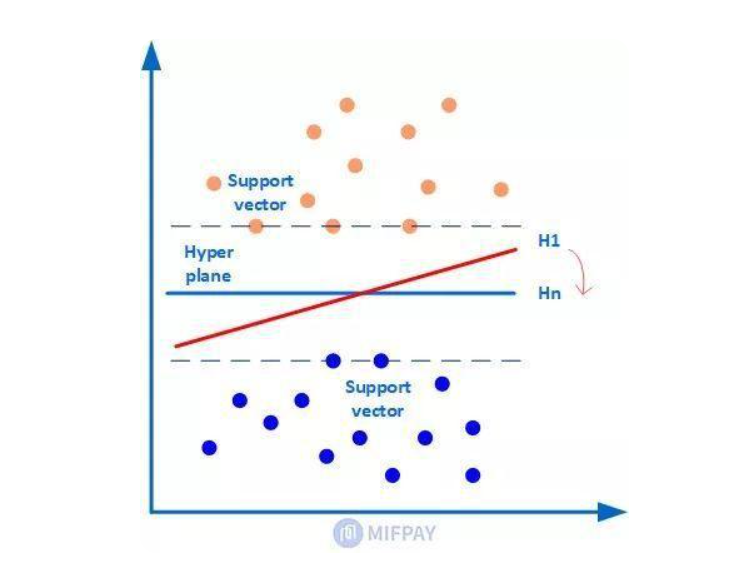

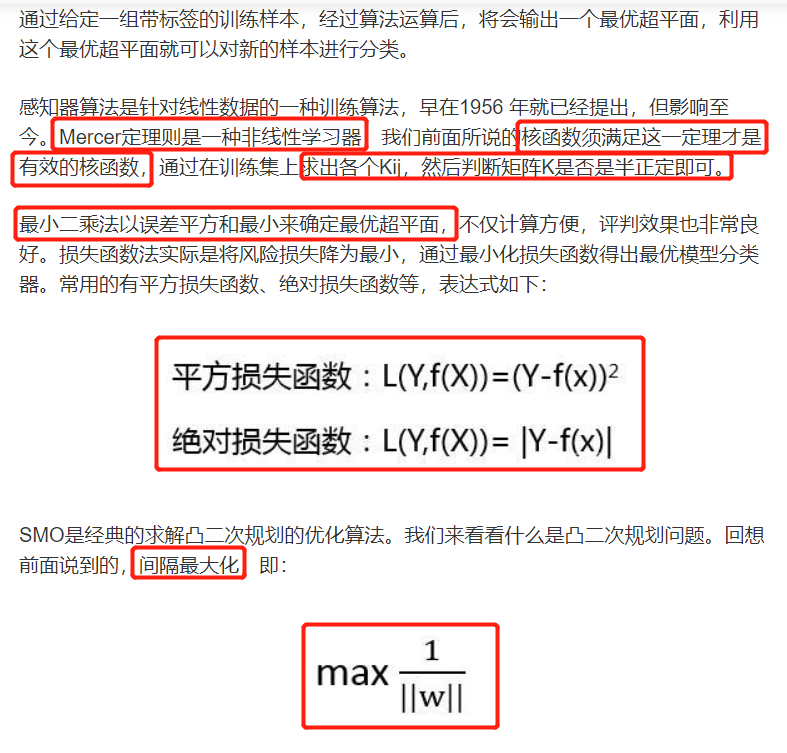

SVM依据原则:间隔最大化

分类超平面确定完全取决于支持向量

<注>不用太费力理解,就是简单的求距离,作者都是按最简单的进行大比方。

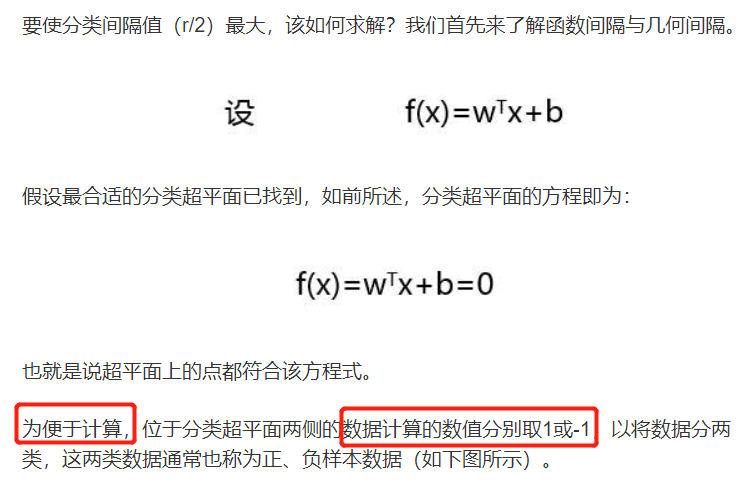

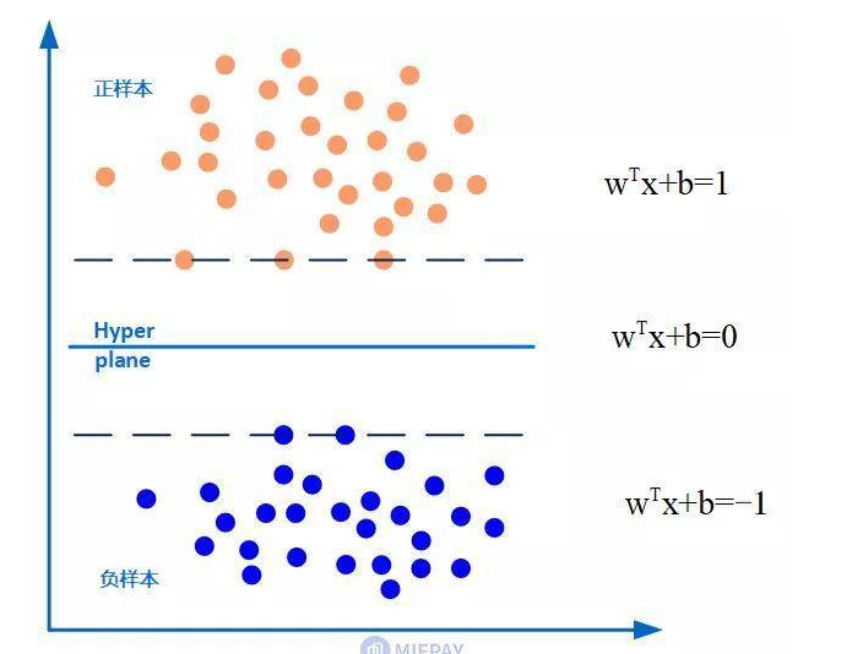

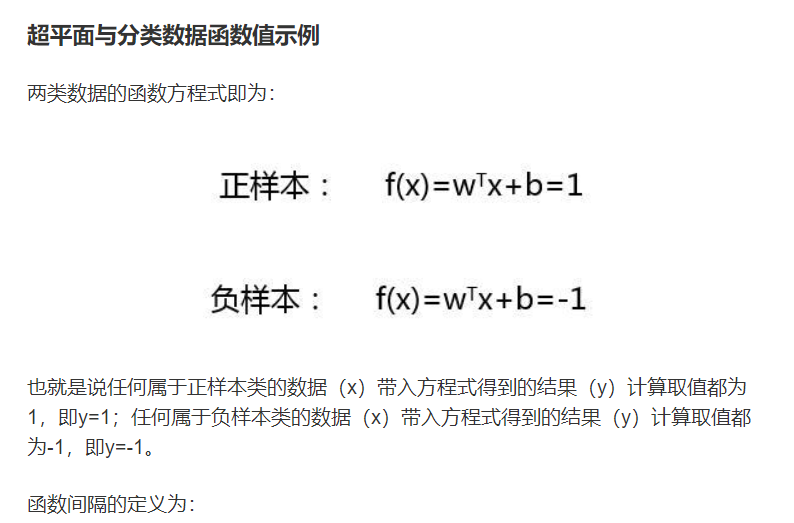

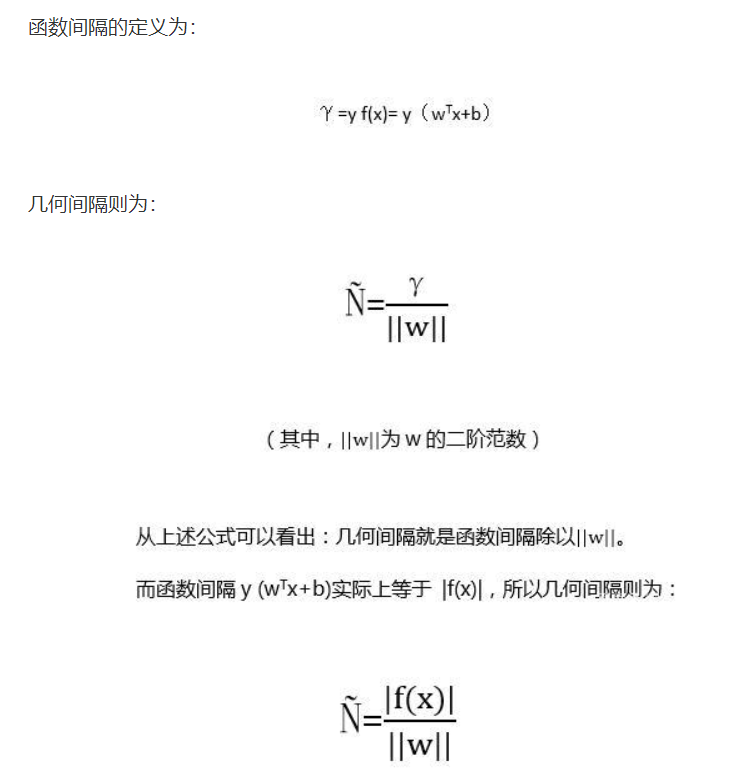

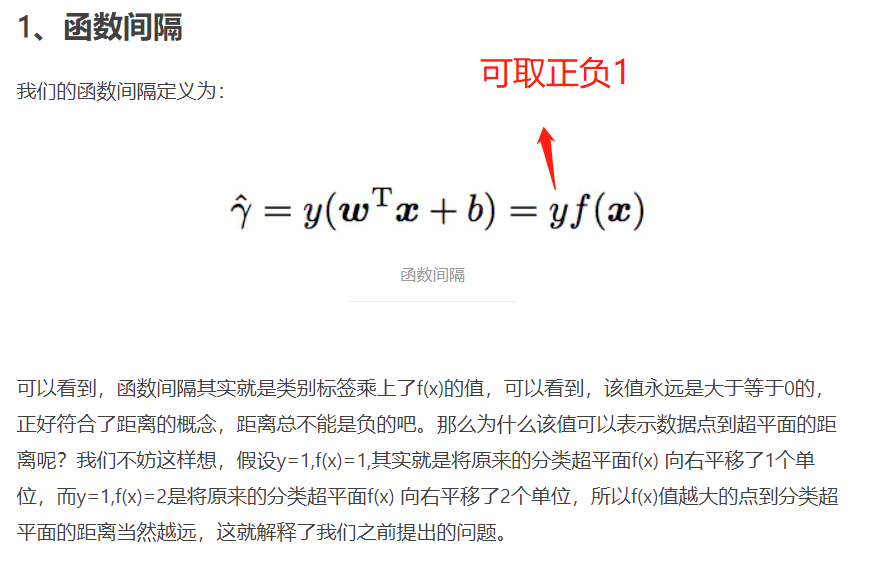

函数间隔

采用几何间隔

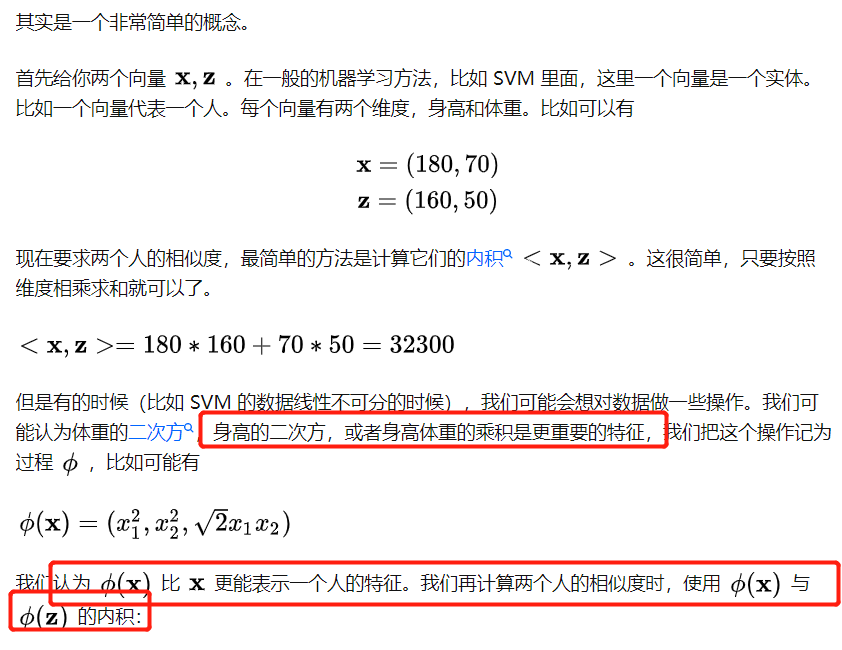

核函数

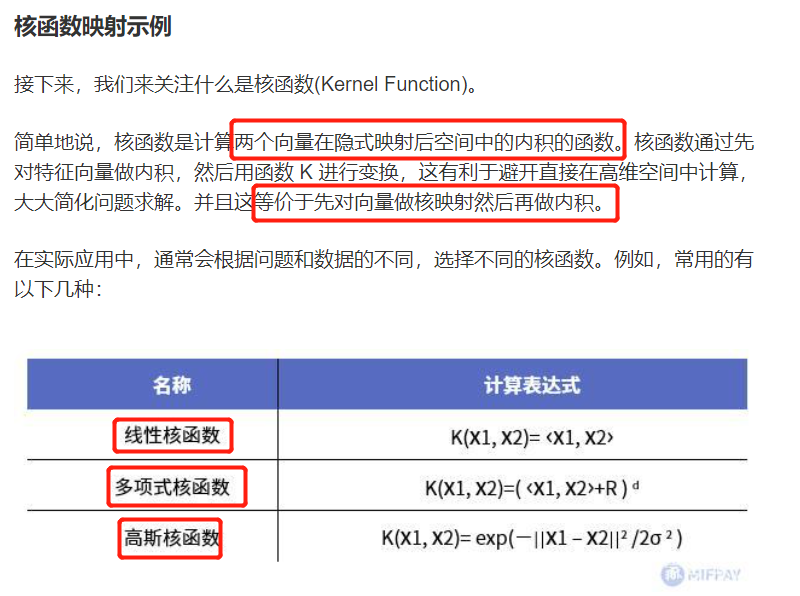

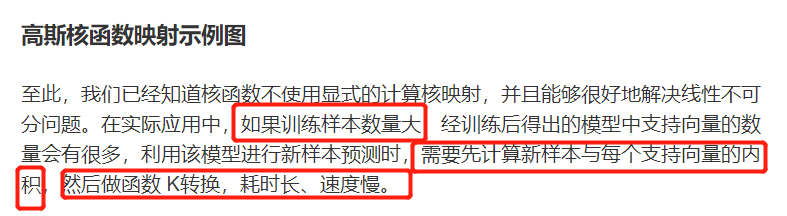

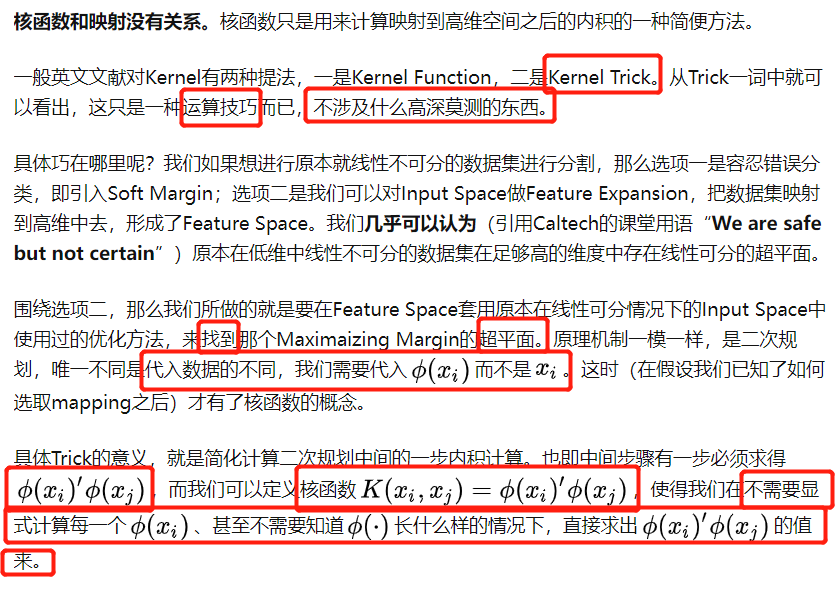

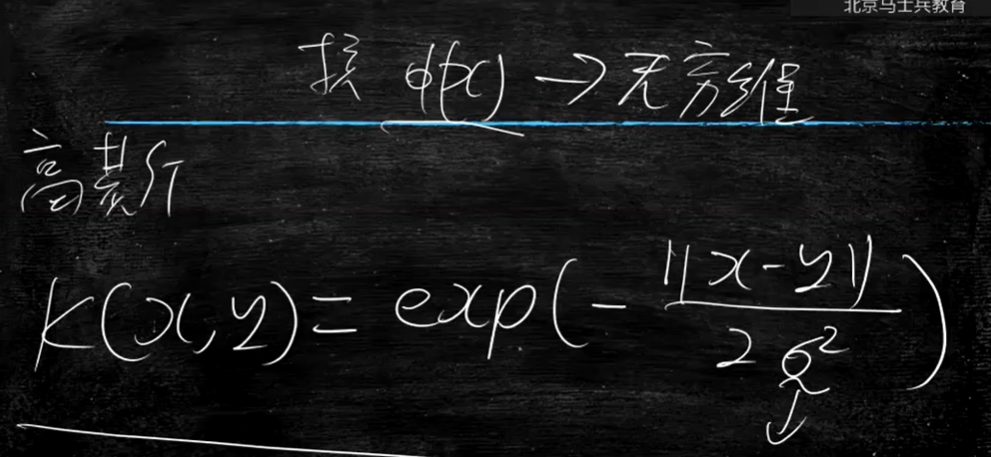

核函数到底是什么:巧妙地绕过了映射

是不是还看不懂,注意这是将新的点

x

j

x_j

xj与老的点

x

i

x_i

xi进行比较得出的结果,下面大佬举得例子更为形象:

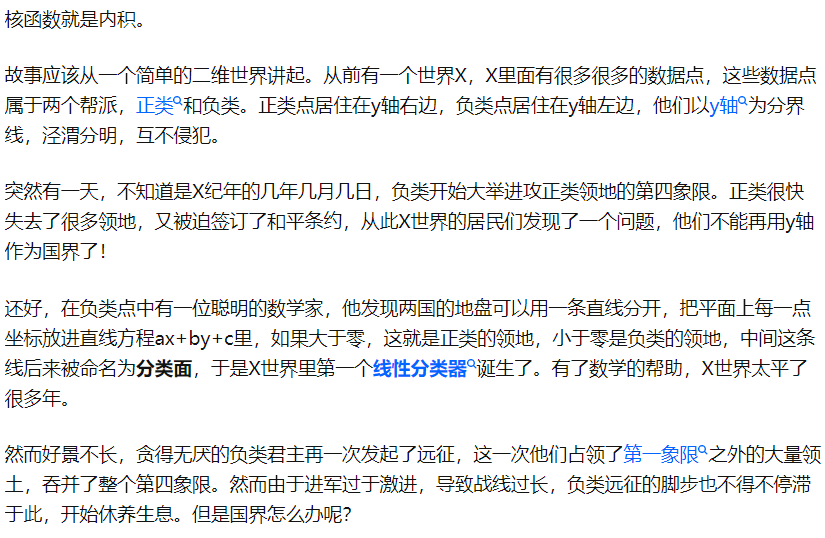

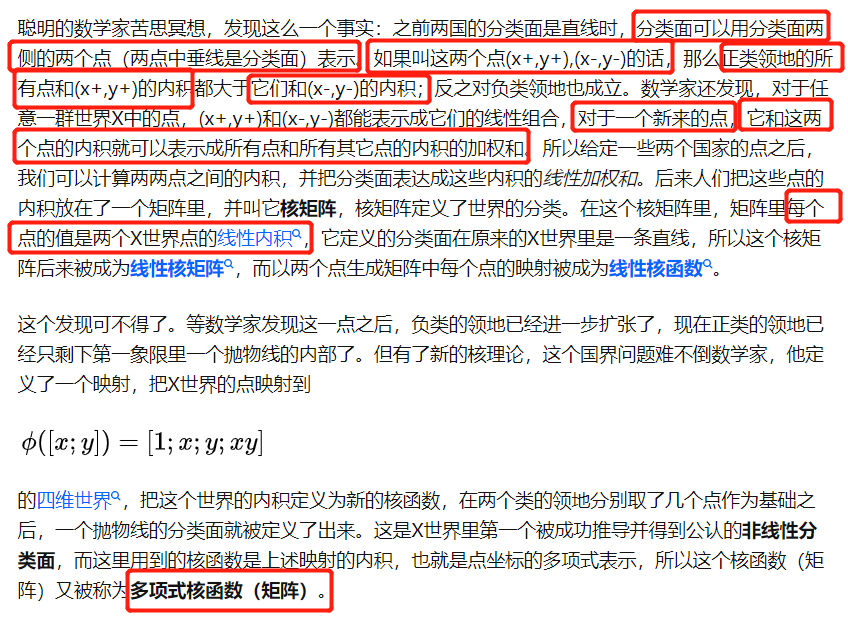

核函数就是内积

会不会对核函数省去什么步骤还是不太理解,别急

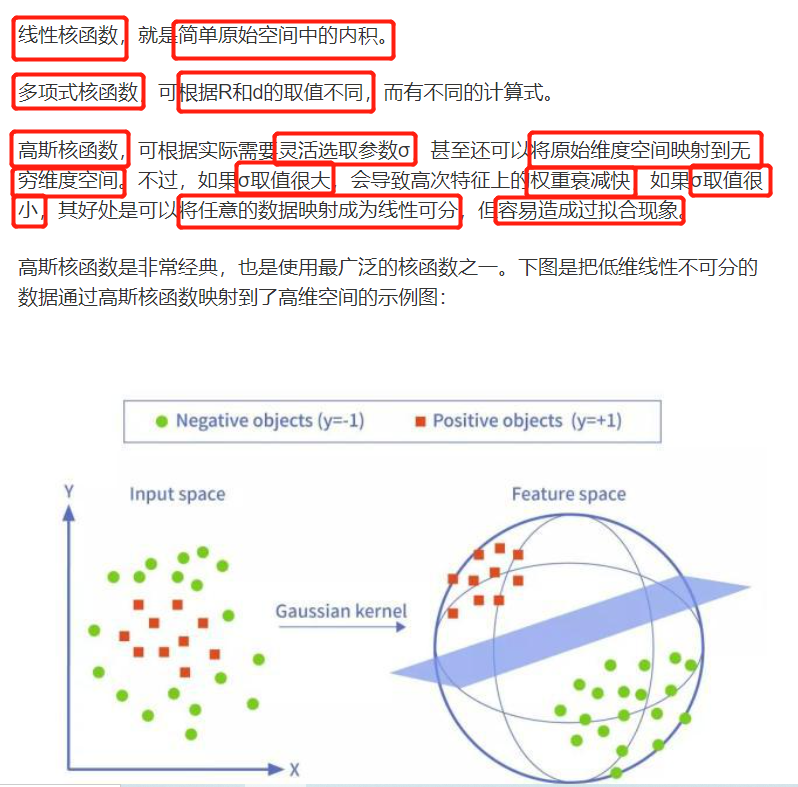

‘linear’:线性核函数

‘poly’:多项式核函数

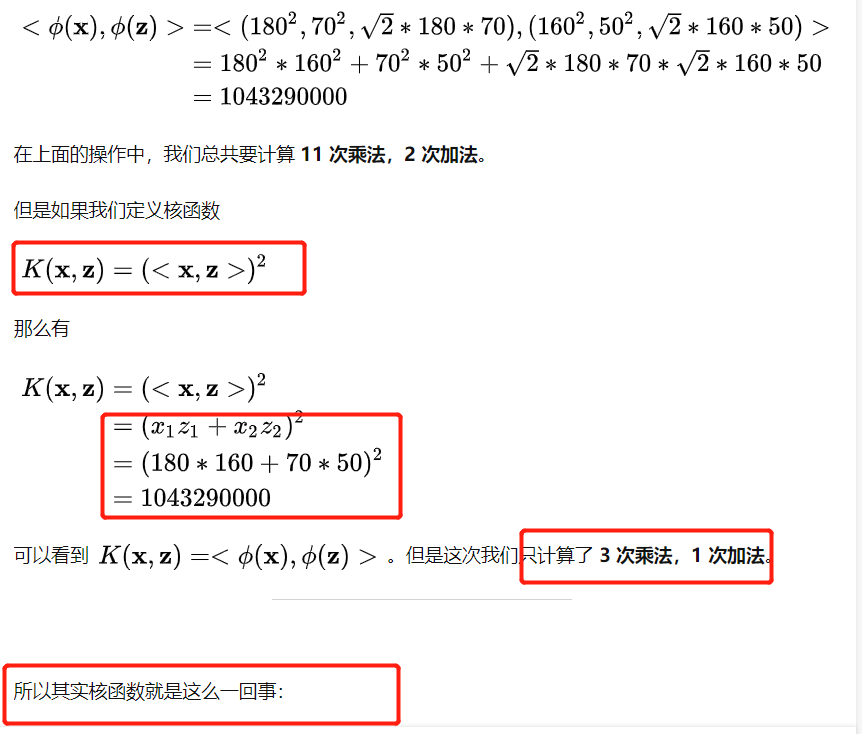

‘rbf’:径像核函数/高斯核

‘sigmod’:sigmod核函数

‘precomputed’:核矩阵

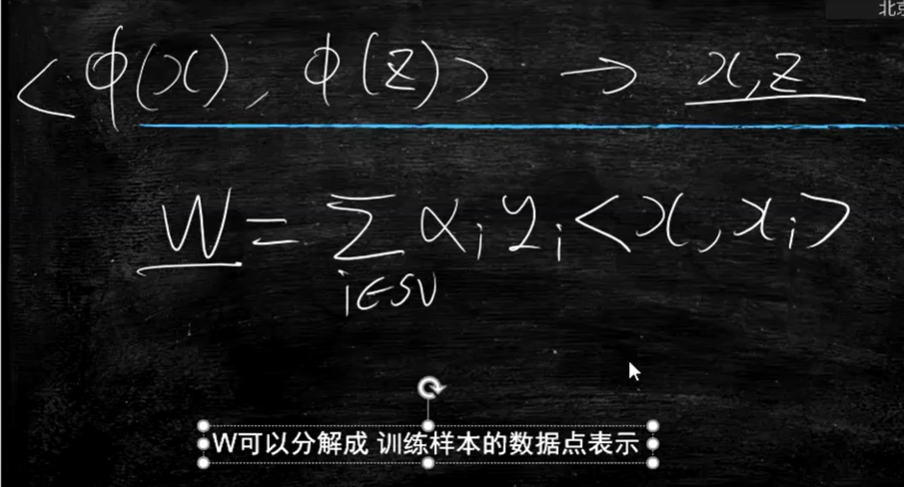

<问>逻辑回归能不能用核函数

逻辑回归不能用核函数

支持向量机避免了算

ω

\omega

ω,逻辑回归需要通过梯度下降计算

ω

\omega

ω

可以理解成SVM想先升维度再得到升维度后点的距离,核函数是直接得到升维度后点和点的距离

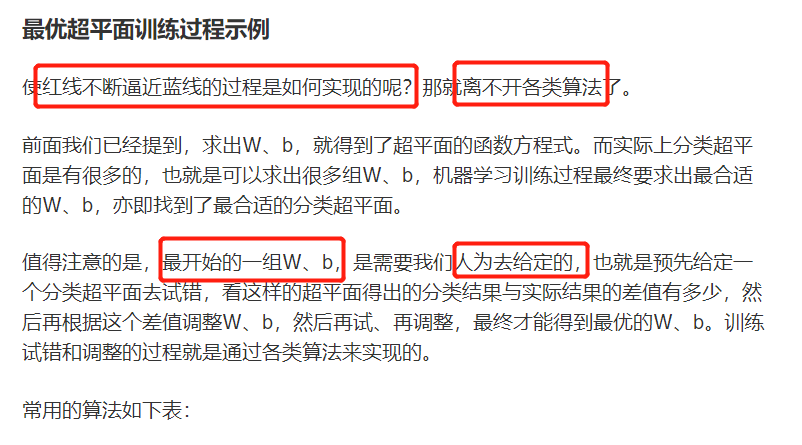

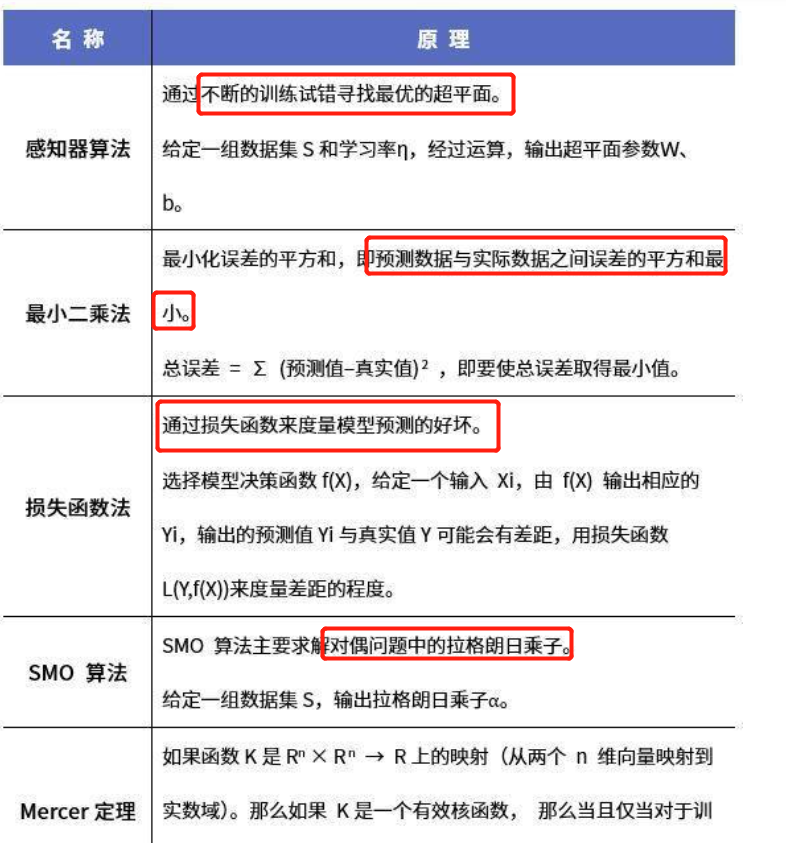

五、支持向量机训练算法

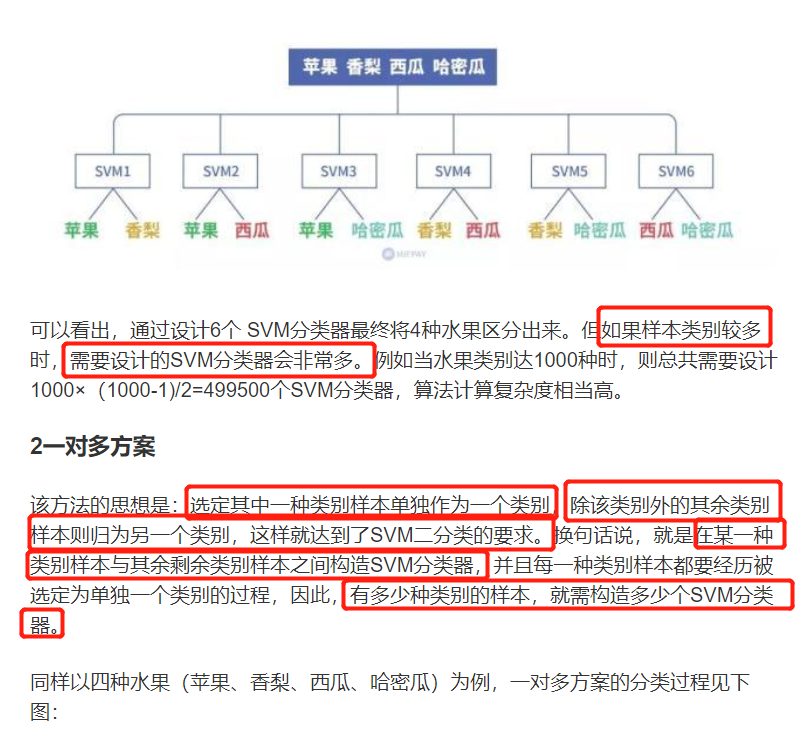

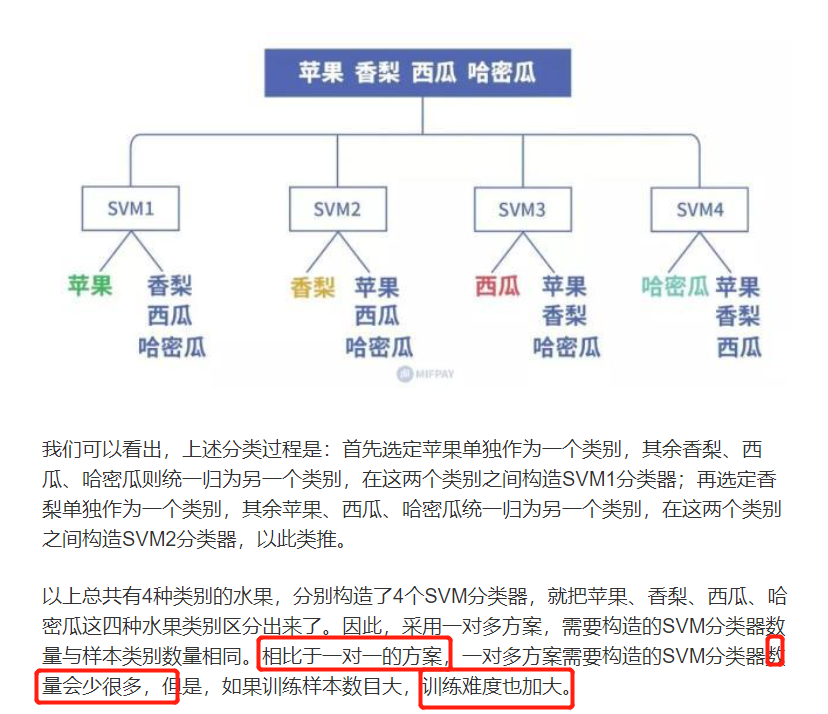

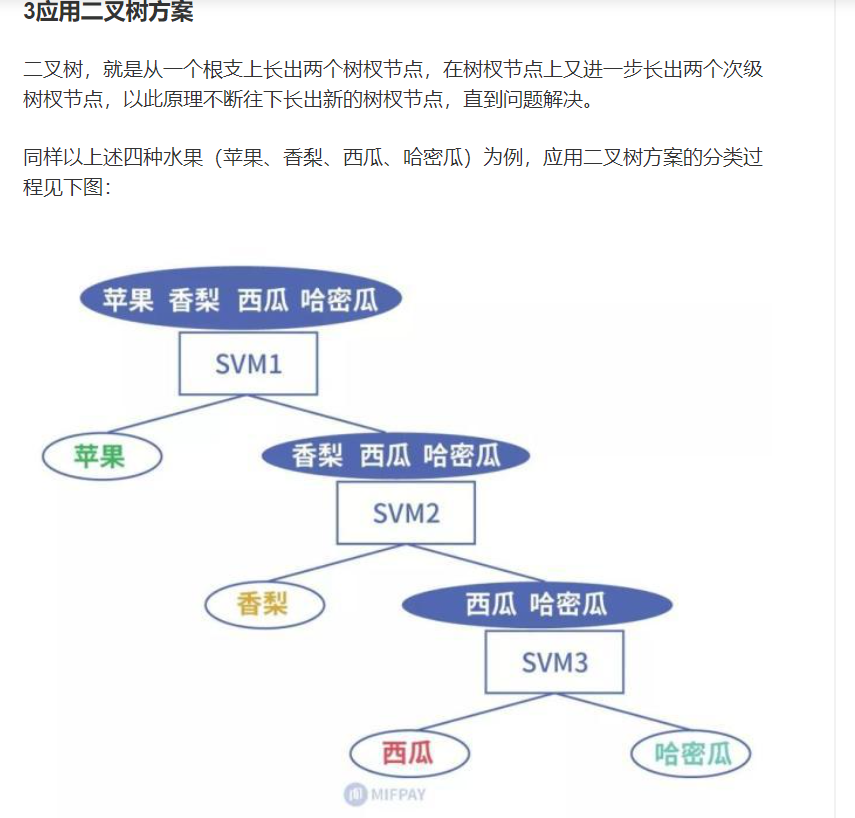

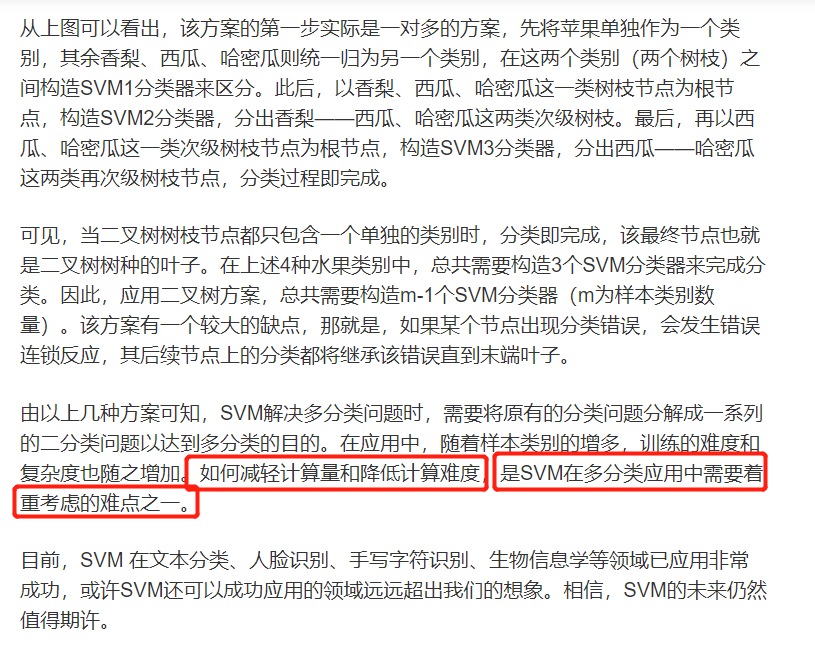

SVM解决多分类问题

注:每个SVM都会出一个结果,最后我们会取值最大的数字

泛化能力:对数据的敏感度越低,泛化能力越强

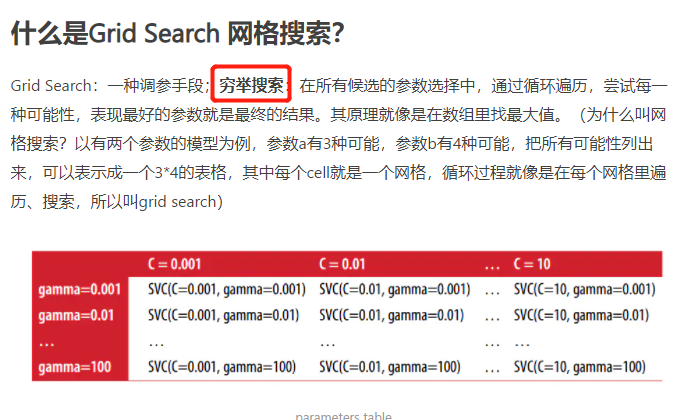

网格搜索

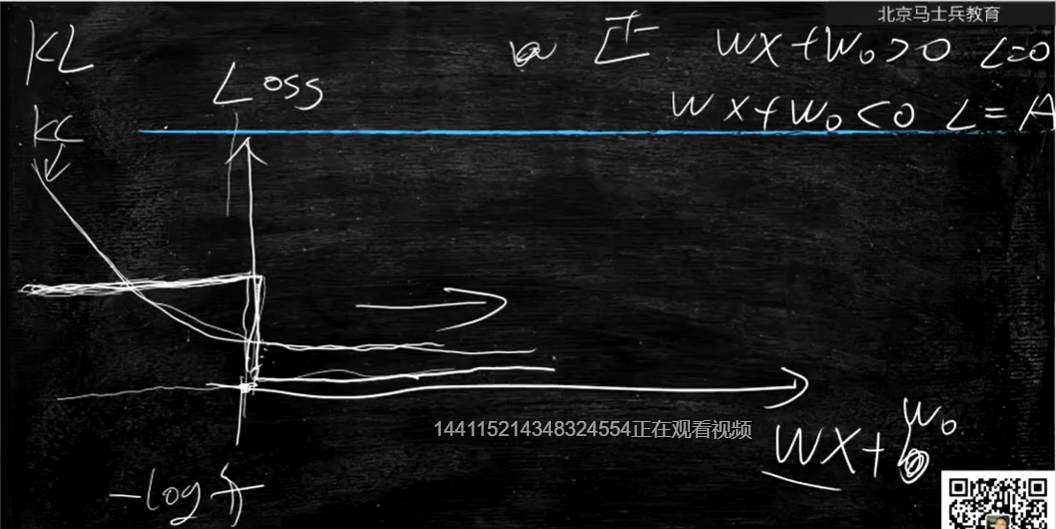

支持向量机使用的损失函数loss

1.方案一:两极(自己取的名字)学习错了没有梯度,不能继续学习

2.方案二:KL距离学习正确之后还是会继续学习

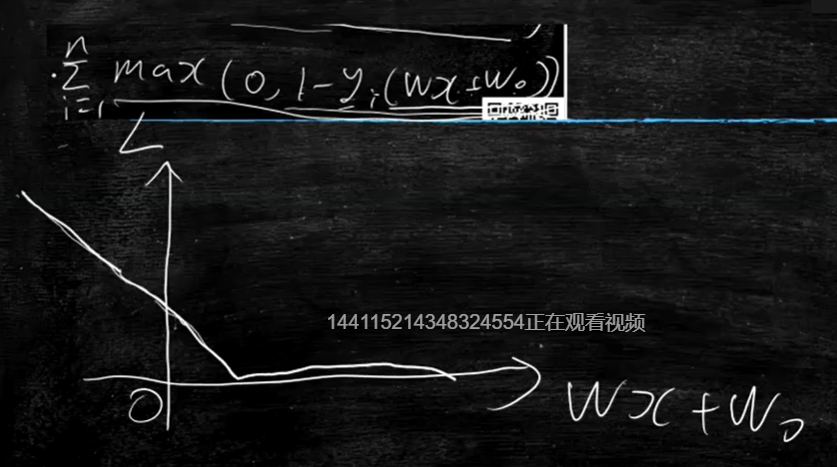

hingle距离:

坏处:错的时候,学习率曲线没有那么陡峭

好处:正确的时候不会无限的迭代下去

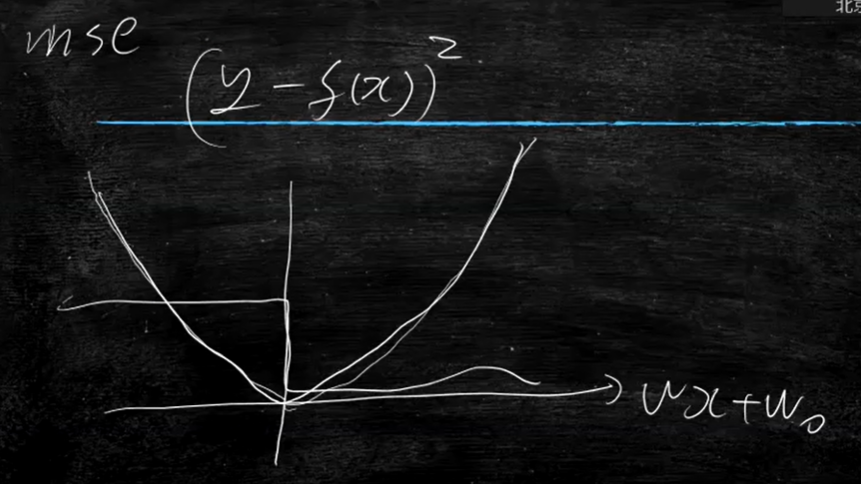

mse问题:学对学错都有损失

5346

5346

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?